|

|

|

|

|

|

|

|

![]()

NOTICIAS CIENTÍFICAS

TITULARES DE LAS NOTICIAS DEL MES

"Los escépticos del 'Climagate' defendían los intereses de la industria"

Hawai contará con el telescopio más potente del mundo

"Lo que está ocurriendo en el Golfo de México es como una patada en el culo"

Stephen Hawking publicará su nuevo libro, "The Grand Design", en Septiembre

Las abejas imprescindibles para el ser humano

Las energías renovables de origen marino están sin desarrollar en Canarias

El genoma humano espera su revolución

Un grupo de escolares descubre una misteriosa cueva en Marte

Los cosmólogos toman medidas a la "partícula fantástica"

El hombre de Atapuerda ocupó Gran Bretaña

El espacio para la investigación de mecánica cuántica

El ancestro de "Lucy" ya andaba de pie

Los pingüinos se mueren de frío en Sudáfrica

"La evolución de la vida ya no es un fenómenos natural"

La China científica antes socia que rival

Craig Venter busca en el Mediterráneo la clave de los combustibles del futuro

La Tierra bate su récord de calor en Junio

Los humanos de Atapuerca comían leones gigantes

Los aviones son capaces desencadenar precipitaciones

El verano será más cálido de lo normal con unos dos grados más de temperatura

¿Cinco "partículas de Dios" en vez de una?

"Atacaremos las células cancerígenas directamente"

Operar el cerebro con puntería milimétrica

La energía oscura no está clara

La pérdida de memoria si se puede frenar

¿Provocar lluvia artificial mediante la aplicación láser?

La Luna contiene cien veces más agua de lo que se creía

El norte de Marte estuvo ocupado por un gran océano

Diez lugares del universo para buscar vida extraterrestre

Identificado un gen supresor de tumores

Grandes reptiles oceánicos de sangre caliente

La fusión entre el cuerpo humano y la tecnología

Un cambio climático hizo desaparecer a los grandes simios de Europa

Un arsenal de 800 fármacos inteligentes acechan al cáncer

Así se produjo el brutal choque que formó la Tierra y la Luna

China se adelanta en explorar los nuevos yacimientos submarinos

El cosmos juega a las muñecas rusas

Las terapias heredadas de la quimioterapia son las nuevas protagonistas

Científicos chinos crean un agujero negro artificial

La ONU abre su parque al público para celebrar el Día del Medio Ambiente

Resuelven la paradoja del sol débil, el misterio científico que venció a Sagan

Un fármaco experimental hace olvidar los malos recuerdos

Cómo la gripe se volvió resistente al tamiflu

El año 2010 va camino de convertirse en el más cálido

Comienza el Gran Hermano marciano

En 2030 se diagnosticarán 20 millones de casos de cáncer anuales

-"Los escépticos del 'Climagate' defendían los intereses de la industria"

El físico Klaus Ha-sselmann (Hamburgo, 1931) no cree que sea discutible que el cambio climático es consecuencia de la acción humana sobre el planeta. Hasselman es uno de los fundadores del prestigioso Instituto de Meteorología Max Planck (Alemania) y visitó Madrid la semana pasada para recibir el Premio Fronteras del Conocimiento, que concede la Fundación BBVA. El jurado le otorgó el premio porque fue uno de los investigadores que demostraron que el calentamiento global se debe a la acción humana y no a la variabilidad natural del clima.

|

Su hallazgo se realizó hace más de una década. ¿Ha cambiado ese impacto desde entonces? No, el impacto es el mismo, sólo que ahora tenemos más datos para afirmarlo. ¿Cuál es la huella que generamos cada uno de nosotros? Una buena forma de medirlo es a través del volumen de gases de efecto invernadero emitido por persona al año. EEUU y Europa tienen cuatro o cinco veces más impacto que China. Tener una forma de medida es una herramienta para intentar solucionar el problema. ¿Cómo debe enfrentarse Europa al cambio climático? Hay que penalizar el uso de combustibles fósiles y dar subsidios a las energías renovables. España podría convertirse en líder en exportación de energía solar si esta se fomenta en Europa y en la propia España. También hay que estimular los incentivos de mercado y los requerimientos tecnológicos, como implantar límites máximos de emisión en los coches y de potencia en las bombillas. Por último, hay que transferir la tecnología y la economía de los países industrializados a los países emergentes. Nosotros somos responsables y tenemos, por tanto, la obligación de apoyar a esos otros países para reducir las emisiones. |

Klaus Hasselmann, después de recibir el Premio Fronteras del Conocimiento.F. bbva |

La próxima cumbre del clima tendrá lugar en diciembre en Cancún (México). ¿Qué resultados espera de ella?

Todo el mundo espera que las naciones colaboren en lugar de competir unas con otras. Los países más contaminantes deben asumir el liderazgo para que otros los imiten y adopten las mismas medidas. Se pueden reducir las emisiones sin dañar la economía, y por ello estoy a favor de una reducción de emisiones del 30% en Europa, independientemente del resto. Tenemos que ser los líderes.

¿Qué pasará si los países no llegan a un acuerdo durante esa cumbre?

No estoy seguro, y realmente no tenemos mucho tiempo. Si no se cambia el sistema, habrá un cambio climático enorme y nadie sabe del todo cuáles serán sus implicaciones. Se producirán grandes presiones migratorias y aumentarán las desigualdades, la brecha entre ricos y pobres. Ya tenemos la tecnología para resolver el problema y el coste sólo supone un 1% del PIB, lo que causaría un retraso económico de un año hasta 2050. Si actuamos ahora, la economía en 2050 será equiparable a la de 2049 y se evitarán todos los peligros del cambio climático. Si no hacemos nada, tendremos cambios estructurales graves.

¿Cree que hay países que se verán beneficiados por el calentamiento?

Sí, por ejemplo Rusia, ya que tendrá un clima menos frío. Sin embargo, es necesario que ellos apoyen a los países que luchan contra la subida de las temperaturas, ya que el cambio climático dará lugar a grandes migraciones y problemas globales. Por ello, aunque su clima mejore, sufrirá un impacto derivado de los problemas climáticos que se produzcan en el resto del mundo. Además, Rusia sufre un gran derroche de energía. Debe reducir su ineficiencia.

El 'Climagate' [filtración de correos donde supuestamente se manipulaban datos para probar el calentamiento] ha puesto en duda la credibilidad de los científicos del clima. ¿Qué opina del suceso?

Se le ha dado demasiada importancia. Los escépticos defendían los intereses de la industria e intentaron mostrar que los científicos mentían en sus investigaciones, pero las dos comisiones independientes que han investigado el suceso han demostrado que los científicos fueron sinceros y que no falsificaron datos. Lo científicos del clima llevamos 40 años diciendo lo mismo. Creo que ha habido un error en la gestión de la información de este grupo de investigación, pero eso no tuvo impacto en esos informes. La credibilidad de esos científicos está intacta, y las encuestas de opinión demuestran que la polémica ha tenido muy poco impacto en la percepción de la gente. Eso se debe a que la opinión pública tiene sentido común.

Fuente: publico.es, 30-6-10

-Hawai contará con el telescopio más potente del mundo

|

La junta directiva de la Universidad de Hawai ha aprobado por unanimidad un plan para construir un telescopio gigante en la cumbre de Mauna Kea. Se espera que sea el que tenga mayor capacidad astronómica del mundo. La construcción del telescopio, que tendrá 30 metros, no ha estado exenta de polémica ya que los nativos consideran que sería profanar el Mauna Kea y los ecologistas han advertido que podría dañar a un tipo de insecto local ('Nysius wekiuicola') que vive en esta montaña. La Universidad indicó en un comunicado que antes de dar la aprobación al proyecto hicieron un estudio del impacto ambiental, que fue aceptado por la Gobernadora de Hawai, Linda Lingle. El proyecto pasará ahora al Departamento de Tierras y Recursos Naturales que tendrá que ratificar el permiso para construir el telescopio. "Este telescopio nos llevará a un emocionante viaje de descubrimientos astronómicos" dijo el presidente de la institución M.R.C. Greenwood, quien subrayó que "los beneficios que se derivarán del proyecto van mucho más allá de los resultados científicos". |

|

En este sentido destacó que la inversión de capital y la creación de trabajo que generará el telescopio Thirty Meter Telescope (TMT, por sus siglas en inglés) serán beneficiosos para la isla. Greenwood se mostró consciente "de la importante responsabilidad de la universidad para garantizar el uso adecuado de este sitio especial, para las generaciones futuras".

Asimismo, reiteró que el cuidado del lugar ha sido un punto de "máxima prioridad" en todo el proceso y "seguirá siendo a medida que trabajamos en estrecha colaboración con la comunidad y todos los actores involucrados en la gestión del Mauna Kea".

El Mauna Kea, cuyo significado es 'montaña blanca', es uno de los cinco volcanes que forman la isla de Hawai junto con Mauna Loa, Hualalai, Kohala y Kilauea. Es el segundo en la zona por su altura y permanece inactivo desde hace más de 3.500 años.

Fuente: elmundo.es, 29-6-10

-"Lo que está ocurriendo en el Golfo de México es como una patada en el culo"

Jean-Michel Cousteau, hijo del mítico explorador submarino francés de cuyo nacimiento se acaban de cumplir 100 años, ha vivido muchos vertidos. Se mudó a Santa Bárbara, un año antes del derrame de petróleo que padeció esta ciudad californiana en 1969.

|

Jean Michel Cousteau |

Documentó el Exxon Valdez, hace 20 años, y el Prestige, hace ocho. Ahora está a punto de realizar su tercera expedición al Golfo de México, desde que se hundió la plataforma petrolífera Deepwater Horizon, donde hablará con BP sobre posibles soluciones. ¿Cuánto tiempo va a durar el impacto del vertido? Hay decenas de miles de personas angustiadas porque durante mucho tiempo van a tener que vivir con esto. Si vas al lugar del Exxon Valdez 20 años después, todavía puedes comprobar el impacto que tiene en la gente y el medio ambiente. Si cavas en el fondo del mar, todavía hay petróleo a medio metro. En el Golfo tenemos un Exxon Valdez vertido al océano cada cuatro días. Estamos en el día 68, así que calcule. ¿Cree que la corriente puede acabar llevando el crudo hacia la costa Este de EEUU? Saldrá del Golfo, al Caribe, y será recogido por la Corriente del Golfo. Y seguirá hasta Inglaterra, Francia, España y Portugal. Y por supuesto que afectará a todas esas personas, y a nuestro sistema de apoyo vital. |

¿Cuánto tardará el petróleo en llegar a España?

Habría que saber la velocidad de la Corriente del Golfo, pero yo diría que en menos de un año.

¿Cree que el pozo de alivio que se va a construir para detener el vertido funcionará?

No creo que puedan pararlo. Hay algo de lo que no habla nadie, la presión. Si lo taponas por un lado, va a reventar por otro. Por eso, no hacen más que inventarse historias, "lo estamos intentando, lo estamos intentando", cuando en realidad quieren dejarlo salir todo. Podrían haberlo parado si no fuera por el gran riesgo que hay de que reviente por otro lado.

¿Así que seguirá brotando hasta que se acabe el petróleo?

Básicamente. O hasta que la presión descienda. La presión del petróleo es mayor que la presión del agua. Tiene que salir por algún lado. Y como la estructura tiene fracturas, si se tapa por un lado saldrá por otro.

¿La única solución es capturar la mayor cantidad de petróleo posible?

O todo. Desde mi punto de vista, no lo están haciendo muy bien. Poner los dispersantes es un gran error. Hay que dejar que suba el crudo, cercarlo y bombearlo. Claro que cuando hay huracanes los barcos se tienen que ir y el petróleo seguirá subiendo. Pero, por ahora, no veo otra opción posible.

¿Ha oído hablar del sistema desarrollado por la empresa Ecomerit que utilizaría burbujas del gas natural para capturar el petróleo y hacerlo subir a la superficie, donde se podría capturar?

Sí, he oído hablar de este sistema. Es una solución mucho mejor que el dispersante, porque acelera la subida del petróleo a la superficie, y para cuando lo hace, todavía se puede utilizar como combustible. Lo que vemos ahora en la superficie no sirve como combustible. El 40%, lo que hace que tu coche se mueva, ya se ha evaporado. Lo que queda es alquitrán.

Habla del océano como nuestro sistema de respiración, de apoyo vital. ¿Qué quiere decir?

Somos 6.700 millones de personas en la actualidad, que, a propósito, es lo que saca de beneficio BP cada trimestre. Sumamos 100 millones de habitantes al planeta cada año. Ya vivas en Santa Bárbara o en lo alto de una montaña, todavía dependes del océano. Cuando esquías en esa montaña, esquías en el océano. Cuando bebes un vaso de agua, estás bebiendo el océano. Estamos todos conectados y dependemos todos del océano para nuestra calidad de vida.

Es inevitable sentirse impotente ante un vertido tan grave como el del Golfo. ¿Qué se puede hacer?

Lo que está ocurriendo en el Golfo es como una patada en el culo, una oportunidad única para cambiar. Cada uno puede ser embajador para que nuestra comunidad entienda que debemos proteger nuestro sistema de protección de vida. Necesitamos cambio. Ya vale de parlotear. Pidamos a las personas que toman decisiones, al Gobierno, a la industria, que acepten el hecho de que necesitamos una comisión internacional para asegurarnos que tenemos la capacidad de prevenir, y de poseer un plan A, B y C en caso de accidentes, como en el programa espacial. Podemos hacerlo, y lo haremos.

¿No podemos dejar que solucionen el problema otros?

Mírale a un niño a los ojos. ¿Le vas a fallar? Tenemos capacidad de hacer algo por el mundo. En 1983 conocí a un jefe de una tribu del Amazonas que me mostró algunos de los árboles que había plantado, que medían unos cuatro metros. Me dijo, "¿Ves esos árboles? Yo no los veré lo suficientemente altos. Mis hijos tampoco. Quizás mis nietos. Pero mis binietos sí". Entonces se dio la vuelta y me dijo, "¿Ves aquel? Ese será una buena canoa". Ésa era su constitución no escrita del futuro. Ese hombre me impactó para el resto de vida tanto como lo hizo mi padre".

Fuente: elmundo.es, 29-6-10

El científico británico Stephen Hawking publicará su nuevo libro, titulado 'The Grand Design', sobre su teoría para describir la naturaleza, el próximo 7 de septiembre, indicó hoy la editorial Bantam Dell.

Stephen Hawking

Se trata de la primera gran obra del físico y cosmólogo británico desde hace varios años y la publicará junto al también científico Leonard Mlodinow, con quien ya ha sido coautor de otras publicaciones como 'A Briefer History of Time (Brevísima historia del tiempo)'.

La editorial indicó que 'The Grand Design' se publicará a principios de septiembre y en ella Hawking y Mlodinow examinan una teoría para 'describir y explicar las fuerzas de la naturaleza'.

Hawking, que padece esclerosis lateral amiotrófica, también conocida como enfermedad de Lou Gehrig, ha sido honrado con doce doctorados honoris causa y galardonado con el Premio Príncipe de Asturias de la Concordia en 1989. Es también un divulgador científico conocido por sus teorías sobre los agujeros negros y la formación del universo. Hawking, que también fue condecorado con la Orden del Imperio Británico en 1982 y con la Medalla Copley en 2006, es autor de otros libros científicos de gran éxito como 'Agujeros negros y pequeños universos y otros ensayos' y 'El universo en una cáscara de nuez'.

Con Mlodinow, que es profesor en el Instituto de Tecnología de California, escribió en 2005 'Brevísima historia del tiempo', una versión de su primer 'best-seller' dirigido para el gran público y que versa sobre astrofísica y física teórica.

Fuente: 29-6-10

Uno de los edificios de la sede de Microsoft en Redmond (Seattle, EEUU) alberga la Casa del Futuro (Microsoft Home), la recreación de un hogar donde la domótica se encuentra en todos y cada uno de sus rincones. Aunque, como precisa Flora Peabody, directora del programa de Estrategia y Prototipos de Consumo de la empresa, no pretenden "marcar el camino ni asegurar que el futuro tenga que ser así", sino "mostrar opciones de cómo se podrían hacer las cosas".

|

La casa fue creada hace 15 años con el objetivo de mostrar las innovaciones que podrían ir viéndose en nuestros hogares durante la década siguiente. Los avances introducidos desde entonces han sido sustanciales, hasta el punto de que quienes ya la han visto antes se sorprenden de cómo ha cambiado el futuro. Algunos de los productos de Microsoft que se encuentran en el mercado nacieron en esta Casa del Futuro; es el caso del Tablet PC o del Windows Media Center. Kinect, el nuevo sistema para la consola Xbox que convierte el propio cuerpo en el único mando necesario, bien podría haber nacido en esta casa del futuro, aunque la directiva se apresura a puntualizar que no es el caso. La integración con Internet se manifiesta en cada habitación de la casa, desde el tablón de anuncios a la manera de gestionar y disfrutar de todo el contenido multimedia, "seleccionando miles de canales de televisión, archivos de vídeo y audio, correos electrónicos y blogs" desde un único dispositivo, explica Peabody. El objetivo es "mejorar significativamente la experiencia del usuario aprovechando toda la información que se encuentra a nuestro alcance, en este caso, en la Red", añade la ejecutiva. Así, se puede leer una revista digital en la mesa del cuarto de estar, desde donde podemos manejar el televisor que tenemos enfrente interactuando con las imágenes. Es como una visita a un museo, en cuyo recorrido, muestra la directora de Prototipos, "un hijo dejara a su madre una nota llamando su atención sobre una obra en particular, en la que puede hacer clic desde la mesa para voltearla y verla desde diferentes ángulos; nunca antes una visita a un museo se había podido realizar así". |

|

En este sofisticado hogar, en el que las órdenes por voz son la norma, una constante en toda la casa es la instalación de proyectores. Gracias a ellos no sólo es posible ver la televisión, cuya pantalla se sustituye por una fina lámina de cristal, sino decorar a la carta cualquier habitación ajustando las imágenes a los marcos de las puertas o de las ventanas, reemplazando a la pintura o al empapelado de paredes. "Se puede cambiar la decoración al gusto, varias veces al mes si se desea", explica la responsable de Microsoft. Es el caso del dormitorio de los niños, en el que mediante diodos orgánicos de emisión de luz (OLED) las paredes se decoran con su música preferida, videoclips o páginas web.

Acompañando a estas proyecciones, unos sensores reconocen objetos e interactúan de manera inteligente. La encimera de la cocina está dotada de esta inteligencia y no sólo despliega complejas recetas de cocina sino que, "en los casos de las personas mayores", explica Peabody, "sólo han de dejar los frascos de las pastillas en la encimera y el sistema proyecta sobre esta las indicaciones de las dosis que han de tomar". No sólo reconocen los envases, sino las píldoras, evitando así errores en las dosis al haber confundido los frascos.

Visto el despliegue tecnológico en toda la casa, uno se pregunta si es energéticamente sostenible, si sus consumos respetan el cuidado por el medio ambiente, más allá de insertar sensores en las plantas que miden con extrema exactitud el nivel de humedad que requiere la tierra. En este sentido, toda la casa está dotada de sistemas inteligentes de iluminación y climatización, "por lo que el consumo de energía es lo más eficiente posible", se apresura a matizar la experta. Puntualiza, además, que "el despliegue que hay en esta casa no ha de ser el de una vivienda habitual, ya que esto no deja de ser un mero escaparate en el que se conjugan tecnologías para todos los gustos, desde los de ejecutivos de edad avanzada que visitan la instalación, al de niños o amas de casa".

Vaciabolsillos

Al depositar el

teléfono móvil, se accede a su contenido.

Panel de control

Informa de la

temperatura y la humedad, de los mensajes en el contestador y de los emails.

Televisión interactiva

Proyectada en un cristal, permite

visitar virtualmente un museo y girar las piezas.

Adornos dinámicos

Al depositar un objeto -por ejemplo,

la Torre Eiffel-, los sensores lo detectan y decoran el panel con fotos de unas

vacaciones en París.

Encimera táctil

Detecta los frascos de pastillas y

proyecta las dosis necesarias. También es ideal para recetas.

Corcho inteligente

Las notas digitales interactúan con

los elementos pegados.

Espejo asesor

Identifica la ropa que nos probamos

y nos aconseja para conjuntar o ir a la moda.

Control táctil

La mesa permite leer una revista y controlar la televisión.

Fuente: publico.es, 28-6-10

-Las abejas imprescindibles para el ser humano

El 75 por ciento de

la flora silvestre se poliniza gracias a las abejas y casi el 40 por ciento de

las frutas y verduras que comemos procede de la polinización, que realizan estos

insectos en declive por un "cóctel" de amenazas como los plaguicidas,

transgénicos, el ácaro varroa, e incluso la mala acción de apicultores

inexpertos.

Así lo han expresado a EFEverde diversos expertos consultados, que han

coincidido en destacar que estos insectos, a menudo molestos, para los

habitantes de las ciudades son imprescindibles para la vida.

A pesar de que la investigación del ahora conocido "Síndrome de despoblamiento

de las colmenas" se inició en 2005, a día de hoy aún no se conocen las causas

del por qué de esta paulatina disminución de las abejas de la miel. Los

científicos insisten también en la pérdida económica que supone la disminución

de estos insectos y afirman que toda la actividad económica que genera la

existencia de las abejas mueve alrededor de unos 10.000 millones de euros

anuales. Afortunadamente en España viven 1.000 de las 25.000 especies de abejas

que existen en el mundo y la abeja de la miel es tan sólo una de ellas.

Concienciar a la sociedad

Aquellos que están involucrados en el mundo de las abejas y conocen su

problemática se han puesto manos a la obra para intentar concienciar a la

sociedad de la importancia de su cuidado, coinciden desde investigadores a

responsables de colmenas.

El apicultor de Apitecnic, Alberto Castro, ha explicado a Efeverde que uno de

sus principales objetivos como profesional es, actualmente, la creación de

estaciones de polinización en La Pedriza (Madrid), con colmenas diseñadas para

hacer estudios y así poder demostrar la importancia de las abejas en los

ecosistemas.

"Si no existieran polinizadores naturales como las abejas, no habría plantas,

sin ellas no existirían los animales herbívoros y sin éstos, los carnívoros

tampoco, por lo tanto al hombre le quedarían muy pocas posibilidades de

sobrevivir sin estos insectos", ha afirmado Castro.

Sin embargo, no toda la culpa es de la mala acción del hombre. El científico del

Real Jardín Botánico, Pablo Vargas, ha reiterado a Efeverde que son "varias las

especies de abejas en peligro de extinción".

En algunos casos porque se especializan en una planta poco común y si ésta

desaparece por las causas que sea, lo hace también la abeja" que depende de

ella.

En España existen 250 asociaciones de apicultores, más de quince museos,

2.700.000 colmenas, pero lo que no existe es una educación adecuada para

aquellos que se dedican profesionalmente a las abejas. Los apicultores

profesionales denuncian que no hay formación a nivel profesional, ni centros de

selección, y que se presta poca atención a un oficio que se ve como algo del

pasado. La razón principal es -añaden- la escasa importancia que el ser humano

concede a este insecto.

Fuente: EFE, 26-6-10

-Las energías renovables de origen marino están sin desarrollar en Canarias

Las energías renovables de origen marino no se han desarrollado en Canarias, a pesar de las posibilidades que ofrece el archipiélago, debido a dificultades administrativas en algunos casos o a que no han pasado de ser experiencias piloto sin aprovechamiento comercial.

|

Así lo indicó a Efe el director de la Agencia Canaria de Desarrollo Sostenible y Cambio Climático, Jorge Bonet, quien recordó que existen diversos tipos de energías renovables con origen en el mar, como la eólica marina ('offshore'), la que utiliza el oleaje o la que aprovecha la diferencia térmica entre la profundidad y la superficie. La energía eólica marina tiene costes de mantenimiento altos pero sus rendimientos también son elevados, pues en el mar hay viento de manera casi constante, indicó Bonet. El desarrollo de este tipo de energía es prácticamente imposible en Canarias debido a la normativa actual, ya que existe un decreto estatal que regula la instalación de plantas eólicas en el mar que no ha tenido en cuenta la insularidad ni sus sistemas aislados. Además, la ley establece que no se puede instalar un aerogenerador en los primeros seis kilómetros a partir de la línea de costa, lo que supone que en Canarias no hay ningún punto con los 50 metros de profundidad necesaria que cumpla este requisito. 'Esta salvedad se ha incluido en la norma por razones paisajísticas, pero impide de facto que pueda instalarse energía eólica marina en Canarias', aseguró Bonet. |

|

Por otra parte, la potencia mínima de 50 megavatios establecida para las centrales eólicas marinas no es de aplicación en algunas islas, como El Hierro, pues exige una inversión demasiado elevada.

'En este momento la normativa impide que la energía eólica marina se desarrolle en Canarias', insistió el director de la Agencia Canaria de Desarrollo Sostenible y Cambio Climático.

En el caso de los otros tipos de energías renovables de origen marino diferentes a la eólica, como la que aprovecha el oleaje o la diferencia de temperatura, no existe ningún desarrollo más allá de experiencias piloto. Actualmente está en marcha la Plataforma Oceánica de Canarias (PLOCAN), una instalación para la investigación marina de referencia en el Atlántico medio, que comenzará a funcionar en 2012 y en la que participan el Estado y el Gobierno de Canarias.

Es una instalación fija que se situará sobre el borde de la plataforma continental al este de la isla de Gran Canaria, en la zona de Telde. Pretende convertirse 'en una base autónoma y sostenible que albergará un conjunto de instalaciones y laboratorios experimentales desde la que se iniciará la ocupación y operación oceánica estable para acceder al océano profundo a través de vehículos y maquinaria de trabajo submarino', según sus promotores.

En la PLOCAN se desarrollarán todo tipo de trabajos e investigaciones científico-tecnológicas avanzadas: desde la investigación científica marina hasta estudios sobre el aprovechamiento de los recursos energéticos marinos. La plataforma dispondrá de conexiones mar-tierra y mar-mar y será accesible por mar y aire.

Además, dispondrá de todas las instalaciones necesarias para la realización de trabajos e investigaciones submarinas, por lo que contará, por ejemplo, con cámara hiperbárica y acceso submarino para vehículos. La plataforma también podrá ser utilizada para la instalación de servicios a profundidades hasta ahora desconocidas y en torno a 300 y 400 investigadores y empresas tecnológicas podrán desarrollar su trabajo en la PLOCAN, según las previsiones.

Fuente: EFE, 25-6-10

-Llegan los pulmones artificiales

Dos estudios publicados hoy suponen un paso clave hacia un futuro en el que los pulmones para trasplantes e investigación científica se fabricarán en un laboratorio. Se trata de métodos aún experimentales y que tardarán décadas en hacerse realidad, pero si demuestran ser viables, podrán acabar con la enorme escasez de pulmones para trasplantes que hay en todo el mundo. También aportarían una nueva generación de órganos artificiales con los que probar la toxicidad de cualquier tipo de compuestos químicos, incluidos los nanomateriales que ya están llegando al mercado, y sin necesidad de usar animales de laboratorio.

|

El primer trabajo, publicado hoy en Science, ha logrado reconstruir un pulmón de rata que había sido previamente vaciado. La técnica, que ya se ha usado para reconstruir corazones, hígados y otros órganos, consiste en tomar un pulmón de rata adulta y usar detergentes especiales hasta retirar de él todas las células que lo componen. El resultado es un andamio de tejido conectivo blanquecino que tiene forma de pulmón, pero que ya no lo es, pues está vacío de venas, alveolos, ADN y cualquier otro rastro de la rata que donó el órgano. Después se introduce ese esqueleto en un tanque que imita un útero y se le baña con células de ratas recién nacidas. También se le inyecta aire para que vaya recobrando la elasticidad característica que hace posible la respiración. En ocho días se retira el órgano del tanque y se trasplanta. "Los pulmones todavía no son perfectos, pero hemos demostrado que funcionan", explica a Público Thomas Petersen, investigador de la Universidad de Yale (EEUU) y coautor del estudio. Tras el tratamiento, los pulmones recuperan los componentes que permiten la respiración. Una vez inyectadas, las células epiteliales reconstruyen los alveolos, sacos microscópicos en los que el oxígeno atraviesa el tejido y entra en el flujo sanguíneo. Otro tipo de células, las endoteliales, reconstruyen los vasos sanguíneos que envían el oxígeno al resto del cuerpo. Trasplantados en ratas receptoras, los órganos funcionaron correctamente durante dos horas. "En esta ocasión sólo queríamos probar que es posible usar esta técnica para reproducir el intercambio de gases que hace posible la respiración", explica Petersen, cuyo equipo ya prepara otros experimentos de mayor duración. "Como sólo usamos la estructura y no el órgano en sí, creemos que también podrían usarse pulmones de cerdo o de chimpancé para futuros trasplantes en humanos", aventura Petersen. "Llegar a aplicar esto en una clínica podría llevar 20 años", advierte. "Esta técnica puede convertirse en una solución definitiva, porque permite hacer órganos a la carta para cada receptor", explica Rafael Matesanz, coordinador de la Organización Nacional de Trasplantes (ONT). Usar los andamiajes de órganos donados permite rellenarlos con células del propio paciente, evitando, en teoría, el rechazo. En España, además, permitiría aprovechar el 80% de los pulmones que se donan y que no pueden trasplantarse, pues su estado no es óptimo. La ONT ya colabora en un proyecto similar que usa corazones donados para fabricar otros nuevos a partir de sus andamiajes. |

|

"Estoy convencido de que reparar o crear nuevos órganos de esta forma será la principal vía de abastecimiento para trasplantes en el futuro", asegura Andrés Varela, jefe de cirugía torácica del hospital Puerta de Hierro de Madrid, uno de los siete centros es-pañoles donde se hacen injertos de pulmón. Varela quiere comenzar un ensayo en el que los pulmones de los donantes se tratarán con células madre de los receptores para evitar el rechazo.

El segundo estudio, también publicado en Science, allana el camino hacia órganos artificiales con los que probar la toxicidad de nanomateriales usados en pinturas, aislantes y otros productos. Se trata de un minipulmón construido sobre una plataforma transparente del tamaño de una goma de borrar.

Este chip lleva en su interior una lámina de tejido con células epiteliales y endoteliales humanas, iguales a las que existen dentro de los alveolos. La capa de tejido es elástica para adaptarse al ritmo respiratorio y deja entrar oxígeno y otras partículas hasta los vasos sanguíneos. Aún no es capaz de realizar el proceso completo de respiración, pero sí simular la entrada de aire en los pulmones. Esto ha permitido, por ejemplo, demostrar la toxicidad de nanopartículas de silicio que se usan en pinturas anticorrosivas.

Un robot científico

El chip podría convertirse en la nueva rata de laboratorio. Mientras los ensayos toxicológicos o farmacológicos con animales pueden llegar a costar más de un millón de euros, el chip cuesta menos de diez céntimos y el equipamiento necesario para usarlo, unos 1.500 euros, según señalan sus creadores.

"Aún es pronto para predecir el futuro de estas aplicaciones", advierte Dan Huh, investigador de la Universidad de Harvard (EEUU) y uno de los creadores del ingenio. "Esta nueva tecnología podría permitirnos conectar varios de estos órganos artificiales para crear un sistema circulatorio con el que hacer ensayos biológicos sobre la respuesta del cuerpo a medicamentos y toxinas, sin la necesidad de realizar largos y costosos ensayos con animales", concluye.

La pionera. Corazón

En 2008, la investigadora de la Universidad de Minnesota (EEUU) Doris Taylor

dio un paso clave hacia el futuro de la medicina regenerativa. Vació un corazón

de rata usando detergentes hasta conseguir una estructura sin células. Después

lo sembró con células cardiacas de rata recién nacida. Poco después, el primer

corazón bioartificial daba sus primeros latidos. El equipo quiere usar esta

técnica para recubrir corazones humanos donados con células madre del paciente

receptor, lo que evitaría el rechazo del órgano.

Colaboración española. Humanos

Taylor ha colaborado con expertos del hospital Gregorio Marañón de Madrid,

que en mayo lograron vaciar un corazón humano para obtener su andamiaje. Ahora,

el equipo trabaja en recubrir esa estructura con células madre para crear el

primer corazón humano bioartificial.

Hígado. Igual que el natural

El 13 de junio, un equipo del hospital General de Massachusetts (EEUU) usó la

técnica del vaciado celular para crear un hígado funcional en ratas. Tras el

vaciado y la recelularización, el órgano fue trasplantado a animales receptores.

Su funcionamiento era equiparable al de hígados normales.

La alternativa. Moldes

El investigador Anthony Atala, del Instituto Wake Forest de Medicina Regenerativa (EEUU), tiene su propia receta para fabricar tejidos y órganos. En lugar de usar andamiajes obtenidos de órganos naturales, usa moldes que recubre con células madre. Su técnica ha permitido crear vejigas funcionales en perros así como regenerar penes de conejo y permitir a los animales reproducirse sin problemas.

Fuente: publico.es, 25-6-10

-El genoma humano espera su revolución

Diez años después de su publicación, la mayoría del libro de la vida sigue siendo un misterio. La secuenciación del genoma humano, que fue comparada con la llegada a la Luna o la invención de la rueda, ha planteado muchas más preguntas que respuestas sobre cómo sus 3.000 millones de bases de ADN predisponen a una persona hacia la salud o la enfermedad.

Lo que sí ha logrado la publicación de esta y otras secuencias, de animales como el ratón o parientes cercanos del hombre como el chimpancé, es cambiar para siempre la manera de trabajar de los científicos que estudian casi cualquier aspecto de la biología, desde los orígenes remotos de las poblaciones actuales hasta la búsqueda de nuevos fármacos contra el cáncer.

"El genoma humano es una herramienta fundamental en la investigación y ha marcado un antes y un después", explica a Público Jaume Bertranpetit, director de la Unidad de Biología Evolutiva de la Universidad Pompeu Fabra. "Sin embargo, no va a cumplir las expectativas, pues se puso un énfasis exagerado en que lo va a curar todo", advierte.

El primer borrador del genoma humano se anunció el 26 de junio de 2000. Sucedió en la Casa Blanca, donde el entonces presidente de EEUU Bill Clinton y el primer ministro británico Tony Blair recibieron a Francis Collins y Craig Venter, dos genetistas que llevaban meses peleando para ser los primeros en descifrar la secuencia completa del genoma humano. Collins lideraba el Proyecto Genoma Humano (PGH), una iniciativa pública en la que participaron unos 2.000 investigadores de EEUU, Reino Unido, Alemania, Francia, Japón, China, India, Canadá y otros países. Venter capitaneaba la empresa Celera, creada para secuenciar el primer genoma humano antes que el proyecto público y financiarse cobrando cuotas por acceder a sus datos. Tras muchas desavenencias y cruces de acusaciones, ambos científicos accedieron a realizar un anuncio conjunto.

"Una vez se logre la secuencia completa", decía el comunicado de la Casa Blanca, el genoma humano servirá para "alertar a pacientes de que sus genes les ponen en riesgo de sufrir ciertas enfermedades", "predecir el curso de una dolencia" y "diagnosticar con precisión el tratamiento a seguir". Diez años después del anuncio, una encuesta publicada hoy por Nature en la que han participado mil investigadores biomédicos de EEUU, Europa y otros países concluye que casi la mitad de los encuestados piensa que se exageró el potencial de la secuenciación del genoma humano. "Hay algo de decepción debido a que, a pesar de tener tanta información, hay aún mucho que no entendemos", explica a la revista David Lipman, director del Centro Nacional de Información Biotecnológica de EEUU.

La secuenciación del genoma permitió identificar unos 20.000 genes que fabrican proteínas humanas. Esas proteínas son el motor de la vida, y también de la enfermedad. La información ha servido para identificar cientos de genes relacionados con muchas enfermedades. Su utilidad clínica ha sido enorme en enfermedades hereditarias raras que están causadas por tan solo un puñado de modificaciones en genes concretos. Las malas noticias son que las grandes asesinas como el cáncer o la diabetes tienen un origen complejo, en el que posiblemente cientos o miles de genes intervienen en la enfermedad junto a otros factores como la dieta, la actividad física y muchos otros, cuyo origen podría estar en ese 80% de ADN basura que no secuencia proteínas.

"Hace unos años, nuestra relación con el genoma era de enamoramiento, estábamos entusiasmados de su potencial", explica el investigador del Instituto Catalán de Oncología Manel Esteller. "Ahora es como un matrimonio, pues nos hemos dado cuenta de que es sólo la base desde la que debemos reconstruir y entender la biología molecular del cáncer", añade.

La tecnología plantea un futuro más prometedor. La secuencia completa del PGH se publicó en 2003. Costó unos 2.000 millones de euros y se tardó más de diez años en lograrla. Ahora, la tercera generación de máquinas lectoras de ADN hacen lo mismo en meses y por algo más de mil euros, tal y como anunció el año pasado una empresa estadounidense. Estos avances traerán una nueva era de medicina personalizada en la que los médicos diagnostiquen y traten a cada enfermo de acuerdo con las particularidades de su ADN.

La antesala de ese futuro son los nuevos tests genéticos que se venden por Internet y que ofrecen información sobre enfermedades. Estos productos han ganado popularidad en los últimos años, sobre todo en EEUU, hasta el punto de que se han intentado vender en farmacias. Las dudas sobre su fiabilidad, utilidad y los riesgos de privacidad han hecho que el Congreso de EEUU abra una investigación a tres empresas líderes del sector.

"En el futuro, secuenciar nuestro genoma será rápido y barato y eso nos permitirá usar esa información para tratar distintas enfermedades", asegura la investigadora del CNIO María Blasco. "Pero la utopía de personalizar los tratamientos de acuerdo con el genoma de cada uno implica un gran desarrollo tecnológico y bioinformático", reconoce.

"En unos cinco años llegarán los primeros estudios del genoma completo de pacientes y conclusiones sobre su respuesta a fármacos como la quimioterapia, por ejemplo", señala Esteller. "Después, en unos diez años, se generalizarán estas prácticas que no curarán el cáncer, pero sí predecirán cómo reaccionará el paciente", añade.

Las factorías de secuenciación que hagan posible ese futuro no estarán en Europa ni EEUU, sino en Asia. China volverá a convertirse en el taller del mundo gracias a lugares como el Instituto BGI de Hong Kong, donde ya se secuencia el equivalente a un genoma humano cada 15 minutos y pronto se alcanzará la cifra de 10.000 secuencias al año. "Esta era nos traerá un nuevo boom excesivo de información", opina Bertranpetit. "Nos va a decir mucho más de lo que podremos entender", advierte.

Fuente: publico.es, 24-6-10

-Un grupo de escolares descubre una misteriosa cueva en Marte

|

Cueva marciana |

Un grupo de intrépidos estudiantes de entre 12 y 13 años que participaban en un programa educativo de la NASA, ha descubierto una cueva en Marte. Los 16 estudiantes de la clase de ciencia del maestro Dennis Mitchell, en la Secundaria Evergreen en Cottonwood,California, descubrieron lo que parece ser un tragaluz marciano: un agujero en el techo de una cueva en Marte. Los escolares participaban en el Programa de Imágenes Estudiantiles de Marte, en el Centro de Vuelo Espacial a Marte en la Universidad Estatal de Arizona. Dicho programa tiene como objetivo estudiar imágenes captadas por una nave espacial de la NASA que orbita alrededor del Planeta Rojo. "Esta fosa definitivamente es nueva para nosotros", le dijo Cushing a los estudiantes. "Y es apenas la segunda que se conoce asociada con el volcán Pavonis Mons". Cushing calculó que el cráter mide aproximadamente 190 por 160 metros de ancho y que tiene una profundidad de por lo menos 115 metros. Un hallazgo por sorpresaLos jóvenes investigadores se habían propuesto buscar en un principio tubos de lava, una característica volcánica común tanto en la Tierra como en Marte. La clase realizó una fotografía y una imagen de respaldo del volcán Pavonis Mons de Marte, enfocadas a una región de la que no se tenían imágenes de cerca. Las imágenes fueron tomadas por la sonda Mars Odyssey de la NASA, usando su instrumento THEMIS (acrónimo en inglés para Sistema de Imágenes de Emisión Térmica). Ambas imágenes mostraban tubos de lava, tal como habían esperado los estudiantes. |

Pero la fotografía de respaldo proporcionó otra sorpresa: un punto negro, pequeño y redondo. Era un agujero en Marte que conducía a la cueva enterrada, dijeron los investigadores.

Los estudiantes han presentado su sitio de investigación para que sea analizado con más imágenes captadas por la cámara HIRISE (siglas en inglés de Experimento Científico de Imágenes de Alta Resolución), que se encuentra en la nave espacial Mars Reconnaissance Orbiter, que podrían revelar detalles suficientes como para ver al interior del agujero en la superficie.

"El Programa de Imágenes Estudiantiles de Marte definitivamente es uno de los mejores programas educativos que se han desarrollado", afirmó Mitchell.

Fuente: elmundo.es, 24-6-10

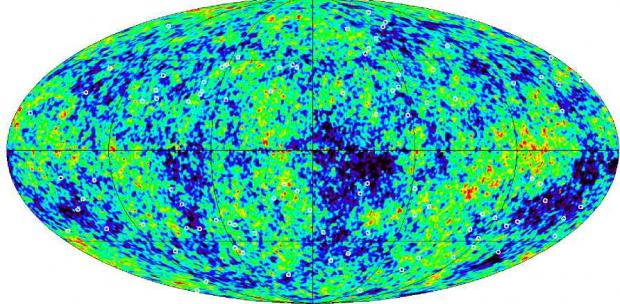

-Los cosmólogos toman medidas a la "partícula fantástica"

Los neutrinos apenas interaccionan con la materia, por lo que la atraviesan sin inmutarse, son como partículas fantasmas que podrían pasar a través de un bloque de plomo de un grosor de un año luz (nueve billones y medio de kilómetros) sin chocar con un átomo del metal. Están por todo el universo y billones de ellas atraviesan constantemente cada de centímetro cuadrado de tierra, agua o persona. Desde hace unos años se sabe, en contra de lo que se pensaba, que estas partículas tienen masa, pero muy pequeña, y es muy difícil medirla. Ahora, un equipo de cosmólogos del University College of London (UCL, Reino Unido) anuncia que la masa del neutrino no supera los 0,28 electronvoltios, lo que significa menos de una milmillonésima de la masa de un átomo de hidrógeno.

|

Su conclusión se basa en el análisis de la distribución de galaxias en el universo y es, según afirman estos científicos, la medida más precisa hasta ahora de la masa del neutrino. La investigación tiene implicaciones cosmológicas porque los neutrinos, tan abundantes como ligeros, podrían constituir una parte, aunque muy pequeña, de la enigmática materia oscura del universo, o parte de ella. Los cálculos más actuales indican que sólo el 4,6% del cosmos está hecho de materia corriente, mientras que un 23,3% debe ser materia oscura, cuya presencia se nota por su efecto gravitacional, pero no brilla de ningún modo; el resto, un 72,1% sería energía oscura, algo mucho más misterioso aún. Ofer Lahav, Filipe Addalla y Shaun Thomas (cuya tesis doctoral es la investigación en cuestión sobre la masa máxima del neutrino) presentarán sus resultados detallados en la revista Physical Review Letters, pero de momento han dado a conocer sus conclusiones en un congreso celebrado en Londres. "Aunque los neutrinos suponen menos del 1% de toda la materia, son una parte importante del modelos cosmológico, es fascinante cómo la esquiva y minúscula partícula puede tener tal efecto sobre el Universo", afirma Thomas en un comunicado del UCL. El descubrimiento de la masa de los neutrinos y la mayoría de los experimentos en curso para determinar su valor se basan en experimentos en los que estas partículas, tras recorrer grandes distancias, se transmutan de un tipo en otro (hay tres tipos de neutrinos). Las observaciones se hacen tanto midiendo los neutrinos procedentes del Sol, por ejemplo, como registrando en un detector los tipos de neutrinos que llegan de un haz de estas partículas disparado a centenares de kilómetros y que también en ese caso se transmutan de un tipo a otro mientras viajan. |

La distribución de galaxias se presenta en este mapa tridimensional del Sloan Digital Survey, desde la perspectiva de la Tierra en el centr- M.BLANTON / SLOAN DIGITAL SURVEY |

Pero Lahav y sus colegas han recurrido a otra estrategia completamente distinta, aprovechando la información que proporciona el mayor mapa tridimensional de galaxias que se ha hecho hasta ahora: el MegaZ, con 700.000 galaxias registradas en el proyecto de observación Sloan Digital Survey. Tal es la abundancia de neutrinos en el universo que su efecto acumulativo influye en la distribución de la materia, en gran medida condensada en grupos galaxias. Ellos han analizado el efecto de los neutrinos en la distribución de las galaxias en combinación con la apariencia del cosmos primitivo tal y como se refleja en la llamada radiación de fondo, que se emitió cuando el universo tenía algo más de 300.000 años (ahora tiene 13.700 millones) y que se mide en todo el cielo. Este análisis ha permitido establecer la máxima masa del neutrino, pero Abadlla considera que la técnica es tan eficaz que permitirá en el futuro afinar aún más ese valor.

Fuente: elpais.com, 23-06-10

-El hombre de Atapuerda ocupó Gran Bretaña

El Hombre de Atapuerca se está haciendo cada vez más europeo. Hace unos días, los responsables del yacimiento burgalés encontraron herramientas de más de 1,3 millones de años, lo que atrasa la fecha en la que el Homo antecessor, considerado el primer europeo, llegó a la sierra de Burgos. Su rastro se pierde hace unos 800.000 años. Ahora, un grupo de paleoantropólogos británicos ha encontrado restos que sugieren que, antes de desaparecer, el antecessor pudo ser el primer humano que se asomó al Támesis.

|

|

El batir del mar durante eras en las playas del este de

Inglaterra ha destapado el tesoro. Se trata de una fina línea de sedimentos

con 78 herramientas de sílex muy afiladas. Son el testimonio inequívoco de

presencia humana. Su edad, de entre 860.000 y 970.000 años, apuntan a un

candidato claro. "Lo más probable es que el que talló estas piedras fuese un antecessor, pues era la especie que más cerca estaba de Inglaterra, y su rango de edad en Atapuerca encaja perfectamente con el nuestro", explica a Público Chris Stringer, investigador del Museo de Historia Natural de Londres y uno de los responsables de las excavaciones en los arenales de Happisburgh, donde han aparecido los restos. Por ahora se trata sólo de una hipótesis, pues aún no se han hallado fósiles humanos como los que han aparecido en Atapuerca. Sin embargo, los colegas españoles de Stringer lo tienen claro. "Obviamente se trata de restos de antecessor", aventura Eudald Carbonell, codirector de Atapuerca. "Si se encuentran restos humanos se confirmará aún más que esta es la primera especie humana hecha en Europa y adaptada a este continente", detalla. La población humana destapada por Stringer y descrita en Nature es la más antigua hallada hasta el momento en el norte de Europa. |

La conexión Burgos-Happisburgh es plausible. Las herramientas halladas en Reino Unido "son comparables a las del antecessor y su tecnología es similar", acepta Stringer. Quienesquiera que fueran, los primeros humanos de Inglaterra pasaban las mismas fatigas que los antecessor de Burgos. "Su forma de vida pudo ser muy similar", explica Stringer. "Eran cazadores recolectores, tomaban carne de animales muertos o incluso los cazaban", detalla.

También hay grandes diferencias. El misterioso poblador británico habitó bosques de pinos similares a los del sur de Escandinavia. Sus herramientas han aparecido junto a restos de mamuts y caballos primitivos, así como especies de ciervos y roedores extintos. El lugar no podría ser más emblemático, pues se encontraba a orillas del Támesis, que en aquella época pasaba a 150 kilómetros al norte de lo que hoy es Londres.

"Los restos demuestran que eran muy inteligentes", opina Mike Field, investigador de la Universidad de Leiden (Holanda) y coautor del estudio. "Hubieran sido muy buenos biólogos, pues sabían identificar y trabajar las mejores piedras y las mejores plantas en su provecho", detalla.

Los expertos creen que estos pobladores aprovecharon un periodo de clima más cálido para llegar hasta Gran Bretaña desde refugios cálidos en Europa como el de Atapuerca. Cruzaron por un pasillo de tierra natural que desapareció hace 450.000 años. Supieron adaptarse al frío y la vida en nuevos bosques. "Eran poblaciones pequeñas y móviles; en épocas más frías pudieron volver a migrar hacia el continente, tal vez hacia lo que hoy es Holanda", detalla Field.

Atapuerca era por aquel tiempo una especie de sabana mediterránea. Las antiguas cuevas que habitaron los antecessor están hoy llenas de sedimentos y, de no ser por las voladuras realizadas a finales del siglo XIX para construir un ferrocarril, seguirían a decenas de metros bajo tierra. De uno de los yacimientos más antiguos del lugar, la Sima del Elefante, acaban de salir dos herramientas líticas que parecen indicar que la presencia de los humanos en este lugar es más antigua de lo que se pensaba. Los responsables del yacimiento presentarán hoy estos y otros hallazgos y mañana recogerán los bártulos hasta 2011. "Tengo muy buen olfato y creo que el año que viene puede haber sorpresas ", aventura Carbonell.

Sus homólogos ingleses no tienen tantas esperanzas. "Nuestro yacimiento fue un lugar de actividad en la ribera, pero aquellos humanos no vivían aquí", comenta Field. Los expertos creen que los asentamientos estaban tierra adentro, en el corazón del bosque, donde hoy extraer fósiles es casi imposible. Si el hielo de las glaciaciones no los ha arruinado, los excavadores tendrían que abrirse paso a través un lecho de roca para encontrarlos. "Sería un trabajo ímprobo", explica Stringer. "Por el momento vamos a concentrarnos en la ribera, donde esperamos encontrar huesos humanos algún día", concluye.

Fuente: publico.es, 23-6-10

-El espacio para la investigación de mecánica cuántica

El espacio es el lugar ideal para realizar experimentos de mecánica cuántica con la mayor precisión posible, ya que la gravedad no afecta a las medidas, explican los investigadores del proyecto Quantus en la Universidad de Hamburgo. Además, estos experimentos permiten acercarse a las fronteras de dos campos de la física básicos pero que siguen separados, sin que se hayan podido conectar hasta ahora: la gravedad y la mecánica cuántica

|

Sin embargo, son estudios muy difíciles de diseñar y de realizar, ya que el sujeto de experimentación es materia muy delicada: los condensados de Bose Einstein, grupos de átomos que a muy bajas temperaturas están en idéntico estado cuántico y pierden su individualidad para comportarse conjuntamente como una partícula cuántica única. Hasta 1995 no se lograron crear estos conjuntos de átomos predichos por los físicos que los bautizaron y que ya han sido objeto de un premio Nobel. El primer paso hacia el estudio cuántico en condiciones de microgravedad lo han dado los investigadores del proyecto citado al lograr dejar caer repetidamente un experimento con un condensado de Bose Einstein, con láseres y todo, desde una altura de 146 metros sin que cambiara su naturaleza. Toda una proeza técnica que permite pensar en futuros experimentos espaciales, que podrían poner a prueba con mayor precisión la teoría de la relatividad general de Einstein y revelar las propiedades gravitatorias de la materia cuántica. Los resultados se publican en la revista Science. Las caídas libres, analizadas al detalle, se han hecho en el interior de la torre de experimentación ZARM, en Bremen. En estas condiciones, la gravedad en el interior de la cápsula que contiene el experimento es hasta 100.000 veces inferior a la terrestre. Así, los investigadores, de Alemania, Reino Unido y Francia partieron de unos 10 millones de átomos de rubidio-87 enfriados a temperatura muy baja. Se cargaron en una trampa magneto-óptica en el interior de la cápsula de caída, un cilindro de 60 centímetros de radio por 215 centímetros de altura. Durante la caída, los átomos se siguen enfriando con láseres hasta conseguir crear un condensando de Bose Einstein de unos 10.000 átomos. Luego, el conjunto se libera con delicadeza de la trampa para que se expanda muy despacio, mientras se ilumina con un láser y se capta con una cámara electrónica. Los experimentos en la torre de Bremen son parecidos en diversos aspectos a los de una plataforma espacial, explican los investigadores, lo que les exigió un gran esfuerzo de miniaturización y limitación en el peso y en la potencia consumida en el diseño de los componentes mecánicos, ópticos y electrónicos. El resultado fue la cápsula más compacta y pesada de las que se han tirado hasta ahora en la torre de Bremen. Las medidas han indicado que el movimiento del condensado dentro de la cápsula se debe a campos magnéticos residuales y no tiene origen gravitatorio. Por eso, los investigadores han comentado a la revista Physics World que quieren repetir el experimento con átomos en un estado cuántico ligeramente diferente, que no resulten afectados por los campos magnéticos y permitan tomar mejores medidas gravitatorias. |

Torre de experimentos de Bremen |

Según Ernst Rasel, director del equipo, el objetivo es estudiar los condensados en el espacio, donde se harían experimentos de interferometría que permitirían detectar pequeñísimas variaciones en la gravedad. Así se buscarían ondas gravitacionales, cuya existencia se supone pero no se ha confirmado, y se podría comprobar con mucha precisión el principio de equivalencia de la teoría de la relatividad general.

Fuente: elpais.com, 23-6-10

-El ancestro de "Lucy" ya andaba de pie

Los huesos de un nuevo australopiteco desenterrado en Etiopía acaban de corroborar que estos posibles antepasados del hombre ya andaban siempre sobre dos piernas hace 3,58 millones de años. Así lo creen los investigadores de EEUU y Etiopía que en 2005 hallaron el esqueleto más antiguo y completo de un Australopithecus afarensis adulto, al que han llamado Kadanumu. Significa hombre grande en afar, la lengua que se habla en la región al norte de Etiopía donde se encontraron sus restos.

"Esta especie ya no mostraba rasgos físicos de un animal que trepa por los árboles y se cuelga de ellos como el chimpancé", explica a Público Owen Lovejoy, investigador del Museo de Historia Natural de Cleveland (EEUU) y autor principal de la descripción de Kadanumu en PNAS.

|

Se trata del espécimen más completo desde Lucy, una afarensis encontrada en 1974 en Hadar, una localidad al sur de la región de Afar. Lucy fue un hallazgo histórico, pues conservaba parte de su cráneo. El esqueleto permitió determinar su sexo y que presentaba la estatura de una niña de 7 años actual. Sus descubridores concluyeron que, hace 3,2 millones de años, los afarensis tenían una capacidad cerebral mucho menor a la del hombre, pero ya andaban la mayor parte del tiempo sobre dos piernas. Las pruebas no bastaron a otros expertos, que opinaron que Lucy era más simiesca y probablemente no estaba equipada para vivir siempre sobre dos extremidades. Otra incógnita era la estatura de los afarensis adultos y cómo de desarrollado tenían su cerebro. El esqueleto de Kadanumu responde una de esas preguntas y deja la otra en suspenso. Los investigadores no han encontrado ni rastro de su cráneo. Sí han recuperado suficientes huesos de sus extremidades y tórax, incluidas su clavícula y algunas vértebras, que permiten concluir que los afarensis estaban equipados para andar tan bien sobre dos piernas como lo hace un sapiens. "Sus hombros y caja torácica nos muestran que eran más parecidos a los humanos de lo que pensábamos", explica Lovejoy. |

|

Los expertos concluyen en su artículo que el bipedalismo apareció muy temprano y que su diseño fisiológico permaneció prácticamente intacto durante millones de años, dadas las similitudes de la cadera de Kadanumu con la de un Homo erectus que vivió en Etiopía 2,2 millones de años después.

"Los resultados muestran que afarensis ya estaba muy avanzado en el camino evolutivo que llevaría a otros homínidos", opina Enrique Baquedano, director del Museo Arqueológico Regional de Madrid y excavador de la garganta de Olduvai en Tanzania, otra de las cunas de la familia humana.

Fuente: publico.es, 22-6-10

-Los pingüinos se mueren de frío en Sudáfrica

La isla, de 19 hectáreas, forma parte del Parque Nacional Addo Elephant, situado en la provincia del Cabo Oriental, en el extremo sureste de Sudáfrica, sobre el océano Indico.

'Los pollitos de los pingüinos empezaron a morir el pasado martes, cuando el tiempo extremadamente frío se juntó con fuertes vientos e intensos chubascos en la provincia del Cabo Oriental', dijo a la agencia local SAPA la directora de comunicación de la Administración de Parques Nacionales de Sudáfrica, Megan Taplin.

|

|

Los pollitos muertos, de entre pocas semanas y dos meses, son ya 600, después de que la isla registrara temperaturas de entre 8,8 y 12 grados centígrados en los tres días pasados, muy bajas para el litoral sudafricano. El frío estuvo acompañado por vientos de 95 kilómetros por hora y unas precipitaciones totales en 72 horas de 63,2 milímetros de agua, anormales en esta época del año. 'Los guardas del parque destinados en la isla utilizan todos los medios posibles para aliviar la situación, sin contar con ayuda del continente debido a la mala mar', agregó Taplin, quien explicó que facilitan refugios temporales a los pingüinos con los materiales que tienen a mano, además de retirar agua de los nidos. Taplin indicó que los pingüinos africanos no protegen a sus crías del mismo modo que los de la zona antártica y, aunque los pollos a veces están en madrigueras, otras salen junto a sus padres al aire libre. Algunos pingüinos heridos y los pollos abandonados han podido ser trasladados hoy en helicóptero a Port Elizabeth, donde existe un centro de rehabilitación para estas aves, habituales en el litoral sudafricanos pero considerados como especie en peligro. Los guardas esperarán a que sea posible el acceso por mar para evaluar la posibilidad de evacuar los pollos si sigue el mal tiempo en la Isla de los Pájaros, donde hay unas 700 parejas reproductoras. |

Desde el lunes pasado, el tiempo ha empeorado en toda Sudáfrica, con una pronunciada bajada de temperaturas y lluvias en las costas y un intenso frío en el interior, que ha obligado a los hincha del fútbol, que acuden al Mundial 2010, a acudir bien abrigados a los estadios, en algunos casos con temperaturas bajo cero. En Johannesburgo, donde se han llegado a alcanzar los 4 grados centígrados bajo cero en algunas zonas, hoy se produjeron atascos y problemas de tráfico, debido a que en algunas calles de la ciudad había placas de hielo, algo muy poco habitual.

Fuente: publico.es, 22-6-10

-"La evolución de la vida ya no es un fenómenos natural"

Craig Venter, el competidor privado en la carrera del genoma humano que concluyó hace 10 años, ha vuelto a saltar a los titulares por otro hito tecnológico: la construcción de la primera "célula sintética" , una bacteria con un genoma sintetizado en el tubo de ensayo de la primera a la última letra. Ayer presentó en Valencia su nueva expedición para catalogar la variedad microbiana del Mediterráneo.

Craig Venter en su yate en Valencia

Pregunta. ¿Espera encontrar formas de vida adaptadas a la contaminación del Mediterráneo?

Respuesta. Desde luego que sí. Algunos microorganismos mueren por la contaminación, y otros se adaptan a ella, así ocurre en todas partes. Los microbios españoles pueden muy bien ser distintos de los microbios griegos. El Mediterráneo se distingue del resto de los mares en que ha sido explotado por la humanidad durante mucho más tiempo, y también en que sus aguas tardan mucho más en renovarse, por no ser un mar enteramente abierto.

P. Hace unos años le pregunté cuántos genes había en el planeta Tierra y...

R. ¿Y qué le respondí?

P. Que era una cuestión muy profunda.

R. Pues sigue siéndolo. Antes de estos estudios de secuenciación en masa se conocían alrededor de un millón de genes. Ahora conocemos 40 millones, pero el ritmo de descubrimiento no muestra signos de saturación: el número de genes distintos sigue creciendo linealmente con la cantidad de muestras analizadas, y por tanto seguimos sin saber cuántos genes puede haber en total en el planeta. En cada centímetro cúbico de mar hay un millón de bacterias y 10 millones de virus, y la variedad es enorme. La mayor parte de esta diversidad consiste en adaptaciones únicas al medio ambiente local: a la intensidad de la luz solar, la temperatura o la contaminación en el entorno local.

P. Uno de los bioéticos más respetados del mundo, Arthur Caplan, comparó su último trabajo [la célula sintética] con los avances de Copérnico y Galileo.

R. Bueno, ¿cómo podría yo discrepar de eso?

P. La pregunta de Schrödinger: ¿Qué es la vida? [así se titulaba un influyente libro que el físico Erwin Schrödinger publicó en los años cuarenta].

R. Estoy escribiendo una versión moderna del libro de Schrödinger, espero tenerla lista en un año.

P. ¿Qué sostiene?

R. Creo que la construcción de una célula sintética que acabamos de publicar muestra que la vida está basada en la información. Esa célula se deriva enteramente de un genoma sintético, fabricado en el laboratorio a partir de meros compuestos químicos, y por tanto demuestra inequívocamente que el fundamento de la vida es la información genética.

P. ¿Podría transmitir esa información a otro planeta para generar vida allí? ¿O haría falta un starter que la hiciera arrancar?

R. La información no basta por sí sola para arrancar: hacen falta otros componentes para que la lean. La cuestión que aborda nuestro experimento es muy distinta del origen de la vida, no tiene nada que ver con la evolución real, con la forma en que la vida surgió realmente en el planeta Tierra. Nuestro trabajo no afecta a esa cuestión. Si uno está diseñando un nuevo coche de carreras, realmente no le importa para nada quién fabricó el primer motor de explosión ni quién inventó la rueda. Simplemente, usas todo ese conocimiento previo y construyes a partir de él. No estamos tratando de recapitular la evolución biológica, sino de utilizarla como punto de partida para hacer nuevos organismos.

P. ¿Hay un texto, una secuencia de ADN, que define la frontera entre la vida y la materia inerte?

R. Hay muchos, y algunos pueden consistir en una sola letra. Por ejemplo, nuestro primer intento de construir la célula sintética no funcionó, y pudimos comprobar después que la razón fue un solo error, una sola letra que faltaba en una secuencia de un millón de bases. En este caso, esa sola letra supone la diferencia entre lo vivo y lo inerte.

P. ¿Cuán lejos estamos de escribir un genoma original, en lugar de copiar uno de una bacteria real?

R. En realidad nadie lo está intentando siquiera. Los genes de los organismos naturales son tan diversos que todos los proyectos tecnológicos actuales se basan en modificar o recombinar genes ya existentes. No sabemos escribir un nuevo gen a partir de cero. En cierto sentido, sí podemos ahora escribir genomas desde cero, genomas que no existen en la naturaleza, pero lo hacemos ensamblando genes naturales en nuevas combinaciones, o genes naturales modificados artificialmente.

P. ¿Se puede aumentar la eficacia de un proceso natural con esas modificaciones? ¿Es eso una forma de evolución artificial?

R. Sí, estamos tomando el relevo a la biología: la evolución ya no es un fenómeno natural. Mediante el diseño de nuevos genes y organismos, podemos adelantarnos a la evolución en miles de millones de años. El árbol de la vida tiene a partir de ahora unas ramas enteramente nuevas. Ramas sintéticas. Son perfectamente distinguibles de las ramas naturales por las marcas de agua que introducimos en sus genomas.

P. ¿Qué son esas marcas? ¿Es cierto que han escrito ustedes sus direcciones de correo electrónico?

R. Se trata de un código dentro de otro código dentro de otro código. Tienes que descifrar el primer código para empezar a entender el siguiente y, en efecto, en un paso determinado te puede aparecer el correo electrónico de un científico al que tendrás que escribir para seguir adelante. También hemos escrito los nombres de 50 científicos implicados en el proyecto, y algunas citas eruditas.

P. ¿Cuán lejos estamos de reconstruir un mamut, o un neandertal?

R. Creo que no estamos muy lejos de un objetivo previo, que es construir células eucariotas [el tipo de células de los que estamos hechos los animales y las plantas] con fines industriales.

P. Hemos publicado las críticas que le hizo el premio Nobel John Sulston...

R. ¡¿Por qué?! [risas]. Quiero decir, hay críticas inteligentes, pero las de John Sulston [contra los planes de Venter de patentar aspectos de la célula sintética] no tienen el menor sentido. Yo no estoy a favor de patentar seres vivos, ni genes naturales, pero si quieres desarrollar una bacteria que produzca biofuel a partir del CO2 atmosférico y la energía solar, necesitas proteger la tecnología con patentes que justifiquen las inversiones. Esto tiene muy poco de nuevo, realmente.

Fuente: elpais.com, 22-6-10

-La China científica antes socia que rival

Si el crecimiento arrollador de la economía china tiene pendiente a todo el planeta, con mucho de asombro y no poco de temor, igualmente lanzada, o más, va su ciencia. Los expertos no le quitan ojo a la trayectoria espectacular del gigante asiático en I+D en los últimos años. China tiene ya tantos científicos como la Unión Europea o como Estados Unidos, casi un millón y medio, y sus ambiciones son espectaculares, pese a que no faltan problemas, como bajos salarios, instituciones rígidas o, al hablar de transferencia de tecnología, un difícil sistema de protección de la propiedad intelectual.

|

Científicos chinos |

"Invertimos ahora un 1,5% del producto interior bruto en I+D y nuestro plan es alcanzar el 2,5% en 2020", destaca Cao Jianlin, viceministro de Ciencia y Tecnología chino. Para valorar la magnitud de estas ambiciones baste recordar que con el 1,5% del PIB, China ya supera a España (1,3%) y se acerca a la media de la UE (1,9%), aunque queda aún lejos de Estados Unidos, con el 2,6%. Hablar en este caso de país emergente, empieza a ser irreal. La imagen de la masiva producción barata, estándares limitados de calidad, imagen y poco valor añadido que ahora se tiene de ese país, puede quedarse anticuada pronto si el actual esfuerzo da los frutos que los dirigentes de Pekín esperan. "China es muy rica en recursos humanos", añade Cao. "Actualmente trabajan en entornos relacionados con I+D unos 40 millones de personas y el crecimiento anual es de dos millones". Salud, medio ambiente, energía, agricultura, oceanografía, nanotecnología, información y comunicación, transporte, nuevas tecnologías y ciencias básicas en general son sus áreas prioritarias. No hay que olvidar el espacio, con China como tercer país (tras EE UU y Rusia) capaz de poner en órbita a sus taikonautas con sus propios cohetes, pero esta es otra cuestión: el espacio se desarrolla en el estricto ámbito militar y sólo se toca de puntillas en el civil. |

Con este escenario expansivo en un país de tal envergadura, no es de extrañar que los países desarrollados no solo estén muy pendientes de la China científica y tecnológica, sino que busquen y desarrollen escenarios de cooperación.

La Comisión Europea está estrechando lazos con la ciencia y la ingeniería del gigante asiático con diferentes actividades, desde acoger a los científicos chinos en su Programa Marco (el principal programa comunitario de I+D) hasta intercambiar investigadores en proyectos conjuntos. Recientemente, la Comisión Europea y China han celebrado una semana dedicada la ciencia común en Shanghai, en marco de la Exposición Universal, con participación de medio millar de científicos de los dos lados. Más de 30 proyectos científicos y tecnológicos fueron presentados y discutidos en las sesiones por los expertos europeos y chinos. El abanico de temáticas se extendió desde la biomedicina o la energía, hasta el agua y la planificación sostenible de la ciudad.

"China es un objetivo estratégico de la UE en ciencia y tecnología", declara José Manuel Silva director general de I+D de la Comisión Europea, quien recuerda que la investigación y la innovación "son absolutamente centrales en la recuperación económica europea tras la crisis global".

Pekín, por su parte, reconoce que necesita colaborar con potencias como Estados Unidos y Europa, además de Canadá o Japón. Han Jianguo, director de la Fundación Nacional de Ciencias Naturales, explicó en el encuentro: "Nuestra institución mantiene acuerdos de trabajo conjunto con 68 agencias de 36 países, con un total de 29.000 proyectos de cooperación".

La nueva potencia asiática se va haciendo notar en todos los ámbitos. El 7º Programa Marco (2007-2013) de la UE, que moviliza 54.000 millones de euros y que es la principal fuente de financiación de la I+D comunitaria (aunque solo supone el 5% de la inversión de la UE, correspondiendo el resto a los programas nacionales), admite propuestas de equipos científicos extracomunitarios, explicó en Shanghai Jean Michel Baer, director de Ciencia, Economía y Sociedad de la Comisión Europea. Pues bien, solo en los tres primeros años se recibieron 900 propuestas de investigadores chinos para colaborar en el 7º Programa Marco y, tras las rigurosas evaluaciones, se seleccionaron 152 (centradas en tecnologías de la comunicación y la información, medio ambiente, alimentos, transporte y salud), con una financiación total de 28 millones de euros (dos tercios son financiados por la UE y un tercio por China), explica Baer.

El país asiático se ha convertido ya en el tercer socio por volumen de proyectos de colaboración en el Programa Marco, tras EE UU y Rusia. En perspectiva, según Baer, "está la puesta en marcha de proyectos de colaboración de China y Europa como socios igualitarios".

La crisis económica mundial no ha perdonado al ambicioso plan de I+D de Pekín y este año el incremento de la inversión ha sido solo del 8%, frente a un 30% en 2009 y un 27% en 2008. Mientras tanto, los países desarrollados que lideran hasta ahora el mundo de la ciencia y la tecnología han tenido que contentarse con crecimientos modestos o afrontar, como es el caso de España, dolorosas reducciones presupuestarias.

La Academia de Ciencias China lanzó el año pasado una hoja de ruta con 18 áreas (incluyendo agricultura, ecología, salud, energía y oceanografía) consideradas clave para preparar "una revolución tecnológica e industrial".

Es lógico que el espectacular despertar chino en ciencia y tecnología no esté exento de dificultades y algunos cuellos de botella. Los científicos chinos, por ejemplo, son los peor pagados entre las potencias asiáticas emergentes, señalaba recientemente la revista Nature.

Otro problema que puede manifestarse en el futuro es la gran concentración geográfica del esfuerzo científico y tecnológico, con sus repercusiones industriales. Esto responde, en la actual fase de crecimiento acelerado, a una optimización de recursos, pero que a la larga puede dejar en herencia unas desigualdades notables en el extensísimo territorio del país. Oficialmente se ha definido 56 polos de alta tecnología, señala Cao, pero la I+D está concentrada en unas cuantas ciudades: Pekín, Shanghai, Guangzho, Shenshen, Guangdon, Nanjin, Wuhan y poco más. Una docena de universidades en todo el país concentran el I+D de alto nivel.

La presencia masiva de estudiantes y jóvenes científicos chinos en países desarrollados (EE UU, sobre todo) debe ser temida como fuga de cerebros, pero a medida que el gigante asiático crece empieza a atraer hacia casa a especialistas bien formados en el extranjero. Ante esta realidad, ya se habla en algunos países, y China lo prefiere, de circulación de cerebros, más que de captación y fuga.

Es el caso, por ejemplo, de Wang Jun, un genetista doctorado en la Universidad de Pekín en 2002 y premiado por el Ministerio de Educación de su país, que, tras una estancia de formación altamente productiva en Dinamarca, ha pasado a dirigir un grupo de 100 investigadores dedicado a la genómica e informática en su país. También es el director del prestigioso Instituto de Genómica de Pekín.

En el encuentro de Shanghai, Wang, presentó trabajos de su instituto en el genoma del cerdo, en estudios de metagenómica y microorganismos del aparato digestivo, de variabilidad del genoma del arroz y del gusano de seda, así como de los mecanismos de procesos de domesticación a nivel molecular, un elenco que nada tiene que envidiar a potentes institutos de investigación de países desarrollados.

Aún así, el rígido sistema chino adolece aún de impulso y oportunidades favorables para los jóvenes investigadores. "Este es el mayor problema que el sistema de ciencia y tecnología chino afronta", avisó el matemático y profesor de Harvard Shing-Tung Yau.

Otra pega que se puede encontrar el sistema chino de I+D obedece a la potencial inadecuación de las instituciones de política científica, por lo que los expertos advierten que el país debería emprender una reforma profunda que ponga a punto los organismos adecuados de gestión Por ejemplo, un sistema eficaz de evaluación de proyectos y resultados para distribuir adecuadamente la financiación.

La escasa transparencia en este caso y la concentración de decisiones en unos pocos organismos, o incluso personas, no es la vía más eficaz, en comparación con la estructura, de corte anglosajón, pero extendido a todos los sistemas científicos desarrollados, incluido el español, de evaluación entre pares de proyectos y resultados. Y cuanto más transparente e independiente sea el sistema, mejor.

Si la UE, como declara Silva, ha asociado recuperación a la economía del conocimiento y está decidida a "situar la investigación y la innovación en centro de todas las políticas europeas", China coincide en la estrategia: "Hacemos mucho énfasis en el desarrollo y la innovación", defiende Han. Su número de patentes crece a buen ritmo: en 2007 se presentaron 153.000 solicitudes, frente a 122.518 el año anterior, según datos de la Organización Mundial de la Propiedad Intelectual.

Ahora bien, a la hora de combinar este ímpetu con la colaboración en I+D industrial y la transferencia de tecnologías, los expertos destacan lo difícil que resulta para los occidentales desenvolverse en el complejo sistema de patentes y protección de la propiedad intelectual del país asiático.

De momento, China ha pasado de 3,1% del volumen total mundial de publicaciones científicas en 1998 al 10,6% una década después. Su irrupción en el panorama internacional ha redistribuido la tarta de la ciencia mundial que hasta hace no mucho era exclusiva de los países consolidados en I+D. Japón ha pasado del 7% de la producción científica mundial al 5% en 10 años; la UE ha bajado del 32% al 29% y EE UU, del 27,4% al 20%. La pujante China se ha hecho hueco en la cantidad de producción científica, pero todavía tiene que superar el reto de la calidad, notablemente inferior a su potencial. Tras el impetuoso crecimiento de la ciencia, cuando China dé la patada en la calidad, se hará oír muy fuerte, vaticinan los especialistas.

- Esfuerzo creciente. China invierte 102.000 millones de dólares en I+D al año, mientras que EE UU se sitúa en 368.000 millones y la UE en 263.000. En los últimos 10 años ha multiplicado por nueve su inversión en ciencia y tecnología.

- Prioridades. El plan de Pekín de investigación a medio y largo plazo y sus áreas prioritarias son muy similares a las de la UE, con énfasis en eficiencia energética, contaminación, intensificación agrícola e innovación.

- Ciencia básica. China es el país en desarrollo que más énfasis está poniendo en el avance de la investigación básica, afirma Cao Jianlin, viceministro de Ciencia.

China proclama su interés en la investigación y las tecnologías relacionadas con energía limpia. Con sus reservas de carbón (es el mayor productor del mundo), la fuerte presión del crecimiento energético acompasado a su desarrollo y la perspectiva de tener que comprometerse en algún momento a contener sus emisiones de gases de efecto invernadero que provocan el calentamiento, no extraña que Cao Jianlin, viceministro de Ciencia y Tecnología del gigante asiático, sitúe el cambio climático y el medio ambiente como área prioritaria de su política científica.

Además, el problema acuciante y creciente de la contaminación que sufre el país no es ajeno a esta estrategia de política científica. "Necesitamos ayuda y transferencia de tecnología de los países desarrollados", declaró Cao en la reunión UE / China en Shanghai. Señaló que para China la energía verde y la eficiencia energética para reducir la intensidad de su industria (energía invertida por unidad producida) depende, en gran medida, de la cooperación internacional.