|

|

|

|

|

|

|

|

![]()

NOTICIAS CIENTÍFICAS

--Nuevas Noticias Próximamente--

![]()

TITULARES DE LAS NOTICIAS DEL MES

Friederich Nietzsche: ciencia y cultura sobre arenas movedizas

Un ex peón israelí resuelve un problema matemático planteado hace 40 años

Extraen un riñón por la vagina de una mujer con cáncer

Desarrollan una nueva forma de extracción de energía del mar

Los biocombustibles son un callejón sin salida, según un experto británico

La NASA inicia las pruebas de los primeros cohetes para ir a la Luna

Un proyecto de la UE aspira a lo último en miniaturización: máquinas moleculares

El "nobel" de las matemáticas premia un trabajo sobre simetrías

El cocodrilo prehistórico de Pernambuco

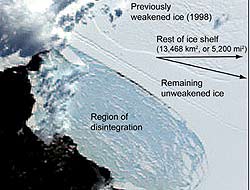

Se derrumba una placa de hielo de 500 kilómetros cuadrados en la Antártida

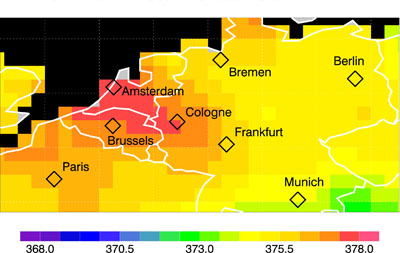

Primeras imágenes de satélite de las emisiones de dióxido de carbono por regiones

Un humano de más de un millón de años en Atapuerca

Mientras unos piensan en mandar hombres a Marte, a los rovers se les acaba el presupuesto

Los volcanes de Venus son parecidos a los de la Tierra

Logran la transmisión sin cables más rápida de la historia

El planeta pierde cada día una masa forestal equivalente a 40000 campos de fútbol

¿Por qué los seres humanos creen en Dios?

"Mars Odyssey" descubre depósitos de sal en Marte

Hubble detecta moléculas orgánicas en un planeta extrasolar

Internet nuevo campo de batalla

La NASA confirma la reducción del espesor de las capas más antiguas del hielo Ártico

Descienden menos de lo esperado las emisiones de dióxido de carbono en España

300000 años separan a sapiens y neandertales

El enigmático "ojo del huracán" en Venus

Un yacimiento en Granada revela indicios del primer homínido europeo

El mayor experimento del mundo

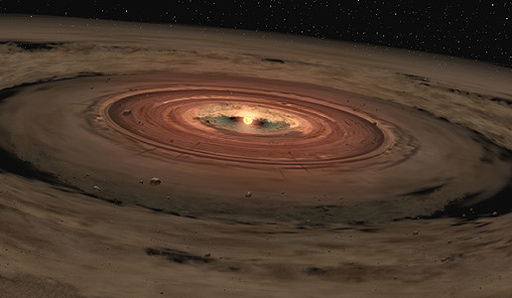

Spitzer detecta grandes cantidades de moléculas orgánicas y vapor de agua

La NASA hace sus primeros ensayos con la cápsula Orión

La agencia Efe reescribe la ciencia: el dióxido de carbono es contaminante

La nave espacial "Endeavour" parte hacia la Estación Espacial Internacional

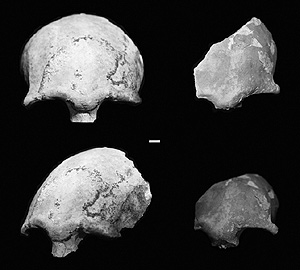

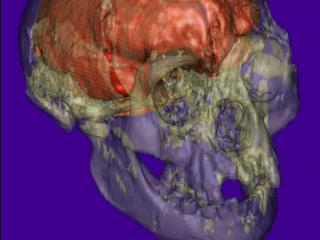

Hallan nuevos esqueletos de homínidos enanos

Cambio climático: la desaparición del Ártico, la muerte de focas y el temporal en Europa

El chip que imita al cerebro humano

La conquista del mar en Gran Canaria

Hallan los restos de un lago habitable en Marte

Un robot nunca sustituirá a un cirujano

Leer la mente escaneando un cerebro

"Que la evolución sea ciega pone nerviosa a mucha gente"

Venus y Marte más casi idénticos en las capas altas de la atmósfera

Las playas canarias pueden retroceder 50 metros por el cambio climático

El número de muertes por la mala calidad del aire se puede cuadriplicará

Un buque japonés de 200 metros estudia el origen de los terremotos y los tsunamis

El "hobbit" indonesio no es una especie humana

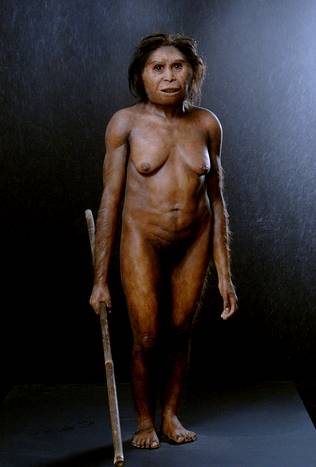

Avalanchas de hielo y polvo en el polo norte marciano

Las sondas sufren unas extrañas anomalías en sus velocidades

Las mujeres prefieren a los solteros durante los días más fértiles del ciclo

Las bacterias hacen llover en todo el mundo

El futuro y la obra de arte hecho robot

-Friederich Nietzsche: ciencia y cultura sobre arenas movedizas

|

Nitezsche |

«Vallejo escribiendo de la soledad mientras se muere de hambre hasta la muerte; // la oreja de Van Gogh rechazada por una puta; // Rimbaud huyendo al África en busca de riquezas y hallando un incurable caso de sífilis; //Beethoven por siempre sordo; / Pound arrastrado a través de las calles en una jaula; // Chaterton bebiéndose el veneno para las ratas; //el cerebro de Hemingway que chorrea y cae dentro de un vaso con jugo de naranjas; //Pascal abriéndose las venas en la bañera; //Artaud encerrado en el manicomio;// Dostoievsky empujado hacia el muro // Lorca fusilado al borde del camino por la guardia civil española: Eso es lo que quieren: un maldito show /una cartelera de neón encendida en medio del infierno. Eso es lo que quieren, /ese montón de aburridos inarticulados protegidos, monótonos amantes de los carnavales»

|

Friedrich Nietzsche, a través de “Sobre Verdad y Mentira en sentido Extramoral y la Gaya Ciencia”, intenta mostrar cómo el edificio de la ciencia se alza sobre la arena movediza del origen ilógico del lenguaje que le sirve como vehículo para expresar sus “verdades”. Según este autor vivimos pensando bajo la influencia de los efectos de lo ilógico. Nos encontramos profundamente sumergidos en ilusiones y ensueños; nuestra mirada se desliza sobre la superficie de las cosas y percibimos “formas”, en ningún caso nos acercamos a la verdad. Entre dos esferas totalmente distintas como lo son el sujeto y el objeto no existe ninguna expresión adecuada, sino una conducta estética, un extrapolar alusivo, un traducir balbuciente a un lenguaje completamente extraño. La esencia de las cosas no se manifiesta en el mundo empírico. Es esa fuerza mediadora la que nos permite poetizar e inventar. “…conocer es simplemente trabajar con la metáfora favorita de uno… la construcción de metáforas es el instinto fundamental del hombre.”

Con la metáfora del edificio de la ciencia sobre la arena movediza de lo ilógico, Nietzsche intenta echar por tierra razones últimas, certezas, dogmas, valores, que constituían el fundamento de la realidad y del conocimiento. Aborda el problema de la verdad estableciendo una conexión con el lenguaje. Muestra su carácter metafórico y su enmascaramiento de la verdad; ésta surge del tratado de paz que los hombres consideran necesario para constituir una sociedad. En ese mismo momento se fija lo que ha de ser “verdad”; “…se ha inventado una designación de las cosas uniformemente válidas y obligatorias.” Se establecen los cánones de lo verdadero y de lo falso, pero lo cierto es que estos cánones también surgen en el seno de una convención: el lenguaje. Por lo tanto “el poder legislativo del lenguaje proporciona las primeras leyes de verdad, pues aquí se origina por primera vez el contraste entre verdad y mentira.”

Lo verdadero y lo falso se fijan en el marco de las normas lingüísticas. De esta manera Nietzsche muestra el carácter doblemente convencional de la verdad. Verdad que en su génesis conlleva la mentira y el error, por ser precisamente una metáfora nacida del lenguaje que a su vez es incapaz de “apresar” la esencia de las cosas. Si la palabra queda definida por su carácter doblemente metafórico; es la copia en sonidos de una impresión sensible: un impulso nervioso se extrapola en una imagen, primera metáfora, y esa imagen se transforma en un sonido: segunda metáfora; en consecuencia el lenguaje es en esencia metafórico. La palabra no designa la cosa, no expresa la realidad: “…se limita a designar las relaciones de las cosas con respecto a los hombres y para expresarlas apela a las metáforas más audaces.” Pero en esta relación no se aprehende la esencia de las cosas, ella es fruto de la necesidad de humanizar el mundo, de interpretarlo desde una visión humana.

Sin embargo el hombre tejió una complicada red de conceptos con los cuales creyó alcanzar la verdad; los creyó universales y necesarios, y los opuso al mundo primitivo de las intuiciones con la intención de configurar un mundo más humano, más regular y más lógico. Para Nietzsche, los conceptos se han formado dejando de lado lo individual, lo real, olvidándose que derivan de una metáfora, e incluso que ellos mismos son metáforas olvidadas. Por lo tanto no son más que ficción, engaño, ilusión, por haber nacido como olvido pero también porque tiene como base a la metáfora. En la Gaya Ciencia, Nietzsche dice que sólo basta inventar nuevos nombres para crear nuevas cosas.

Para crear el “mundo verdadero” el hombre debió inventar primero la verdad, él mismo debió concebirse como un ser sencillo, transparente, sin contradicciones. Junto a ese mundo verdadero creó el “mundo aparente” y se vio en la obligación de falsear no sólo al mundo sino a sí mismo. Transportó erróneamente las categorías de la razón a la realidad, olvidando que sólo se trataba de ficciones que habían servido para hacer soportable el mundo.

La instauración de ese “mundo verdadero”, establece la oposición realidad-apariencia, que bajo la perspectiva de Nietzsche quedará anulada al fragmentar la noción de verdad y al tomar a la vida toda como apariencia.

Nietzsche se coloca fuera del paradigma de la racionalidad, violenta la lógica, instaura dicotomías no excluyentes. De ahí que el “mundo verdadero” sea para él, el resultado de un largo error: el hombre necesitó encontrar razones a la existencia, mitigar la angustia ante el caos, y para no sufrir se vio en la necesidad de inventar un mundo “más humano” y “sin contradicciones.” Las ficciones pasaron a constituirse en las verdades más profundas. Pero esta búsqueda incansable de lo imperecedero, de la no contradicción fue para Nietzsche una oposición a la vida, a tal punto que definió a la verdad como un principio destructor que acaba con la voluntad de vivir.

El hombre vive con cierta calma y seguridad, “gracias a que se olvida de sí mismo como sujeto creador, y por cierto como sujeto artísticamente creador; pero si pudiera salir, aunque sólo fuese un instante, fuera de los muros de esa creencia que lo tiene prisionero, se terminaría en el acto la conciencia de sí mismo.” Cuando el hombre vive de manera inconsciente su papel de creador, cree que el lenguaje y los conceptos que arma, dicen el mundo verdadero, y cree en su yo como el origen de todos sus pensamientos. Sin embargo si fuese consciente de que es interpretado y pensado por el propio lenguaje cuya esencia es metafórica, perdería toda sustancialidad, transformándose en ficción, sin unidad, sin identidad.

Imaginación

Si bien el autor que nos ocupa señala que las verdades son ficciones útiles para

la autoconservación de la especie, el mismo principio de conservación es una

ficción más. En la “Gaya Ciencia”, afirma con claridad: “no poseemos órgano

alguno para el conocimiento, para la verdad; sólo sabemos o creemos saber lo que

conviene que sepamos en interés del rebaño humano, y hasta lo que llamamos en

este caso utilidad no es más que una creencia, un juego de la imaginación o tal

vez esa necedad funesta que algún día hará que perezcamos.”

Para Nietzsche algo es verdadero no porque sea útil, sino porque creemos en su utilidad. Reconocemos a algo como “verdadero” por la creencia, por la fe en ello, por el grado de antigüedad que lo convirtió en condición vital. La creencia es una instancia fundamental que está en la base de toda perspectiva.

No olvidemos que para Nietzsche el conocimiento parte del error de creer que existe una verdad exterior al sujeto que puede ser revelada, por eso le opone la interpretación como posibilidad de crear nuevas formas de ver el mundo sin estar supeditados a la verdad. Así, el mundo ya no aparece como objeto de conocimiento sino como objeto de creencia. La verdad se fragmenta en perspectivas; no existe una “verdad absoluta”sino una pluralidad de perspectivas sobre las cosas. Se destruye el mundo de las esencias; la “esencia, pasa a ser una opinión sobre la cosa, una atribución de sentido.”

Las cosas son lo que son para mí; no poseen una naturaleza independiente de aquél que las concibe; la realidad se reduce exactamente a esta acción y reacción particulares de cada individuo respecto al conjunto. Ya no nos es necesario seguir ciegamente las ideas creadas por los doctrinarios del fin de la existencia que configuraron el mundo verdadero tratando de instaurar la racionalidad a toda costa.

Ante nosotros, dice Nietzsche, camina un ideal particularmente seductor, lleno de riesgos. El ideal de un espíritu que de manera ingenua y en virtud de un poder exuberante, se burla de todos los criterios que hasta ahora fueron las cosas supremas de la humanidad, y que en realidad no fueron más que peligro, decadencia, rebajamiento y ceguera que nos llevaron al olvido de nosotros mismos.

Hay que liberar al hombre de todos los valores falsos devolviéndole el derecho a la vida y a la existencia. En ella es donde esos valores tradicionales pierden su poder, tal como lo expresa Nietzsche en su ineludible proclamación “Dios ha muerto”. El libre pensador debe olvidar los viejos conceptos y la moral que justifican la decadencia personal. La razón que parece ennoblecer al hombre con el tiempo se vuelve vulgar y necesita de ese grado de locura que la regenere. No es la locura la contrapartida de la razón, sino la creencia de que tenemos la verdad. Creencia que inspira aversión y frena el ritmo de los procesos espirituales; impacienta a los poetas y artistas en quienes irrumpe esa ansia de locura. Solo estos pueden ponerle ritmos a las palabras, renovarlas y pintar los pensamientos con nuevos colores. Por tal motivo Nietzsche exhorta a que la nueva filosofía se inspire en la poesía; porque es a través de la cadencia rítmica de las palabras como pueden despertarse las pasiones.

En nuestra pasión por conocer se ocultan el héroe y el bufón, descubrirlos nos permitirá gozar de la sabiduría y despertar nuestro instinto creador. Instinto que nos permite mantenernos por encima de las cosas y de la moral instaurada por los héroes. Necesitamos de la tragedia y la comedia. La risa y la alegría no le quitan sensatez a nuestros pensamientos, por el contrario reírse, lamentarse y maldecir son impulsos necesarios para contrarrestar la continua reaparición de esos eternos fundadores de morales y religiones: los héroes.

Es necesario encontrarle un sentido a

la vida, no debemos seguir pensando simplemente en la satisfacción de

necesidades vitales. Es hora de acabar con el mito positivista de la ciencia que

sólo pensaba en brindarles bienestar a las personas. La nueva filosofía debe

instaurar un nuevo pensamiento: la cantidad de placer debe estar en proporción

directa a la cantidad de displacer.

Para aniquilar la “realidad” no basta denunciar, es necesario crear, y para ello

es propicio abolir ese mundo ilusorio y falso que ha ignorado lo vital.

Nietzsche reclama el triunfo de los ideales dionisíacos mediante la utilización

metafórica del lenguaje como expresión de la voluntad de poder. Claro que

también es consciente que será necesaria una salud más vigorosa y tenaz. El

dionisíaco en tránsito hacia la obra de arte vital, será el que vive en

constante riesgo ante el carácter meloso y blando del sospechoso intelectual que

confirma el estado de las cosas, o lo que es lo mismo el Poder, con sus teorías

cobardes.

Es indudable que la teoría de Nietzsche revaloriza la capacidad creadora de la especie humana. En este sentido son una aportación invalorable al estudio del lenguaje y a la creación artística. Ambos productos de la actividad humana.

La particular mirada de Nietzsche sobre el lenguaje termina fragmentando la noción de verdad haciéndole perder el sentido, e introduce la idea del perspectivismo que le permite al hombre y al mundo recuperar su multiplicidad, su contradicción, su sin sentido, su falta de fundamento. Ruptura que admite al hombre y al artista en particular traspasar los límites impuestos por la forma literal del lenguaje, a través de la construcción de metáforas que llevan en sí una nueva visión, una nueva organización del universo, aclarando que lo realmente nuevo son las asociaciones que permiten ese nuevo orden.

Lo que puede ser pensado debe ser ciertamente una ficción, por eso la apariencia, la ilusión y la ficción no han de ser censurada, sino que deben permitir inventar irrealidades. La ficción se convierte en una matriz generadora de sentidos susceptible de infinitas interpretaciones. Con ella Nietzsche nos propone un nuevo tipo de razón que penetre en la zona de la irracionalidad del ser humano. Se trata de una razón narrativa, más compleja y delicada, que pueda referirse a la complejidad de lo humano y a sus posibilidades de experimentar la realidad. En contraposición al arte subordinado al logos, propone el triunfo de los ideales dionisíacos, mediante la utilización metafórica del lenguaje como expresión de la voluntad de poder, es decir, propone que el artista no reprima sus pasiones, o lo que es lo mismo lo vital. Esta libertad de la que habla Nietzsche, no puede sorprendernos si tenemos presente que en la historia muchos creadores la han buscado en el opio o la embriaguez.

Fuente: sunchaleshoy.es, 31 de Marzo de 2008

-Un ex peón israelí resuelve un problema matemático planteado hace 40 años

Avraham Trahtman no estaba buscando la fama en el momento de resolver el denominado problema de la ruta coloreada, un enigma matemático que tenía desconcertados a los más expertos matemáticos desde hacía cerca de cuatro décadas.

Sin embargo, debido no sólo a su edad –tiene 63 años– sino, también, a los antiguos trabajos que había ejercido en el pasado como peón y guardia de seguridad, Trahtman ha conseguido atraer sobre sí la atención de muchos especialistas en este ámbito científico, habiendo llegado, en la actualidad, a convertirse en una especie de luminaria de las ciencias matemáticas.

Dicho en términos más adecuados para las personas legas, el problema de la ruta coloreada, planteado por primera vez en el año 1970 por un equipo de matemáticos dirigido por los norteamericanos de origen israelita Benjamin Weiss y Roy Adler, presuponía que era posible crear un mapa universal en el que se proporcionaran las correspondientes direcciones hacia un punto determinado y sin importar el lugar desde el que se comenzara a buscar. Los expertos aseguran que la solución hallada por Trahtman podría tener importantes aplicaciones en el campo de la cartografía.

En el dibujo se puede observar se puede ver que saliendo desde un círculo cualquier

y siguiendo una ruta azul-rojo-rojo., azul-rojo-rojo, azul-rojo-rojo, se llega siempre al círculo amarillo

"Supongamos que alguien se encuentra perdido en una ciudad en la que nunca había estado anteriormente y tiene que hallar la casa de un amigo, pero en las calles de dicha ciudad no existe ninguna clase de señal indicativa. Y, a pesar de ello, consigue dar con la dirección", ha asegurado Stuart Margolis, colega del doctor Trahtman en la Universidad Bar-Ilan de Tel Aviv.

"En los círculos matemáticos, solemos hablar de ‘resultados maravillosos’ cuando se consiguen soluciones tan magníficas como inesperadas. Expresado, incluso, en términos legos, eso es algo absolutamente contrario a las expectativas lógicas, aunque, ciertamente, algunas veces ocurre", señala Margolis. El propio doctor Trahtman ha hablado sobre su solución al enigma: "La gente suele contemplar las cosas desde puntos de vista sumamente complicados. Y yo me limité a crear un simple algoritmo".

Pero, en el caso del doctor Trahtman no se trata, tan sólo, de mencionar el hecho de que su solución al problema le haya proporcionado el poder disfrutar del estatus de una gran celebridad, sino que es preciso destacar, asimismo, cuáles fueron sus orígenes.

Trahtman nació en el año 1944 en la ciudad de Yekaterinburg, en la Rusia central, y se dedicó a estudiar matemáticas "porque era la única cosa que podía hacer allí". Estando en la Universidad Técnica Estatal de los Urales, donde era profesor adjunto, dedicó todo su tiempo al campo del álgebra, disciplina muy pasada de moda por aquel entonces.

En 1992, el doctor Trahtman se unió a la ola de emigrantes judíos que aprovecharon la oportunidad de la descomposición de la Unión Soviética para solicitar la ciudadanía israelí.

Sin embargo, y a pesar de que la Ley de Retorno israelí prometía la residencia en aquel país para todos aquellos cientos de miles de rusos de ascendencia judía, dicha ley no garantizaba el mantenimiento en su nuevo país del anterior estatus de quienes se habían acogido a ella.

En consecuencia, y tal como le ocurrió a muchas otras personas, el doctor Trahtman tuvo que ponerse a trabajar de peón o como guardia de seguridad antes de que, finalmente, lograra volver a trabajar en el campo de las matemáticas, en esta ocasión como profesor interino. Más adelante, le fue concedido un puesto como investigador en la Universidad Bar-Ilan, después que el doctor Margulis le recomendara para ello ante el departamento de matemáticas de dicha institución.

Hoy día, el doctor Trahtman rara vez viaja hasta Tel Aviv, dado que prefiere trabajar desde su casa de Jerusalén. Y fue allí, precisamente, donde dio con la solución al famoso enigma.

"No podía creérmelo. La primera cosa que hice fue comprobarlo, intentando hallar alguna clase problema en la solución. Pero era todo muy simple, y no había ninguna clase de dificultad", ha asegurado el propio Trahtman.

El doctor Trahtman anotó la solución del enigma con un simple lápiz y sobre seis hojas de un cuaderno de notas. «Pensé que nadie iba a creer que un viejo como yo hubiera logrado hacer aquello. Y, ahora, hablan más sobre mi edad que acerca de mi solución al problema», comenta.

Fuente: elmundo.es, 31 de Marzo de 2008

Científicos estadounidenses aseguran que un ayuno de 48 horas hace que las células sanas de ratones de laboratorio aumenten su resistencia a la quimioterapia, mientras que la de las cancerosas disminuye

Científicos de la Universidad del Sur de California (USC) han desarrollado un método basado en el ayuno que promete revolucionar la lucha contra el cáncer y que permitiría supuestamente aumentar las dosis de quimioterapia sin sufrir efectos secundarios.

El equipo del biólogo italiano especializado en envejecimiento Valter Longo halló que, al someter a un organismo -por ahora han probado con ratones- a un ayuno de 48 horas, las células sanas concentran su escasa energía en su supervivencia, lo que las hace más resistentes a la quimioterapia que las cancerosas.

Una "bala mágica"

La investigación, que comenzó hace cuatro años, vio la luz hoy en la revista científica PNAS Early Edition y ya ha sido calificada por muchos médicos como un gran avance en la batalla contra los tumores.

"Todo el mundo estaba buscando la 'bala mágica', que dañase sólo las células tumorales y no atacase las sanas. Nuestra propuesta es diferente. ¿Por qué no se dejan tranquilas las células cancerosas y se protege el resto de la quimioterapia?", explicó a Efe Valter Longo, director de las investigaciones.

El uso del ayuno como arma defensiva ante el cáncer supone un giro copernicano en el enfoque de los tratamientos contra esta enfermedad que llega desde el campo de la biología.

"Normalmente un oncólogo te diría que una buena alimentación ayuda a superar el cáncer, pero desde el punto de vista del envejecimiento, sabes que la restricción calórica favorece la conservación de las células", dijo el científico. Fernando Safdie, médico argentino miembro del equipo de Longo, describió el fenómeno.

Células sanas más fuertes

"En esa situación, las células utilizan la poca energía que tienen para protegerse, en lugar de reproducirse por ejemplo, lo que las hace más resistentes", dijo Safdie a Efe, un enfoque que ya ha sido denominado como el "escudo mágico".

"Por ahora hemos realizado experimentos con ratones y ha funcionado. En los próximos seis meses tendremos los resultados de los tests en células humanas" indicó Longo, que se mostró muy optimista con respecto a estas pruebas.

"A pesar de las diferencias entre el organismo del ser humano y el de los ratones, el principio que sustenta la teoría va a funcionar ya que el comportamiento de células sanas y células cancerosas es muy similar, al margen del individuo", aseguró.

Efectos más limitados en humanos

Longo señaló, no obstante, que el mayor grado de sofisticación del cuerpo humano hará que el nivel de protección frente a la quimioterapia será inferior al conseguido en ratones o levaduras.

"No se necesita aumentar la resistencia celular en miles de veces como en el caso de levaduras. En seres humanos esperamos incrementarla por veinte", dijo Longo, para quien este avance mejorará drásticamente los tratamientos.

"En la actualidad se aplican dos sesiones de quimioterapia cada tres semanas para tratar un cáncer de próstata. Ahora imaginemos que se puede hacer esto veinte veces todos los días con unos limitados efectos secundarios", declaró el investigador.

"Por supuesto, no se querrá hacer esto todos los días, pero sí cada tres o cuatro con el fin de evitar los efectos secundarios de la quimioterapia y creo firmemente que será efectivo ante cualquier tipo de cáncer y funcionará, aunque en diferente grado, en todos los pacientes", matizó.

"Es difícil imaginar que no vayamos a conseguir alguna protección en el corto plazo, porque por definición cualquier célula cancerosa está incapacitada para defenderse", sentenció Longo.

Los investigadores de la USC esperan que a partir de ahora oncólogos de todo el mundo empiecen a aplicar este descubrimiento en sus propias investigaciones.

"Realmente cualquier experto puede hacer sus propias pruebas y mi esperanza es que alguien me llame en un año y me diga: así es cómo funciona con un cáncer de mama en los estudios que hemos hecho en España o en otros países", confesó Longo.

Fuente: adn.es, 31 de Marzo de 2008

-Extraen un riñón por la vagina de una mujer con cáncer

El Hospital Clínic ha realizado una operación pionera en Europa al extraer un riñón a través de la vagina a una mujer de 66 años que padecía un cáncer renal, según ha explicado hoy el doctor Antonio Alcaraz, natural de castril (Granada), coordinador del equipo que ha realizado esta intervención.

Alcaraz ha señalado que la operación, una nefrectomía transvaginal, se llevó a cabo el pasado 10 de marzo y consistió en la extirpación de un riñón a través del orificio vaginal mediante laparoscopia, una intervención que no deja cicatrices externas y que reduce al mínimo el tiempo de recuperación.

Se trata de la primera operación de este tipo que se lleva a cabo en Europa y la segunda en todo el mundo, después de una similar realizada hace unos meses en Brasil. La nefrectomía transvaginal es una técnica que permite la extracción del riñón con tan sólo dos pequeñas incisiones en el abdomen de aproximadamente un centímetro cada una. Además, requiere otra incisión que no es visible en la parte interna de la vagina, por la que se extrae el riñón .

Gran precisión

|

Rufina Gilo, paciente operado |

Para llevar a cabo la intervención se introdujo por la vagina una óptica flexible de gran precisión, y por dos pequeñas incisiones en el abdomen el instrumental para separar el riñón y sacarlo, envuelto en una bolsa para evitar la contaminación de tejido. El doctor Alcaraz ha destacado que a diferencia de la laparoscopia, con la nefrectomía transvaginal se aprovecha el orificio vaginal y se trabaja desde el canal del parto para extraer el tumor, una masa que en este caso medía 13 centímetros de alto, 8 de ancho y 5 de profundidad. Rufina Gilo, la paciente operada, una cacereña que vive en Mataró (Barcelona) desde hace 45 años y que es madre de tres hijos, ha explicado que está estupendamente y que nunca pensó que fuera tan bien la intervención, y que incluso el mismo día que se le dio el alta puso la mesa, hizo la comida y hasta planchó de madrugada. La mujer, que está curada según han remarcado los médicos, dice que no tenía miedo antes de ser intervenida porque sabía que se lo tenían que quitar, "y cuanto antes mejor", y que todavía no está segura de que no tenga que tomar ningún medicamento, aunque lo médicos le dicen que no. Hasta ahora, los especialistas en urología del Hospital Clínic hacían nefrectomías asistidas por laparoscopia para tratar quirúrgicamente este tipo de tumores renales, una técnica que ha dado grandes resultados en los últimos seis años y que ha permitido mejorar la atención al paciente, ya que se reduce el dolor postoperatorio y la estancia en el hospital. Sin embargo, a pesar de las ventajas, la laparoscopia requiere, como en la cirugía tradicional, una incisión abdominal para extraer el riñón , que provoca una cicatriz de unos seis centímetros. |

Candidatas a usar esta tecnología

Mujeres que han tenido hijos y con tumores de menos de unos diez centímetros son las candidatas a ser intervenidas con esta nueva tecnología, que se lleva cabo en menos de dos horas, y se estima que unas 25 podrían ser operadas en los próximos meses. El mismo facultativo ha anunciado además que quieren aplicar esta técnica, en el plazo de un año, en las extracciones de riñón que se hacen a donantes de órganos vivos.

La técnica mínimamente invasiva con la que se ha operado a esta mujer se enmarca en el programa NOTES (Natural Orifice Transluminal Endoscopy Surgery), que implica el abordaje quirúrgico a través de los orificios naturales del cuerpo. Hasta ahora en el hospital Clínic, y dentro del programa NOTES, ya se han realizado con éxito dos intervenciones pioneras en España, la extracción de la vesícula biliar a través de la boca, y una intervención para el tratamiento del reflujo gastroesofáfico. Además de Antonio Alcaraz, jefe del Servicio de Urología, han participado en esta intervención la uróloga María José Ribal, Alejandro Molina, residente de Urología, la anestesista Concepción Monsalve, la instrumentista Ana Palacio, y Francesc Carmona, Jefe del Servicio de Ginecología del centro.

Audio de "España Directo" de RNE

Fuente: Ideal.es, RNE, 31 de Marzo de 2008

-Desarrollan una nueva forma de extracción de energía del mar

A finales de marzo próximo, una zambullida en las aguas de la costa oeste de Bretaña va a hacer mucho ruido: la empresa francesa Hydrohelix Energie va a colocar en el fondo del mar un prototipo industrial de turbina que empezará a producir electricidad explotable gracias a una fuente inagotable y prometedora: las corrientes marinas.

Han hecho falta años y años de balances energéticos y de tanteos para realizar un sueño que saltaba a la vista. El mar es una fuente de inmensa energía, pero aprovechar esa fuerza es más difícil y, de hecho, Francia cometió un desaguisado enorme en ese intento, en los años sesenta del siglo pasado: una inmensa central eléctrica construida para explotar las mareas se ha convertido en un fiasco para el ecosistema, sin por ello aportar una solución duradera en términos de producción.

Lo de ahora va en serio: tras los primeros prototipos en Reino Unido y Noruega, ingenieros tránsfugas procedentes del mundo de las hidroeléctricas fluviales han inventado turbinas ligeras que, colocadas en el fondo del mar, cerca de las costas y en lugares donde se registran fuertes corrientes concentradas en puntos determinados, pueden arrojar un balance energético óptimo con un mínimo impacto medioambiental.

Uno de esos ingenieros es el codirector de Hydrohelix Energie, Hervé Majastre. Su start-up ecologista ha recibido respaldo financiero del Gobierno regional de Bretaña, el Gobierno provincial de Finisterre y la Agencia estatal de Control de la Energía (Ademe ) francesa para la fabricación e instalación del prototipo industrial de la central eléctrica del fondo del mar.

“Nuestros cálculos indican que podemos producir 5.000 megavatios en los tres emplazamientos calificados de muy propulsivos”, señala Majestre, recordando que esa potencia representa nada menos que 25 teravatios/hora. Y el ingeniero ecologista insiste, además, en que ese volumen representaría un 5% de la producción de energía francesa “real y actual”.

El lastre de Sabella

|

Sabella |

La turbina, bautizada Sabella,

lleva un lastre que le permite permanecer fijada al fondo del mar a unos 20

metros bajo la superficie. Mide unos 5,5 metros de alto –3 de ellos para la

hélice en sí– y girará sólo a unas 50 revoluciones por minuto para producir

directamente electricidad a 50 herzios. Y ello gracias a la instalación de

100 polos. En esa innovación reside toda la eco-compatibilidad de Sabella : en vez de tener que girar 30.000 revoluciones por minuto –como sus primas en manos de grandes firmas que también trabajan en la llamada energía hidroliana–, Sabella gira de manera estable y lenta. De momento, la energía del prototipo de HydroHelix será disipada en unas resistencias, con el objeto de poder medir la producción en situación real y el impacto medioambiental. “A partir de 2009, si no es este año, empezará la producción industrial de electricidad hidroliana para su consumo real si disponemos de la financiación”, estima Majastre. El reto de HydroHelix y otras compañías de la misma filosofía es el de producir cerca de las costas y en emplazamientos muy propulsivos, con el objetivo de empezar a divulgar un objetivo muy deseado por los partidarios de las renovables: el de producir local para consumir local, lo que evita las pérdidas ligadas al transporte. Es un objetivo que permitiría escapar a la carrera loca de la superproducción y el superconsumo de energía, que se justifican el uno al otro. Una carrera que, por ejemplo, ha llevado a que Francia construyera durante años edificios con calefacción sólo eléctrica, buena manera de justificar la ambición nuclear. Ese objetivo del “consume local, produce local” no está en las mentes de las grandes firmas. La petrolera Total , por ejemplo, ha entrado en la carrera, al igual que EDF . Majastre, por su parte, destaca que de lo que se trata es de ir descubriendo lugares muy propulsivos para las pequeñas sabellas. Y manifiesta su interés por las proximidades de las rías gallegas, que están siendo estudiadas por los precursores de la energía hidroliana en España.

|

Fuente: publico.es, 30 de Marzo de 2008

El presidente de la Royal Society of Chemistry recuerda que para propulsar a un solo avión a través del Atlántico con estos carburantes habría que destinar la producción anual de una superficie agrícola equivalente a 30 campos de fútbol

El coro de voces autorizadas que elevan el tono de las críticas al uso de biocombustibles como una alternativa a los carburantes convencionales derivados del petróleo no deja de crecer. El último en sumarse a esta marea ha sido el máximo responsable de la reputada Royal Society of Chemistry británica, Richard Pike.

Tras los estudios científicos que advierten en los últimos meses de que para producir más biocombustibles habrá que roturar terrenos salvajes en todo el planeta, liberando más CO2 del que se ahorra consumiendo aquéllos, Pike señala además las enormes extensiones de terreno agrícola que necesitan los cultivos a partir de los que se producen. Utilizando una comparación muy gráfica, el científico señala que para fabricar el biocombustible necesario para propulsar un único vuelo entre Londres y Nueva York sería necesario dedicar una superficie agrícola equivalente a 30 campos de fútbol. Y eso sólo para la ida.

"Los historiadores del futuro terminarán apuntando a los biocombustibles como un callejón sin salida", señala Pike, que afirma que la presión de varios grupos relacionados con la industria agroalimentaria, sumada a una planificación energética "atolondrada" por parte del Gobierno, pueden terminar llevando a Reino Unido a una crisis de suministro

"El camino que tenemos por delante debe incluir (más) investigación, que permita aumentar la eficiencia de los biocombustibles dramáticamente y avanzar en la fotosíntesis artificial para la producción de alcohol", añade el experto, que señala que en cualquier caso hay que poner "más prioridad en otras tecnologías" de producción energética. Con ellas se refiere a la energía solar fotovoltaica, unida a mejores baterías para vehículos y a una nueva generación de depósitos de almacenamiento de hidrógeno.

Fuente: publico.es, 29 de Marzo de 2008

|

Puerto de Sidney antes (arriba) y después del apagón (abajo).

|

El apagado de la iluminación de la Casa de la Ópera, el puente sobre el puerto y de los rascacielos de la ciudad de Sidney ha marcado el inicio oficial de 'La Hora del Planeta 2008'. Esta iniciativa contra el cambio climático, que el Foro Mundial para la Naturaleza (WWF) inauguró el año pasado en esta ciudad para concienciar a la ciudadanía de la importancia del cambio climático, se ha convertido en 2008 en un evento global. Casi 400 ciudades y pueblos, 20.000 empresas y 280.000 ciudadanos de más de 35 países de todo el mundo se habían registrado hasta hoy en la página de internet del evento y, cuando en su franja horaria se marquen las 20.00 horas, apagarán las luces durante una hora. El evento finalizará 18 horas después de su comienzo en Sidney, cuando sea el puente de San Francisco, el famoso Golden Gate Bridge, en Estados Unidos, el que se una a la acción medioambiental. Según los registros de la página de internet de 'La Hora del Planeta', los últimos en celebrarlo serán los ciudadanos de San Francisco, pero "alguien ha dicho que en Honolulu, que no ha manifestado a WWF su interés en ser parte de la iniciativa, también están preparando eventos", apuntó Ridley. Además de Sidney, también las ciudades australianas de Melbourne, Adelaida, Camberra, Brisbane y Hobart así como numerosas localidades más pequeñas han secundado este año la iniciativa. Miles de ciudadanos festejaron la Hora de la Tierra con reuniones masivas frente al edificio del Parlamento en Camberra, la capital, y en la plaza central de Melbourne, Federation Square. La esperada ausencia de contaminación lumínica fue aprovechada además por grupos de astrónomos, que instalaron telescopios para observar las estrellas del cielo australiano. En marzo de 2007, cuando la ciudad de Sidney celebró la 'Hora de la Tierra' por vez primera, sus habitantes lograron ahorrar un 10 por ciento de la energía de la ciudad; el equivalente de retirar a 48.000 coches de las vías públicas durante 60 minutos. Este año participan ciudades de todo el mundo como Copenhague, Dublín, Manila, Chicago, Tel Aviv (que lo celebró el viernes por motivos religiosos), Bangkok, Vancouver, Montreal o Toronto y, según la organización WWF, también Argentina, Bolivia, Brasil, México, Nueva Zelanda, Uruguay, Venezuela y España se han unido al proyecto.

|

Fuente: elmundo.es, 29 de Marzo de 2008

-La NASA inicia las pruebas de los primeros cohetes para ir a la Luna

|

La NASA acaba de iniciar las primeras pruebas de su futuro cohete 'Ares I', que se encargará de impulsar a sus nuevas naves espaciales, diseñadas para sustituir a los actuales transbordadores y enviar astronautas a la Luna. Las pruebas, que comenzaron apenas 24 horas después de concluir la última misión del transbordador 'Endeavour' en la Estación Espacial Internacional (ISS), se centraron en los procedimientos para cargar el combustible que se utilizará en los cohetes, cuyo sistema tiene un diseño similar al de los misiles 'Peacekeeper' de la Fuerza Aérea de Estados Unidos. Los transbordadores, que todavía deben realizar 10 misiones a la ISS y otra para reparar el telescopio 'Hubble' a finales de este año, serán retirados en 2010 y sustituidos por el programa 'Constellation', que utilizará las naves 'Orion' impulsadas por el cohete 'Ares I'. La NASA tiene prevista para abril de 2009 la primera prueba de vuelo no tripulado con el cohete 'Ares I'. El cohete, de más de 100 metros de altura, usará combustible sólido en su primera etapa y combustible líquido en la segunda. La nave 'Orion' viajará instalada en su extremo superior tal y como lo hicieron las cápsulas 'Apollo'. El cohete 'Ares I' también podrá llevar astronautas hasta la ISS en la primera etapa de un futuro viaje para el retorno del hombre a la Luna, previsto para el 2020. Pero antes de iniciarse las pruebas de vuelo, los ingenieros de la NASA tendrán que determinar las formas más seguras de cargar el combustible en el cohete impulsor. Y es en esa etapa donde se encuentran ahora las actividades de los técnicos de la agencia espacial estadounidense, según manifestó David Tomisic, ingeniero de sistemas de fluidos en el Centro Espacial Kennedy (Florida). Tomisic indicó que los trabajos se han centrado particularmente en los tanques de helio, para determinar cómo reaccionarán bajo presión. También se han probado los tanques de titanio que albergarán combustible superfrío y oxidante. Por ahora, para evitar emergencias, los ingenieros están utilizando agua en vez de los combustibles finales, señaló Tomisic. "Hemos aprendido a hacer algunos ajustes en nuestro equipo y todo está funcionando bien", agregó |

Simulación por ordenador del "Ares I" |

Fuente: elmundo.es, 28 de Marzo de 2008

-Un proyecto de la UE aspira a lo último en miniaturización: máquinas moleculares

«La naturaleza utiliza máquinas y motores

moleculares para cada uno de los procesos biológicos», señaló el coordinador del

proyecto, el profesor David Leigh de la Universidad de Edimburgo (Reino Unido).

Con estas máquinas, los sistemas biológicos aprovechan la energía solar, se

comunican, perciben el mundo que les rodea y controlan nuestros movimientos.

El hombre, en cambio, utiliza actualmente máquinas basadas en tecnologías

«macro». Todos nuestros medicamentos y materiales se basan en las propiedades

estáticas de estas sustancias. Una vez alcanzada la nanoescala, las moléculas y

los átomos se comportan de un modo muy diferente, y esto es lo que los

investigadores esperan aprovechar.

«Estamos acostumbrados a las máquinas en el gran mundo», explicó el profesor

Leigh. «Nuestra labor consiste en tratar de encoger este concepto hasta lo

último en miniaturización, donde las máquinas son las propias moléculas.»

Lo que inspiró el proyecto fue un descubrimiento por azar. El profesor Leigh y

su equipo intentaban crear una molécula grande con forma anular en su empeño por

crear nuevos sensores químicos. En cambio, produjeron dos moléculas anulares

entrelazadas que se asemejaban a un eslabón.

Además, la investigación de este sistema permitió fabricar compuestos

denominados rotaxanos, en los que una molécula «rueda« se acopla alrededor de

una molécula «eje». Fue con estas moléculas con las que el equipo de

SYNNANOMOTORS creó el primer motor molecular, al usar una superficie modificada

con rotaxanos para transportar una gota de líquido cuesta arriba. En este caso,

el brillo de una luz delante de la gota hizo que las moléculas se desplazaran de

forma tal que el agua fue impulsada eficazmente por los diminutos motores.

Los socios del proyecto esperan que esta tecnología se pueda usar algún día para

transportar carga, como por ejemplo medicamentos, por el cuerpo. Mientras tanto,

los nanomotores también encuentran aplicación en el área del almacenamiento de

información. En un sistema con dos anillos entrelazados, al cambiar la

orientación de los anillos se modifican también las propiedades de la sustancia.

Por ejemplo, en una orientación puede ser fluorescente y en otra no. Esto

significa que la información se puede «leer» de forma óptica a partir de una

película polimérica cubierta en las moléculas.

Ya hay planes respecto a las primeras aplicaciones comerciales de estos

minúsculos motores, según explicó uno de los participantes del proyecto, el

profesor Wybren Jan Buma de la Universidad de Ámsterdam (Países Bajos).

«Si colocas una capa muy fina de estas moléculas sobre una superficie y las

tocas con una punta muy afilada, de un átomo de ancho, y presionas sobre ella,

obtendrás los patrones», afirmó a CORDIS Noticias. El patrón resultante de las

gotitas puede ser controlado, y una empresa spin off está utilizando actualmente

esta técnica con fines de identificación y de falsificación. «Por tanto, se

trata de algo que ya estamos usando», añadió.

Entre los socios del proyecto hay expertos europeos en química, física, ciencia

de superficies y nanotecnología. No obstante, al recoger el premio, el profesor

Leigh quiso rendir homenaje a la ardua labor de los miembros más jóvenes del

consorcio. «Estoy seguro que habrá una gran cantidad de pizza y cerveza en el

laboratorio para celebrarlo», dijo.

Fuente: Cordis, 28 de Marzo de 2008

-El "nobel" de las matemáticas premia un trabajo sobre simetrías

Para los matemáticos, un monstruo es un

"objeto" que existe sólo en un espacio de exactamente 196.883 dimensiones. Pero

lo importante de esta inimaginable forma no es dónde está, sino el hecho de que

sea una estructura cuyas simetrías no son "descomponibles" en ninguna otra. ¿Y

qué? Y mucho. Para los matemáticos, un monstruo es un "objeto" que existe

sólo en un espacio de exactamente 196.883 dimensiones. Pero lo importante de

esta inimaginable forma no es dónde está, sino el hecho de que sea una

estructura cuyas simetrías no son "descomponibles" en ninguna otra. Contiene

exactamente 8 x 1053 elementos simétricos.

El estudio matemático de las simetrías, un área llamada teoría de grupos, es esencial tanto para la investigación básica como la aplicada. Dos de los matemáticos que han contribuido a su desarrollo, John Griggs Thompson, de la Universidad de Florida (Estados Unidos) y Jacques Tits, del Collège de France, acaban de ser galardonados con el premio Abel, que otorga la Academia Noruega de Ciencias y Letras. Dotado con 750.000 euros, el Abel viene a ser el nobel de las matemáticas. hompson y Tits reciben el premio "por sus profundos logros en álgebra y, en particular, por dar forma a la moderna teoría de grupos", dice la Academia Noruega en su comunicado de prensa.

Jonh Griggs (el de la medalla)

Jonh Griggs y Jacque Tits ganadores del Premio Abel.

Este premio se concede desde 2003 y es concedido por

la Real Academia de las Ciencias y las Letras.

Su nombre viene del ilustre matemático noruego Niels Henrik Abel

(famoso por sus estudios de la teoría de grupos).

200 años después de su nacimiento se creó el premio como homenaje

La simetría es uno de los fenómenos más importantes de la naturaleza. La noción

intuitiva de simetría es fácil. Pero en matemáticas empezaron a describirse en

el siglo XIX, gracias al matemático Evariste Galois -que desarrolló su trabajo

la noche antes de morir en un duelo, a los 20 años-. Las simetrías de una figura

son las múltiples maneras en que esa figura puede ser rotada y colocada de

nuevo, de forma que encaje bien, en un molde suyo. Galois descubrió que las

simetrías de un objeto pueden ser descompuestas en otras simetrías primarias,

que no pueden descomponerse en otras.

Las operaciones simétricas son aquellas

que se hacen sobre un objeto sin que este sufra cambios. Por ejemplo, si rotamos

un cuadro o un cubo totalmente o en un giro de un cuarto del total, veremos que

la figura obtenida es idéntica a la original. Todas las operaciones simétricas

aplicables a una figura constituye un grupo. Existe un número limitado de grupos

a partir de los cuales se pueden obtener todas las formas dentro de otro pequeño

número de clases básicas de simetría, como si éstas fueran una especie de tabla

periódica, pero de elementos, si no de simetrías.

MÚLTIPLES DIMENSIONES

Thompson y Tits, entre otros, han contribuido a elaborar la lista de simetrías

primarias de las que surgen todas las demás; simetrías que no se limitan al

mundo de tres dimensiones, sino que existen también en múltiples dimensiones,

como el "monstruo".

Thompson demostró que ciertas operaciones simétricas pueden ser descompuestas en otras más simples e indivisibles al igual que una molécula se puede reducir a átomos. Estas operaciones elementales están relacionadas con los números primos. Por ejemplo, una rotación simétrica de un polígono de 15 lados es equivalente a las rotaciones de un polígono de 5 y un triángulo equilátero, ambos inscritos dentro del polígono original. Esta propiedad sólo existe en polígonos con un número impar de simetrías (como los 15 lados). El descubrimiento de esta propiedad se plasmó en el extenso teorema del orden impar.

Los grupos finitos contienen un número finito de simetrías elementales que pueden ser clasificadas en familias. Estos grupos forman una tabla periódica. En el "Atlas de los Grupos Finitos" se da un pormenorizado repaso de dicha calisificación.

Tits ha estudiado las

propiedades simétricas de los grupo lineales, dentro de los que las operaciones

simétricas pueden ser infinitas. Un círculo, por ejemplo, puede ser rotado todas

las veces que quieras sin que sufra ninguna variación. Aunque un círculo sea una

forma simple, las infinitas simetrías de formas parecidas son difíciles de poder

ser captadas. Tits ha desarrollado su trabajo en estos últimos años intentando

domesticar el infinito espacio de estos objetos y amansar su comportamiento.

Tits ha demostrado como estos grupos pueden ser descritos y analizados en

términos geométricos, haciendo que sus propiedades sean más fáciles de

visualizar. Acuñó el termino "edificio" para describir las estructuras

geométricas que se presentan como un resultado, y además, demuestra que pueden

ser descompuestas en lo que denomina "apartamentos" y "cámaras".

"La teoría de grupos tiene aplicaciones desde a la resolución de problemas de

ingeniería a la teoría de la relatividad, o incluso es lo que está detrás del

modelo estándar de la moderna cosmología, el llamado Big Bang. Todo eso son

grupos", explica Manuel de León, director del Instituto de Ciencias Matemáticas.

Los trabajos de Tits y Thompson han permitido entender mejor la extraña clase de objetos simétricos llamados grupos esporádicos. "No parecen venir de ningún lado" dice Graham Niblo, uno matemático que estudia la teoría de grupos en la Universidad británica de Souhthampton. Thompson ideó una manera de predecir cuantas formas simétricas puede haber en un grupo esporádico, uno de esos grupos ha sido bautizado con su nombre, el "Grupo Tits" en español sonaría, vulgarmente, como el Grupo Tetas, Tits es francés, de ahí que los ingleses, con su peculiar sentido socarrón, les parezca gracioso lo del nombre .

Fuente: EFE, Nature, 28 de Diciembre de 2008

Alan Stern, uno de los principales responsables de los proyectos científicos de la NASA, ha renunciado a su cargo, según ha confirmado la agencia espacial estadounidense, NASA. Aunque aún no está claro de qué manera, parece el anuncio de su dimisión está relacionado con el pequeño revuelo que se ha formado esta semana a cuenta de un extraño anuncio de la agencia. El lunes, responsables del Laboratorio de Propulsión a Chorro (JPL) aseguraron que un recorte presupuestario iba a obligar a detener durante unos meses la actividad de uno de los dos robots que exploran la superficie de Marte, y a limitar las del otro.

El martes, la propia agencia se desmintió a sí misma al más alto nivel por boca de su director, que aseguró que ningún recorte detendría a Spirit o a Opportunity (que trabajan incansablemente desde hace cuatro años, pese a haber sido diseñados sólo para funcionar durante tres meses).

Cruce de decisiones

"Aunque lamento profundamente su decisión de abandonar la NASA, comprendo sus razones y le deseo lo mejor en sus actividades venideras", ha señalado en un comunicado Michael Griffin, director de la agencia espacial. Stern, por su parte, ha asegurado a sus colegas de forma privada que seguirá "durante algunas semanas" en el cargo, en el que será sustituido por Edward Weiler, actual director del Centro de Vuelos Espaciales de la NASA, ubicado en Goddard, Maryland. Griffin señaló el martes la carta en que se proponía una reducción del presupuesto para la exploración científica de Marte no había sido "coordinada plenamente" con su oficina.

Fuente: periodistadigital.com, 27 de Marzo

Echar una ojeada al futuro significa ver

cómo se diluyen las categorías en las que compartimentamos la realidad

tecnológica. El desarrollo de la potencia de computación nos lleva

ineludiblemente a la producción de formas de inteligencia artificial, que a

través de la ingeniería genética nos acerca a los primeros genomas artificiales,

los cuales no serían posibles sin los desarrollos de la biocomputación, cuyas

bases de datos alojadas en Internet son accesibles de forma masiva gracias al

crecimiento de la banda ancha. Las profecías tecnológicas, cuando fracasan,

acostumbran a hacerlo no porque se cometa un error sobre cuándo estará

disponible una nueva tecnología, sino porque no se acierta en la forma de uso de

ésta. En estas páginas apuntamos algunos de los augurios más verosímiles que

expertos de todo tipo han hecho sobre este futuro. Habrá que esperar a ver quién

acierta, pero todos los vaticinios tienen una base sólida.

2012, LOS COCHES SE COMUNICAN Y ESCOGEN RUTAS

IBM realiza periódicamente unas predicciones para los próximos cinco años. En su

última edición se fijaba en el desarrollo de la automoción y decía que para 2012

se producirá una "ola de conectividad" entre los vehículos y las autopistas, lo

que permitirá un tráfico fluido permanentemente (y reducirá, consecuentemente,

la contaminación). Los coches se comunicarán entre sí y elegirán rutas

alternativas en el caso de que sea necesario.

Curiosamente, la previsión recuerda a la que Walt Disney hizo en un corto de

animación sobre el desarrollo de las autopistas, aunque en este caso la

previsión se hacía allá por los años cincuenta y para un futuro no muy alejado

de aquel momento. Algunos piensan en autopistas donde la conducción sea

automática y la velocidad la fije el coche.

2015, MÓVILES 4G TOTALMENTE DISTINTOS

Según la consultora Gartner, dentro de sólo cuatro años (en 2012) el 50% de los

trabajadores móviles dejarán en casa sus portátiles, que habrán sido sustituidos

por otros dispositivos inalámbricos con idénticas o más prestaciones.

Para el año 2015, Tomi Ahonen, un consultor dedicado al sector de la telefonía,

se aventura a prever la cuarta generación móvil (4G), en la que los terminales

tendrán un zoom óptico de al menos 50 aumentos, sistemas de reconocimiento de

voz capaces de traducir de un idioma a cualquier otro, y tanta capacidad de

almacenamiento que podremos guardar de forma continuada lo que sucede alrededor

de manera que podamos regresar a ello al instante: "¿qué fue ese sonido?",

bastará ir al móvil y darle al replay.

Por supuesto, el terminal no tendrá botones y no nos lo colocaremos en la oreja.

Las interfaces serán algo completamente diferente.

2020, 'SOFTWARE' CON INTELIGENCIA ARTIFICIAL... CASI HUMANA

Año 2020. No todo es hardware.

El software es otra historia y quizá lleve otro paso. Si bien los desarrollos

actuales del software se han centrado en programas orientados a la solución de

problemas muy concretos, durante las próximas cinco décadas se desarrollará un

software destinado a "la exploración sistemática del universo computacional de

todos los posibles programas", según el físico teórico Stephen Wolfram, creador

del programa Mathematica.

Y antes de llegar a ese punto, a medio camino, en el 2020, usaremos herramientas

de inteligencia artificial que incluirán todos los procesos implicados en la

inteligencia humana, según Ray Kurzweil, hasta el punto de que algunas máquinas

serán capaces de superar el llamado test de Turing.

Ese famoso test plantea el diálogo entre un hombre y una máquina oculta a su

mirada y verifica si la persona detecta que su interlocutor es una máquina.

2020: LOS PC SIMULARÁN EL CEREBRO

Si hay en computación una ley talismán ésa es la que el cofundador de Internet,

Gordon Moore, enunció allá en 1965 y según la cual la capacidad de los

procesadores se duplica cada 12 meses. Aunque ha sido revisada, lo cierto es que

el desarrollo de la potencia de computación en los últimos 40 años hace

ridículas las previsiones como la del presidente de IBM en 1943, Thomas Watson,

quien pensaba que "hay un mercado mundial para unos cinco ordenadores", o la que

Ken Olson, presidente de DEC, hizo unos 30 años después, cuando afirmó: "No hay

ninguna razón por la cual alguien quisiera tener un ordenador en su casa". La

cosa es ahora muy diferente y, dejando volar la imaginación, el inventor y

futurólogo Ray Kurzweil espera que para el año 2020 la potencia de computación

haya llegado al punto de ser capaz de simular el cerebro humano (que realiza

unos 10.000 millones de cálculos por segundo). Lo mejor de todo, según Kurzweil,

es que costará menos de 1.000 euros. Trazando un paralelismo, si los coches

hubieran seguido el mismo ritmo, ahora tendrían las dimensiones de una

tostadora, costarían 200 euros y alcanzarían una velocidad de 50.000 kilómetros

por hora.

El desarrollo de procesadores según el sistema actual de litografía, sin

embargo, tiene un límite, así que una de las vías con las que se elucubra para

sobrepasar ese límite físico es la computación cuántica, ya que según Frank

Wilczek, premio Nobel de Física en 2004, "aumentaremos nuestras capacidades

convirtiendo la luz y el spin de los electrones en transportadores de

información en estructuras autoensamblables, después de lo cual, máquinas con

una inteligencia suprahumana serán corrientes".

2020, NANOMÁQUINAS

El sistema de producción de procesadores alcanzará en los próximos años unos

límites que sólo mediante el desarrollo de la nanoingeniería podrán ser

solventados. La nanotecnología era de hecho una de las cinco áreas identificadas

en una encuesta entre 700 miembros del IEEE (Institute of Electrical and

Electronics Engineers). Dentro de poco más de una década, en 2020, "podemos ser

capaces de desarrollar nanomáquinas que entren en nuestro cuerpo y encuentren y

destruyan células cancerosas individuales sin dañar a las células sanas", según

la previsión de un jefe de investigación de la multinacional Battelle, Kevin

Priddy. Más aún: las nanomáquinas podrían ser usadas para distribuir en partes

del cuerpo muy localizadas determinados fármacos, para limpiar arterias o

incluso para reparar daños.

2030, LO VIRTUAL Y LO REAL SE CONFUNDEN

Si lo natural y lo artificial se funden, lo mismo ocurre con lo virtual y lo

real. Las experiencias en los mundos virtuales y a través de simulaciones

resultarán tan reales en unos años que parecerán la realidad misma.

De aquí a una década, los gráficos de los ordenadores tendrán tal grado de

realismo que ya no seremos capaces de distinguir sin son reales o simulaciones;

al menos es la opinión de los miembros encuestados por el Institute of

Electrical and Electronics Engineers. El desarrollo de metaversos (metauniversos)

como Second Life y otros juegos masivos por Internet encaja en estas

previsiones.

El pionero de la computación Alan Kay cree que ese desarrollo de la simulación

nos llevará a desarrollar nuevas formas de alfabetización basadas en la

simulación, de manera que permitan experimentar verdaderamente lo que se

aprende, por ejemplo: ¿cómo sería tu vida si fueras un vegetariano estricto?, ¿y

si corrieses 16 kilómetros cada día?

El cofundador de Sun Microsistems, Bill Joy, cree que hacia los años 2030 se

habrá desarrollado una tecnología que recuerde a la película Matrix, en la que

una interfaz tridimensional entre humanos y máquinas pone en cuestión lo que

llamamos realidad convencional.

Por ahí van otras de las 10 predicciones básicas de Battelle, una empresa que

hace desde 1995 estas prospectivas. Nos maravillaremos por la realidad aumentada

de la simulación, dicen, y gracias a sensores y a la tecnología genética,

seremos capaces de implantar dispositivos que nos permitan oír mejor o ver más

lejos.

2050, LOS ROBOTS SE CASARÁN

Uno de los temas recurrentes en la ciencia ficción, en las predicciones y en el

imaginario popular ha sido el de los robots. Bill Gates se preguntaba en un

artículo publicado en Scientific American: "¿Cuándo formarán parte de nuestra

vida cotidiana los robots?", para seguidamente responder con algunos datos. Así,

según la International Federation of Robotics, la cifra de unos dos millones de

robots que había en 2004 pasará a siete millones este año. Y para indicio de

cambios, la referencia de Corea del Sur. El Gobierno pretende introducir un

robot en cada casa en el año 2013. Mucho más extrema es la previsión de David

Levy, un científico del campo de la inteligencia artificial que el año pasado

publicó un libro, titulado Amor y sexo con las máquinas, en el que hacía

propuestas tan radicales como que en 2050 los robots podrán casarse, aunque

antes de eso, dentro de unos 20 o 30 años, mantendrán conversaciones

sofisticadas.

2050-2060, MILLONES DE ORDENADORES EN UNA MISMA TAREA

Internet probablemente siga pasando por los buscadores en el futuro, se llamen

Google, o Microhoo! Peter Norving, director de investigación de Google, lo ve

claro: dentro de unas cuatro décadas, allá por 2050, los buscadores se habrán

transformado, de manera que "en lugar de teclear unas cuantas palabras en el

buscador, la gente discutirá sus necesidades con un intermediario digital que le

ofrecerá sugerencias y refinamientos en la búsqueda".

Pero quizá el cambio a gran escala venga de la transformación de Internet en un

gran computador, un sueño con décadas de antigüedad y en el que confiaban

mayoritariamente los 700 miembros del IEEE encuestados, para quienes la

computación distribuida será uno de los logros que se alcanzarán en los próximos

50 años.

Esto es, poner a trabajar a los miles de millones de ordenadores que hay (o

mejor, que habrá) en la Tierra en macroproyectos destinados a desarrollar

vacunas contra el sida, simular reacciones químicas o identificar posibles

señales inteligentes que lleguen desde el espacio, como ocurre con el http://seti.astroseti.org/setiathome/,

paradigma de este modelo de computación.

VIDA ARTIFICIAL A UN PASO

Del software a la inteligencia artificial, y para saltar de ésta a la vida

artificial no hay más que un paso. Ya se ha elaborado el primer genoma sintético

de un organismo vivo, un logro fundado en la computación masiva de datos

genéticos, imprescindible para dar cuenta de su enorme volumen. De hecho, la

capacidad para identificar y utilizar datos genéticos se dobla cada 12 o 24

meses, aproximadamente. Así que la vida artificial, construida a base de

genómica y desarrollos basados en la biocomputación, es una consecución

ineludible. "La idea de la biología sintética", dice el investigador de la

Universidad de Berkeley Jay Keasling, "es hacer con la biología lo mismo que la

electrónica ha hecho con el diseño de circuitos y la química con la síntesis de

compuestos, es decir, desarrollar una ingeniería a partir de ella".

2060, TRASPLANTES DE ANIMALES A HUMANOS Vida artificial y vida natural

reprogramada: órganos que se desarrollan en animales, por ejemplo en cerdos,

para ser trasplantados a humanos. Definitivamente, lo artificial y lo natural

pierden sus límites definidos (¿es natural un órgano creado a partir de células

humanas que se desarrolla en un cerdo y es trasplantado después al donante

original?). La producción ilimitada de órganos humanos sin necesidad de que otro

humano haga de donante es para Bruce Lahn, un genetista de la Universidad de

Chicago, ineludible: "Cuando un paciente necesite un órgano nuevo, un riñón, por

ejemplo, el cirujano se pondrá en contacto con un productor comercial de órganos

y le proporcionará el perfil inmunológico del paciente. El productor escogerá

una serie de cerdos que porten el tejido de riñón adecuado, que serán de origen

enteramente humano". Y esto dentro de menos de 50 años.

Fuente: El País Digital, 27 de Marzo de 2008

|

Aterrizaje del Endeavour |

El Endeavour desafió la amenaza de mal tiempo en la Florida y descendió sobre la pista del Centro Espacial Kennedy, al culminar una exitosa misión a la Estación Espacial Internacional (EEI). La llegada nocturna del transbordador, tras una misión de 16 días a la EEI, se produjo tras un primer intento que debió cancelarse por la amenaza de mal tiempo en la zona de Cabo Cañaveral (Florida). "Endeavour ha llegado", dijo el control de la misión en el Centro Espacial Johnson en Houston (Texas), después de que la nave tocara la pista de descenso a las 00.39 GMT del jueves. "Bienvenido a casa Endeavour, en el fin de lo que ha sido una muy exitosa misión", agregó. La misión S-123 del Endeavour fue la más prolongada de los transbordadores de la NASA y, por primera vez, incluyó cinco caminatas espaciales en torno al complejo que orbita la Tierra a casi 400 kilómetros de altura. El feliz descenso ocurrió después de que el comandante Dominic Gorie y el piloto Greg Johnnson encendieran los motores del transbordador para sacarlo de su órbita 249 sobre el océano Pacífico y hacer su ingreso en la atmósfera terrestre. En esos momentos los vientos eran calmados en la zona, pero había nubes altas que podían convertirse en cualquier momento en una amenaza para la seguridad de la nave. De haber persistido las malas condiciones climáticas el descenso se habría tenido que postergar un día. Sin embargo, Gorie avisó al control de la misión que él y los seis tripulantes del transbordador se habían preparado para cualquier contingencia y que se sentían dispuestos para aterrizar en la pista del Centro Espacial Kennedy durante la noche.

|

Abortado el primer intento

El mal tiempo que obligó a cancelar una primera oportunidad de descenso, cuando todavía alumbraba el sol, y un problema en un pasador de la EEI durante el desacoplamiento el lunes, fueron los únicos inconvenientes sufridos por la misión, la número 25 de los transbordadores a la EEI.

Tras el acoplamiento con la EEI el 12 de marzo, los astronautas instalaron en el complejo el primer segmento del módulo científico japonés Kibo (Esperanza). El último de esos segmentos llegará a la EEI el próximo año. Sumado al laboratorio europeo Columbus, instalado a mediados del mes pasado por la tripulación del Atlanti, Kibo aumentará la capacidad de investigación científica de la EEI en varias disciplinas, dijo la NASA.

La tripulación del Endeavour, de la que formó parte el astronauta japonés, Takao Doi, también instaló el último elemento del sistema robótico canadiense Dextre que ampliará la capacidad de servicio y mantenimiento externo de la EEI. Además, la tripulación del Endeavour realizó pruebas de una técnica de reparación del escudo térmico del transbordador concebida para evitar accidentes como el ocurrido al Columbia el 1 de febrero de 2003 cuando regresaba de una misión científica.

Un trozo de aislante se desprendió del tanque externo de la nave y perforó una de sus alas causando la desintegración de la nave cuando regresaba de una misión científica. La misión también llevó al astronauta e ingeniero de vuelos Garrett Reisman, quien sustituyó al astronauta francés de la Agencia Espacial Europea Léopold Eyharts, quien permaneció 48 días en la estación Alfa. Además de Reisman, los inquilinos de la EEI son la comandante estadounidense Peggy Whitson y el cosmonauta ruso Yuri Malenchenko.

La agencia espacial estadounidense tiene previstas otras 10 misiones de los transbordadores para completar la construcción de la estación espacial antes de 2010. demás, a finales de este año, proyecta enviar uno de los transbordadores en una misión de reparación y mantenimiento del observatorio espacial Hubble.

Fuente: ADN.es, 27 de Marzo de 2008

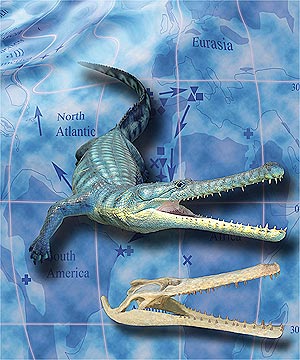

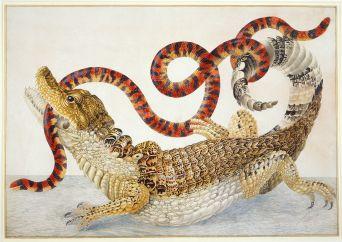

-El cocodrilo prehistórico de Pernambuco

Un grupo de científicos de Brasil ha encontrado en Pernambuco (al noroeste del país) los restos mortales de un tipo de cocodrilo prehistórico que surgió en la Tierra después de la catástrofe que causó la desaparición de los dinosaurios, aunque su linaje es muy anterior y logró sobrevivir de algún modo a aquella extinción masiva. El hallazgo de los restos del animal, cuya existencia era hasta ahora ignorada por la comunidad científica, ha sido anunciado en Río de Janeiro por los científicos José Antonio Barbosa, Alexander Kellner y María Somalia Sales Viana.

Al mismo tiempo, un artículo con los detalles del estudio acaba de ser publicado por la revista británica 'Proceedings of the Royal Society B'. Los fósiles de la especie 'Guarinisuchus munizi' fueron hallados en rocas de origen marino del litoral de Pernambuco.

fósil de 'Guarinisuchus munizi'

Distribución del cocodrilo marino hace 62 millones de años

Los investigadores recuperaron huesos del cráneo, de la mandíbula, de la pata delantera y partes de costillas, lo que fue suficiente para los restos como pertenecientes a una especie desconocida, de unos tres metros de largo y que vivió hace más de 60 millones de años. Según los científicos, el 'G. munizi' forma parte de la familia 'Dyrosauridae', que vivió durante el período del Paleoceno y resistió al fenómeno que extinguió del planeta a los grandes dinosaurios. El estudio afirma que, en base al hallazgo, los expertos pudieron elaborar una nueva teoría sobre las rutas de dispersión seguidas por los 'Dyrosauridae', que habrían salido de África para ocupar áreas de Sudamérica (el noreste de Brasil) y, luego, de Norteamérica.

"Además, el trabajo establece que los cocodriliformes dirosaurideos fueron los mayores depedradores de los mares tras la gran extinción ocurrida hace 65 millones de años", agrega el informe.

Según la tesis que apuntan los invetigadores, esos animales compartieron con los tiburones la tarea de "colonizar" las regiones costeras.

Fuente: elmundo.es, 27 de Marzo de 2008

Jaime tiene 12 años y cursa primero de la ESO. Al preguntarle por Plutón, reconoce el nombre, pero es tajante en su sentencia: “Ya no se estudia”. Y alega: “No es un planeta”. Su padre, con la natural perplejidad de quien se formó en la extinta EGB, replica: “¿Entonces qué es?”. “Un planeta enano”, aclara Jaime. “¿Qué es eso de planeta enano? O es un planeta, o no es un planeta”, razona su padre.

Jaime está en lo cierto, pero el lío de su padre es comprensible. No es el único enredado en esta aparente contradicción; en el último número de la revista Science, Mark Sykes, director del Instituto de Ciencias Planetarias de Tucson (EEUU), escribe: “La Unión Astronómica Internacional (UAI) define los planetas enanos... pero explícitamente dice que no son planetas, lo queconfunde a muchos”.

Víctima inocente

La de Sykes es una de las principales voces que se alzaron cuando, en agosto de 2006, la asamblea general de la UAI aprobó una definición de planeta que expulsaba del selecto club al más lejano, pequeño y helado de los nueve que hasta entonces integraban el Sistema Solar. Plutón no era, en realidad, el objetivo de la votación, pero fue la víctima inocente de un enmarañado cónclave que, tratando de arrojar algo de luz sobre los revueltos cajones taxonómicos de la astronomía, no hizo sino intrincarlos aún más.

La historia tiene su origen en el verano de 2005, cuando el astrónomo del Instituto Tecnológico de California Michael Brown presentó en sociedad a 2003 UB313, un mundo gélido que gira alrededor del Sol a mayor distancia que Plutón y cuyo tamaño es un 10% mayor que éste. El nuevo cuerpo, llamado informalmente Xena y finalmente bautizado Eris, fue saludado en los medios de comunicación como “el décimo planetadel Sistema Solar”. El acontecimiento obligó a la UAI a dejar de ignorar por más tiempo una definición oficial de planeta. Plutón se había admitido como tal porque, de hecho, había surgido de la búsqueda de un planeta. En 1930, año de su descubrimiento, el número de cuerpos conocidos era mucho menor que ahora, y en un primer momento parecía que Plutón zanjaba las anomalías orbitales observadas en el Sistema Solar, cerrando el elenco planetario. Pero el avance de las ciencias espaciales ha revelado la presencia de otros centenares de objetos bajo la influencia gravitatoria del Sol. Muchos de ellos pertenecen al cinturón de Kuiper, una faja de asteroides situada más allá de Neptuno. De hecho, el propio Plutón pertenece a esta franja, lo mismo que el nuevo Eris. La órbita de Plutón, inclinada respecto al plano de las demás y que en un tramo de su trayectoria invade la ruta de Neptuno, situaba también al noveno planeta en el mismo cajón que Eris. La conclusión para la UAI era obvia: otodos, o ninguno.

Barrer la órbita

La primera intención era clara: todos. Ante su 26ª asamblea prevista para el mes de agosto en Praga, la UAI seleccionó a un comité de sabios para que redactase una definición. La propuesta que elaboraron admitía en la élite planetaria a cualquier objeto que orbitara en torno al Sol y que fuera lo suficientemente masivo para que su gravedad le confiriese forma esférica. Al comenzar la asamblea, todo indicaba que la Tierra se disponía a dar la bienvenida a tres nuevos planetas: Eris, Ceres –el mayor de los asteroides del cinturón entre Marte y Júpiter– y Caronte, un gemelo menor de Plutón que forma con éste un sistema doble. Es más: la fórmula abría la puerta a la incorporación de nuevos objetos de Kuiper que cumplieran las condiciones.

Pero entonces, algo ocurrió. Un amplio grupo de astrofísicos, expertos en dinámica orbital, opinaba que la definición no debía detenerse en lo puramente morfológico, sino incluir también un criterio físico. Según ellos, planetas son los que llevan sobre sus cabezas el peso gravitatorio de todo el sistema; por tanto, debía especificarse la necesidad de que un planeta reine en su espacio, lo que se traduce en el hecho de que debe barrer de su órbita otros objetos. Esta condición de limpieza orbital excluía a Plutón, cuyo recorrido está invadido por otro cuerpo mayor: Neptuno.

Astrónomos a puñetazos

Las discusiones, relataba en su blog la redactora de Nature Jenny Hogan, fueron feroces: hombres y mujeres hechos y derechos “a punto de pegarse puñetazos” por un quítame allá ese planeta. Los astrónomos hacían cola ante el micrófono. Entre el guirigay de abucheos y aplausos, el astrofísico italiano Andrea Milani gritaba: “¡La propuesta del comité es un insulto para los dinamicistas!”. “Nunca debió convertirse en algo tan emocional”, comentaba a Hogan George Miley, astrónomo de la Universidad holandesa de Leiden.

Al término de una de las convenciones más surrealistas de la historia de la ciencia, una abrumadora mayoría de manos alzadas daba la victoria a los astrofísicos. A las 3:32 de la tarde, hora de Praga, del 24 de agosto, Plutón era degradado a planeta enano. No perdía su nombre, pero recibía como triste apéndice elnúmero 134340.

La historia no acabó así. Los numerosos detractores de la decisión hicieron notar los defectos. Primero, de forma: sólo una pequeña proporción de los miembros de la UAI asistieron al congreso. Segundo, las propias contradicciones de la nueva definición; entre otras, la confusión que hace notar Sykes, o el hecho de que los 277 planetas extrasolares descubiertos hasta la fecha no estén contemplados en la fórmula –se habla únicamente del Sol–, o incluso lo que para Sykes es la “pesadilla para el profesor”: la órbita de Júpiter está ocupada por una miríada de asteroides llamados troyanos. Por otra parte, si Plutón no ha expulsado de su órbita a Neptuno, tampoco al contrario. Según el criterio de la UAI, argumenta Sykes, Júpiter y Neptuno no son planetas.

El astrónomo de Tucson propone una redefinición más geofísica, que elimine el criterio de limpieza orbital y englobe a los cuerpos celestes que giran alrededor de otras estrellas. Esto devolvería al club a Plutón, que traería consigo a su hermano Caronte, a Eris, y tal vez incluso a Sedna, ligeramente menor que Plutón y que tarda unos 12.000 años en dar una vuelta al Sol.

El debate no está cerrado. Para mantenerlo vivo, Sykes y otros científicos promueven una reunión que se celebrará el próximo agosto en la Universidad Johns Hopkins (EEUU) y que bajo el título El gran debate de los planetas: la ciencia como progreso discutirá las dos definiciones alternativas, con el fin adicional de mostrar a la comunidad educativa y, de forma transitiva, a los escolares, cómo es “el proceso continuo de hacer ciencia”. Además de preparar el camino para la próxima asamblea de la UAI, que se celebrará en Río de Janeiro en 2009 y donde sin duda el affaire Plutón aflorará de nuevo, tal vez las conclusiones ayuden a sentar criterios que no mareen a estudiantes como Jaime ni desconcierten a sus padres. O al menos, que aseguren que la próxima definición de la UAI no expulse del club de los planetas a la mismísima Tierra.

Anecdotario "plutónico"

Una sonda sin planeta al que dirigirse

Entre las varias peticiones que reclaman la devolución del grado de planeta a Plutón, aparece un nombre especialmente combativo: Alan Stern, astrónomo e investigador principal de la misión New Horizons de la NASA. Se trata de la primera sonda destinada a sobrevolar Plutón y recoger imágenes detalladas. Despegó de la Tierra en enero de 2006. Cuando llevaba siete meses en vuelo, pasó de tener el planeta Plutón como objetivo a tener el planeta enano 134340. Como es lógico, Stern no acepta la nueva definición: “Si la UAI proclama que el cielo es verde, eso no lo hace verde”, declaró. Además de Sykes y Stern, otros científicos y aficionados promueven webs para ‘salvar’ a Plutón, como plutopetition.com, pleasesavepluto.org, o www.savingpluto.org.

Protesta geológica: inventar una palabra que ya existe

La UAI eligió el nombre de ‘plutones’ para los cuerpos similares al planeta enano. Esto motivó la protesta de los geólogos, que llaman ‘plutónica’ a un tipo de roca. Owen Gingerich, de la UAI, justificó la elección de la palabra porque “al no figurar en el corrector ortográfico de Word, pensamos que no era una palabra común”. El científico Allen Glazner dijo que “es como si los botánicos encuentran otra cosa entre árboles y arbustos y deciden inventar la palabra ‘animal’ para describirlo”.

Luto planetario: un crespón negro

Tras la degradación de Plutón, alguien ató un lazo negro al panel de Plutón en el Smithsonian Institution de Washington.

Valor sentimental: el lamento de un niño