|

|

|

|

|

|

|

|

![]()

NOTICIAS CIENTÍFICAS

TITULARES DE LAS NOTICIAS DEL MES

La gravedad terrestre en forma de "papa"

Un robot español para farmacias

China será líder en producción mundial en el año 2013

¿Qué está pasando en Fukushima?

¿Ha adelantado una hora su reloj?

El éxodo rural fulmina los recursos naturales

Batido el límite de precisión de medida que impone la mecánica cuántica

Fukushima: la rutina del trabajo extremo

La temperatura media subió en España más de medio grado en los últimos 50 años

El mono europeo rejuvenece 2 millones de años

Buscan las ondas de las vibraciones del espacio y el tiempo en el Cosmos

La izquierda ve posible una España sin nucleares

La sonda Messenger llega a Mercurio

Una superluna podrá verse este sábado

Una terapia génica es eficaz para el Parkinson

Las palabras clave para entender el desastre nuclear

Los neandertales trajeron a Europa el fuego

Elminar basura espacial con rayos láser

Los Ángeles vuelven a la Edad de Hielo

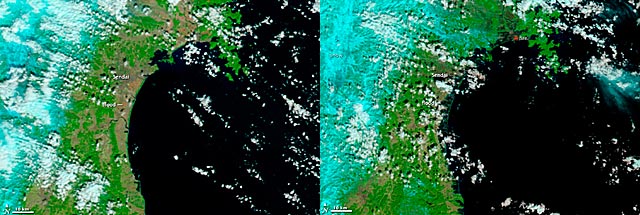

El terremoto desplaza 2,4 metros el eje de la Tierra

La Armada de EEUU no está lista para el deshielo

Posible fusión del núcleo de un reactor nuclear de Fukushima

¿Qué ha ocurrido en el terremoto de Japón?

Primeras imágenes del asteroide Apophis en 3 años

Predicciones numéricas del factor Q en mecánica cuántica

La industria pesquera americana del Paleolítico

La ciencia afea al FBI en el caso Antrax

El transbordador "Discovery" emprende su último viaje

Segundo vuelo del minitransbordador secreto de EEUU

Google no se hace cargo de los resultados de su buscador

Otro gran Cañón del Colorado en Marte

Los meteoritos pudieron detonar el inicio de la vida

Una explicación del extraño comportamiento del Sol

Un antibiótico evita que crezca el cáncer

-La gravedad terrestre en forma de "papa"

Después de sólo dos años en órbita, el satélite GOCE de la Agencia Espacial Europea (ESA) ha recopilado suficientes datos como para crear un mapa de la gravedad de la Tierra con una precisión sin precedentes. Los científicos tienen ahora acceso al modelo más preciso jamás producido del geoide para mejorar nuestra comprensión de cómo funciona la Tierra.

El modelo sirve para ilustrar las diferencias de gravedad en diferentes puntos del planeta. Así, las zonas de la recreación en color amarillo son aquellas donde la gravedad es mayor, mientras que en las azules el nivel es menor. El nuevo geoide, que recuerda a una patata, se dio a conocer este jueves en el Cuarto Taller Internacional para Usuarios de GOCE organizado en la Universidad Técnica de Múnich, en Alemania.

El geoide es la superficie de un océano global en ausencia de mareas y corrientes, en forma única por efecto de la gravedad. Es una referencia fundamental para medir la circulación de los océanos, el cambio del nivel del mar y la dinámica del hielo, todos ellos procesos afectados por el cambio climático. El profesor Reiner Rummel, ex jefe del Instituto de Astronomía y Geodesia Física en la Universidad Técnica de Múnich, explicó: "GOCE nos dará la topografía dinámica y patrones de circulación de los océanos con una calidad y resolución sin precedentes. Confío en que estos resultados ayudarán a mejorar nuestra comprensión de la dinámica de los océanos del mundo."

Además, los datos de gravedad de GOCE están ayudando a desarrollar un conocimiento más profundo de los procesos que provocan terremotos, como el caso de que recientemente devastada Japón.

Dado que este terremoto fue causado por el movimiento de las placas tectónicas bajo el océano, el movimiento no puede ser observado directamente desde el espacio. Sin embargo, los terremotos crean firmas en los datos de gravedad, lo que podría utilizarse para comprender los procesos que conducen a estos desastres naturales y en última instancia, ayudar a predecirlos.

El satélite GOCE fue lanzado en marzo de 2009 y lleva doce meses recogiendo datos de gravedad.

Volker Liebig, Director de Programas de Observación de la Tierra de la ESA, dijo que, beneficiado de un período de excepcional baja actividad solar, GOCE ha sido capaz de permanecer en órbita baja y lograr una cobertura de todo el planeta seis semanas antes de lo previsto.

"Esto también significa que todavía tenemos combustible para continuar midiendo la gravedad hasta final de 2012, duplicando así la vida de la misión, y agregar aún más precisión al geoide GOCE".

GOCE ha logrado muchas novedades en la observación de la Tierra, gracias a su gradiómetro, su órbita de menor altitud pese a su tonelada de peso, y su innovador motor de iones que genera fuerzas pequeñas para compensar la resistencia del satélite.

Fuente: elmundo.es, 31-3-11

![]()

-Un robot español para farmacias

"En el 2008 vi lo que se nos echaba encima con la crisis y pensé: 'Madre mía de mi alma'...". Así, con el miedo en el cuerpo, fue como a Javier Martín, vallisoletano de 42 años, le llegó el turno de arriesgar. O eso, o su empresa de ingeniería pasaba a mejor vida. Pensó entonces en las farmacias, en cómo modernizarlas, y se puso manos a la obra. Dos años de desarrollo y medio millón de euros después, nació R-evolution, un robot que dispensa medicamentos mediante tecnología de levitación magnética, similar a la utilizada en los prototipos de trenes de alta velocidad en China y Japón.

|

La idea a simple vista no es muy diferente de lo que ya existe. Un 4% de las 21.000 farmacias españolas están robotizadas. Y no son androides, es más sencillo. El farmacéutico aprieta un botón, un brazo mecánico se activa, serpentea entre decenas de estanterías en busca del medicamento, lo deposita en una cinta transportadora y, como si de una maleta en un aeropuerto se tratara, llega al mostrador. Todo en unos 18 segundos. "Estos robots valen entre 120.000 y 150.000 euros. Pero cada mes hay que pagar 600 o 1.000 euros de mantenimiento. Para una farmacia es insostenible. Y esto es justo lo que queremos cambiar", dice Martín. Su invención consiste en sustituir todas las piezas móviles por un campo de imanes fijos. Las fuerzas generadas entre los imanes, y no los elementos mecánicos, son las que desplazan el brazo robotizado a una velocidad de cinco metros por segundo. Un sistema conocido como levitación magnética y que en Japón, China o Corea del Sur intentan aplicar a gran escala para fabricar los trenes más rápidos del mundo. Gracias a esta tecnología, el R-evolution se mueve sin un solo cable. "Es completamente inalámbrico". Y esto resulta en una doble ventaja: cero coste de mantenimiento, "y cero es cero", recalca Martín, y mayor rapidez. Apenas 10 segundos para buscar, seleccionar y escupir el medicamento en manos del farmacéutico. |

Javier Martín, con su robot farmacéutico.- J. M.

|

Martín calcula que las farmacias podrían ahorrar en 10 años un 50% de lo que les costaría un robot normal. "El precio de adquisición es muy similar, pero la diferencia clave está en el mantenimiento", dice.

Su aspiración este año es conservadora, comercializar 25 unidades. ¿Venderá su patente a una multinacional? Niega cinco veces seguidas. El plan pasa por convencer directamente a las medianas y grandes farmacias, empezar en España y Portugal y luego dar el salto a Dinamarca, Suecia y Noruega. "Los países nórdicos están convencidos del valor de la tecnología".

Él y otros 16 empleados de la empresa, con sede en Valladolid, han diseñado también el software. De funcionar, de generar impacto internacional, quizás suponga un pequeño logro para la robótica industrial en España, sector en manos de norteamericanos, alemanes y japoneses. Al pensarlo, Martín recuerda que ni siquiera terminó sus estudios de ingeniería, "pero tampoco Bill Gates, ¿no?".

Fuente: elpais.com, 30-3-11

![]()

-China será líder en producción mundial en el año 2013

China arrebatará a EEUU el puesto de primer productor científico en 2013, según un estudio publicado por la Academia nacional de Ciencias de Reino Unido, la Royal Society en Londres.

En 1996, China produjo 25.480 estudios científicos, lo que la situaba como novena potencia mundial en una lista dominada por EEUU con casi 300.000 trabajos publicados. Aunque en 2008 EEUU seguía liderando la lista, con 316.000 estudios, China se había convertido en su mayor perseguidor por delante de Japón y Reino Unido, según el estudio.

De seguir el ritmo de producción de ambos países, China adelantará a EEUU en dos años en un panorama científico cambiante en el que la producción de los antiguos pesos pesados como EEUU,Japón, Reino Unido y Alemania va en declive mientras la de potencias emergentes como India, Brasil y Corea del Sur aumenta.

Los datos del estudio no suponen que China vaya a ser el país más influyente en ciencia. El volumen de producción debe compararse también al de la calidad de los estudios publicados. Mientras el indicador usado por la Royal Society sólo contabiliza el número absoluto de estudios, otro índice conocido como el impacto contabiliza lo influyentes que son los trabajos de cada país a nivel mundial. "La calidad de los estudios de China es media, pues publican muchos resultados que ya habían hecho otros", advierte Juan José Damborenea, vicepresidente del CSIC. "En unos años veremos también una explosión en la calidad de sus trabajos", advierte.

Fuente: publico.es, 29-3-11

![]()

-¿Qué está pasando en Fukushima?

|

Los ingenieros japoneses están luchando a contrarreloj por hacerse con el control de la central nuclear de Fukushima Daiichi, después de que el pasado 11 de marzo resultara gravemente dañada por el terremoto y el posterior tsunami. Sin embargo, los avances son pocos y los problemas son cada vez mayores. De los seis reactores con los que cuenta la central, dos se encuentran estables, pero el resto están seriamente dañados y son imposibles de controlar. ¿Qué se puede hacer entonces ante el desastre nuclear más importante después de Chernóbil? Los más de 100 trabajadores que permanecen en la central y que trabajan en turnos rotatorios de 50 en 50 luchan 17 después de la catástrofe por reiniciar las bombas de refrigeración de los reactores 1, 2, 3 y 4, los más dañados y peligrosos, en especial el 3 que contiene plutonio. El desafío más inmediato es bombear el agua radiactiva que ha inundado los sótanos de los números 1, 2 y 3, y que están obstaculizando el restablecimiento de la electricidad que permita a los trabajadores encender las bombas de refrigeración y así enfriar reactores y las piscinas de combustible. Además, los mayores problemas se plantean ahora en el reactor número 2, el cual está emitiendo altos niveles de radiación situados en más de 1.000 milisievert y la hora y en el que el Gobierno cree que se ha producido una fusión parcial de su núcleo al derretirse parte de sus barras de combustible. Además, la compañía ha informado de que se ha detectado agua con altos niveles de radiación en el exterior de este reactor. El portavoz del Gobierno japonés, Yukio Edano, dijo que ese alto nivel de radiación en la unidad 2 podría provenir del contacto de agua con material de las barras de combustible nuclear parcialmente fundido. Mientras tanto, en el reactor número 1 se ha conseguido hacer llegar la corriente eléctrica para evacuar el agua radiactiva, aunque después de cuatro días los avances son ínfimos. Lo mismo ocurre en el resto de reactores y la empresa ya empieza a plantearse nuevas estrategias para atajar la crisis nuclear. ¿Cuánto tiempo podría durar?Nadie lo sabe. El escenario más probable es una batalla larga, incansable e interminable con pequeños avances en la refrigeración y graves problemas con la radiación. . |

|

Una vez que las bombas y los sistemas de extracción de calor residual estén en funcionamiento, sólo llevaría un par de días para que los reactores entrarán en parada fría. Sin embargo, los ingenieros están trabajando completamente a oscuras lo que dificulta las tareas, y sólo se ha conseguido algo de luz en la sala de control del reactor 3. Además, las mediciones de radiación se siguen haciendo manualmente porque los puestos de control no funcionan.

A esto hay que sumarle que los trabajadores se encuentran además con tuberías rotas, escombros, equipos inundados y la falta de bombas de oxígeno de repuesto. Algunos expertos sospechan de graves daños en la estructura de contención alrededor del reactor 2, y se cree que podría tomar hasta meses para que ese reactor entre en parada fría

El principal riesgo proviene de la radiación que se filtre o que llegue a explotar si se producen fugas en las tuberías o un aumento de la presión que los trabajadores no puedan liberar.

Un portavoz de la Agencia de Seguridad Nuclear e Industrial japonesa, Hidehiko Nishiyama, ha informado de que los niveles de yodo radiactivo en el agua de mar recogida en las inmediaciones supera ya en 1.250 veces el límite legal.

Beber medio litro de este agua supondría exponerse a un milisievert de radiación, el límite anual recogido en las leyes japonesas, ha señalado Nishiyama, según declaraciones recogidas por la agencia de noticias japonesa Jiji.

Las fugas de agua radiactiva podrían entrar en contacto directo con la tierra y el mar, mientras que los picos de radiactividad podrían contaminar cultivos en un radio más amplio que el de hasta ahora. El riesgo de que las piscinas de combustible de los reactores entren en estado crítico es poco probable, según algunos expertos, siempre y cuando haya trabajadores y bomberos que estén dispuestos a continuar enfriando las piscinas con camiones cisternas que viertan agua sobre ellos.

Sin embargo, algunos expertos dice que hay cierto riesgo de que se produzca una explosión de vapor, en particular en el número 1, que es la planta más antigua de las seis. Se produciría un aumento de la temperatura y una liberación repentina de gran cantidad de hidrógeno en el recipiente de contención. En caso de que eso ocurra, podría dispersarse altos niveles de radiación en un radio de hasta 20 kilómetros alrededor.

Lo más probable es que así sea. Incluso después de una parada fría quedarán toneladas de deshechos nucleares bajo los reactores. Inyectando plomo como se hizo en Chernóbil para tapar esos residuos se podría contener la radiación y vivir relativamente cerca de la planta, aunque sólo por un periodo de tiempo porque a lo largo del tiempo acabarán expulsando partículas radiactivas.

El combustible nuclear gastado en Fukushima ha sido dañado por el agua de mar, por lo que el reciclado no es una opción, mientras que transportarlo a otra parte es improbable dada la oposición que la propuesta traería. La otra opción, que algunos barajan, es crear un sarcófago similar al que ahora mismo se encuentra en Chernóbil, el problema es que a los 30 años, el sarcófago deja de contener la radiación.

Fuente: elmundo.es, 28-3-11

![]()

-¿Ha adelantado una hora su reloj?

|

Esta madrugada ha comenzado la hora de verano y los relojes se han adelantado una hora (a las 02.00h han sido las 03.00h), un cambio con el que se estima que cada hogar español ahorrará seis euros en consumo eléctrico. Según el Instituto para la Diversificación y Ahorro de la Energía (IDAE) -entidad del Ministerio de Industria, Turismo y Comercio- el potencial de ahorro en iluminación por el cambio de hora puede llegar a representar un 5% del consumo eléctrico en iluminación, unos 300 millones de euros. De esa cantidad, 90 millones corresponderían al potencial de los hogares españoles, lo que supone un ahorro de seis euros por hogar durante el período llamado "horario de verano", mientras que los otros 210 millones se ahorrarían en los edificios del sector terciario y en la industria, según estimaciones del IDAE. Ahorro energéticoPara alcanzar este ahorro, el IDAE, no obstante, recomienda llevar a cabo un comportamiento responsable en el hogar a la hora de prescindir de la iluminación artificial cuando no es necesaria, así como el uso de tecnologías de ahorro en edificios industriales y otros. Estas tecnologías consisten en fotocélulas o sensores de luz que apagan o regulan la iluminación artificial en función de la luz natural a través de ventanas o lucernarios. |

Esta madrugada comienza el 'horario de verano'. |Christian Hartmann/Reuters |

En este sentido, el IDAE ha mencionado que el Código Técnico de la Edificación hace ya obligatoria la instalación de estos sistemas en los edificios de nueva construcción y que existen ayudas para reformar la iluminación en los edificios del sector terciario. Además, independientemente del cambio de hora, el Ministerio de Industria, Turismo y Comercio y el IDAE han aconsejado a los ciudadanos contribuir al ahorro de energía durante todo el año haciendo un uso inteligente de la iluminación.

"Seguir determinadas pautas o hábitos puede permitirnos, sin renunciar al confort, ahorrar hasta 100 euros al año, además de evitar emisiones contaminantes a la atmósfera", han asegurado.

Entre las recomendaciones: usar colores claros en la decoración de la casa (el ambiente es más luminoso), limpiar con regularidad las fuentes de luz, ya que la suciedad acumulada dificulta la correcta difusión; y elegir bien las bombillas de bajo consumo.

El cambio de hora comenzó a generalizarse, aunque de manera desigual, a partir de 1974 cuando se produjo la primera crisis del petróleo y algunos países decidieron adelantar sus relojes para aprovechar mejor la luz del sol y consumir así menos electricidad en iluminación.

Desde la aprobación de la novena directiva por el Parlamento Europeo y Consejo de la Unión, en enero de 2001, este cambio se aplica con carácter indefinido. Esta directiva está incorporada al ordenamiento jurídico español por real decreto desde el 1 de marzo. El carácter indefinido de la aplicación del cambio de hora se ha adoptado porque se entiende que "el buen funcionamiento de algunos sectores, no sólo el de los transportes y las comunicaciones, sino también otros ramos de la industria, requiere una programación estable a largo plazo", ha recordado el IDAE en una nota de prensa.

Esta directiva establece con carácter permanente las fechas de inicio del período de la hora de verano el último domingo de marzo y su finalización -cuando se retrasa el reloj una hora- el último domingo de octubre respectivamente.

El pasado mes de febrero, el presidente ruso, Dmitri Medvedev, anunció la anulación de los cambios de horario anuales en su país. De este modo, ésta será la última vez que los rusos tengan que adelantar el reloj. A partir de entonces, la hora rusa será la GMT+4. Con esta medida, Rusia se une a las voces críticas con el cambio de hora. De hecho, la Comisión Europea reconocía en 2000 que el ahorro energético era "relativamente modesto", entre un 0 y un 0,5%, tesis que corrobora Red Eléctrica de España, que lo considera "insignificante, no relevante".

Fuente: elmundo.es, 27-3-11

![]()

La función de las Reservas de la Biosfera es proteger tanto los recursos naturales como el desarrollo económico y humano de estos territorios. Muchas de estas zonas, no obstante, se enfrentan a un grave problema de éxodo rural que termina no sólo con un abandono de la cultura y las tradiciones de la región sino también de la conservación del entorno. La Reserva de la Biosfera de Alto Bernesga (León) ha sufrido un importante descenso de población en los últimos años. Uno de los municipios que la integran, La Pola de Gordón, ha puesto en marcha un programa, con el apoyo de la Fundación Biodiversidad, para luchar contra la despoblación en la zona. A través de la cualificación y formación de las mujeres rurales, el objetivo es la recuperación demográfica y socioeconómica de esta reserva. "El binomio hombre-biosfera es lo más importante, y hay que evitar la extinción del primero en estas zonas", explica Benedicta Rodríguez, técnica gestora de la Reserva de Alto Bernesga.

|

El proyecto que han desarrollado se compone de tres puntos: formación, orientación a emprendedores y creación de asociaciones de empresarios. "Hay que hacer que los oficios tradicionales sean rentables, darles una visión de mercado actual", añade Rodríguez. Además de cursos de formación homologada en diferentes áreas, el programa anima a sus vecinos a utilizar los recursos naturales para crear productos y servicios innovadores y productivos económicamente. Rodríguez señala que la agricultura y la ganadería ecológicas, así como la apicultura o la formación en turismo "no sólo pueden ser rentables sino que también ayudan a recuperar montes y pastos". Aunque la visión económica tradicional presenta como incompatibles el de-sarrollo de las comunidades rurales y la conservación de la naturaleza, la orientación que se ofrece a estos nuevos emprendedores promueve el crecimiento aprovechando los espacios naturales. La agricultura ecológica, por ejemplo, fertiliza y frena la desertificación, manteniendo los hábitats de los animales silvestres. El programa puesto en marcha en La Pola de Gordón incluye un análisis de la situación de partida para conocer los aspectos relacionados con la finca (suelo, clima, etc.) y saber cómo se va a enfocar la nueva gestión. "La implantación de marcas de calidad, denominaciones de origen y etiquetas ecológicas supone un alto valor añadido para estas zonas", resume Rodríguez. |

Cooperativa de cultivo de frambuesa puesta en marcha en La Pola de Gordón. B. R.B. S. |

La elevada participación de mujeres unas 350 colaboraron en la primera fase del proyecto, que terminó el pasado enero ha llevado a ampliar el programa un año más. Un Observatorio Permanente sobre despoblación y mujer rural realizará un seguimiento de los resultados obtenidos. El propósito es que los 5.200 vecinos que componen la Reserva de la Biosfera de Alto Bernesga no sólo no se sigan reduciendo sino que tengan la posibilidad de ampliarse.

Fuente: publico.es, 26-3-11

![]()

-Batido el límite de precisión de medida que impone la mecánica cuántica

¿Se puede medir algo con infinita precisión o hay un límite? En teoría sí, según el llamado límite de Heisenberg, consecuencia de uno de los pilares de la mecánica cuántica, el principio de incertidumbre, que dice que si se conoce exactamente dónde se encuentra un objeto muy pequeño, como un átomo, no se pude saber a dónde se dirige, explican unos científicos del Instituto de Ciencias Fotónicas (ICFO) de Barcelona. Sin embargo ellos han logrado soslayar ese límite teóricamente infranqueable y han medido en un experimento señales magnéticas ultradébiles. Eso sí, puntualizan que el resultado no significa que el principio de incertidumbre de Heisenberg sea incorrecto, destaca el Instituto de Física (IOP) británico, sino que no se sabe bien cómo manejarlo en sistemas de múltiples partículas.

|

Ilustración del principio básico del experimento de medida ultrasensible de un átomo con haces láser, realizado por científicos del Instituto de Ciencias Fotónicas (Barcelona).- ICFO |

El logro del equipo que dirige Morgan Mitchell en el ICFO, presentado en la revista Nature, no sólo es un hito de física básica por lo que tiene de avance en la comprensión de los mecanismos que limitan la precisión de las medidas, sino que puede tener aplicaciones importantes, por ejemplo en aparatos de investigación y diagnóstico médico para ver con detalle cómo interactúan las neuronas del cerebro. También permitirá hacer relojes atómicos más precisos que los actuales. En otro campo también de física fundamental, la detección de ondas gravitacionales que emiten fenómenos como las colisiones de agujeros negros, puede verse beneficiada por este avance al mejorar las posibilidades de precisión. "Supongamos, por ejemplo, que queremos medir la temperatura del agua caliente introduciendo un termómetro en ella", plantean los expertos del ICFO en un comunicado de la Universidad Politécnica de Cataluña. "Dicho termómetro está frío y, al entrar en contacto con el agua, la enfría ligeramente", continúa. "El dato obtenido sigue siendo una buena aproximación de la temperatura, pero su exactitud no llega hasta la billonésima de grado; el termómetro ha modificado casi imperceptiblemente la temperatura que estábamos midiendo". La idea es que para alcanzar precisión extrema, los instrumentos de medida tienen que ser cada vez más pequeños, y se acaba llegando al mundo de los átomos o los fotones (las partículas de luz) que se rigen por las leyes de la mecánica cuántica. De acuerdo con el principio de Heisenberg, nada puede ser medido sin cambiarlo "ya que cuando una herramienta de medida interacciona con el objeto que se está midiendo, le está transfiriendo su incertidumbre intrínseca". Así, "según cómo se sumen todas las incertidumbres entre herramientas y partículas, se llega a un límite último de sensibilidad". Mario Napolitano y sus colegas del equipo de Mitchell han hecho los experimentos disparando pulsos de láser a una muestra de átomos de rubidio ultrafríos y contenidos sen una trampa óptica. Pero, en lugar de utilizar cada uno de los fotones del láser de forma independiente y hacer la medida, ellos hacen trabajar conjuntamente a los fotones. Logran así amplificar la señal y mejorar en diez veces la sensibilidad de la medida del campo magnético, demostrando que es posible superar el límite. Más técnicamente, los científicos han utilizado un interferómetro de polarización. La idea del experimento procede de trabajos teóricos de hace unos años, uno del español Alfredo luis (Universidad Complutense), de 2005, y otro de Carlton Caves (Universidad de Nuevo México, EEUU), de 2007, sobre lo que podría considerarse la superación del límite de Heisenberg. Napolitano, Mitchell y los demás miembros del equipo han puesto en práctica ahora la idea del estadounidense. |

Con sensores ópticos basados en átomos y la demostración de los científicos del ICFO se podrían desarrollar instrumentos compactos y sencillos para hacer magnetoencefalogramas y obtener imágenes del campo magnético cerebral con altísima resolución y en tiempo real, señalan los expertos. También se podrían mejorar los relojes atómicos. En cuanto a los detectores de ondas gravitacionales, como el LIGO, que ya funciona en EE UU pero aún en fase de mejora de sus prestaciones, se podría dar un paso adelante. Ligo está diseñado para registrar las distorsiones del espacio-tiempo de las ondas gravitacionales mediante la medida ultraprecisa de diferencias minúsculas que deben sufrir los haces láser del detector al pasar una de esas ondas, explica Edwin Cartlidge en Physicsworld.com. Según el físico teórico Jonathan Dowling, con el avance de los científicos de Barcelona se puede mejorar la sensibilidad de Ligo o reducir mucho la potencia de los láseres, lo que evitaría el calentamiento potencial y la deformación de los instrumentos ópticos.

Fuente: elpais.com, 25-3-11

![]()

-Fukushima: la rutina del trabajo extremo

Humo blanco, humo negro, electricidad a veces y otras no, evacuaciones... El trabajo en la central nuclear se ha convertido más en una rutina que en una cuenta contrarreloj para frenar la crisis de la central.

Después de 13 días desde el terremoto y el tsunami que asoló Japón, la situación en Fukushima y las noticias que de allí llegan parecen boletines similares un día sí y al otro también. ¿Se avanza realmente en Fukushima? Tras las explosiones de los reactores 1 y 3 y los incendios del número 4, la mecánica en la planta nuclear se ha convertido casi en una rutina. Un día, los bomberos de la central luchan contra el humo que sale del reactor más peligroso y dañado, el 3, y al día siguiente vuelve a su sala de control para intentar dominar las altas temperaturas que se registran en la piscina del reactor.

|

Operarios intentando instalar el circuito eléctrico en la central nuclear. EFE |

Evacuaciones parciales que paralizan momentáneamente los trabajos para regresar horas después y continuar con la refrigeración de los reactores a través de los camiones cisternas que vierten agua sobre estos. Son momentos de pánico que por las pocas imágenes que van llegando de lo que sucede en el interior de la central muestran el peligro y duro trabajo al que están sometidos los 180 trabajadores que en turnos de 50 siguen en la central, así como de los bomberos enviados a por el Gobierno para ayudar en las labores de refrigeración. Una vez controlado el humo -ha habido dos escapes en el 3 de humo negro y uno en el dos de humo blanco-, lo que más preocupa a la compañía dueña de la central es situar en los niveles de seguridad la temperatura de las piscinas donde se encuentran las barras de combustible del núcleo. Para ellos, además de los camiones cisterna, que ya van en su quinto día vertiendo toneladas de agua, se ha luchado por hacer llegar la electricidad a los reactores a través de cables de energía. De momento, se ha logrado conectar en el 1 y en el 3, aunque este miércoles una columna de humo detectada en este último obligo a desconectar la energía y a parar de nuevo los trabajos en la central. |

Las informaciones que dan la televisión japonesa y sus agencias son una constante: humo en el reactor 3, evacuación, vuelta al trabajo e intentos para refrigerar la central. Sólo este miércoles, 12 días después de la tragedia se pudo ver por primera vez cómo trabajan los bomberos y los operarios de la central. Con máscaras, a oscuras y cubiertos por pesados monos para protegerles de la central se ha podido ver como intentan apagar los incendios y el humo de los reactores o como acceden a sus de control para medir la radiación y comprobar que no hay ningún escape radiactivo.

Todo ello sometidos a unos niveles de radiación que ya superan los 150 milisievert situados como máximos por la central. De hecho, este jueves tres trabajadores resultaban heridos por su exposición. Dos de ellos han tenido que ser trasladados al hospital al presentar graves quemaduras en sus piernas al haber entrado en contacto con agua contaminada por la radiactividad.

Sin embargo, ellos siguen allí día tras día intentando en ocasiones con éxito y otras sin él controlar lo que ya muchos llaman desastre nuclear. Poco se sabe sobre qué va a ocurrir si se logra por fin refrigerar los reactores y qué medidas se tomarán después en la central. Lo único que ha asegurado el Gobierno es que la planta será desmantelada, pero se desconoce aún si se utilizará un sarcófago similar al de Chernóbil para enterrar bajo él los reactores o cuál será la mejor opción para proteger de la radiactividad a Japón. Mientras en la central la mejoría es en algunas ocasiones insignificante y las tareas continúan desde hace días en el mismo punto muerto, fuera de ella el miedo a la radiactividad aumenta en la población tras detectarse yodo 131 y cesio 136 en alimentos cercanos a Fukushima y en el agua corriente de varias prefecturas y en Tokio.

De momento, varios países como EEUU, Rusia y China han prohibido las importaciones de alimentos procedentes de la zona de la central, mientras que en Tokio el agua embotellada empieza a escasear tras la recomendación de las autoridades de no dar agua del grifo a los bebés por la radiactividad hallada en dos piscifactorías.

Fuente: elmundo.es, 24-3-11

![]()

-La temperatura media subió en España más de medio grado en los últimos 50 años

La temperatura media ha subido en España algo más de medio grado (0,55) en los últimos 50 años. Sin embargo, el promedio de precipitaciones no ha aumentado significativamente y está estabilizado en 648 milímetros al año. Son datos extraídos de las últimas actualizaciones elaboradas por la Agencia Estatal de Meteorología (Aemet)que ha presentado la agencia, además del primer atlas climático de la península ibérica, con motivo del Día Meteorológico Mundial.

El presidente de la Aemet, Ricardo García Herrera, ha explicado en una rueda de prensa que en esta subida media de las temperaturas hay que tener en cuenta que los años 70 fueron muy fríos. Como contraste, la última década (2000-2010) fue la más cálida de los últimos 50 años. Concretamente, entre 1991 y 2010, las temperaturas registradas fueron muy altas, y no solo en España, sino en líneas generales en todo el mundo, según García.

La Aemet ha analizado la evolución climatológica entre los años 1961 y 2010, que ha dividido a su vez en tres periodos. De 1961 a 1990, la temperatura media anual se situó en los 14,43 grados; de 1971 a 2000, en 14,63 grados; y de 1981 a 2010, en 15,09 grados. Esta evolución muestra que durante el último periodo la temperatura aumentó más del doble respecto a lo observado entre los dos periodos de referencia anteriores, pasando de 0,22 a 0,46 grados de diferencia.

García ha señalado que este aumento de los termómetros es una muestra más del cambio climático, y ha llamado a la responsabilidad de todos para frenar el calentamiento global, porque, según ha dicho, el futuro de este"no está escrito". En este sentido, el presidente de la Aemet ha recordado que "la misión de la agencia no es solo predecir el clima sino vigilarlo para contribuir en las políticas medioambientales del Gobierno".

Un informe de la Aemet sobre el impacto del cambio climático en España presentado en julio del año pasado señala que entre 2071 y 2100 las temperaturas máximas crecerán entre 3 y 6 grados, mientras que las mínimas también se verán afectadas, aunque en menor medida, y subirán en ese mismo periodo entre 2 y 5 grados. En cuanto a las precipitaciones, las proyecciones no muestran un cambio significativo en la primera mitad del siglo XXI, pero la posibilidad de sufrir más sequías y vivir estaciones con pocas lluvias será más acusada a partir de 2050. Según los cálculos de la Aemet, la última década del actual siglo será la peor, cuando las lluvias se reducirán hasta un 30% respecto al periodo comprendido entre 1961 y 1990, el anterior sometido a análisis.

¿Quién mide la temperatura y las precipitaciones?

Los datos de esta evolución han sido recopilados de "las 43 mejores estaciones de precipitaciones y temperaturas" de las 4.500 que hay repartidas por todo el territorio nacional. "Un 60% del total de estas estaciones son atendidas por nuestros colaboradores altruistas", apunta un portavoz de Aemet. Las estaciones no son más que una garita pequeña compuesta por varios termómetros y un pluviómetro para medir la cantidad de agua. Deben instalarse en el exterior y a la sombra. Puede ser un párroco, la Guardia Civil o un agricultor quien acuda a la cita diaria con la meteorología. En definitiva, cualquier ciudadano que de forma voluntaria quiera colaborar con la agencia.

Entre ellos se encuentra Manuel Capelo, de 76 años, quien lleva midiendo los litros de agua por metro cuadrado que caen en Moguer (Huelva) desde hace más de 40 años. La Aemet ha querido reconocer a este agricultor jubilado por su colaboración desde 1963. También a los veteranos Antonio García (estación de Liérganes, Cantabria) y Juan González (estación de Arona en Tenerife), dentro de los actos de celebración de este día. "Me gusta informar a la gente del pueblo cuando me pregunta cuánto ha llovido", ha dicho el andaluz, minutos antes de recibir el galardón en la sede de la Aemet.

Fuente: elpais.com, 23-3-11

![]()

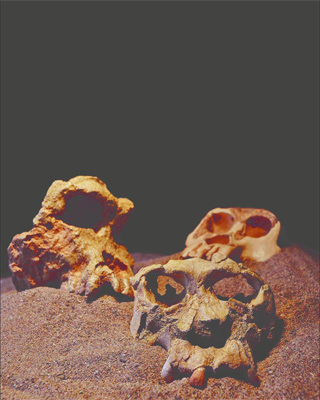

Siete millones de años después de su extinción, un equipo de investigadores españoles quiere quitarle antigüedad al mono europeo. Creen que los primeros monos hominoideos, parientes del orangután de hoy, llegaron al viejo continente hace 14 millones de años, dos millones de años después de lo que se pensaba.

La propuesta, publicada hoy en PNAS por un equipo del Instituto Catalán de Paleontología (ICP), recorre un periodo del Mioceno en el que se estaban fraguando las características físicas que ayudarían a los monos a bajar de los árboles y convertirse en hombres capaces de bombardear ciudades o escribir poemas. Aún es un misterio si algunas de esas características, como la de moverse con la espalda recta, se las debemos a monos de Europa, Asia o África. Es una pregunta por la que los paleontólogos son capaces de rebuscar en un basurero.

Eso es a lo que se dedica el equipo del ICP en Can Mata, un vertedero cercano a Barcelona donde pueden sepultarse 3.000 toneladas de basura al día. Entre la tierra removida por las excavadoras han aparecido en los últimos años hasta tres especies de hominoideos que vivieron hace unos 11,8 millones de años. Entre ellas está Pau, conocido como el primer catalán.

Los descubridores de Pau, autores del nuevo árbol

genealógico, sitúan en África el comienzo de esta historia. Hace unos 18

millones de años, África salió de su ostracismo, explica Isaac Casanovas-Vilar,

investigador del ICP y coautor del estudio. La retirada del Mediterráneo y

el Oceáno Índico inauguró una nueva autopista de dos carriles.

"Los elefantes fueron los primeros en salir de África hacia Asia y Europa",

apunta. Según el nuevo trabajo, los simios siguieron el mismo camino que los

elefantes hace unos 14 millones de años.

La llegada a Europa del primer primate hominoideo, un linaje del que también

forman parte los grandes simios y el hombre, es aún materia de disputa. Un

equipo alemán dice que se remonta a hace 16 millones de años basándose en un

diente encontrado en Baviera y descrito en 2001, un año antes que Pau. Según

Casanovas-Vilar, la datación de este pionero no era fiable, por lo que su

equipo volvió a analizar su fecha de acuerdo a otros estudios que han

analizado estratos de terreno de la misma antigüedad que los de Engelswies,

donde apareció el molar. "Aún no se sabe si ese diente viene de ese

yacimiento y, de hecho, todo induce a pensar que no", opina Casanovas-Vilar.

Ante la duda, el trono del hominoideo más antiguo de Europa es para Turquía,

donde se han hallado restos de unos 14 millones de años. Desde ahí, este

grupo de simios, los driopitecos, se extendió de rama en rama por una Europa

cubierta de bosques, donde por aquella época las temperaturas eran mucho más

cálidas y las estaciones poco marcadas. Así era también Catalunya, donde

hasta tres especies de seres peludos de en torno a un metro y unos 30 kilos

recorrían parsimoniosamente las copas de los árboles en busca de los frutos

de los que se alimentaban. "Aquí encontramos una diversidad de géneros que

supera la que vemos actualmente en otros continentes", destaca Casanovas-Vilar.

Los cráneos de 'Pau' y 'Jordi' (derecha), junto a otro

hominoideo de Grecia. I. C.-V

Espalda recta

De todos los yacimientos de Asia y Europa, el vertedero de Can Mata es el primer sitio donde un primate puso la espalda recta. Era Pau, quien, según los autores, ya tenía un rasgo de modernidad que heredaron los actuales orangutanes de Asia.

Hace años, los descubridores de Pau pensaron que estos simios migraron después a África, donde aportaron sus espaldas rectas y otros rasgos de modernidad al linaje que desembocaría en el Homo sapiens unos 11 millones de años después. Pero la aparición de nuevos fósiles en África y la nueva datación de los restos europeos les ha hecho cambiar de idea y pensar que las espaldas rectas surgieron en dos momentos distintos de la evolución y en dos continentes diferentes. La del hombre no se hizo en Europa, sino en África, lo que implicaría que el mismo rasgo se desarrolló por separado.

"Es una buena hipótesis y es sólida, pero aún es una posibilidad entre tantas porque no hay pruebas concluyentes", advierte Jean-Jaques Jaeger, paleoprimatólogo de la Universidad de Poitiers (Francia). Jaeger defiende que en la época en que los primeros hominoideos salieron de África ya había simios de este grupo en Asia, pero reconoce las limitaciones de su teoría. "Los comienzos de este grupo en Asia son una pregunta sin respuesta, pues no hay restos de esta época", lamenta.

El problema de reconstruir una larga historia que pudo comenzar hace 50 millones de años es que todos los caminos acaban en un vacío. Tanto en Asia como en África hay periodos en los que no hay fósiles, por lo que la evolución no se muestra a los ojos de los paleontólogos como una secuencia, sino como carpetas de fotos con criaturas similares entre sí pero muy diferentes de las que aparecen en la carpeta siguiente. Tanto la teoría asiática como la africana se topan con esos vacíos de los que por ahora es difícil salir sin tomar posición por un bando u otro.

El grupo español no descarta que los homínidos como el chimpancé y el humano moderno tengan su antepasado en Asia o incluso Europa, pero tampoco lo defiende.

"No se puede descartar que se deriven de formas europeas, pero parece que hay más datos que apoyan la opción africana", señala el experto. Según su hipótesis, el linaje de chimpancés y hombres surgiría en África a partir de unas criaturas llamadas afropitecos que aparecieron hace unos 20 millones de años en África. La historia se corta hace unos 14 millones de años, fecha a partir de la cual no se tienen restos de este continente. El relato continúa tras un apagón de 10 millones de años, cuando aparecen los primeros australopitecos en África. Detrás de ellos llegarán al fin los primeros humanos. "Nos falta buena pa

rte de esta historia de evolución en África", reconoce Casanovas-Vilar, que opina que los restos deben encontrarse no en el este y sur de África, muy explorado por los paleontólogos, sino en zonas como Chad, menos exploradas por los científicos debido a las impenetrables junglas y los conflictos bélicos.Jaeger afronta también un vacío. Él mantiene que los primeros hominoideos que aparecen en Asia, de hace unos 50 millones de años, acaban por llegar a África hace unos 38 millones.

Pero entre ambos hay un vacío entre hace 32 y 25 millones de años durante el que no hay ni un solo fósil de estas especies en Asia. El experto le da la vuelta a los datos del grupo de Casanovas-Vilar. "En Pakistán, los últimos restos de hominoideos aparecen hace 12,5 millones de años y en Catalunya hace 12 millones", comenta. La falta de fósiles no deja claro en qué sentido viajaron los hominoideos y hacia dónde. "Estas especies pudieron muy bien llegar de Asia".

Poco después de que Pau y el resto de monos catalanes trepasen por las junglas de lo que hoy es Can Mata, el tiempo empezó a cambiar. De hecho ya había empezado y empeoró hasta lo invivible. Las temperaturas bajaron gradualmente y llegaron picos de frío y de calor que, en una escala de cientos o miles de años, acabaron dándole forma a unas estaciones marcadas.

Esto acabó con los árboles de cuyos frutos se alimentaban los hominoideos y, indefectiblemente, con su linaje. El rastro de los hominoideos reconstruido por el equipo del ICP también reseña el destino de los últimos monos europeos. Empujados por el enfriamiento, sólo unas cuantas bolsas de resistencia aguantaron en países como Grecia, donde se han hallado lo que parecen los penúltimos monos europeos salvando a los macacos gibraltareños, desaparecidos hace unos siete millones de años, según Casanovas-Vilar. "Esta es una historia que acaba mal", señala, "aquellas especies desaparecieron sin dejar rastro".

A los científicos les gusta decir que la evolución es como un gran libro del que apenas tenemos unas pocas páginas. Y en el vertedero de Can Mata, 50 kilómetros al norte de Barcelona, ha aparecido un puñado de esas páginas. Los paleoantropólogos han conseguido intuir qué lugar ocupaban en el libro de la evolución. Allí apareció el ‘Pierolapithecus catalaunicus', bautizado ‘Pau' por el Instituto Catalán de Paleontología porque se presentó en 2004 coincidiendo con las manifestaciones masivas contra la guerra de Irak. ‘Pau' significa paz en catalán. Según los investigadores, el animal, que vivió hace unos 12 millones de años, ya tenía un cuerpo erecto para trepar verticalmente por los troncos. Tras ‘Pau', apareció ‘Lluch', perteneciente a otra nueva especie de primate: ‘Anoiapithecus brevirostris'. Sus descubridores lo bautizaron ‘Lluch' ( ‘el que ilumina'), porque iluminó la evolución de los homínidos en el Mediterráneo. Vivió hace 11,9 millones de años y tenía rasgos primitivos y modernos. Era una especie de transición. Además de ‘Pau' y ‘Lluch', en las obras de ampliación del basurero de Can Mata han aparecido más de 50.000 fósiles y queda trabajo científico para años.

Kenyapithecus

El estudio de los fósiles catalanes muestra que los Kenyapithecus eran dos millones de años más jóvenes de lo que se pensaba y habrían surgido hace unos 14 millones de años. El paleoantropólogo Louis Leakey, descubridor del ‘Homo habilis', halló los primeros restos de este género extinto en la década de 1960 en Kenia. Según algunos estudios científicos, los Kenyapithecus habrían sido pioneros en la salida de los monos de África.

Afropithecus

La familia Leakey también desenterró y bautizó en 1986 los primeros restos fósiles de ‘Afropithecus turkanensis', en Kenia. Las primeras dataciones apuntaron a una edad de entre 16 y 18 millones de años. Por la edad a la que dataron su primera muela, el profesor de la Universidad de Illinois Jay Kelley propuso una historia vital de los Afropithecus similar a la de los chimpancés.

Griphopithecus

Después de los restos hallados en Engelswies (Alemania), los fósiles de hominoideos desenterrados en Turquía, en Pasalar y Çandir son los más antiguos de Eurasia. En ambos yacimientos hay ‘Griphopithecus alpani', con unos 15 millones de años de antigüedad.

Oreopithecus

El llamado mono de los pantanos, cuyos restos se han hallado en

lo que hoy es Italia, en la Toscana y Cerdeña, pesaba unos 30 kilogramos. Vivió hace unos ocho millones de años. Según los estudios de sus fósiles, podían caminar sobre dos patas, pero no con excesiva rapidez.Fuente: publico.es, 22-3-11

![]()

-Buscan las ondas de las vibraciones del espacio y el tiempo en el Cosmos

Los científicos cada día están más cerca de desentrañar los misterios que rodean a los agujeros negros, esas regiones del espacio-tiempo del Universo que surgen por una gran concentración de masa en su interior. Uno de los paladines de esta búsqueda es Kip Thorne, catedrático de la Universidad de Caltech (EEUU) que ha dedicado su vida a la 'caza' de las ondas gravitatorias que se producen cuando dos de esos agujeros negros colisionan entre sí.

Thorne, que visita España

invitado por la Fundación BBVA para ofrecer una conferencia sobre 'El

Universo Curvo', está convencido de que los próximos interferómetros,

unos sofisticados instrumentos científicos que recogerán datos a partir

de 2013, serán capaces de detectar estas ondas y que incluso se podrá

hacer 'un diccionario' de formas de estas ondas que digan si han chocado

dos agujeros del mismo tamaño, si eran de distinto tamaño o si uno se ha

tragado una estrella.

Thorne, en una conferencia de prensa, explicó como el espacio/tiempo se

creó en el Bing Bang, la explosión que originó el Universo, con

distorsiones, una especie de 'arrugas' o vibraciones en el tejido

cósmico del espacio-tiempo. En este tejido están las estrellas, los

planetas, los cometas... y los agujeros negros, que funcionan como

grandes tornados, capaces de tragarse estrellas masivas.

Estos agujeros tienen en sus bordes grandes turbulencias en espiral

(vórtices, como los tornados) en las que los objetos cósmicos entran

girando a la velocidad de la luz y en ambas direcciones. Nada de lo que

entra puede salir.

Al colisionar dos agujeros negros, Thorne explicó que hay hasta seis de

estos vórtices en acción. "Es algo que acabamos de descubrir: durante

días y días, se mantienen los dos vórtices de cada agujero negro y otros

dos de la fusión y emiten ondas gravitatorias. Si logramos detectarlas,

sabremos exactamente lo que ocurrió", señala Thorne.

Kip thorne, en la sede de la Fundación BBVA. | Fundación

BBVA

Precisamente este es el objetivo principal del investigador, colega y amigo de Stephen Hawking, con quien suele hacer apuestas científicas. Este mismo pasado fin de semana, ambos han estado preparando un proyecto del que Thorne no ha querido adelantar nada en Madrid.

De lo que sí ha hablado es de cómo se captarán las escurridizas ondas gravitacionales. Hay que recordar que, hasta ahora, los astrónomos trabajan observando ópticamente y captando las ondas electromagnéticas que viajan por el espacio con los radiotelescopios. Es la forma de saber lo que hay más allá del alcance de las lentes y lo que ha permitido llegar a captar la luz del Universo cuando sólo tenía 400.000 años de existencia.

Más allá, la densidad es tal que las ondas electromagnéticas no la han podido atravesar para llegar hasta nosotros.

Por ello, como recordaba Thorne, para llegar más allá, es necesario conocer las ondas gravitacionales, que existen según las teorías de la física general de Einstein.

El primer paso fue el programa LIGO, en los años 80, un sistema de interferómetros situados en varios países con los que no se logró detectar ninguna de estas ondas. Pero, según Thorne, es algo que estaba ya previsto que ocurriera. "Para los astrónomos es duro construir intrumentos que no sirven para nada, pero para los físicos es el camino a seguir", puntualiza.

"El presidente Bush congeló el presupuesto, pero dede 2009 tenemos interferómetros mejorados que comenzarán a funcionar en 2013. Con ellos queremos ver muchos agujeros negros, siguiendo el movimiento con espejos que pesan 40 kilos cada uno y con una precisión de física cuántica", afirma el famoso astrofísico. Se trataría de llegar a ver objetos de tamaño de un cuerpo humano que se comporten como indica la física cuántica".

Se refiere al programa LISA. De hecho, reconocía que a veces se introducen ondas falsas en los interferómetros para ver si los investigadores son capaces de detectar algo que mide a una precisión de uno sobre 1.000 del núcleo de un átomo. "Si finalmente no vemos nada puede ser que algo esté mal en el umbral de detección o que algo está mal en las leyes de Einstein, o que e Universo es distinto de como pensamos", afirma Thorne.

Como metáfora, puso un ejemplo musical: "Es como si escuchamos una orquesta en pleno, pero queremos fijarnos solo en el violín. Al principio no se escucha, pero llega un momento en el que se distingue".

En paralelo a este trabajo, Kip Thorne prepara un guión cinematográfico con Steven Spilberg. Algunas fuentes aseguran que el científico incluso podría actuar en el film, pero no lo ha confirmado.

Fuente:

elmundo.es, 21-3-11

![]()

¿Puede España prescindir de la energía nuclear, que hoy representa alrededor del 20% de la electricidad que consumimos? Para los ecologistas, la respuesta siempre ha sido sí. Y mañana mismo. Su argumento: en España hay exceso de potencia: 100.000 megavatios, el doble de lo que se ha requerido nunca.

Estas cuentas, sin embargo, topan siempre con una reserva muy importante: esta potencia es más teórica que real, sobre todo porque las renovables dependen, para estar operativas, de factores externos incontrolables, como el viento o el sol. Para garantizar el suministro constante, en la base del sistema siempre tiene que haber una fuente también constante. Y en esto, la energía nuclear es difícil de superar: las centrales necesitan precisamente operar sin paros.

En los últimos años, sin embargo, las principales

organizaciones ecologistas como Greenpeace, en 2007, y Ecologistas en

Acción, el pasado enero han elaborado extensos documentos con propuestas muy

pegadas a la realidad y con todas las fases necesarias para llegar a

prescindir de la energía nuclear.

El de Greenpeace pone el acento en tener el 100% de renovables en 2050. Y el

de Ecologistas en Acción supone un plan de transición para que en 2020 la

generación eléctrica sea mucho más sostenible y ya sin un solo MW nuclear.

Este documento tiene tanto los pies en el suelo para los picos de demanda,

prevé recurrir al gas que sus redactores se ven obligados a precisar:

"Temporalmente se asumen proyectos energéticos ya realizados contra los que

hemos luchado. No hemos cambiado de valoración sobre estos proyectos, sigue

siendo parte de un modelo insostenible que debe desaparecer".

Estas propuestas han situado el terreno en un punto similar al que también han llegado, con el mismo nivel de detalle y pragmatismo, organizaciones de izquierdas como ICV, que tiene un documento sobre cómo abordar la transición hacia un futuro sin nucleares, IU o la Fundación Ideas, del PSOE, que en 2009 lanzó Un nuevo modelo energético para España, en el que propone, como Greenpeace, el 100% de renovables en 2050.

El horizonte es tan lejano porque el mayor problema sigue siendo cómo llenar este tronco central por constante, que no dependa de vaivenes incontrolables sin sustituir la energía nuclear por fuentes que dispararían la emisión de CO2. Para 2050, los entusiastas de las renovables están convencidos de que la tecnología habrá avanzado tanto que ya será posible el almacenamiento, lo que le permitiría ocupar también el tronco central. La paradoja es que la esperanza tecnológica les une a los pronucleares, que también esperan tener resuelto entonces el problema de los residuos.

Fuente:

publico.es, 20-3-11

![]()

-La sonda Messenger llega a Mercurio

Por fin. Después de seis años y medio de viaje, la nave Messenger de la NASA se convirtió ayer en el primer satélite que se sitúa en órbita alrededor de Mercurio, el planeta más próximo al Sol y el más inexplorado del sistema solar interior.

En la maniobra más comprometida de toda la misión, la nave encendió su motor principal a las 2.54 de la madrugada (hora española) y, durante quince minutos críticos, redujo su velocidad en 3.000 kilómetros por hora para ser capturada por la débil gravedad de Mercurio. A las 3.09, la Messenger estaba a salvo en una órbita que la acerca a 200 kilómetros de la superficie de Mercurio en el punto de máxima aproximación y la aleja a 15.000 kilómetros en el de máxima lejanía.

|

Esta órbita, más parecida a un huevo que a un aro, es la que los responsables de la misión han elegido para estudiar el planeta durante los próximos doce meses, tiempo que corresponde a cuatro años en Mercurio (porque allí el año dura tres meses terrestres) pero solo a seis días (porque el día dura dos meses). “Ahora es cuando empieza la misión de verdad”, declaró a Space. com Sean Solomon, investigador principal del proyecto, tras confirmarse que la nave había llegado bien a destino. “Estamos preparados para aprender sobre uno de nuestros vecinos más próximos”. Los ocho instrumentos científicos que la nave lleva a bordo escrutarán la atmósfera, la superficie y el subsuelo de Mercurio para tratar de resolver los muchos enigmas del planeta. Los astrónomos esperan que los datos que envíe la Messenger ayudarán a comprender mejor la historia de los pequeños planetas rocosos como la Tierra. Mercurio era una asignatura pendiente desde que se iniciaron las misiones de exploración espacial en los años 60. Se trata de un astro extremo, donde las temperaturas diurnas ascienden a 450 grados pero las nocturnas caen a 180 bajo cero por la falta de una atmósfera densa. Con su superficie salpicada de cráteres, a primera vista se parece más a la Luna que a la Tierra. Y al igual que en la Luna, también por la falta de atmósfera densa, el cielo es negro incluso de día. |

Sonda Messenger |

Sin embargo, de los cinco planetas conocidos desde la antigüedad –los que se pueden observar sin telescopio–, es el único que aún no había sido visitado por una nave en una misión de larga duración. En parte porque no es tan parecido a la Tierra como Venus y Marte. Ni es tan espectacular como los gigantes gaseosos Júpiter y Saturno. Pero sobre todo porque es más inaccesible que cualquiera de ellos.

En su máxima aproximación a la Tierra, Mercurio se acerca a unos 90 millones de kilómetros, una distancia corta para una misión espacial. Para ir a Marte, que se acerca a 80 millones de kilómetros, bastan seis meses. Pero Mercurio es más pequeño y está en dirección al Sol. Lo cual ha obligado a la Messenger ha realizar múltiples cambios de trayectoria y maniobras de frenado durante el viaje para dejarse atrapar por el campo gravitatorio de Mercurio. “Hemos sobrevolado planetas en seis ocasiones, hemos realizado cinco maniobras principales de propulsión y otras dieciséis maniobras de corrección de trayectoria”, ha declarado Eric Finnegan, ingeniero de la misión, en un comunicado difundido por la NASA.

Tras ser lanzada desde Cabo Cañaveral en el 2004, la nave sobrevoló una vez la Tierra, donde aprovechó el campo gravitatorio terrestre para cambiar de rumbo y dirigirse hacia el interior del sistema solar; después dos veces Venus, para nuevos cambios de dirección; y, desde el 2008, tres veces Mercurio. Con tantos rodeos, Messenger ha recorrido hasta la fecha 7.900 millones de kilómetros y ha dado quince vueltas alrededor del Sol.

Los tres fugaces encuentros con Mercurio ya han empezado a completar la visión que los astrónomos tienen del planeta. Hasta ahora, la única nave que había visitado Mercurio era la Mariner 10 de la NASA, que en 1974 y 1975 lo sobrevoló tres veces y solo consiguió fotografiar el 45% de su superficie. La Messenger, en cambio, ya ha cartografiado el 91% de la superficie del planeta. Y si las cámaras de la Viking 10 no distinguían estructuras menores de un kilómetro, las de la Messenger ofrecen una resolución media de 250 metros por píxel (es decir, una resolución 16 veces mayor que con la Viking 10).

Más allá de las imágenes en alta resolución, algunos de los datos que la Messenger ya ha transmitido de Mercurio han sorprendido a los astrónomos. El descubrimiento más inesperado es que, durante la mayor parte de la historia del planeta, ha habido actividad volcánica que ha remodelado su superficie. También se ha descubierto que su superficie tiene una composición mineral distinta a la Luna, aunque harán falta más observaciones para precisar qué minerales hay en Mercurio. Y se ha podido analizar el campo magnético del planeta –una característica que lo equipara a la Tierra, pero que lo diferencia de Venus y Marte, que no tienen campo magnético–.

En las próximas dos semanas, los responsables de la misión comprobarán que los instrumentos de la nave han sobrevivido al viaje espacial y funcionan correctamente. La NASA prevé difundir las primeras imágenes de Mercurio tomadas por la Messenger tras situarse en órbita antes de quince días. Y la cosecha de datos científicos debe iniciarse formalmente el 4 de abril.

La nave dispondrá de doce meses, en los que describirá 730 órbitas alrededor de Mercurio, para descifrar los secretos del planeta. Dedicará dieciséis horas al día a captar datos y ocho horas, a transmitirlos a la Tierra a un ritmo de 15 megabytes diarios. Al final de este primer año de trabajo, si ha sobrevivido a la intensa radiación solar de la órbita de Mercurio y se encuentra en buen estado, la NASA mantiene abierta la posibilidad de prorrogar la misión un segundo año. Después, una vez terminada la misión, la nave seguirá orbitando durante años alrededor de Mercurio hasta que un día se estrelle contra la superficie del planeta.

Fuente: 19-3-11, lavanguardia.com

![]()

-Una superluna podrá verse este sábado

Mañana por la noche es una fecha señalada para los aficionados a la astronomía. El 19 de marzo, se verá desde la Tierra una luna llena de tamaño poco habitual. Se producirá un singular fenómeno denominado 'Superluna', una luna que alcanza el "perigeo lunar" y se observa con un tamaño un 14% mayor.

|

Una espectacular luna vista desde Ibi, Alicante. GONZALO CAO

|

El fenómeno es poco común. "La última luna llena en perigeo y tan cerca de la Tierra se produjo en marzo de 1983", señala Geoff Chester del Observatorio Naval de EEUU en Washington. La observación de la Luna llena parece variar de tamaño en diferentes momentos debido a la forma ovalada de la órbita lunar. Se trata de una elipse con una cara (perigeo) que se acerca unos 50.000 km más a la Tierra que la otra (apogeo). Las vistas de las lunas en perigeo desde la Tierra aumentan entre un 14% y un 30%, y se ven más brillante y con más detalles de su superficie que las lunas en apogeo. "La luna llena del 19 de marzo es una coincidencia que solo ocurre cada 18 años, aproximadamente", añade Chester. Estas Superlunas traen consigo mareas más altas, pero que no revierten ningún peligro. La gravedad lunar en el perigeo atrae las aguas marinas sólo unos pocos centímetros más de lo habitual. La geografía particular de cada lugar puede amplificar este efecto hasta unos 15 centímetros. El mejor momento para observar la luna es cuando está cerca del horizonte. Es entonces cuando la ilusión se mezcla con la realidad para producir una vista realmente espectacular, explican los expertos. Este efecto, además, produce la sensación de una "ilusión lunar", cuando se observa la luna a través de árboles, edificios y otros objetos en primer plano. Da la sensación de que la Superluna "es de mentira". |

Fuente: publico.es, 18-3-11

![]()

Hasta cuatro veces han vertido agua sobre el reactor número 3, el único con plutonio, en un intento por enfriar las barras de combustible de su núcleo tras detectar graves daños en su estructura de contención. Sin embargo, parece que ha sido en vano ya que los altos niveles de radiación registrados en torno a estos dos reactores no han descendido.

Según la compañía TEPCO, la radiactividad se encuentra en los 300 milisievert a la hora. Una persona puede soportar sin que se produzcan daños en la salud hasta 100 milisievert en un año.

|

El humo sigue saliendo este jueves del destrozado edificio del reactor 3. | AP |

El miedo, por tanto, continúa. Se teme que un aumento de la temperatura, en torno a los 40º centígrados, y la escasez de agua en las piscinas de los reactores fundan las barras de combustible y liberen materiales radiactivos de alta intensidad.Además, un camión cisterna provisto de un cañón de agua está también preparado para repetir la operación en el caso de que no se logre enfriar los reactores, aunque por el momento es inviable debido a los altos niveles de radiación. Asimismo, TEPCO tiene previsto colocar una fuente temporal de energía eléctrica para intentar volver a bombear agua a los reactores. De momento, este procedimiento se está retrasando. El objetivo de los técnicos es restablecer los circuitos de enfriamiento de los bloques 1 y 2. Los reactores 3 y 4 han centrado la preocupación de los expertos que trabajan en la zona, por la temperatura que está alcanzando el combustible nuclear gastado en las piscinas de estas unidades. Las explosiones e incendios en ambos reactores han dejado sin agua la piscina de la unidad número 4, mientras que la unidad 3 presenta daños similares a los que el martes se confirmaron en la estructura de contención del reactor 2. |

"Creemos que la muralla secundaria de confinamiento ha sido destruida [en el reactor 4], que no hay más agua en las piscinas con los combustibles gastados y que los niveles de radiación son extremadamente elevados", advirtió este miércoles el director de la Comisión Regulatoria Nuclear estadounidense (NRC), Gregory Jaczko, hablando de unos daños en este reactor mucho mayores de los reconocidos hasta ahora las autoridades niponas. Sin embargo, este jueves tanto portavoces de TEPCO y NISA (la agencia nuclear nipona) han desmentido que haya habido una pérdida total de agua de refrigeración en la piscina. Según la agencia francesa de seguridad nuclear (IRSN), es imposible saber con certeza el estado real de la piscina, pues no hay medios para inspeccionarla directamente.

Además, el Gobierno japonés ha informado de que posiblemente hoy militares de EEUU operen un avión no tripulado Global Hawk de reconocimiento a gran altura, para tomar imágenes del interior del edificio que alberga el reactor 4 y ver sus daños.

Varios minutos antes de que los helicópteros comenzaran a operar sobre la central nuclear de Fukushima, las autoridades japonesas han aumentado en unas 28.000 personas el número de evacuados desde el miércoles en las localidades cercanas a la central para evitar ser expuestos a la radiación, según ha informado la televisión NHK.

Casi todos los nuevos desplazados están siendo reubicados en refugios de la provincia de Fukushima, aunque otros podrían ser alojados en provincias cercanas como Niigata y Tochigi, ante la avalancha de personas sin hogar.

Las autoridades de Fukushima están enviando centenares de personas a hoteles y refugios provisionales de provincias vecinas, mientras que algunas personas se quejan de que la situación está comenzando a desbordarse.

El Gobierno de Japón descarta por el momento ampliar el área de evacuación más allá de los 20 kilómetros. El ministro portavoz Yukio Edano, señaló también que "entiende" la recomendación de EEUU de que sus ciudadanos se alejen de la central en un radio de 80 kilómetros, aunque insistió en que no creen que de momento sea necesario ampliar el perímetro.

Desde que el pasado viernes Japón se vio sacudido por un

terremoto y posterior tsunami, las explosiones e incendios se han sucedido en la central de Fukushima Daiichi. Al día siguiente del seísmo, se produjo la primera explosión en la planta, en su reactor número 1 (el primero que mostró problemas de calentamiento y elevada presión), que aparentemente sólo produjo daños en el edificio.La madrugada del domingo al lunes, fue el reactor número 3 el que registró una explosión de hidrógeno. Hace dos noches, el reactor número 2 sufrió una nueva explosión (a las 6.10 del martes en Japón, 22.10 horas del lunes en la Península). Unos minutos después, registraba una explosión en el número 4 y, tres horas después, se declaraba un incendio en este edificio. En la noche del martes al miércoles, fueron de nuevo los reactores 3 y 4 los que mostraron problemas.

En el caso de los reactores 2 y 3, los daños parecen especialmente importantes. Según reconocieron este martes las autoridades niponas al OIEA, la estructura primaria de contención (una estructura de acero y hormigón preparada para frenar una posible fuga radiactiva) del 2 se vio dañada y es posible que también haya daños en la vasija del reactor. La unidad 3 parece sufrir daños similares.

Hoy es el día clave de la central de Fukushima. O TEPCO logra controlar los reactores más dañados, los 3 y 4, o la situación será de extrema gravedad. Así lo ha asegurado un portavoz de Tokyo Electric Pover (TEPCO) al afirmar que el reactor número 3 tiene que enfriarse "hoy mismo".

El nivel de radiación en la

central nuclear de Fukushima no se ha conseguido controlar, pese a las tareas de refrigeración que se llevan a cabo con helicópteros de las Fuerzas Aéreas que han vertido agua de mar sobre los reactores 3 y 4, los más peligrosos actualmente. Una operación que según la cadena NHK ha fracasado por el momento.La gravedad de la situación en el reactor 3 se debe a que éste es el único de los seis que se abastece de un combustible especial procedente del uranio ya gastado y que contiene plutonio, por lo que los gases radiactivos son más peligrosos.

Fuente:

elmundo.es, 18-3-11

![]()

-Una terapia génica es eficaz para el Parkinson

La inserción de un gen en el cerebro de afectados por una forma avanzada de párkinson es segura y mejora sus síntomas motores.

|

Estimulación cerebral profunda en un paciente de párkinson. |

Un estudio publicado hoy en The Lancet Neurology confirma así lo que ya se sospechaba por otros trabajos, que la terapia génica puede dar mucho que hablar en la lucha contra las enfermedades neurodegenerativas. Sin embargo, este ensayo clínico tiene algo que lo hace destacar por encima de otros: es el primero doble ciego en el que se ha comparado la eficacia del procedimiento con una operación quirúrgica placebo. Es esta característica lo que motiva el título del editorial que acompaña al artículo: Por fin, ¿una terapia génica para el párkinson? En él, el investigador de la Facultad de Medicina de la Universidad de Nueva York Michael Hutchinson afirma que la "diferencia significativa entre los dos grupos de tratamiento es un tributo al cuidadoso diseño" del trabajo y subraya "la excepcional importancia de la exigencia en los ensayos clínicos quirúrgicos pequeños". Los autores del trabajo evaluaron a 37 pacientes de párkinson avanzado, que mostraban resistencia a la levodopa, el fármaco que mejor funciona para el control de las deficiencias motoras que provoca la enfermedad. Antes de someterles a la intervención21 a un procedimiento inocuo y 16 a la terapia, se calculó su Escala Unificada de Medición de la Enfermedad de Párkinson (UPDRS). Para participar en el ensayo, tenían que superar la puntuación de 25. Seis meses después de su paso por el quirófano, se les volvió a aplicar la escala. Los receptores de la terapia tuvieron una mejora del 23,1% en su UPDRS, frente al 12,7% de aumento del grupo placebo. |

El autor principal del estudio, el científico del Instituto Feinstein para la Investigación Médica Andrew Feigin, señaló por correo electrónico que existen otras terapias génicas investigadas para el párkinson. La diferencia con la actual es que sus ensayos no son doble ciego, la clave de la medicina basada en la evidencia.

El gen inyectado en el núcleo subtalámico del cerebro de los pacientes es el de la enzima ácido-glutámico-descarboxilasa (GAD), que incrementa la producción de GABA, un neurotransmisor que regula el movimiento. Para realizar la transferencia genética, los autores del estudio utilizaron como vector un virus adenoasociado inactivo, el AAV2, que ya se había mostrado eficaz en ensayos sin grupo control.

Feigin comentó que el ensayo se hizo en pacientes avanzados porque se trata de un procedimiento quirúrgico, por lo que considera que su uso "sólo se justifica en personas con la dolencia relativamente avanzada". El autor no sabe todavía si se llevará a cabo un ensayo en fase III, lo que "depende del patrocinador", la biotecnológica Neurologix.

Según el editorial, es importante investigar más para saber cuánto duran los efectos y, sobre todo, si la terapia génica es superior a la estimulación cerebral profunda, un procedimiento quirúrgico que se utiliza hoy en pacientes resistentes a levodopa.

Fuente: publico.es, 17-3-11

![]()

-Las palabras clave para entender el desastre nuclear

Reactor nuclear: Instalación en la que puede iniciarse, mantenerse y controlarse una reacción nuclear en cadena. El reactor (nuclear) de agua a presión es un reactor refrigerado con agua natural a una presión superior a la de saturación, a fin de impedir su ebullición. El reactor de agua en ebullición (como los de la central de Fukushima) es un reactor refrigerado con agua natural, la cual se deja que hierva en el núcleo en una cantidad considerable.

BWR o Reactor de agua en ebullición: El calor generado por las reacciones en cadena se usa para hervir el agua. De este tipo son los reactores de la planta japonesa de Fukushima o los de Garoña, en Burgos. Ambas plantas usan el mismo reactore de tecnología BWR (Boiling Water Reactor) fabricado por General Electric. La compañía americana les vendió el mismo modelo a japoneses y españoles a comienzos de los 70. El reactor 1 de Fukushima y el único que hay en Garoña son idénticos y se inauguraron en 1971.

Barra de combustible: Combustible nuclear dispuesto en forma de barra formado por pastillas contenidas en una vaina tubular metálica. En las centrales nucleares puede usarse Uranio y Plutonio, pero este segundo también es utilizado en la fabricación de armas nucleares. En Fukushima hay cinco reactores que funcionan con uranio y uno de ellos -el reactor tres- que contiene una mezcla llamada MOX que contiene plutonio y uranio.

Vasija: Recipiente en el que se encuentra el núcleo de un reactor nuclear. En él están las vainas de combustible (cubierta metálica que contiene herméticamente el combustible), el reflector (material situado alrededor del núcleo que es el encargdo de devolver los neutrones que de otro modo escaparían), el refrigerante (agua radiactiva) y otros componentes.

Contención: Estructura utilizada para albergar en su interior instalaciones nucleares o radiactivas para disminuir la posibilidad de contaminación del medio ambiente. En centrales nucleares, la contención está formada por una chapa de acero de revestimento y un recubrimiento de hormigón de 90 centímetros de espesor y contiene en su interior el reactor y el circuito primario.

Sievert (Sv): Unidad de la dosis equivalente y de la dosis efectiva en el Sistema Internacional de Unidades. Es decir, mide la dosis de radiación absorbida por la materia viva. Un Sv equivale a un julio de energía por cada kilogramo de peso. La unidad antigua es el REM, usada, por ejemplo, en la antigua Unión Soviética. Fue la unidad de referencia durante el accidente de Chernóbil. 1Sv equivale a 100 REM. Hay ocasiones en las que se hace referencia a bequerelios, pero las unidades no son comparables porque el bequerelio es una unidad de radiactividad, no de dosis equivalente.

Radiactividad: Propiedad de algunos elementos químicos de emitir partículas u ondas electromagnéticas. Esta propiedad se debe a la existencia de una descompensación entre el número de neutrones y de protones del núcleo del átomo, que provoca una inestabilidad y una liberación de la energía acumulada en forma de partículas u ondas. La radiactividad natural se debe a elementos que emiten radiaciones espontáneamente, como es el caso del uranio, el torio o el radón, por ejemplo.

Núcleo del reactor: Región de un reactor nuclear en la que se encuentra el combustible y donde se produce la reacción nuclear de fisión y la liberación de calor.

Fusión nuclear: Reacción entre núcleos de átomos ligeros que conduce a la formación de un núcleo más pesado que los iniciales, acompañada de la emisión de partículas elementales y de energía.

Fisión nuclear: Reacción nuclear en la que tiene lugar la ruptura de un núcleo pesado, generalmente en dos fragmentos cuyo tamaño son del mismo orden de magnitud, y en la cual se emiten neutrones y se libera gran cantidad de energía.

Fusión del núcleo: Es un daño grave del núcleo del reactor debido a un sobrecalentamiento. Se produce cuando un fallo grave del sistema de la central impide la adecuada refrigeración del núcleo del reactor. Cuando eso sucede, las vainas de combustible se calientan hasta llegar a derretirse. Supone un gran peligro debido a que existe el riesgo de que el material radiactivo (el combustible nuclear) sea emitido a la atmósfera. No se debe confundir con fusión nuclear (ver más arriba).

Isótopo: Cada una de las distintas formas de los átomos de un elemento químico. Todos los isótopos de un elemento tienen el mismo número atómico (número de protones) y, por tanto, pertenecen al mismo elemento químico, pero difieren entre sí en el número de neutrones.

Partículas alfa: Son emitidas por los radionucleidos naturales no son capaces de atravesar una hoja de papel o la piel humana y se frenan en unos pocos centímetros de aire. Sin embargo, si un emisor alfa es inhalado, ingerido o entra en el organismo a través de una herida puede ser muy nocivo.

Partículas beta: Son electrones que salen despedidos en los procesos radiactivos. Los de energías más bajas son detenidos por la piel, pero la mayoría de los presentes en la radiación natural pueden atravesarla. Al igual que los emisores alfa, si un emisor beta entra en el organismo puede producir graves daños.

Rayos gamma: Radiación electromagnética producida en el fenómeno de desintegración radiactiva. Su longitud de onda es menor que la de los rayos X, por lo que es una radiación extraordinariamente penetrante. La radiación gamma suele acompañar a la beta y a veces a la alfa. Los rayos gamma atraviesan fácilmente la piel y otras sustancias orgánicas, por lo que puede causar graves daños en órganos internos.

Fuente: elmundo.es, 16-3-11

![]()

-Los neandertales trajeron a Europa el fuego

Si, hace 40.000 años, un Homo sapiens le hubiese pedido fuego a un neandertal, este hubiera sabido ayudarle sin problemas. La especie extinta llevaba más de 300.000 años usando las llamas de forma regular para hacer mejores herramientas y abrigarse del frío europeo.

|

El dominio del fuego en Europa ya lo habían demostrado varios antiguos asentamientos en Reino Unido y Alemania y ahora lo confirma la revisión más completa de los datos existentes en 141 yacimientos del continente. El trabajo, publicado en PNAS, apunta que la aparición de hogueras en Europa, hace hasta 400.000 años, coincide con la aparición del linaje neandertal, a quien los autores atribuyen el dominio del fuego en el continente. Los resultados también implican que los ancestros de esta especie que habitaron Europa hace más de un millón de años y entre los que se encuentra el hombre de Atapuerca, colonizaron el continente sin saber hacer fuego. "La fabricación de herramientas de piedra y el control del fuego son los dos momentos más importantes de la evolución de los primeros humanos", señala el trabajo, firmado por Paola Villa, de la Universidad de Colorado (EEUU) y Wil Roebroeks, de la Universidad de Leiden (Países Bajos). Sin embargo, la importancia del momento no está acompañada de datos concluyentes que permitan detallar cómo sucedió aquel dominio. Villa y Roebroeks han recopilado información de 141 yacimientos europeos, 16 de ellos en España, que datan de entre hace 1,2 millones de años y 35.000 años. La primera fecha corresponde a los restos de los Homo antecessor que vivieron en la sierra de Atapuerca (en Burgos), una población a la que se considera como los primeros europeos. El segundo está muy cercano a la fecha en la que se extinguieron los neandertales, por razones aún desconocidas. Atapuerca y OrceLos dos autores han repasado los restos de hogueras (carbón, piedras o huesos quemados, herramientas fabricadas al fuego, sedimentos que fueron calentados a altas temperaturas...) en cada uno de los yacimientos y han determinado en cuáles se dan pruebas "sólidas" de intervención humana. "Se trata del trabajo más completo de este tipo hecho hasta la fecha, no existe una base de datos igual", señala Villa. |

Excavaciones en la Gran Dolina de Atapuerca.EFE

|