|

Inicio |

|

|

|

|

NOTICIAS

CIENTÍFICAS

Mayo 2011

TITULARES DE LAS NOTICIAS DEL MES

Tecnología para lograr unas carreteras silenciosas

Catorce muertos en Alemania por una bacteria que sacude a la

agricultura europea

El plástico del futuro serán las frutas

Que no te vendan gato por liebre en la pescadería

Algunas partes de la Luna contienen tanta agua como la Tierra

La edad del petróleo se acaba

El Spirit dice adiós a Marte

Google abandona la digitalizacón de los diarios

Los satélites hayan 17 nuevas pirámides

Chorros de partículas a partir de un agujero

negro

Los efectos del paro en la pobreza

El universo nació de rebote

El terremoto de Japón elevó tres metros el fondo del mar

El espacio está lleno de planetas rebeldes

Einstein no se equivocó

8 horas de internet al día

Primer mapa de las arrugas de la Luna

Malas noticias para un fármaco estrella contra el cáncer

Muere un operario en Fukushima por causas desconocidas

Cometas y meteoritos originaron la atmósfera de la Tierra y Titán

La dieta que alarga la vida de los gusanos

Fuertes vientos barren el polvo interestelar de la galaxia

Descubrir fármacos, una actividad arriesgada

Un nuevo sensor detecta la presencia de

proteínas infecciosas en la sangre

Merkel confirma el final de la era atómica

Las especies del mar profundo colonizan las costas de la Antártida

Una nueva central nuclear en Japón en cuarentena

Un gen provoca un nuevo tipo de "vejez" precoz

Un cráneo revela al "abuelo" de sapiens y

neandertales

La supernova que engalanó el nacimiento de un rey

Río Tinto, el Marte español

Hacia la detección precoz del alzhéimer

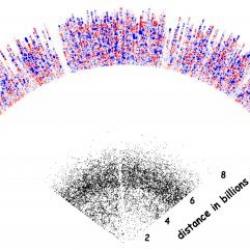

Mapa 3D del universo remoto

La NASA pospone de nuevo el lanzamiento del "Endeavour"

Archivo

-Tecnología para lograr unas carreteras

silenciosas

El centro español investiga en una

novedosa tecnología destinada a atenuar el ruido de las ciudades. Bajo el

paraguas del proyecto Pass By, Cidaut trabaja con nuevos materiales con el fin

de fabricar pavimentos de las aceras, carreteras o vías del ferrocarril que

reduzcan hasta casi desaparecer las vibraciones, el ruido y la contaminación. Lo

singular de estos materiales es que consiguen mantener la seguridad en el

asfalto y conservan la eficiencia energética. De modo que un coche no tiene por

qué gastar más combustible o realizar mayor esfuerzo por circular sobre un

asfalto de estas características 'silenciosas'.

Por ejemplo, para aislar una carretera

se tiende a que sea menos rígida, y tenga menor ruido pero, por el contrario,

supone mayor gasto de gasolina para el vehículo porque el esfuerzo es más

grande. El material insonorizante con el que Cidaut trabaja logra filtrar la

energía que genera el vehículo al pasar, y evitar que llegue en forma de ruido a

construcciones cercanas. Para lograrlo, hay que moldear el material aislante

para cada situación concreta. Además, el centro emplea materiales reciclados de

desechos de neumáticos y también de productos plásticos. Los neumáticos cuentan

con características muy buenas para reducir la rigidez de la carretera y se

adecúan muy bien al coche que circula por ella. Cidaut desarrolla estos nuevos

materiales buscando el equilibrio entre todos los componentes, reduciendo ruidos

y vibraciones tanto de carreteras como de las vías del tren. Este planteamiento

de tener en cuenta todas las variables como la seguridad y la utilización de la

energía, es pionero, según sus responsables.

Fuente: portalpie.com, 31-5-11

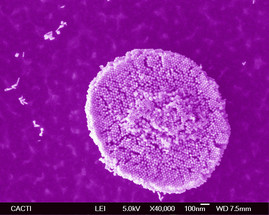

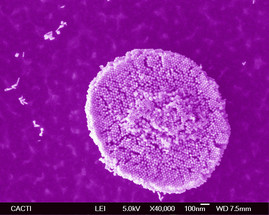

-Catorce muertos en Alemania por una bacteria que sacude a

la agricultura europea

Catorce

personas han muerto por el brote infeccioso en Alemania

atribuido en principio a una partida de pepinos españoles, ante lo que España

anunció hoy que pedirá ayudas a la UE para paliar las pérdidas y estudia

solicitar indemnizaciones por lo que considera acusaciones "sin fundamento".

El brote infeccioso se debe a una variante de la bacteria

intestinal E. coli Enterohemorrágica, debido a la cual hoy se

produjeron cuatro nuevas muertes en Alemania, que se suman a los diez

fallecimientos registrados la semana pasada.

|

Asciende a once el número de muertos en Alemania por la

la bacteria intestinal.REUTERS/Herwig

Prammer

|

|

En concreto, las muertes se deben al síndrome

urémico hemolítico (SUH) que provoca este germen patógeno y que

causa insuficiencia renal, anemia hemolítica microangiopática,

trombocitopenia, defectos de coagulación y signos neurológicos variables.

Los casos de infección por la bacteria intestinal asciende a 1.200 y los

afectados por el SUH son ya 352, según el Instituto Robert Koch de Berlín.

El foco continúa activo, según Bahr

El ministro alemán de Sanidad, Daniel Bahr, alertó de

que el foco infeccioso continúa activo y "lamentablemente hay que contar

con un creciente número de casos". Ante lo que considera acusaciones

"precipitadas y sin fundamento" por la bacteria intestinal, España se

plantea solicitar a la Unión Europea (UE) "algún tipo de indemnización".

El secretario de Estado español para la UE,

Diego López Garrido, dijo que es necesario esperar los resultados

de los análisis sobre el origen del brote antes de adoptar una medida de

este tipo y señaló que las empresas españolas afectadas podrían iniciar

"procedimientos de responsabilidad civil", aunque deberán ser ellas mismas

las que "tomen la iniciativa".

Insistió en que las medidas adoptadas en algunos países

para bloquear la importación de productos españoles "no están justificadas

en base al derecho europeo", ya que "no existen fundamentos

científicamente comprobados sobre que esas enfermedades, que se han

producido en Alemania, obedezcan a un producto español". |

Ayudas a la UE

Por otra parte, el Gobierno de España solicitará ayudas a

la UE para paliar las perdidas causadas a su sector hortofrutícola por el

brote infeccioso, después de que los productores españoles hayan estimado los

daños en 200 millones de euros semanales. La ministra española de Medio

Ambiente y Medio Rural y Marino, Rosa Aguilar, quien hoy analizó la situación

con representantes de organizaciones agrarias, subrayó que España "no

consentirá que se siga haciendo daño gratuitamente al sector" y pedirá a

Alemania aclaraciones sobre el transporte y la distribución de los pepinos

para conocer con certeza qué ha ocurrido.

Asimismo, la titular española de Sanidad, Leire

Pajín, afirmó que hasta la fecha "no hay ninguna prueba, ni

evidencia" de que en España se haya producido la contaminación de los pepinos.

Pese a ello, Rusia prohibió a partir de hoy las importaciones de verduras

procedentes de España y Alemania y afirmó que, si no hay cambios, esta medida

se extenderá a todas las verduras europeas.

Bélgica también prohíbe su importación

También Bélgica prohibió la importación de pepinos de las

dos explotaciones españolas sospechosas de haber distribuido la hortaliza

contaminada por la bacteria intestinal, mientras la República Checa ordenó la

retirada de dos remesas llegadas la semana pasada de Alemania, como hizo

Dinamarca en los últimos días con productos hortofrutícolas procedentes de

España.

En Austria se ha iniciado una operación para retirar de la

venta al público pepinos, tomates y berenjenas de las tiendas que adquirieron

productos de dos mayoristas de verduras alemanes que habían comprado a

empresas españolas.

En general, los países de la UE han reforzando la

vigilancia sobre los pepinos, tomates y otras verduras a la venta, a la espera

de tener más datos sobre el origen de la contaminación por "E.coli". No

obstante, un experto de la Comisión Europea no considera necesario un bloqueo

general de la importación de pepinos y otros productos agrícolas procedentes

de España.

Para el Ejecutivo comunitario, el bloqueo de los productos

cultivados en las dos explotaciones concretas que le comunicó el Ejecutivo

español es suficiente hasta que se disponga de datos fiables sobre el origen

de la infección. El foco infeccioso, según medios alemanes, fue detectado tras

realizar análisis, entre otras verduras, a cuatro pepinos escogidos

aleatoriamente del mercado central de Hamburgo, de los que tres procedían de

España -uno de ellos de cultivo biológico- y el otro de Holanda.

Fuente: publico.es, 30-5-11

-Que no te vendan gato por liebre en la pescadería

|

Un claro ejemplo del fraude en el sector

pesquero es cuando, a precio de ganga, se venden filetes de

bacalao o incluso de lenguado supuestamente procedentes del Báltico

cuando en realidad son simples filetes de pez gato del mar del Norte.

La Comisión Europea ha publicado este viernes un

informe en el que apostando por la tecnología molecular, ofrece

respuestas a muchas de las preguntas que se hacen los consumidores, que,

entre otras cosas, desean saber de qué especie proviene el

producto, dónde se pescó y, si es salvaje o de piscifactoría.

El

estudio, titulado 'Represión de las actividades

ilegales en el sector pesquero', elaborado por el Centro Común de

Investigación de la Comisión (JRC), apunta que esta vía de investigación

puede ayudar en la lucha contra las prácticas ilegales.

Además, el hallazgo permitirá trazar el origen de productos tan

complejos como puede serlo el pescado enlatado.

Origen del producto

Maria Damanaki, comisaria europea de Investigación,

Innovación y Ciencia declaró en Génova, ciudad elegida para presentar el

estudio, que "se calcula que la pesca ilegal representa 10.000

millones de euros al año en todo el mundo". Añadió que se trata

de una "actividad criminal" que afecta negativamente a cuatro sectores

clave: la economía mundial, los ecosistemas marinos, las comunidades

pesqueras y los consumidores. Insistió en que "si no se cumplen

las normas no habrá una pesca sostenible". |

|

Imagen de una pescadería sostenible del Mercado de San

Miguel. | Carlos Adillo

|

Etiquetar el pescado y los productos pesqueros con

nombres de especies falsas y asignándoles un falso lugar de procedencia son

dos de las técnicas de fraude más comunes. Por ejemplo, en

ocasiones, especies muy económicas como la perca dael Nilo se venden

disfrazadas de mero.

El informe apuesta por técnicas moleculares indicando que

las basados en la tecnología del ADN permiten identificar la especie

sin la necesidad de un experto. La novedad reside en que este

método también funciona en productos preparados. La idea es que las

autoridades europeas implementen estas técnicas.

Negocio de lucro

Según Maìire Geoghegan-Quinn, principal responsable del

JRC y comisaria europea de Investigación, Innovación y Ciencia, el informe

demuestra que usando la tecnología molecular de forma coordinada y

documentada, se podría reducir el fraude pesquero. Supondrá

una garantía para los consumidores que no sólo obtendrán aquello por lo que

han pagado sino que también sabrán exactamente qué están comiendo.

En 'Slow Fish 2011', la quinta reunión bianual dedicada

al mundo de los peces y el ecosistema marino, se han formulado propuestas

muy variadas. Una de ellas aboga por ofrecer más información. Para analizar

el pescado optan por facilitar el acceso de los laboratorios de países

miembro a los depósitos de información. Apuestan por crear una red de

laboratorios que funcionen bajo un protocolo común. Coincidieron en la

importancia de formar al personal.

Para mejorar la trazabilidad de los productos pesqueros y combatir la

pesca ilegal, la Comisión está invirtiendo para que se aplique la norma

conforme a la cuál todos los productos pesqueros han de venir acompañados de

un certificado de captura.

Fuente: elmundo.es, 29-5-11

-El plástico del futuro serán las frutas

Cuando dentro de cientos de años los arqueólogos descubran algún vestigio de

la sociedad de hoy, es probable que encuentren antes restos de basura que de

arte o arquitectura. Desde que, en 1909, el químico estadounidense de origen

belga Leo Hendrik Baekeland obtuvo el

primer polímero sintético, la baquelita, vivimos envueltos en un mundo que

depende del plástico, uno de los materiales más dañinos para el medio

ambiente. Una botella de agua o un vaso desechable pueden tardar entre cien y

mil años en ser asimilados de nuevo por la naturaleza.

|

En el planeta se producen más de 100 millones de

toneladas de plástico al año, de las que un 10% acaba en el mar. Un

altísimo coste natural, según Eben Bayer

y Gavin McIntyre, fundadores de Ecovative, una empresa neoyorquina

especializada en diseño ecológico. "Nosotros no fabricamos materiales, los

cultivamos", explica Bayer.

Su compañía ha creado un plástico natural y

biodegradable, el EcoCradle, a partir de las fibras de los hongos, los

micelios, mezcladas con desechos de plantas de procesamiento de algodón. "Queremos

sustituir el plástico en todos aquellos productos en los que no tiene

sentido su uso, desde ordenadores a televisores", afirman. "No

entendemos cómo se puede fabricar material a base de benceno, que dura

hasta 10.000 años, para usarlo en un embalaje y tirarlo. Es insostenible",

asegura Bayer, quien presume de haber diseñado el primer plástico "vivo".

Los clientes de esta empresa, fundada en 2007, tienen

que esperar dos semanas antes de que sus pedidos estén listos. "El

EcoCradle tiene un periodo de crecimiento de cinco días", confiesa

su creador. El plástico a base de hongos ideado por estos exalumnos del

Instituto Politécnico Rensselaer (EEUU) es altamente biodegradable y se

reintegra en el ecosistema en un plazo de entre tres meses y un año.

|

|

|

El pasado enero, Ecovative fue una de las compañías más

premiadas durante la celebración del Foro

Económico Mundial en Davos. Poco después, firmó un acuerdo con el

gigante de la informática Dell para convertir en sostenible el embalaje de sus

ordenadores. Además, hace sólo unos días, la compañía automovilística Ford

anunció que utilizará en sus vehículos el otro gran producto de Ecovative, el

Greensulate, un aislante de fibras de hongos que es más barato, ecológico y

ligero que las espumas tradicionales, además de ignífugo. Ford sustituirá más

de 15 kilos de material aislante de derivados del petróleo por esta solución

alternativa. Con apenas 30 años, Bayer y McIntyre pueden revolucionar un

sector que genera un volumen de negocio de más de 20.000 millones de dólares

al año.

La industria automovilística también podría sufrir un

cambio radical si un grupo de científicos brasileños con base en EEUU culmina

con éxito el desarrollo de fibras de nanocelulosa a partir de limones, piñas y

plátanos. Este compuesto frutal reciclable, similar al plástico y tan duro

como el Kevlar, podría usarse para diseñar piezas de vehículos.

Según el director del proyecto,

Alcides Leao, la nanocelulosa es hasta

un 30% más ligera que los laminados de plástico que actualmente se utilizan y

con apenas un kilo de compuesto se pueden obtener hasta 100 de fibras de

plástico ecológicas. "Estamos convencidos de que, en un futuro, la mayoría de

las piezas de los coches, entre ellas el salpicadero o los parachoques, se

fabricarán con fibras de fruta", señala Leao, que con su solución espera "reducir

el peso de los vehículos y mejorar el consumo de combustible".

Leao y Ecovative no son los únicos que están tratando de

buscar alternativas más sostenibles a los plásticos. YiqiYang, profesor de

Bioingeniería de la Universidad de Nebraska, se ha propuesto que los millones

de plumas de aves que acaban en la basura cada año se conviertan en los

sustitutos del petróleo. Las plumas, como las uñas o el pelo, están compuestas

principalmente por queratina, una proteína que, aplicada a la actual fórmula

de fabricación de plásticos, podría aumentar su fuerza y reducir su peso.

Según Yang, las plumas podrían alcanzar hasta

el 50% de la composición de los plásticos, con lo que se reduciría la

dependencia de derivados del crudo como el polietileno y el polipropileno.

Para Yang, "las plumas son actualmente un desecho, pero tienen grandes

propiedades que podrían convertirlas en una alternativa económica y sostenible

a los materiales sintéticos".

Fuente: publico.es, 29-5-11

-Algunas partes de la Luna contienen tanta agua como la Tierra

Hasta hace menos de cinco años, la comunidad científica

aceptaba que la Luna era una roca seca, quizá con la salvedad de algunos

cráteres sombreados en los polos que podrían albergar hielo procedente de

impactos de asteroides y cometas. En 2009, las observaciones confirmaron que

hay agua en la Luna, en una cantidad que después llegó a estimarse en 600

millones de toneladas. Hoy la cantidad se

corrige de nuevo al alza, hasta el punto de que ya no será tan fácil

cuantificarla.

|

|

|

Uno de los equipos que investigan el agua lunar no

utiliza sondas ni telescopios, sino muestras recogidas hace décadas por

las misiones Apolo de la NASA. Se trata de cristales procedentes

de las antiguas erupciones de los volcanes lunares. El grupo que dirige el

geoquímico argentino Alberto Saal en la Universidad Brown de EEUU ya

publicó en 2008 que los cristales analizados todavía retenían agua, aunque

habían perdido la mayor parte y era

difícil estimar el contenido original.

En el nuevo estudio, que hoy publica Science,

Saal y su equipo, en colaboración con otras instituciones de EEUU, han

analizado cristales que contienen inclusiones de magma aisladas del

exterior y que por tanto actúan como

cápsulas del tiempo, reteniendo intacto su contenido original.

Empleando herramientas de medición ultrasensibles, han descubierto que el

contenido de agua es cien veces mayor de lo que se creía, equiparándolo al

del manto externo terrestre.

Los científicos llegan a sugerir un replanteamiento de

la actual teoría sobre el origen de la Luna. Hasta hoy se asume que se

formó por una colisión catastrófica que evaporó todos los elementos

volátiles, incluyendo el agua. Los resultados muestran que no es así y que

al menos parte del agua acumulada en los polos probablemente no procede de

cometas, sino del propio magma lunar. |

Fuente: 27-5-11, publico.es

-La edad del petróleo se acaba

«La edad de piedra se acabó no porque se acabaran las

piedras y la del petróleo llega a su fin no porque se extinga el petróleo,

pero está claro que toca a su fin». Esa fue una de las conclusiones de las

jornadas que ayer se celebraron en la

Escuela de Energía y Cambio Climático Fundación Focus-Abengoa bajo

el epígrafe «¿Qué modelo energético para España?». José Domínguez Abascal,

secretario técnico de Abengoa y moderador del foro, abogó por reducir de

forma importante el consumo de este combustible fósil ya que España gasta

al año 140 millones de toneladas.

El objetivo es reducirlo de aquí al año 2020 con la

meta de sustituir el petróleo por energías renovables pero también la

principal meta es lograr que ese aumento de la energía renovable vaya

pareja a una disminución progresiva del consumo de energía. En ese

sentido, Domínguez Abascal dejó claro que el ahorro es una pieza

fundamental para ese cambio por el que todos los países y también España

deben luchar, pero también la idea es buscar energías alternativas, como

el sol. Y es que, para el secretario técnico de Abengoa, las termosolares

pueden ser parte de esa solución. Para demostrarlo apuntó un dato: en una

hora llega a la tierra más energía solar que la que consumimos en un año.

Y eso hay que aprovecharlo.

Sin embargo para reducir el consumo de petróleo sería necesario contar con

el apoyo de los fabricantes de transportes, según uno de los ponentes, Luis

Puch, profesor de la Universidad Complutense e investigador de FEDEA, que

admitió que España está todavía «muy lejos» de la reducción del gasto de

petróleo que ya han acometido otros países de la UE como Alemania

precisamente por la resistencia de los fabricantes de coches. |

|

|

Otra solución apuntada por Pedro Linares, profesor de la Escuela Técnica

Superior de Ingeniería ICAI de la Universidad Pontificia Comillas, e

investigador del Instituto de Investigación Tecnológica, pasa por un cambio de

modelo energético basado en el ahorro. Y para ello es necesario educar a las

nuevas generaciones porque, a su juicio, «en España hay una generación que

despilfarra energía» mientras que la conciencia por el ahorro está todavía en

muy bajos niveles. Y a la par es necesario invertir en I+D. «El cambio de

modelo energético es la revolución que viene» y que, según los expertos,

pasará por la desaparición del 50 por ciento del petróleo, la mitad por

el ahorro y otro tanto por el uso de las renovables.

-El Spirit dice adiós a Marte

Tenía una esperanza de vida de apenas 90 días pero durante más de seis años

se convirtió junto a su gemelo Opportunity en los ojos de la humanidad en el

Planeta Rojo. Hoy la NASA anunciaba oficialmente la 'muerte' del Spirit,

varado en un banco de arena tras perder el movimiento de dos de sus seis

ruedas y con el que no había podido comunicar desde hace 14 meses.

Desde el pasado mes de marzo los ingenieros de la agencia espacial han

realizado diversos intentos por restablecer el contacto con el robot, pero

sus llamadas no han obtenido respuesta.

La hipótesis que se maneja es que, carente de suficiente energía para

calentarse, el invierno marciano podría haber dañado sus circuitos internos

al someterlos a temperaturas de hasta 50 grados bajo cero. "Con insuficiente

energía para mantener en funcionamiento sus calentadores es probable que las

temperaturas en el interior del aparato explorador fuesen demasiado bajas",

señala el comunicado de la NASA.

El 4 de enero de 2004 el Spirit aterrizó en Marte. Apenas 15 minutos después

enviaba su primer mensaje a la Tierra para confirmar que todos sus sistemas

se encontraban operativos. "¡Hemos vuelto!", fue el grito de júbilo que se

escuchó dentro de la sala de control de California. Veinte días después el

Opportunity repetía la maniobra con idéntico éxito.

La llegada de ambos robots al Planeta Rojo supuso un respiro para la NASA,

que había visto como 24 de sus 32 misiones anteriores con este destino se

saldaron con sonoros fracasos y apenas un año antes sufrió la destrucción

del Columbia cuando reentraba en la atmósfera terrestre. No era esta aún así

la primera vez que se alcanzaba este objetivo. La NASA lo consiguió con las

Viking I y II (1976) y la Pathfinder (1997), mientras que los soviéticos

hicieron lo propio en 1971 con la Mars 3, con la que se perdió la

comunicación apenas unos segundos después de tocar suelo.

Laboratorio portátil

Del tamaño de un carrito de golf, para realizar sus experimentos el Spirit

contaba con un completo laboratorio portátil integrado por un brazo mecánico

para manipular objetos, cámaras y distintos utensilios para el análisis de

las muestras recogidas. Además del envío de decenas de miles de imágenes,

entre los logros del robot se encuentra el haber contribuido a hallar

indicios de que hace millones de años el agua pudo recorrer la superficie

marciana, y de que esta habría registrado temperaturas mucho más cálidas que

las actuales, lo que ofrece esperanzas de que la vida pudo existir en Marte.

En su periplo llegó a ascender una pendiente de 82 metros -equivalente a la

Estatua de la Libertad-, un esfuerzo de 14 meses pero que le permitió

realizar desde la cima de la bautizada como colina Husband la que es una de

las panorámicas más espectaculares del planeta.

El Spirit ya había dado señales de debilidad en otras ocasiones en forma de

silencios no programados, envío de datos sin sentido o fallos temporales en

sus mecanismos, aunque ante la sorpresa de sus ingenieros siempre había

conseguido recuperarse. La suerte también le sonrió a través del viento

marciano que inesperadamente le sirvió para limpiar de polvo la superficie

de las placas solares mediante las que se alimentaba. Esta vez parece que su

silencio es definitivo pero ha cumplido su misión con creces. "Han

convertido la ciencia ficción en realidad, y llevado a la gente a un lugar

que no habrían podido imaginar en toda su vida", dijo sobre ambos robots el

exjefe de ingenieros del proyecto, Jake Matijevic.

La investigación en Marte tiene asegurado su futuro inmediato pese a la baja

del Spirit. El Opportunity -que a lo largo de estos años ha recorrido 26

kilómetros frente a los 7,7 de su gemelo- continúa la exploración en

perfecto estado. Además, pronto le llegarán refuerzos. Para noviembre de

este año está previsto el lanzamiento del Curiosity que llegará al planeta

vecino en el verano de 2012. Con un volumen seis veces superior al de sus

dos predecesores, este nuevo robot tendrá como principal misión confirmar si

Marte albergó vida microbiana.

ciento del petróleo, la mitad por el ahorro y otro tanto por el uso de

las renovables.

Fuente: abc.es, 26-5-11

-Los satélites hayan 17 nuevas pirámides

|

17 pirámides de las que no se tenía conocimiento han

sido identificadas en un 'escaneado' por satélite del territorio de

Egipto, según informa en su página 'web' la radiotelevisión pública

británica BBC.

La prospección, según la BBC, se ha realizado

empleando rayos infrarrojos que han permitido descubrir

estructuras enterradas bajo el suelo. Además de las 17

pirámides, más de 1.000 tumbas y otros 3.000 yacimientos han sido

detectados en esta investigación.

Los sondeos, además, ya han dado sus frutos y dos de

las pirámides detectadas están siendo investigadas por equipos

arqueológicos, con resultados positivos.

Las excavaciones, así como el estudio por

infrarrojos, son iniciativa de un equipo de la Universidad de Alabama,

empleando satélites que trabajan a 700 kilómetros de la superficie de la

Tierra. Según los responsables del proyecto, los resultados que se han

alcanzado con esta investigación "sólo corresponden a los

yacimientos que están cerca del suelo. Hay miles de yacimientos

más que el nilo ha cubierto con el limo. Esto es sólo el comienzo de

este tipo de investigaciones".

Según la arqueóloga Sarah Parcak, el empleo de

satélites "permite afinar y ser más precisos en el trabajo que hacemos.

Cuando nos enfrentamos a un gran yacimiento, uno no sabe por dónde

empezar. Como herramienta, los satélites nos permiten tener una

perspectiva más amplia". |

|

Cuatro imágenes del documental de la BBC.

|

Fuente: elmundo.es, 25-5-11

-EEUU presenta su futura nave espacial

La

nueva nave de EEUU para explorar el "espacio profundo" es una vieja

conocida. El jefe de la NASA, Charles Bolden, anunció ayer un nuevo vehículo

para transporte de astronautas que responde a las siglas MPCV y que, según

la agencia espacial estadounidense, está basado en el diseño de las cápsulas

Orión.

Estos vehículos cuyo diseño comenzó en 2005 eran el buque insignia de la

agencia para llegar a la Luna y a Marte, según los planes aprobados por el

expresidente George Bush. Obama las canceló primero y, tras la polémica,

decidió conservarlas como vehículo de escape

de la Estación Espacial Internacional (ISS).

El nuevo anuncio es otro balón de oxígeno para las Orión, cuyo

fabricante, Lockheed Martin, esperaba tener que despedir a parte de sus

empleados debido a las cancelaciones. El MPCV llevará a cuatro astronautas

en misiones de 21 días.

Podrán amerizar en el océano Pacífico y

serán "diez veces más seguras durante la entrada en la atmósfera que

sus predecesores, los shuttle", según la NASA. Aún quedan dos

misiones a bordo de estas naves. El Endeavour regresará desde la

ISS el 1 de junio y el Atlantis partirá por última vez el 8 de

julio.

Fuente: publico.es, 25-5-11

-Google abandona la digitalizacón de los diarios

Google abandona su plan de digitalización de la hemeroteca de

los diarios. Se trata de un proyecto lanzado en 2008 y en el que estaban

implicados unos 2.000 periódicos.

En un comunicado remitido a searchengineland, la empresa

explica que mantendrá accesible la consulta del archivo de las cabeceras

digitalizadas, pero no ampliará su contenido. Google News Archive planeaba hacer

accesible en Internet el contenido de diarios desaparecidos o la hemeroteca de

diarios en circulación. En su base de datos hay publicaciones como London

Advertiser, de 1895.

Según el Boston Phoenix, que había llegado a un

acuerdo con Google para digitalizar su contenido, en el aviso recibido la

empresa anuncia que se concentrará en el proyecto Google One Pass, una

plataforma que facilita la gestión de suscripciones y acceso de pago de los

diarios desde sus propios sitios en Internet.

Fuente: elpais.com, 24-5-11

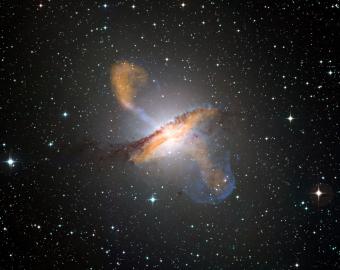

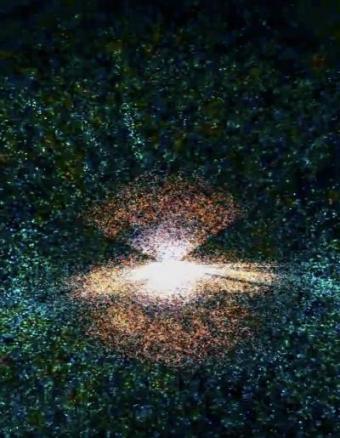

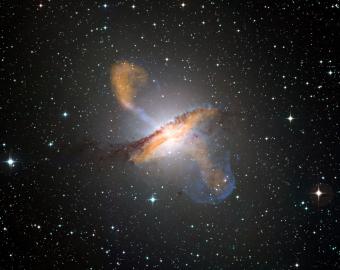

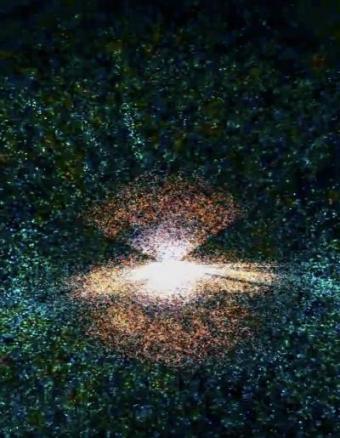

-Chorros de partículas a partir de un

agujero negro

La galaxia Centauro A está a unos 12 millones de años luz de la Tierra y tiene

un agujero negro con una masa aproximada de 55 millones de soles a partir del

cual salen proyectados dos chorros de partículas, de materia que sale disparada

a un tercio de la velocidad de la luz.

|

El mecanismo que originan estos chorros no están claros, pero ahora un

equipo de astrónomos ha obtenido las imágenes de ellos con mayor detalle

hechas hasta ahora, lo que debe ayudar a explicar el fenómeno. Han hecho las

observaciones con radiotelescopios, en concreto sincronizando los registros

de nueve antenas situadas en Australia, Suramérica, Suráfrica y la Antártida.

"Estos chorros surgen cuando se acerca al agujero

negro la materia que está cayendo en él, pero no conocemos aún los detalles

de cómo se forman y cómo se mantienen", explica Cornelia Mueller, estudiante

de doctorado de la Universidad de

Erlangen-Nurenberg (Alemania),

que lidera estas observaciones. El equipo, con los radiotelescopios

sincronizados, ha logrado obtener imágenes de una región de Centauro A que

mide menos de 4,2 años luz, inferior a la distancia entre el Sol y la

estrella más cercana. En ella se aprecian detalles de 15 días luz, según

informa la NASA.

Centauro A es uno de los objetos celestes más brillantes y más grandes

cuando se observa en radio, porque la galaxia que se ve en luz visible tiene

dos grandes lóbulos, cada uno de casi un millón de años luz de largo,

emitiendo en radio, que se alimentan de los chorros de partículas originados

en las proximidades del agujero negro central.

Estos astrónomo, que presentan su trabajo en el número

de junio de la revista Astronomy

and Astrophysics y ya está

disponible en internet, forman parte del proyecto Tanami.

Lo que han hecho es combinar, con una técnica que se denomina iterferometría,

las observaciones de las diferentes radioantenas ubicadas en los diferentes

continentes (siempre en el hemisferio Sur), logrando así una enorme

resolución en sus imágenes radio, ya que este parámetro es mayor al aumentar

la distancia entre las antenas. Luego los registros de cada una se combinan

con técnicas informáticas avanzadas. |

|

En la galaxia Centauro A se aprecian los dos chorros y los lóbulos cuando se

combinan las imágenes tomadas en diferentes longitudes de onda, desde rayos

X hasta radio, pasando por la luz visible y microondas.-

ESO/WFI/MPIFR/APEX/NASA/CXC/CfA/WEISS/KRAFT |

Fuente: elpais.com, 23-5-11

-El Papa contacta con los tripulantes de la Estación Espacial

Internacional

El papa Benedicto XVI ha contactado vía satélite con los tripulantes de la

Estación Espacial Internacional (ISS) con motivo de la última misión del

transbordador Endeavour.

"Estoy muy feliz de tener esta oportunidad extraordinaria de poder conversar con

vosotros durante vuestra misión. Sobre todo, estoy honrado de poder hablar con

muchos de vosotros. En este momento la humanidad está atravesando un periodo de

gran progreso desde el punto de vista del conocimiento científico y las

aplicaciones tecnológicas", afirmó Benedicto XVI.

En este sentido, sois los representantes de esta tecnología, con la que

lleváis adelante la capacidad humana y las nuevas posibilidades del futuro, que

hacen mejor nuestra existencia de todos los días. Admiro vuestra valentía y

vuestro compromiso para el que os preparáis toda la vida", agregó.

En una conversación de unos 20 minutos, el pontífice les dijo a los

tripulantes, entre ellos dos italianos, que son fuente de inspiración para

muchas personas.

"Estáis a disposición de toda la humanidad con vuestras acciones, con las

que buscáis el bien común. Esta conversación me da la oportunidad de

expresar mi admiración y mi estima por vosotros, también porque habéis hecho

posible esta misión y la habéis podido llevar a cabo de un modo positivo",

apuntó el Papa.

Acto seguido, el pontífice les planteó cinco preguntas sobre diversos temas,

entre ellos la paz, el cuidado del medioambiente, la aventura espacial como

forma de búsqueda de los orígenes de la humanidad, así como el mensaje que van a

transmitir a los jóvenes una vez que regresen a la Tierra. El Papa preguntó

también al ingeniero italiano Paolo Nespoli cómo había vivido la reciente muerte

de su madre, a tantos miles de kilómetros de distancia. "Querido Paolo, sé que

en los últimos días tu madre te ha dejado. Todos estamos cerca de ti y rezamos

por ti", dijo Benedicto XVI, quien habló con los astronautas en inglés, excepto

esta última cuestión, que fue planteada y respondida en italiano.

Nespoli le contestó que las misiones en el espacio te ofrecen la ventaja de

poder observar la Tierra desde arriba, pero también tiene el inconveniente de no

poder estar con la familia en momentos como la muerte de un ser querido, aunque

dijo que se ha sentido muy cercano y arropado por sus compañeros. Durante la

conexión se pudo ver cómo el otro astronauta italiano, Roberto Vittori, pasó a

Nespoli la medalla con la imagen de la creación del hombre de Miguel Ángel, que

el Papa le dio para que la llevara al espacio y que ahora su compañero deberá

traer de nuevo a la Tierra.

Última misión del 'Endeavour'

El transbordador Endeavour despegó el lunes rumbo a la Estación Espacial

Internacional (ISS), en la que será su vigésimo quinta y última misión al

espacio.

La nave partió del Centro Espacial Kennedy, en Florida, para realizar una misión

que durará 16 días y que incluye cuatro jornadas de trabajo de sus astronautas

fuera del complejo que órbita a unos 385 kilómetros de la Tierra. El Endeavour,

que con una carrera espacial de 19 años es el más joven en una flotilla que tuvo

cinco transbordadores, se desprendió de los dos cohetes propulsores y continuó

rumbo hacia su órbita sin problemas.

Los astronautas del Endeavour y de la Estación Espacial Internacional (ISS)

realizarán diversos experimentos científicos, entre ellos uno a desarrollar con

el aparato que viaja a bordo del transbordador y que permitirá el estudio de la

física de las partículas en los rayos cósmicos.

Fuente: elmundo.es, 22-5-11

-Los efectos del paro en la pobreza

Investigadores

de la Universidad Rey Juan Carlos (URJC) confirman que la proporción de

personas que experimentan carencias y dificultades es superior entre las

familias inmigrantes, lo que representa un riesgo cinco veces superior al que

afrontan las demás familias. Además alertan de la vulnerabilidad de los

trabajadores inmigrantes en el mercado de trabajo y ante posibles descensos

repentinos de ingresos, como son los asociados a la pérdida de empleo. La

brecha se amplia, a partir de 2008, por efecto de la crisis.

Los resultados de la investigación “Privación multidimensional

en España: Diferencias entre nativos e inmigrantes” liderada por Luis Ayala,

desde el departamento de Economía Aplicada II de la Universidad Rey Juan Carlos,

confirman plenamente la idea de que los trabajadores inmigrantes ocupan una

posición subordinada y vulnerable en el mercado de trabajo, con una mayor tasa

de asalarización y una concentración muy marcada en un puñado de ocupaciones

poco cualificadas de determinados sectores de actividad (como la construcción o

la hostelería).

En dichas ocupaciones, los inmigrantes trabajan muy frecuentemente con

contratos temporales, cambian de empleo más a menudo que los trabajadores

autóctonos y ejercen menos veces tareas de responsabilidad que impliquen la

coordinación o dirección de equipos de trabajadores. Además, ganan menos que los

trabajadores autóctonos con similar nivel educativo.

En concreto, los resultados sobre salarios muestran que los trabajadores

inmigrantes están sobre-representados en los tramos retributivos más bajos,

especialmente en el caso de las mujeres, lo que se traduce en una brecha

salarial media situada en torno al 25%. Por otra parte, los salarios que cobran

los inmigrantes son más homogéneos que los que reciben los restantes

trabajadores, y todo ello implica un elevado riesgo de llegar a ser trabajadores

(y sobre todo trabajadoras) “pobres “ y se traduce en una también alta

proporción de familias con ingresos inferiores al umbral de riesgo de pobreza,

situado en el 60% de la media. A lo largo de todo el período estudiado, la tasa

de riesgo de pobreza de las familias sustentadas por inmigrantes ronda el 30%,

más de 10 puntos por encima del promedio nacional.

La posición económica relativa de los hogares sustentados por una persona

inmigrante se agrava cuando se utilizan indicadores distintos de la tasa de

pobreza convencional, basada en la renta disponible. Es el caso de la inclusión

del alquiler y de los ingresos los gastos relacionados con la vivienda (sin

incluir la amortización de posibles préstamos hipotecarios), que llevaría a

situar a casi la mitad de las familias inmigrantes por debajo del umbral. Esta

gran brecha refleja las disparidades entre viejos y nuevos residentes en el

acceso a la propiedad inmobiliaria, así como en la calidad media de las

viviendas y en la carga financiera que supone su alquiler o compra. Ello supone

un nuevo factor de vulnerabilidad ante posibles descensos repentinos del nivel

de ingresos, como los asociados a la pérdida del empleo.

Por último, en prácticamente todos los indicadores, la proporción de personas

que experimentan carencias y dificultades es superior entre las familias

inmigrantes, con diferencias especialmente abultadas en aspectos como la

posesión de ordenador o automóvil, las dificultades para llegar a fin de mes y

la frecuencia de los retrasos en los principales pagos periódicos (recibos,

alquiler o hipoteca, compras aplazadas).

Por otra parte, la brecha vuelve, además, a ampliarse en 2008, año en el cual

once de los catorce indicadores de privación empeoran, por efecto de la crisis,

en el caso de los hogares sustentados por inmigrantes. En esta última fecha,

casi la mitad de la población en hogares encabezados por inmigrantes sufre

privación material (es decir, presenta tres o más carencias simultáneamente), el

triple que en los hogares nativos, y casi uno de cada cuatro sufre

simultáneamente baja renta y privación material, lo que representa un riesgo

cinco veces superior al que afrontan las demás familias.

Fuente: madridiario.es, 21-9-11

-El universo nació de rebote

Los físicos no tienen herramientas para enfrentarse al origen del universo. Lo

que sí han conseguido demostrar es que hace aproximadamente 13.700 millones de

años, toda la materia y la energía se encontraban en una diminuta región, que,

poco a poco se expandió, dando nombre a la famosa teoría del 'Big Bang'. Sin

embargo, queda por resolver qué sucedió durante ese espacio de tiempo previo. La

teoría de la 'Gravedad Cuántica de Lazos' formulada por Abhay Ashtekar hace

ahora 25 años explica qué ocurrió antes de la expansión. Ashtekar, director del

Instituto para Física Gravitacional y Geometría de la Universidad del Estado de

Pensilvania ha expuesto los últimos avances junto a su colega Carlo Rovelli en

la sede madrileña de la Fundación BBVA.

La teoría ideada por Ashtekar se presenta como candidata a resolver uno de

los retos más importantes de la física contemporánea: unificar las leyes de

la relatividad general con las de la mecánica cuántica. Según el físico

indio, "es la única teoría bien desarrollada en la que todo, la materia y el

espacio-tiempo, son cuánticos desde su nacimiento". La Gravedad Cuántica de

Lazos indica que, a escalas muy pequeñas, el espacio-tiempo está formado por

una red de lazos entretejidos parecida a la espuma. La 'teoría de las

cuerdas' es su competidora más directa. El físico reconoce que han tenido

diferencias con los defensores de esta teoría. El mayor reto al que se

enfrenta ahora es el de comprobar sus predicciones. Para ello contarán con

los datos recogidos por el satélite de la Agencia Espacial Europea (ESA)'Planck'.

La Gravedad Cuántica de Lazos se ha unido a un modelo en el que el 'Big Bang'

es precedido de una o varias fases previas de colapso y expansión en algo

parecido a un rebote.

"La región del 'Big Bang' es inaccesible para la física convencional",

abunda Rovelli, "con la Gravedad Cuántica de Lazos podemos hacer cálculos y

computar lo que puede haber pasado. Los resultados de estos cálculos indican

de forma rotunda que antes del 'Big Bang' hubo otro universo que se

contrajo; luego, al rebotar, dio lugar al nuestro".

El físico y su equipo también han aportado hipótesis que explican los

misteriosos agujeros negros cuya altísima concentración de materia los físicos

no entienden. Ashtekar confesó que su fascinación por la física y las

matemáticas empezó cuando a los 15 años, leyó el libro 'Un, dos, tres,

infinito', escrito por el mítico George Gamow.

Fuente: elmundo.es, 20-5-11

-El terremoto de Japón elevó tres metros el fondo del mar

La corteza terrestre dio un monumental bandazo y desplazó decenas de metros el

fondo del mar cuando el pasado 11 de marzo un terremoto de 9 grados Richter

azotó la costa de Japón causando un gran tsunami. Un estudio recién publicado en

la revista 'Science' indica que una banda del fondo marino de 20 metros de ancho

se elevó tres metros verticalmente. Mariko Sato y varios colegas de la

Universidad de Tokio han podido analizar los datos recogidos por una serie de

aparatos de observación situados en la base del océano. Curiosamente, entre los

años 2000 y 2004 habían colocado cinco aparatos traspondedores muy cerca del

foco del terremoto del 11 de marzo.

El tsunami toca tierra en la localidad

de Natori. | Reuters

|

|

Cruzando esos datos junto con las mediciones de GPS y los registros de ondas

acústicas, los autores del artículo en Science han podido confirmar que hubo una

larga banda de terreno, de varios kilómetros de largo, que se desplazó

horizontalmente entre cinco y 24 metros a lo largo del fondo del mar. Ademas,

esa banda de corteza marina dio un 'brinco' vertical de entre 80 centímetros y

tres metros de alto. Fue en la zona más cercana al epicentro donde se registró

el mayor movimiento: 24 metros en horizontal y tres metros en altura.

Ese es precisamente el tipo de movimiento que genera tsunamis como el del 11

de marzo. Al desplazarse hacia arriba, la corteza empuja el volumen de agua

que tiene encima y empieza a desplazarla en todas direcciones. Es el mismo

efecto que se observa cuando se da un golpe hacia arriba con la mano en el

culo de un vaso. Los investigadores terminan su artículo haciendo una

valoración de cuánta parte de la corteza se vio afectada por el movimiento.

No tienen observaciones completas para poderlo demostrar, pero estiman que

ese movimiento de traslación y de elevación registrado afectó a una banda

del fondo marino de 70 kilómetros de longitud.

Lo que los científicos han encontrado más interesante es descubrir que el

movimiento detectado por los traspondedores fue realmente cuatro veces más

grande de lo que los sensores de tierra habían permitido deducir, lo que

tiene repercusiones para mejorar las valoraciones sobre futuros tsunamis. |

Otras conclusiones

Además de este artículo liderado por Mariko Sato, la revista Science publica en

su último número algunos trabajos más sobre el seísmo del 11 de marzo, al que

los geólogos han bautizado ya con el nombre de Gran Terremoto de Tohoku-Oki y

que ayudan a entender mejor el tipo de movimiento qe se produjo y qué fue lo que

liberó tanta energía.

Fuente: elmundo.es, 20-5-11

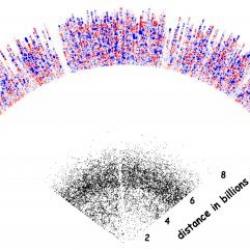

-El espacio está lleno de planetas rebeldes

El universo no deja de mostrar que otros mundos son posibles.

Primero fueron los exoplanetas que orbitan estrellas fuera del Sistema Solar,

después los supuestos gemelos de la Tierra y, ahora, una clase de mundos sin

ataduras que se comportan de forma tan extraña

que no hay ni consenso para ponerles nombre.

Son supuestos planetas que vagan libres por el espacio, sin

dar vueltas a una estrella como hace la Tierra y la gran mayoría de los más de

500 exoplanetas confirmados desde 1995. Un equipo internacional describe hoy en

Nature diez de estos mundos, a los que han llamado "masas planetarias".

Tienen el tamaño de Júpiter, el mayor planeta del Sistema Solar, y su distancia

a la estrella más cercana es diez veces mayor que la que hay entre el Sol y la

Tierra (1.500 millones de kilómetros). Por ello, los autores sugieren que "la

mayoría" de ellos "no están ligados a una estrella".

La idea de un planeta libre no es nueva. En 2000, un equipo

de investigadores del Instituto de Astrofísica de Canarias fue el primero en

observar estos cuerpos que habían soltado amarras de sus estrellas.

|

|

|

Eran hasta 15 veces mayores que Júpiter y, en un

artículo en Science, los astrónomos los bautizaron "planetas

gigantes solitarios". También señalaron que su existencia cuestionaba las

teorías terrícolas de cómo nace un planeta.

En su trabajo actual, los 30 investigadores de Japón,

Nueva Zelanda, Reino Unido, EEUU, Polonia y Chile que firman el artículo

ofrecen una posible explicación para su nacimiento. Los gigantes solitarios

se formaron en torno a una estrella junto a otros planetas, es decir, el

proceso habitual, pero en algún momento pasaron tan cerca de alguno de ellos

que las fuerzas gravitatorias los expulsaron al espacio exterior.

Hacer un censo

"Nuestro estudio es como un censo de población", dice

el astrónomo de EEUU David Bennett, coautor del trabajo, en una nota

difundida por la NASA. Primero estudiaron una porción de la Vía Láctea

durante dos años con el telescopio MOA de Nueva Zelanda, que capta picos

de luz reflejada en estos planetas, y el OGLE, que hace observaciones

directas desde Chile. Luego se cuenta el número de planetas solitarios y

se extrapola al resto de la galaxia, explica Bennett.

|

El resultado es que este tipo de cuerpos pueden ser dos

veces más numerosos que las estrellas normales, aunque por las técnicas de

observación, basadas en la alineación de dos estrellas, son muy difíciles de

ver. Eso significaría que en la Vía Láctea habría medio billón de estos

rebeldes sin sol, según el experto en exoplanetas del CSIC Ignasi Ribas. "Es

algo que predecían los modelos y que comenzamos a observar de forma directa",

destaca.

Los autores del trabajo actual se cuidan de llamarlos

planetas, ya que no está claro que un cuerpo que no orbita una estrella lo

sea. Además se ignora de qué están hechos y si pueden albergar vida, algo que

varios trabajos anteriores han visto que es posible. En un artículo

complementario, el astrónomo de la Universidad de Heidelberg Joachim

Wambsganss cita varias de las denominaciones que actualmente están en liza.

Incluyen "planeta flotante", "planeta solitario" y, en un giro que recuerda al

cantante Prince, "objetos antes conocidos como

planetas". "Es un tema aún muy confuso, no sabemos cómo llamarlos, pero

yo me resisto a que se les llame planetas", confiesa Ribas.

Fuente: publico.es, 19-5-11

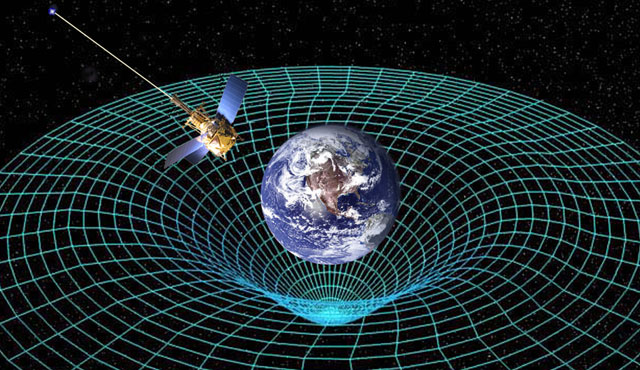

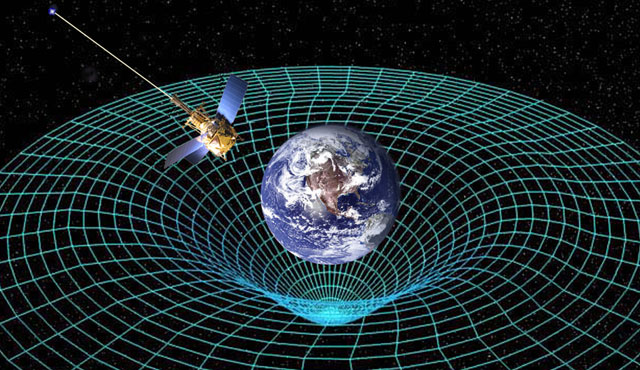

-Einstein no se equivocó

La sonda espacial de la

NASA

Gravity Probe B acaba de confirmar las distorsiones del espacio-tiempo

predichas por la Teoría de la Relatividad General de Einstein. Culmina así una

larga empresa que ha costado cinco décadas de trabajo y más de 750 millones de

dólares. Entre tanto, este mismo fenómeno ha sido puesto de manifiesto por

otros experimentos, lo que ha ocasionado un debate en la comunidad científica

sobre la necesidad y conveniencia de Gravity Probe B.

|

|

La Teoría de la Relatividad General enunciada por

Albert Einstein en 1916 sigue siendo la mejor descripción existente de la

gravedad, posiblemente la fuerza física más determinante en la estructura

y evolución del Universo.

Según el físico alemán, un cuerpo masivo curva el

espacio-tiempo en su entorno, lo que ocasiona que los rayos de luz

abandonen en su proximidad la trayectoria rectilínea para seguir

trayectorias curvadas, es lo que se conoce como �efecto geodésico�.

Otra consecuencia de la Teoría de Einstein, predicha

por los físicos austríacos Lense y Thirring en 1918, es que si ese cuerpo

masivo se encuentra girando (como hace la Tierra), las líneas del

espacio-tiempo se deforman aún más, torciéndose para acompañar al giro. Es

lo que se conoce como 'arrastre del marco de referencia'.

Se trata de un fenómeno similar a la creación de un

campo magnético por una carga en rotación, por ello también se denomina

efecto gravitomagnético. Para hacernos una idea aproximada, podemos pensar

en la Tierra sumergida en chocolate fundido. Según gira el planeta, el

chocolate del entorno es arrastrado y tiende a también a girar en el mismo

sentido que la Tierra. |

Bolas de ping pong ultraprecisas

Ya en 1920, Arthur

Eddington sugirió utilizar giróscopos de alta precisión para detectar los

efectos que el giro de la Tierra debía ocasionar sobre ellos, y probar así la

Teoría de Einstein. La idea fue desarrollada a finales de los años 1950 y la

NASA comenzó el diseño de los giróscopos más precisos de la historia. Del

tamaño de una pelota de ping-pong, las esferas de dichos giróscopos fueron

construidas en cuarzo y bañadas en niobio superconductor para lograr un

comportamiento electromagnético óptimo. Tales giróscopos fueron embarcados en

la nave Gravity Probe B que, tras múltiples estudios y peripecias, fue lanzada

en el año 2004.

El satélite fue puesto en órbita polar a unos 650 kilómetros de altitud, y

el eje de giro de los giróscopos (que en la nave espacial se encuentran en una

situación equivalente a gravedad cero) fue orientado cuidadosamente en la

dirección de la estrella IM Pegasi.

Si el espacio-tiempo no fuese curvo, el eje de giro de las bolas de cuarzo

no debía variar en el tiempo. Pero lo que se ha observado es que, debido al

efecto geodésico predicho por Einstein, el eje de giro varía (precesa) de

6.601,8 milisegundos de arco por año (con un margen de error del 0,3 por

ciento).

Por otro lado, una variación adicional de 37,2 milisegundos de arco por año

(con un margen de error del 19 por ciento) solo puede ser ocasionada por el

arrastre del marco de referencia (Lense y Thirring predijeron un valor de 39).

Estos resultados han sido publicados hace unos días en la revista

especializada Physical Review Letters.

Un experimento 'relativamente' necesario

La sonda de la NASA confirma así dos predicciones

fundamentales realizadas haci casi un siglo por la Teoría de la Relatividad de

Einstein, lo que sin duda supone un nuevo éxito para el genial físico.

Sin embargo, no es esta la primera vez que la Teoría de

Einstein ha sido sometida es este tipo de test; otros experimentos, realizados

con anterioridad, habían logrado medir estos efectos aún con mayor precisión.

Por ejemplo, se realizaron otros tests similares a

principios de los años 1970 mediante la medida precisa del movimiento de la

Luna, ello se consiguió reflejando un láser en los espejos que fueron

instalados en la superficie de nuestro satélite por las misiones Apolo.

También el estudio de los púlsares binarios y el seguimiento mediante láser de

los satélites LAGEOS permitió validar la misma Teoría de Einstein. Finalmente,

la medida de los retrasos experimentados por una radioseñal emitida por la

sonda Cassini consiguió medir el efecto geodésico con una precisión del 0,002

por ciento.

Así las cosas, no es de extrañar que la misión Gravity

Probe B, plagada de graves dificultades técnicas, haya estado al borde de la

cancelación en unas 7 ocasiones a lo largo de su desarrollo y haya sido el

centro de un agrio debate en la comunidad científica.

El último examen de la misión realizado en 2008 pudo ser

superado gracias a las aportaciones extraordinarias de capital privado, entre

ellas la de la familia real de Arabia Saudí, que permitieron refinar el

análisis de los datos. Se realizaron entonces modelos muy detallados de los

efectos instrumentales que alteraban el giro de las esferas de manera

indeseable, hasta conseguir una precisión aceptable en la identificación de

los efectos relativistas.

Francis Everitt, el físico de la Universidad de Stanford

que ha pilotado la misión durante estas cinco décadas, puede por fin respirar

tranquilo tras alcanzar su objetivo de una manera que ha sido calificado como

heroica. Sus datos encajan bien tanto con la teoría como con las medidas

anteriores.

Sin embargo estos nuevos resultados pueden tener unas

implicaciones tecnológicas superiores a las meramente científicas. La

tecnología desarrollada podrá servir para optimizar la fabricación de relojes

embarcados en naves espaciales. Es de esperar pues que los datos de Gravity

Probe B sean de utilidad para mejorar la precisión de los sistemas de

posicionamiento global mediante constelaciones de satélites.

También interesante

-

Las esferas de Gravity Probe B entraron en el libro

Guiness por ser las más perfectas fabricadas por el hombre. Las

irregularidades en sus superficies no superan un espesor de 40 átomos. Si

una de esas esferas tuviese el tamaño de la Tierra, sus valles y montañas no

superarían, respectivamente, los 2 metros de profundidad y altura. Las

esferas giraban a unas 10.000 revoluciones por minuto.

-

El apantallamiento magnético de los giróscopos se lograba

mediante su instalación en un recipiente Dewar de plomo de 1,25 centímetros

de espesor enfriado, con Helio líquido, a unos 271 grados Celsius bajo cero.

A tan bajas temperaturas, el plomo se hace superconductor y sirve así de

pantalla magnética eficiente, manteniendo el campo magnético en las esferas

por debajo de 3 microgauss. Al girar las esferas, el baño de niobio (también

superconductor) crea un pequeño campo magnético alineado con el eje de giro

(mediante el denominado �efecto London�). Unos sensores electrónicos (tipo

SQUID) detectaban los cambios en el campo magnético registrando así la

precesión del eje de giro.

-

Aunque en gravedad próxima a cero, el Gravity Probe B no

podía evitar el estar sometido a aceleraciones ocasionales. Tales

aceleraciones eran compensadas inmediatamente mediante impulsos generados en

el sistema de propulsión del satélite. De esta manera la gravedad a la que

estaban sometidos los giróscopos nunca superaba una diez mil millonésima

parte de la gravedad terrestre.

Fuente: elmundo.es, 18-5-11

-8 horas de internet al día

Cerca de la mitad de los usuarios que utiliza Internet pasa más de

ocho horas al día online. De esta cifra hay que tener en cuenta que

el principal uso es laboral. Con motivo de la celebración el 17 de mayo del

Día de Internet, la comunidad Red Innova ha hecho público un estudio basado

en encuestas a usuarios del que se desprende que el

49,4% de los usuarios de Internet pasan más

de ocho horas conectados.

Una amplia mayoría, un

97,8%, lo hace para trabajar, el 90,7% para consultar el correo

electrónico, siendo el segundo uso mayoritario, el ocio es la tercera opción

con un 86,9% y la consulta de noticias se sitúa en la cuarte posición, aún

con un porcentaje muy elevado (84,7%).

En cuanto al uso de las redes sociales, un 82,6% de los

encuestados asegura utilizarlas para

compartir información, mientras que un 75,4% las emplea para hacer

contactos profesionales y buscar trabajo. En tercer lugar los usuarios

emplean las redes sociales para mantener el contacto con los amigos (69,8%),

mientras que un 58,6% de los internautas habituales afirma que navega por

las redes sociales durante su tiempo de trabajo porque cree que son una

fuente de información o sirven para mantener el contacto con sus clientes.

Además, el 66,3% considera que Internet es una excelente

opción para compaginar mejor la vida

profesional y la personal, mientras que un 65,7% de los encuestados

señala como uso cotidiano las compras y la ejecución de operaciones

bancarias. Del estudio se desprende que el 67,3% de los internautas afirma

que utiliza su teléfono móvil para conectarse.

Fuente: publico.es, 17-5-11

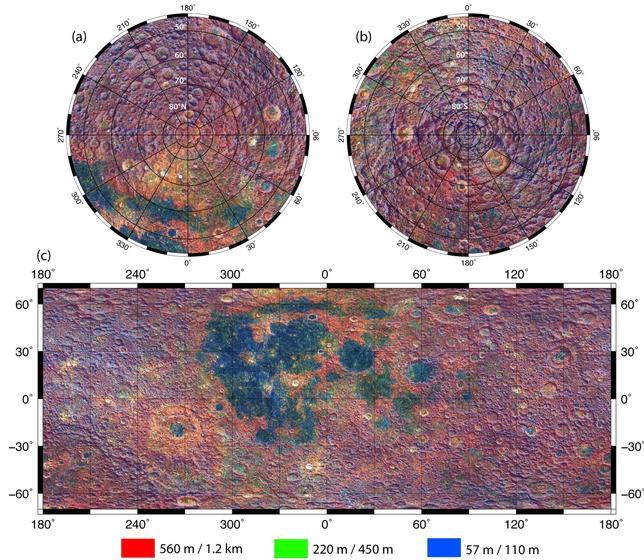

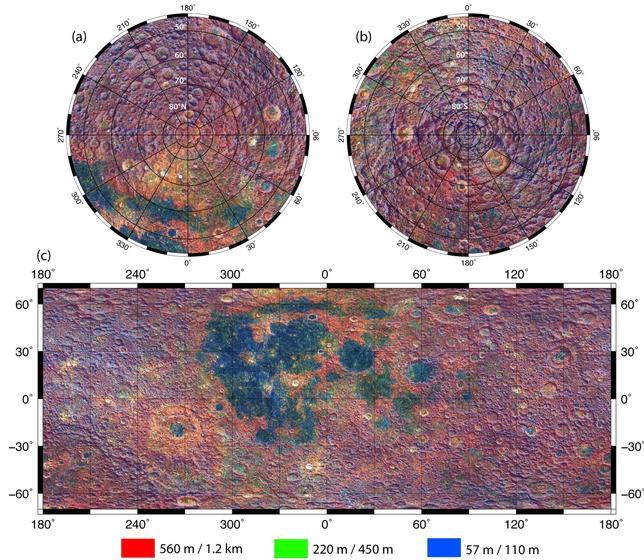

-Primer mapa de las arrugas de la Luna

La Luna lleva impresos en su castigada superficie los daños que ha sufrido

durante 4,5 millones de años. No hay cosmética que haya podido suavizar los cráteres

de impacto o las oscuras llanurascreadas por antiquísimas erupciones

volcánicas, unas cicatrices que pueden esclarecer a los científicos cuál es la

auténtica historia de nuestro satélite natural. Ahora, científicos del

Instituto de Tecnología de California en Pasadena han elaborado el

primer conjunto completo de mapas que revelan la rugosidad de la cara de la

Luna. Esta especial

cartografía se ha realizado con detallados datos recogidos por un instrumento

del Orbitador

de Reconocimiento Lunar (LRO,

por sus siglas en inglés) de la NASA, construido en el Centro de Vuelo

Espacial Goddard en Greenbelt, Maryland.

Al igual que las arrugas en la piel, la aspereza de los cráteres y otras

características de la superficie de la Luna pueden

revelar su edad.«La clave está en buscar en la rugosidad en escalas

largas y cortas», explica Meg Rosenburg, principal autora del artículo que

describe los resultados, publicados en el Journal

of Geophysical Research a

principios de este año.

La rugosidad depende de las subidas y bajadas sutiles del paisaje, una

calidad que los investigadores pueden descubrir mediante la medición de la

pendiente en localizaciones por toda la superficie. Para armar un cuadro

completo, los investigadores examinaron la rugosidad en un rango de

diferentes escalas -las distancias entre dos puntos -de 17 metros a 2,7

kilómetros-.

«Los cráteres viejos y jóvenes tienen propiedades diferentes de

rugosidad», dice Rosenburg. Eso es porque los cráteres más antiguos han

sido golpeados durante mucho tiempo por meteoritos, cambiando la forma

original del cráter. Esta es una forma de descubrir qué cráteres son

viejos y cuáles nuevos.

Pistas sobre la evolución de la Luna

Al observar dónde y cómo están los cambios de rugosidad, los

investigadores pueden obtener pistas importantes sobre los

procesos que dieron forma a la Luna. Un

mapa de la rugosidad del material que rodea la cuenca Oriental, por

ejemplo, revela diferencias sutiles en el material expulsado cuando el

cráter se formó por un objeto gigante que se estrelló contra la Luna.

Esa información se puede combinar con un mapa de contornos que muestra

dónde están los puntos altos y bajos. «Al mirar los dos juntos, podemos

decir que una parte de la cuencia Oriental no sólo es mayor o menor, sino

también diferente en rugosidad», dice Rosenburg. «Eso nos da algunas

pistas sobre el proceso de impacto que lanzó el material expulsado y

también sobre los procesos de la superficie que más tarde actuaron para

modificarlo».

De la misma forma, las llanuras lisas de María -que en un principio los

astrónomos confundieron con mares- fueron creadas

por la actividad volcánica y tienen una rugosidad diferente a la de las

tierras altas de la Luna, lo que refleja orígenes distintos en los

dos terrenos.

Fuente: abc.es, 16-5-11

-Malas noticias para un fármaco estrella contra el cáncer

Hace pocas semanas, EEUU decidió prohibir el uso de

bevacizumab (más conocido por su nombre comercial Avastin) para el

tratamiento del cáncer de mama. Una de las razones alegadas es que sus

beneficios no parecen ser superiores a sus riesgos. Ahora, los resultados

de una revisión ahondan en el tema de su seguridad al detectar un pequeño

aumento de la mortalidad que invita a reconsiderar en qué situaciones debe

usarse este fármaco 'superventas'.

El trabajo, publicado en la revista

'Journal

of the American Medical Association', analiza los datos de 16 ensayos

clínicos en los que se comparó el uso combinado de bevacizumab más

quimioterapia o terapia biológica frente a estos dos tratamientos por

separado en pacientes con distintos tipos de cáncer (colon, riñón,

próstata, pulmón, mama y páncreas). Su conclusión es que "añadir este

fármaco a la terapia antineoplásica se asocia con un

aumento significativo del riesgo de sufrir reacciones adversas fatales",

apunta el trabajo.

Basándose en la información de más de 10.000 pacientes,

los autores concluyeron que aquellos tratados con Avastin tenían

un riesgo 1,5 veces superior de sufrir un efecto secundario letal

en comparación con los demás. Aunque se trata de una probabilidad pequeña

(2,5%), los autores sugieren que el tratamiento con este fármaco se "debe

reconsiderar" y "es importante para los médicos y los pacientes que

entiendan y reconozcan los riesgos".

Algo que, según Ricardo Cubedo, oncólogo del Hospital

Puerta de Hierro de Majadahonda (Madrid), ya se había observado. "Sabemos

que Avastin tiene toxicidad y que hay que tener cuidado con las

perforaciones [gastrointestinales] y las hemorragias", explica a

ELMUNDO.es. El problema con este fármaco, según los expertos consultados

por este medio, es otro.

Resultados inconsistentes

La historia de Avastin, un anticuerpo

monoclonal que

inhibe el desarrollo de nuevos vasos sanguíneos, fenómeno del que

depende el crecimiento de tumores y metástasis, está llena de altibajos. A

pesar de los buenos augurios iniciales, "el desarrollo clínico de

bevacizumab incluye éxitos y fracasos decepcionantes", apunta Daniel Hayes,

reputado oncólogo de la Universidad de Michigan (EEUU), en un editorial

acerca de este estudio. La euforia inicial se ha ido

disipando debido principalmente a las sospechas acerca de sus

efectos adversos letales y a que Avastin no aumenta la supervivencia

global de los pacientes.

"La inconsistencia de los resultados despierta

cuestiones importantes: ¿Tiene bevacizumab beneficios específicos contra

el cáncer?", se pregunta Hayes. La práctica clínica y el análisis

detallado de la respuesta al fármaco sugieren que "funciona bien,

pero sólo en pacientes seleccionados", señala este experto.

Emilio Alba, presidente de la Sociedad Española de Oncología Médica (SEOM),

coincide en que "en algunos pacientes funciona muy bien pero en otros no

tiene ningún efecto".

Administrarlo o no

A pesar de esto, Avastin es el fármaco de su familia

más utilizado en España y uno de los más empleados en EEUU. Pero es que

averiguar qué personas se beneficiarían del tratamiento con Avastin pasa

por realizar estudios biológicos que determinen qué biomarcadores

predicen este efecto positivo y cuales indican el futuro fracaso.

"Habría que hacerlo -subraya Cubedo-; pero, ¿quién lo hace?".

Por un lado, las farmacéuticas "no tienen ningún

incentivo para llevar a cabo estas investigaciones", señala este oncólogo.

Por otro, "cuestan demasiado dinero para que las hagan otras

instituciones". Mientras tanto, bevacizumab se sigue

administrando o se prohíbe para ciertos tumores, en función de las

decisiones de las diferentes agencias reguladoras (Reino Unido, por

ejemplo, ya le impuso serias restricciones).

¿Cuál es la acertada? Para Hayes, los beneficios de su

uso generalizado "podrían no estar justificados" dados los "modestos"

beneficios detectados y al enorme coste de este fármaco (unos

30.000 euros por paciente).

Fuente: elmundo.es, 15-5-11

-Muere un operario en Fukushima por causas desconocidas

|

La central nuclear de Fukushima, en Japón.ap

|

|

Un trabajador de la central nuclear Fukushima

Daiichi falleció durante su jornada laboral, según anunció un

portavoz de Tepco, la compañía dueña de la planta.Aunque las causas

de la muerte son desconocidas por el momento, el portavoz declaró

que su cuerpo no presentaba niveles

elevados de contaminación radiactiva y que el operario

llevaba ropa y máscara protectoras.

Se da la circunstancia de que

la víctima, de 60 años, llevaba sólo un día trabajando en la

central y se calcula que se había expuesto a 0,51 milisieverts el

viernes y 0,17 en la parte de jornada laboral que cumplió el sábado,

una cantidad "apenas cuatro veces superior a la que se obtiene tras

hacerse cuatro radiografías de tórax", señala The Washington

Post.

Al parecer, el operario se empezó a encontrar mal

cuando trabajaba en un edificio de depósito de agua radiactiva. "La

temperatura en las instalaciones no está siendo monitorizada, pero

hemos sabido que no es un ambiente preocupante ni en términos de

humedad ni en cuanto a niveles de radiación", explicó a los medios

el portavoz de Tepco Yoshimi Hitosugi, que añadió que el trabajo de

la víctima "no requería de gran

esfuerzo físico". Varios medios japoneses han apuntado a que

la causa de la muerte sería un infarto.

Se trata del primer fallecimiento de un

trabajador de Fukushima durante los trabajos de reparación de la

central. Dos operarios fallecieron anteriormente, pero por el

terremoto y posterior tsunami que sacudió el país el pasado 11 de

marzo. |

Momento delicado

La muerte del trabajador viene en un momento delicado

para Tepco, después de que el miércoles pasado Goshi Hosono, un asesor

especial para el primer ministro japonés, Naoto Kan, expresara en rueda

de prensa su preocupación por las

condiciones laborales de los trabajadores de Fukushima. El diario

japonés Mainichi, publicó que muchos operarios de la central

están siendo obligados a trabajar sin estar completamente

descontaminados. El diario citaba a un empleado de una subcontrata de

Tepco que afirmaba que su empresa

"firmaba permisos especiales" para permitir a sus trabajadores

trabajar a más niveles de radiación de los permitidos.

La crisis coincide con el anuncio de que el Gobierno japonés

continuará trabajando con energía nuclear, aunque fomentará el uso de

otras energías alternativas. Según el periódico Yomiuri, así lo

expresará Kan a los primeros ministros de

los países más ricos del mundo en la

reunión del G8, que se celebrará en Deauville, Francia, los

próximos 26 y 27 de mayo. En la reunión hará hincapié, eso sí, en que

Japón aumentará la seguridad en torno a la energía nuclear.

Fuente: publico.es, 14-5-11

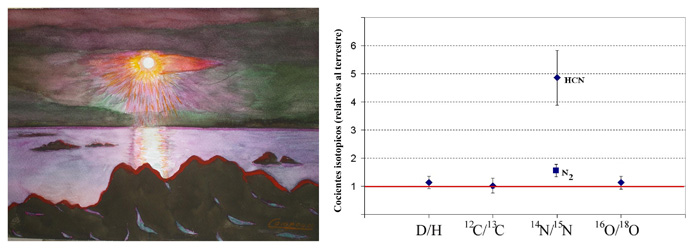

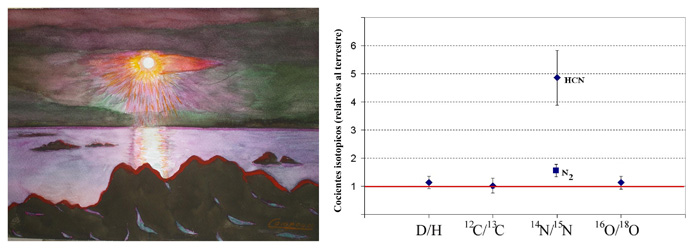

-Cometas y meteoritos originaron la

atmósfera de la Tierra y Titán

Investigadores

del Consejo Superior de Investigaciones Científicas (CSIC) han hallado un nexo

común en el origen de las atmósferas de la Tierra y del satélite de Saturno

Titán. El análisis de los datos obtenidos por la misión Cassini-Huygens, un

proyecto de la NASA, la Agencia Espacial Europea y la Agencia Espacial Italiana,

sugiere que la evolución química de ambas atmósferas estuvo marcada por el

último gran bombardeo de asteroides y cometas durante la formación del Sistema

Solar, hace unos 3.900 millones de años.

|

Figura 1. Izqda. Reconstrucción de la Tierra primitiva en las fases de

producción de materia orgánica en la atmósfera. Acuarela de J. Trigo Campoy.

Dcha. Gráfica mostrando la similitud entre los cocientes isotópicos de la

Tierra (línea roja) y los de Titán para los principales elementos

constituyentes de la materia orgánica. Los datos se han extraído de

diferentes resultados obtenidos por la misión Cassini-Huygens (ESA)./CSIC |

|

Según los

científicos del CSIC Josep Maria Trigo y Francisco Javier Martín, autores

del estudio que aparece publicado en el último número de Planetary &

Space Science, este “gran bombardeo tardío” se inició cuando los

planetas gigantes Júpiter y Saturno migraron hasta sus actuales órbitas, lo

que produjo un impulso gravitatorio sobre cuerpos helados formados en varias

regiones de la parte externa del Sistema Solar. Como consecuencia, una gran

cantidad de objetos ricos en agua y en materia orgánica empezaron a impactar

sobre planetas rocosos como la Tierra.

Los científicos

han hallado grandes similitudes entre la Tierra y Titán, a pesar de que

ambos cuerpos planetarios se formaron muy lejos el uno del otro (el planeta

azul se encuentra nueve veces más cerca del Sol que el satélite de Saturno).

En concreto, sus atmósferas tienen en común la abundancia de nitrógeno

molecular, deuterio, hidrógeno, carbono, nitrógeno y oxígeno. Todos estos

elementos apuntan al mismo origen derivado del impacto de cometas y

asteroides. |

También han

llevado a cabo un estudio termodinámico de las condiciones atmosféricas de ambos

cuerpos planetarios. Los resultados sugieren que la evolución química de ambas

atmósferas habría sido similar, marcada por varios impactos. “Dado que la Tierra

se formó en un entorno muy caliente próximo al Sol, ese gran bombardeo tardío

resultó fundamental para enriquecerla con los ingredientes básicos para la

aparición de la vida. De hecho, la mayoría de cuencas y grandes cráteres de la

Luna fueron provocados por el impacto de estos objetos enriquecedores en ese

periodo, tal y como dataron las rocas lunares recogidas por las misiones Apolo”,

explica Trigo, que trabaja en el Instituto de Ciencias del Espacio (CSIC) y el

Instituto de Estudios Espaciales de Cataluña.

Según Trigo,

además del registro lunar de cráteres, existen otras evidencias del importante

papel que tuvo el impacto de estos objetos. Una de ellas revela que la

composición de la corteza y el manto terrestre, en concreto su abundancia en

metales, tiene su origen en ese proceso de enriquecimiento. “El manto alberga

metales que, de no haber llegado de manera tardía, deberían estar en el núcleo

terrestre. Además, los volcanes emanan gases con anomalías características de

los meteoritos condríticos”, señala Trigo.

Una

atmósfera terrestre inestable

Los investigadores van más allá y

creen que el “gran bombardeo tardío” fue clave para cambiar el destino de la

Tierra, un planeta que hace 3.900 millones de años no era adecuado para la

vida. Aunque la superficie luminosa del Sol era en aquel periodo un 30% menor

que en la actualidad, el flujo de radiación ultravioleta que emitía hacia la

Tierra era mucho mayor.

“Debido a este flujo de un joven

Sol, una atmósfera terrestre rica en nitrógeno molecular hubiese sido inestable.

Esta circunstancia, unida al gran impacto que dio origen a la Luna, hace pensar

que la Tierra pudo perder, quizás varias veces, su atmósfera”, explica al

respecto Javier Martín Torres, que trabaja en el Centro de Astrobiología, un

centro mixto del CSIC y el Instituto Nacional de Técnica Aerospacial.

“La llegada de tales compuestos,

y de partículas metálicas catalizadoras capaces de sintetizar moléculas

orgánicas más complejas bajo el influjo de la radiación solar, permitió

convertir nuestro planeta en el único oasis de vida que, por ahora, conocemos”,

aseguran los autores del estudio.

Fuente: csic.es, 13-5-11

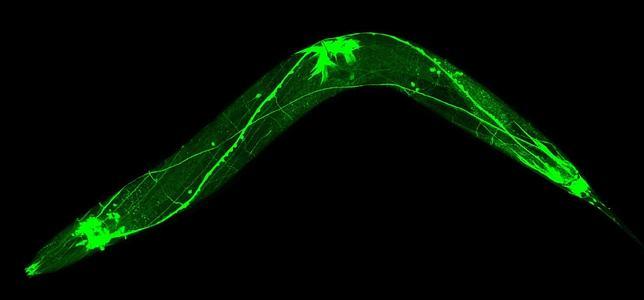

-La dieta que alarga la vida de los gusanos

Los científicos no tienen ninguna duda de que la restricción dietética

prolonga la vida, una vida que, además, resulta más saludable durante más

tiempo. Muchos estudios han demostrado que la limitación de la ingesta de

nutrientes

permite vivir más y mejor a la levadura, los gusanos y las moscas, y

que

pospone las enfermedades relacionadas con el envejecimiento en los ratones.

Sin embargo, este mecanismo, por qué comer menos está relacionado con

la longevidad, todavía desconcierta a los científicos, que están convencidos

de que aquí puede encontrarse

la clave para descubrir nuevas terapias contra enfermedades como el Alzheimer,

el Parkinson e incluso el cáncer.

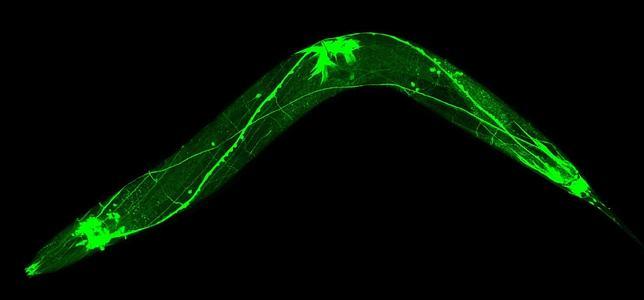

|

Investigaciones con el gusano C. elegans en el

Instituto Buck de Investigación del Envejecimiento han arrojado una

nueva luz sobre el proceso. El secreto se encuentran en un grupo de

moléculas que señalan lípidos llamadas

N-Acylethanolaminas (NAEs), que informan a los animales sobre si han

obtenido muchos o pocos nutrientes y les ayudan a regular su respuesta al

envejecimiento ante los cambios en su dieta. Algunas de estas moléculas

son similares a unas sustancias llamadas

endocannabinoides, que se encuentran en el interior del cuerpo humano,

donde se regulan diversos procesos fisiológicos como la ingesta de

nutrientes y el balance energético. Así,

el vínculo entre los endocannabinoides, la restricción dietética y el

envejecimiento podría ocurrir en distintas especies. El estudio

aparece publicado en la revista

Nature.

«Esta es la pieza que faltaba del rompecabezas. Ahora estamos entrando en

la mecánica del proceso», asegura Matthew S. Gill, responsable de la

investigación. En el estudio, Gill y sus colegas del Instituto Buck

demostraron que la abundancia de las moléculas NAEs en los gusanos se

reducía durante los períodos de restricción de la dieta, y que esa

deficiencia era suficiente para extender la vida útil de los animales. |

|

|

También en los mamíferos

De acuerdo con Gill, la mayoría de las investigaciones sobre la restricción

dietética se han centrado en la identificación de las proteínas y los genes

individuales que funcionan en el proceso. La nueva investigación, por el

contrario, identifica esta nueva pequeña molécula, que señala cómo el gusano

responde a ambientes de alimentos limitados o abundantes.

Los endocannabinoides son activos en casi todos los sistemas en la fisiología

de los mamíferos y, hasta ahora, se les había implicado en