|

|

|

|

|

|

|

|

|

|

![]()

NOTICIAS CIENTÍFICAS

--Nuevas Noticias Próximamente--

![]()

TITULARES DE LAS NOTICIAS DEL MES

Las especies se extinguen 100 veces más rápido de lo natural

Defectos en el universo primitivo

Un panel instalado recientemente en la Estación Espacial se rompe

NEC lanza el superordenador por vectores más rápido del mundo

El cáncer podría tener el mismo origen metabólico que la diabetes o la obesidad

Podría existir más de un universo

Descubierto el animal más viejo del mundo

Nuevo récord de impulso en los motores iónicos

Dos astronautas del Discovery realizan su primer paseo espacial

Descubren rastros de una antigua luna de Saturno en sus anillos

Un campus faraónico sobre el Mar Rojo

Los neandertales eran pelirrojos

El Airbus A380 hace su primer vuelo comercial

China lanza con éxito el satélite que abre su carrera para poner pie en la Luna en 2020

La Estación Espacial Internacional tiene otra pieza

El mapa de nuestras diferencias genéticas

En el 2020 veremos el Ártico sin hielo

La revolución de la nanotecnología

La revolución de la nanotecnología

El "Eureka" de cinco magníficos

La pastilla antisida llega a Europa

Cambio de horario: más molesto que rentable

Por primera vez, una mujer al frente de la Estación Espacial Internacional

Científicos españoles descubren que el cuerpo carotídeo crea células madre convertibles en neuronas

La ley de biodiversidad se echa al mar

Descubren un agujero negro junto a una estrella

Animales en peligro de extinción

Estirpes de ratones noqueados para descifrar sus genes

Microsoft quiere patentar un lector de mentes

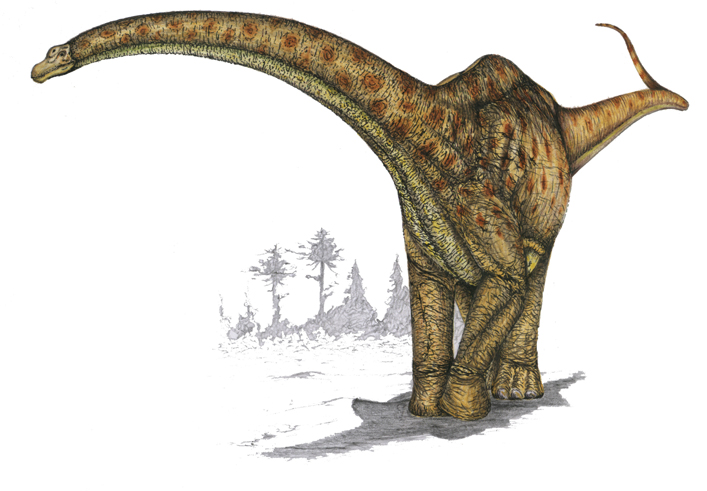

Descubren en la Patagonia argentina una nueva especie de dinosaurio herbívoro

El 90% del proceso tumoral ocurre sin que nos demos cuenta

Un lugar de Marte donde situar una nave terrestre

A la búsqueda de vida extraterreste

La NASA celebra los diez años del lanzamiento de Cassini

Al Gore, Premio Nobel de la Paz

El investigador alemán Gerhard Ertl es el ganador del Premio Nobel de Química

El Nobel de Física premia a los descubridores de la "magneto resistencia gigante"

El Nobel de Medicina va a parar a tres científicos estadounidenses

Craig Venter, el padre del genoma, anuncia que ha logrado sinterizar un cromosoma artificial

Hallan una estrella gemela al sol

Japón lanza un satélite a la Luna

Concedidos los Ig Nobel del año 2007

El agujero de la capa de ozono se reduce un 30% con respecto a 2006

Las células madre de las células óseas potencian la metástasis en el cáncer

Arranca la "guerra del Ártico"

Cuidado, astrónomos, con la energía oscura

Los neardentales llegaron a Siberia

Alcatel Lucent inventa la TV inteligente de banda ancha

El fotón abre una nueva vía en el procesamiento de información

50 años del lanzamiento del Sputnik

-Las especies se extinguen 100 veces más rápido de lo natural

En 1987, la ex primera ministra noruega Gro Harlem Brundtland lanzó la primera gran alerta ecologista. En el informe Nuestro futuro común concluía: "El coste de la pobreza, en sufrimiento humano, en el derroche de los recursos humanos y en la degradación ambiental se ha ignorado enormemente".

Han pasado 20 años, la población ha

aumentado un 34% y la renta per cápita media ha ascendido en casi un 40%. Pero

las cosas no parecen haber mejorado, según el IV Informe mundial sobre el

medio ambiente elaborado por la

Oficina de Naciones Unidas de la

materia. El texto, de 572 páginas y elaborado con colaboración de 1.000

expertos, repasa los grandes problemas del medio ambiente. Estos son tres de los

más importantes.

- Sexta extinción. "Las especies se están extinguiendo a unas

tasas que son 100 veces más rápidas que las observadas a través de los registros

fósiles, debido a los cambios de uso del suelo, la pérdida de hábitat, la

sobreexplotación de los recursos y la expansión de especies invasoras". Desde

los dinosaurios el mundo no ha vivido nada parecido. "Más del 30% de los

anfibios, el 23% de los mamíferos y el 12% de las aves están amenazados", según

la ONU.

A estos factores hay que añadir la pérdida de biodiversidad en los cultivos.

"Sólo 30 tipos de cultivo proporcionan el 90% de las calorías del mundo y 14

especies animales constituyen el 905 de la actividad ganadera del mundo".

- Cambio climático. El cambio climático es uno de los grandes

desafíos de la humanidad. Tanto, que para hacerle frente "las emisiones de gases

de efecto invernadero deberían reducirse en un 50% para 2050 respecto al nivel

de 1990". Según las Naciones Unidas esa es la reducción necesaria para que la

subida media de la temperatura no supere los dos grados centígrados, el nivel a

partir del cual "es posible que se produzca gran daño irreversible". Para ello,

los países desarrollados deberían reducir sus emisiones entre el 60% y el 80%

para 2050. "El objetivo no es presentar un escenario negro y pesimista, sino una

llamada urgente para la acción", señala el estudio, aunque no lo parece.

- Sobreexplotación. El informe incide en una vieja preocupación

ecologista: que el consumo masivo de recursos supera la producción de materias

primas. Es decir, que la humanidad consume cada año más de lo que el planeta

genera. Para ello, en los últimos años se ha desarrollado el concepto huella

ecológica, que mide el consumo equivalente a la producción por la superficie

terrestre. "La población del mundo ha alcanzado un estado en el que la cantidad

de recursos necesaria para mantenerlo supera lo que hay disponible. La huella

ecológica de la humanidad es de 21,9 hectáreas por persona, mientras que la

capacidad biológica de la Tierra es, de media, de sólo 15,7 hectáreas por

persona".

Un 60% de los ecosistemas están sobreexplotados, aunque el mayor abuso se da en

la pesca. Según el estudio la pesca es un claro ejemplo. Actualmente se pesca a

un ritmo casi cuatro veces mayor de lo que pueden soportar los océanos.

Fuente: El País Digital, 31 de Octubre de 2007

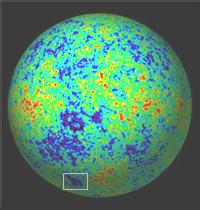

-Defectos en el universo primitivo

En el mapa del cielo

que está haciendo el satélite WMAP se aprecia una gran mancha muy fría en la

radiación más antigua que se puede ver. La descubrieron hace cuatro años unos

físicos españoles y nadie encontró una buena explicación. Ellos, por supuesto,

siguieron dándole vueltas al asunto, estudiando más datos y haciendo más

análisis, y ahora creen que han logrado aclarar el origen de la mancha: se trata

de la huella de algo llamado textura cósmica, una extraña burbuja de energía o,

sencillamente, un defecto del universo primitivo.

"Aunque sea radical,

la hipótesis de la textura es la explicación más plausible de las propuestas

para la mancha", escriben estos investigadores en la revista

Science, donde presentan su trabajo. Si están

en lo cierto, debe haber más defectos cosmológicos en forma de manchas frías o

calientes, la cuestión es descubrirlas.

Inmediatamente después de la explosión inicial, el universo ultracaliente y

ultradenso empezó a enfriarse y a expandirse. Al ir cayendo la temperatura se

produjeron transiciones de fase, algo fácil de comprender si se piensa en la

congelación del agua líquida, cuando se convierte en hielo. Las transiciones de

fase del universo primitivo son más exóticas, pero igual que en el cubito de

hielo se forman irregularidades en el proceso de cristalización de líquido a

sólido, en el cosmos pudieron formarse defectos en las transiciones de fase,

aunque no se había detectado ninguno hasta ahora.

La idea se remonta a hace casi 30 años, cuando unos físicos de partículas

teóricos conjeturaron que en las transiciones de fase del universo ultracaliente

primitivo, a la vez que las fuerzas fundamentales dejaban de estar unificadas,

cuando apenas habían transcurrido unas millonésimas de segundo desde el Big Bang,

se podrían formar esos defectos. Pero no se detectó algo así en el cosmos.

Ahora, los investigadores del

Instituto de

Física de Cantabria (IFCA) Marcos Cruz,

Patricio Vielva y Enrique Martínez, junto con dos colegas británicos, han

rescatado esa conjetura porque encaja muy bien con lo que ellos habían observado

en el cielo: el defecto, la textura, dejaría una huella en forma de gran mancha

de mayor o menor temperatura -en este caso menor- que la media de la radiación

de fondo que mide WMAP.

El universo primitivo estaba demasiado caliente para que se formaran átomos y

para que se emitieran los fotones de la luz. No fue hasta unos 380.000 años

después de la explosión inicial cuando el cosmos, expandiéndose y enfriándose,

alcanzó una temperatura suficientemente baja para que se unieran electrones y

protones formando primeros átomos de hidrógeno y empezando los fotones de la luz

a circular libremente. El cosmos, en ese momento, se hizo transparente. El símil

de la piscina de agua hirviendo llena de burbujas que se enfría y, al alcanzar

una temperatura inferior al punto de ebullición del agua, se hace transparente,

es un símil útil.

Lo que el WMAP mide es la radiación del universo emitida en aquel momento,

380.000 años después de la explosión inicial o, lo que es lo mismo, hace 13.500

millones de años. Es la radiación -muy fría- más antigua que se puede ver, ya

que antes el universo era opaco. Se descubrió en 1965.

"Esta radiación, que se observa ahora en todas las direcciones del cielo a una

temperatura de unos 270 grados centígrados bajo cero, representa la mejor prueba

de un pasado denso y caliente del universo en el que los átomos estaban

divididos en sus componentes más elementales. Este escenario cosmológico es lo

que denominamos comúnmente como Big Bang", explica Martínez.

Esa radiación de fondo, que parecía uniforme, resultó no serlo cuando se

lograron desarrollar sensores suficientemente sensibles para detectar minúsculas

variaciones de temperatura, pequeñas irregularidades que servirían para explicar

por qué ahora la materia no está uniformemente repartida por el cosmos sino

agrupada formando conjuntos de galaxias, galaxias, estrellas y planetas. Y WMAP,

más sensible que su predecesor COBE, también de la

NASA,

está haciendo un mapa de alta precisión de esas ligeras variaciones de

temperatura.

"Hace unos cuatro años, un grupo de investigadores del IFCA descubrimos la

presencia de una mancha muy fría y muy grande en el mapa de todo el cielo

producido durante el primer año de funcionamiento de WMAP, algo que había pasado

desapercibido para el propio equipo científico responsable del satélite",

recuerda Martínez.

La mancha es realmente grande, unos 10 grados de diámetro -la Luna mide medio

grado en el cielo- y su origen era un misterio. La explicación aparentemente más

sencilla la propusieron unos científicos estadounidenses: es un gran vacío

cósmico, una región del cielo donde no hay galaxias.

Pero a los físicos de Cantabria no les cuadraba este gran vacío con su mancha

fría, que seguían estudiando. "Sería un vacío de proporciones descomunales (de

varios cientos de millones de años luz de diámetro)", dicen, "y en total

contradicción" con la teoría estándar del Big Bang. "La explicación de la mancha

como un gran vacío no es otra cosa que solucionar un problema creando otro

problema", afirma Martínez. Sin embargo, la hipótesis del defecto, de la textura

cósmica, encaja mucho mejor con los datos de la mancha fría, dicen Cruz y sus

colegas.

La idea es que en aquella remota transición de fase de la materia y radiación

del universo primitivo (como en la cristalización imperfecta del cubito de

hielo), se formarían unos objetos tridimensionales, como unas burbujas de

energía, cuya huella sería identificable en la luz del universo cuando éste se

hizo transparente. "Dentro de una de esas burbujas, los campos energéticos que

forman la textura están enmarañados", explica Cruz. "Las texturas y otros

defectos deberían ser detectables como variaciones de temperatura en la

radiación de fondo cósmico de microondas [lo que detecta el WMAP]".

¿Por qué detecta el sensor del satélite la huella de esa burbuja de energía

enmarañada? Porque la radiación, la luz fría del fondo de microondas, siente su

efecto gravitatorio al pasar cerca, efecto que ve el satélite en forma de mancha

fría, contesta Martínez. La teoría indica que se formarían no uno, sino muchos

defectos, fríos y calientes; los científicos están buscándolos.

Los propios autores de la investigación publicada en Science, así como otros

expertos, advierten de que la cuestión no está zanjada. "Aunque el origen de la

mancha fría no está totalmente demostrado, este hallazgo podría aportar nuevos

puntos de vista sobre la infancia del universo", dice Cruz.

Su colega Neil Turok, de la

Universidad de Cambridge (Reino Unido) añade:

"Será muy interesante ver si esta explicación se confirma en los próximos años.

Si es así, las implicaciones serán extraordinarias porque las propiedades del

defecto proporcionarán una ventana absolutamente única abierta hacia la

unificación de las partículas y las fuerzas", unificación que se rompería en

aquella transición de fase a la vez que se formarían las texturas en el universo

primitivo enfriándose.

"El futuro satélite Planck de la

ESA, que medirá el cielo

de microondas con mayor precisión que WMAP y cuyo lanzamiento está previsto para

julio de 2008, podrá confirmar la presencia de ésa y otras texturas en el

universo", señala Vielva.

Fuente:

elpais.com, 31 de Noviembre de 2007

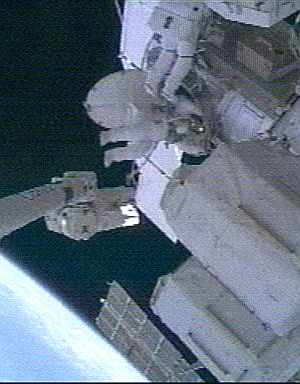

-Un panel instalado recientemente en la Estación Espacial se rompe

El panel solar que estaba siendo desplegado de una viga, instalada recientemente, en la Estación Espacial Internacional (ISS) se rompió ayer, obligando a la NASA a suspender la operación y poniendo en duda los planes de expansión de la base orbital.

Parte del extenso panel con forma de ala se veía roto y arrugado en imágenes de televisión obtenidas desde el espacio.

Brecha abierta en el panel solar

La NASA había dicho que el despliegue del conjunto de paneles era crítico para proveer de electricidad a los laboratorios europeos y japoneses, cuya llegada a la estación comenzaría en diciembre, operación que se había retrasado ya después de que se hubiera averiado el mecanismo que hace rotar otro panel solar.

Los astronautas de la estación detuvieron el despliegue del panel cuando detectaron el daño, e indicaron que el brillo del sol les había impedido verlo con anterioridad.

"Parecía como si el daño hubiera aparecido repentinamente", dijo Pamela Melroy, comandante del transbordador espacial 'Discovery', que se encuentra acoplado en la ISS.

Los ingenieros de la NASA en la base de control de la misión en Houston dijeron a los astronautas que registren fotos del daño para estudiarlo en Tierra y les indicaron que replegaran parcialmente el panel para reducir la tensión en la rotura.

De momento, no se ha anunciado cual será el siguiente paso de la NASA, pero funcionarios dijeron el pasado lunes que si había problemas desplegando el panel, los astronautas que habían planeado revisar el mecanismo de rotación ya averiado deberían trabajar en el panel solar.

El contratiempo empaña lo que había sido un día exitoso para los astronautas, quienes instalaron previamente en la estación la viga de 17,5 toneladas en la cual estaba almacenado el panel.

La viga fue colocada con la ayuda de los caminantes espaciales Scott Parazynski y Douglas Wheelock, quienes guiaban el brazo robótico manejado por Daniel Tani y Stephanie Wilson.

El dispositivo había estado encima de la estación por siete años esperando ser ubicado en su posición permanente. "Se ve bien, hombre del espacio", decía uno de los caminantes espaciales mientras realizaban la tarea.

Una vez que la viga estuvo instalada, la mitad del conjunto de paneles solares, integrado por dos paneles separados y de 73 metros de longitud cuando está completamente extendido, fue desplegada sin dificultad. El problema ocurrió cuando la otra mitad estaba siendo extendida.

Este se suma a los problemas de energía de la estación, después de que la NASA desactivara el domingo uno de los dos ensamblajes rotarios de tres metros de la estación que permiten al conjunto de paneles apuntar hacia el Sol para producir electricidad.

El ensamblaje, instalado en junio, ha estado activo por dos meses. Tani encontró virutas de metal dentro del mecanismo el domingo durante una caminata espacial. La viruta indicó que las partes móviles de metal se están gastando, lo que hizo que la NASA extendiera en un día la estancia del transbordador 'Discovery' en la ISS para que Parazynski y Wheelock puedan inspeccionar de cerca el ensamblaje durante una caminata espacial de mañana y determinar qué reparación se necesita llevar a cabo.

Fuente: elmundo.es, 31 de Octubre de 2007

-NEC lanza el superordenador por vectores más rápido del mundo

La compañía japonesa NEC afirmó que ha lanzado el superordenador de vectores más rápido del mundo, el modelo SX-9, con una velocidad de procesamiento de datos de 839 TFLOPS, según informó la agencia de noticias Kyodo.

El ordenador de NEC, una computadora equipada de procesadores

de vectores que podrá emplearse para propósitos científicos o técnicos,

realizará 839 trillones de operaciones por segundo.

Este tipo de ordenadores se emplean en computación compleja y de gran escala

para sistemas como la climatología, la aeronáutica o el estudio del espacio,

además de simulaciones medioambientales o dinámicas de fluidos.

El modelo SX-9 ocupa un cuarto del espacio y consume un cuarto de la energía que

los superordenadores convencionales.

NEC comenzará a exportar el producto en marzo, que se distribuirá por el sistema

de 'leasing' (arrendamiento financiero con opción a compra) a cambio de casi

tres millones de yenes la unidad (unos 26.270 dólares).

La empresa prevé vender 700 unidades en los próximos tres años.

Fuente: EFE, 30 de Octubre de 2007

-El cáncer podría tener el mismo origen metabólico que la diabetes o la obesidad

Hasta ahora se pensaba que las células tumorales consumían

más energía que las sanas debido a que se dividen mucho más rápidamente. Sin

embargo, una investigación española aporta nuevos datos que podrían darle la

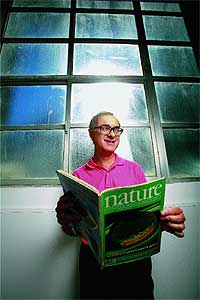

vuelta a la tortilla. Según publica esta semana la revista 'Nature

Reviews Cancer', las alteraciones metabólicas no son una consecuencia del

cáncer, sino que podrían ser la causa del tumor.

Como explica a elmundo.es Javier Menéndez, coordinador de la

Unidad de Investigación Traslacional del

Instituto Catalán de

Oncología (ICO) en Girona y principal autor de esta investigación, este

estudio aporta nuevos datos a un debate que se inició hace casi un siglo y que

ha estado un poco olvidado por parte de la comunidad científica.

Las pruebas radiológicas, por ejemplo, emplean la glucosa para marcar las

células cancerosas porque se sabe que éstas la consumen en grandes cantidades y

permite 'verlas' con más facilidad. "Sin embargo, nadie ha pensado que, al

contrario, esa alteración del metabolismo de los ácidos grasos pueda ser una

causa y no una consecuencia".

En trabajos de laboratorio con células de mama sanas, el equipo de Menéndez ha

logrado reconstruir el proceso tumoral, remontarse a la fase en la que las

células empiezan a dividirse anómalamente. "En ese momento", explica el

investigador, "las células malignas viven en unas condiciones de estrés

ambiental, les falta oxígeno, el medio que les rodea es muy ácido...".

Convertir azúcar en ácidos grasos

En ese medio hostil, las células cancerosas son capaces de activar una enzima

que les permite seguir siendo metabólicamente independientes. Es decir, seguir

nutriéndose. Esa enzima es la sintasa de los ácidos grasos (SAG), una proteína

capaz de convertir los azúcares de la dieta en ácidos grasos, en grasa endógena.

En las personas sanas, la mayoría de los tejidos prefieren utilizar los ácidos

grasos que provienen directamente de la dieta (exógenos), y por tanto la

actividad de la enzima SAG es muy baja. "Sólo en la lactancia se activa SAG de

manera controlada porque el niño necesita ácidos grasos en esa etapa de su vida

y la glándula mamaria se encarga de producirlos", añade Menéndez.

En sus trabajos con cultivos celulares, Menéndez y los suyos observaron que con

sólo activar esa enzima en células sanas de la mama bastaban unas pocas horas

para que se 'despertasen' una serie de genes claves en el proceso tumoral, como

el conocido HER2. "Estamos muy lejos aún de disponer de fármacos muy

específicos, capaces de actuar contra SAG cuando éste se descontrole", admite el

investigador, "pero sí sabemos que en el caso del cáncer de mama hay algunos

subtipos de tumores que son muy lipogénicos". Es decir, muy dependientes de los

ácidos grasos y de esta vía metabólica.

Además, reconoce que uno de los puntos más interesantes de este trabajo es que

abre la puerta a utilizar fármacos que ya están en el mercado, contra la

obesidad o la diabetes tipo 2, para luchar contra el cáncer de mama en

combinación con otros antitumorales. "Lo mires por donde lo mires", apunta, "los

ácidos grasos tienen un papel clave en el origen del cáncer". Bien sean los de

tipo exógeno, como ya se ha demostrado al relacionar una dieta rica en grasas

con mayor riesgo tumoral; o bien los de tipo endógeno, como apunta este estudio.

De hecho, Javier Menéndez, que ya demostró el potencial anticancerígeno del

aceite de oliva sospecha que las grasas 'buenas' de este ingrediente, en

realidad funcionan engañando a SAG. Es decir, "el ácido oleico del aceite de

oliva apaga esta factoría y les dice a las células malignas que no utilicen los

ácidos grasos endógenos, sino esta grasa exógena, que es buena".

Fuente: elmundo.es, 29 de Octubre de 2007

-Podría existir más de un universo

Cosmólogos norteamericanos han detectado lo que podrían ser las huellas de otro universo que colisionó con el nuestro poco después del Big Bang. Estos investigadores señalan que la existencia de otros universos podría demostrarse gracias a la medición de la radiación de fondo de microondas, ya que, si en el inicio de nuestro universo, éste hubiera colisionado con otros universos, hipotéticamente tal choque quedaría registrado en la distribución de dicha radiación. Hasta ahora nadie ha intentado buscar dicha irregularidad, pero los autores de este estudio han encontrado al menos una llamativa asimetría anómala en el cosmos que, aunque no se atreven a afirmar que se trata de la huella de otro universo, consideran que esta hipótesis puede ser el comienzo de un largo proyecto de investigación

|

Si existen otros universos aparte del nuestro, éstos podrían ser detectables, predicen científicos en un nuevo estudio cuyos resultados han sido publicados en la revista Physical Review D. En este estudio, Matthew C. Johnson y sus colaboradores, Anthony Aguirre y Assaf Shomer, de la universidad de California en Santa Cruz, explican que han evaluado la posibilidad de que existan algunos efectos observables o “marcas” distinguibles que otros universos hubieran dejado en el nuestro, debido a colisiones entre ellos acaecidas en la época en que nuestro universo era aún muy reciente. La idea de que existen otros universos es controvertida en la cosmología actual. Si realmente existieran, lo más probable es que no sean perceptibles y sería muy difícil probar su existencia. Lo que aporta el nuevo estudio es la hipótesis de que, si realmente existieron otros universos que colisionaron con el nuestro, hipotéticamente podríamos hoy detectar su presencia, lo que en opinión de los autores de este estudio constituye un trascendental descubrimiento. Al mismo tiempo, estos investigadores reconocen que las consecuencias de esa eventual colisión entre universos continúan siendo una cuestión abierta, ya que, aunque se considera que si hubo colisión entre universos ambos habrían sido destruidos, lo que proponen estos científicos es una nueva aproximación. |

Johnson ha declarado al respecto a la revista

World Science que aún

queda por definir qué tipo de secuelas habría que buscar para confirmar el

choque entre los universos. Algunas teorías físicas señalan que realmente

existen otros universos, llamados

universos burbuja y que

cada uno de ellos tiene sus propias características e incluso valores diferentes

de las constantes físicas.

Demostrar la transmultiversalidad

Tras la idea de los universos burbuja subyace la hipótesis de que,

aparentemente, el espacio entero contiene energía, la llamada

energía del vacío, que es

una energía de fondo de origen puramente cuántico y responsable de efectos

físicos mensurables, como el

efecto Casimir (fuerza

física ejercida entre objetos separados debido a la resonancia de los campos

energéticos en el espacio entre los objetos).

Algunos cosmólogos han propuesto que, si se dan ciertas circunstancias, esta

energía puede crecer de manera explosiva dando lugar a un nuevo universo –como

ocurrió con el nuestro-. Esto podría estar sucediendo continuamente, generando

muchos universos que coexistirían con el que conocemos de la misma forma que

coexisten las burbujas en un baño espumoso.

Analizar la radiación del fondo cósmico

¿Pero cómo saberlo? Johnson y sus colegas creen que cualquier encuentro o

colisión entre los universos habría producido efectos que se propagarían en

ambas direcciones. Dichos efectos quizá dejaran huellas en la forma de material

expelido, que podrían afectar a la distribución de la materia en cada universo

afectado.

Si un tipo de colisión así hubiera acontecido recientemente, desde la

perspectiva temporal de nuestro universo, resultaría indetectable dado que el

universo es demasiado extenso como para que se vea notablemente afectado. Sin

embargo, si los hechos ocurrieron hace mucho tiempo, es decir, cuando el

universo era aún muy pequeño, la marca podría ser aún visible al haberse

expandido.

Cuando el universo medía aproximadamente menos de una milésima parte de lo que

mide actualmente, se cree que sufrió una transformación. Según se fue

expandiendo, se enfrió lo suficiente como para que se formaran los átomos.

Entonces se volvió transparente.

Antes de esto, el universo había consistido en una espesa niebla con pequeñas

variaciones de densidad en diversos puntos. Las partes más densas siguieron

aumentando y al unirse dieron lugar a las galaxias.

Investigaciones pendientes

Pero esta niebla es aún visible porque muchas de las ondas lumínicas que se

produjeron en ese momento en ella nos llegan ahora y son observables en la forma

de un débil resplandor que llena universo por completo.

Estas ondas han sido denominadas

radiación de fondo de microondas,

que es una forma de radiación electromagnética considerada por muchos cosmólogos

como la prueba principal del modelo cosmológico del Big Bang que diera lugar al

universo. Esta radiación es asimismo considerada el borde de nuestro universo

conocido.

Los astrónomos plantean que una colisión entre universos podría haber generado

un patrón que habría reordenado las fluctuaciones de densidad en estas

circunstancias y que, si pudiera registrarse dicha reordenación, aparecería como

un área de irregularidad simétrica.

Hasta ahora nadie ha intentado buscar dicha irregularidad, pero los autores de

este estudio han encontrado al menos una llamativa asimetría anómala en el

cosmos que , aunque no se atreven a afirmar que se trata de la huella de otro

universo, consideran que esta hipótesis puede ser el comienzo de un largo

proyecto de investigación.

El caso es que las variaciones de temperatura en el fondo cósmico de microondas

se cree que reflejan las variaciones de densidad en el universo primitivo, pero

aún quedarían por hacer numerosas investigaciones para poder llegar a una

respuestas.

Fuente: Tendencias21, 28 de

Octubre de 2007

-Descubierto el animal más viejo del mundo

Una almeja islandesa podría ser el animal más longevo del mundo

| Según un equipo de científicos de la

Universidad de Bangor en el País de Gales, el molusco (una almeja de

Islandia) tiene entre 405 y 410 años y podría ofrecer algunas claves para

entender la longevidad. Los investigadores calcularon la edad de la almeja

por los anillos que aparecen en su concha.

Según el Libro de Récords de Guinness, el animal más viejo que se había encontrado hasta la fecha era otra almeja de la misma variedad que encontraron en 1982, cuando tenía 220 años. Extraoficialmente, hace algún tiempo se descubrió que otra almeja que se conserva en un museo de Islandia tenía 374 años. Pero la almeja más reciente a la vez es la más antigua. La llaman Ming por la dinastía china que estaba en el poder cuando nació, y estaba en su infancia cuando Isabel I llegó al trono y cuando Shakespeare y Cervantes escribían sus obras. |

Almeja Ming |

El profesor Chris Richardson, de la escuela de Ciencias Oceanográficas de la Universidad de Bangor, dijo a la BBC que los incrementos de crecimiento de la almeja "ofrecen un registro de cómo ha variado la tasa de crecimiento del animal de un año a otro".

Los cambios, señaló el profesor dependen del clima, la temperatura del agua del mar y la alimentación del molusco.

Viendo a los animales "se puede reconstruir el ambiente en el que crecieron, porque son como grabadoras diminutas en el lecho del océano que integran señales sobre la temperatura y la alimentación en un período específico".

Según el profesor Richardson, el descubrimiento de Ming podría arrojar luz sobre las razones por las que hay animales que viven vidas extraordinariamente longevas.

"Lo que intriga al grupo de Bangor es cómo han logrado estos animales evitar la senectud", indicó el académico.

"Pensamos que una de las razones es que los animales tienen una tasa diferente de renovación celular que asociaríamos con otros que viven vidas mucho más cortas", señaló.

La universidad recibió fondos de la organización británica caritativa Help The Aged (Ayuda a los Ancianos) para su investigación.

Fuente: BBC Mundo, 28 de Octubre de 2007

-Nuevo récord de impulso en los motores iónicos

Un motor iónico ha batido el récord de empuje total en una prueba realizada por la NASA. El éxito en los test de prueba del motor podría ser utilizado en futuras misiones de la NASA. Los motores iónicos funcionan acelerando átomos cargados eléctricamente, es decir, iones, a través de un campo eléctrico, lo que empuja la nave espacial en la dirección opuesta

El impulso que proporcionan, en un instante dado es muy pequeño, aproximadamente igual a la fuerza necesaria para mantener una hoja de papel en contra de la gravedad de la Tierra. Pero pueden funcionar continuamente en el espacio durante años utilizando muy poco combustible. Así, en última instancia, proporcionar un impulso mucho mayor que un cohete químico.

|

Esquema de un motor iónico |

Esta es la trayectoria de la sonda Dawn en su viaje hacia el cinturón de asteroides |

Motor iónico en funcionamiento en los laboratrios de la NASA |

La misión Dawn, que se inició el jueves, está equipada con

la primera generación de los motores iónicos de la NASA, llamado NSTAR. Dawn

posee tres motores NSTAR que le permitirá llegar al cinturón de asteroides y

colocarse en órbita en torno a dos diferentes asteroides.

La agencia también ha realizado test

sobre un motor iónico más avanzado, el llamado “NASA Evolutionary Xenon Thruster”

(NEXT), que genera 2,5 veces más impulso que el motor NSTAR.

Ahora, NEXT ha roto un récord, proporcionando un mayor “cantidad total de

impulso” que cualquier otro motor iónico anterior. El “total de impulso” es una

medida de la aceleración que un motor le proporcionaría a una nave espacial. Es

el resultado de multiplicar el empuje del motor por la cantidad de tiempo que

puede estar encendido.

Record de combustible

El motor NEXT ya ha estado funcionando de continuo durante más de 12.000 horas

(500 días), proporcionando más de 10 millones de Newton segundos de impulso, más

de lo que cualquier otro motor iónico ha logrado.

Durante este tiempo, se ha suministrado más de 245 kilogramos de combustible en

forma de gas xenón, una cifra récord para un motor de iones. La cantidad de

combustible que se puede suministrar antes de que se desgaste el motor es

fundamental, ya que los motores iónicos en las naves espaciales necesitan

funcionar de continuo durante años.

Las estimaciones anteriores habían

sugerido que NEXT podría consumir con seguridad 450 kilogramos de combustible en

su vida. NSTAR está pensado sólo para 150 kilogramos de combustible, aunque un

motor NSTAR consumió 235 kilogramos de combustible en una prueba anterior.

"Esta prueba valida la tecnología NEXT para una amplia gama de misiones de

exploración del sistema solar de la NASA, así como potencial de empresas

comerciales tierra-espacio", dice Mike Patterson investigador principal de NEXT,

del Glenn Research Center de la NASA en Cleveland, Ohio, EE.UU.

NEXT podría realizar una misión a Titán, la luna de Saturno. Se requerirían

alrededor de 20 kilovatios de potencia en caso de que la misión incluyera tanto

un vehículo orbital como un aterrizador (lander). "Podemos hacer esto con una

serie de tres impulsores, además de uno de repuesto," dijo Scott Glenn Benson

director del proyecto NEXT a New Scientist.

La Guerra de las Galaxias

Aunque ambos NSTAR y NEXT usan gas xenón como propulsor, NEXT acelera iones de

xenón de manera más eficiente, proporcionando hasta 236 milliNewtons de empuje

en comparación con NSTAR que alcanza como máximo 92 mN. Los motores de iones

usados en la nave espacial japonesa Hayabusa hacia el asteroide Itokawa

proporcionaban 22 mN, mientras que los que utilizaron en la Agencia Espacial

Europea para el SMART - 1, la sonda lunar, consiguieron los 70 mN.

NEXT también puede variar su empuje en una escala de 1 a 11, en comparación con

NSTAR cuya escala es del 1 al 5. Esto significa que el regulador puede bajar a

niveles inferiores, lo que le permite operar a una mayor distancia que NSTAR, ya

que, viajar a más distancia del Sol supone recibir menos luz solar.

Aunque los motores de iones acaban de empezar a ser de uso regular en las sondas

científicas, han sido ya muy descritos el la ciencia ficción durante muchos

años. Marc Rayman ingeniero de la nave espacial Dawn del Laboratoriuo de

Propulsión a Chorro de la NASA en Pasadena, California, EE.UU., recordó a los

periodistas, en una reciente conferencia de prensa, que los motores iónicos son

los utilizados en las películas de “la Guerra de las Galaxias”.

"Si recordamos los cazas TIE que Darth Vader y el Imperio del Mal utilizan para

luchar contra la alianza rebelde, TIE es el acrónimo de “dos motores de iones” (Twin

Ion Engines),” dijo. Y añadió "Bueno, Dawn utiliza mejores motores que los cazas

TIE de Star Wars porque utilizan tres motores de iones."

Fuente: sondasespaciales.com, 26 de Octubre de 2007

-Dos astronautas del Discovery realizan su primer paseo espacial

Los astronautas estadounidenses Scott Parazynski y Douglas Wheelok, tripulantes del Discovery, han realizado el primer paseo espacial de la actual misión del transbordador, acoplado desde ayer a la Estación Espacial Internacional (ISS).

Los dos astronautas permanecieron fuera de la plataforma orbital cerca de seis horas y media, informó el representante de la NASA en el Centro de Control de Vuelos Espaciales de Rusia, Serguéi Puzanov, citado por la agencia Interfax.

Parazynski y Wheelok efectuaron los primeros trabajos para instalar en la ISS el módulo presurizado 'Harmony', de fabricación italiana, que llegó al laboratorio espacial en la bodega del transbordador, y un nueva antena.

El 'Harmony', que pesa casi 16 toneladas se ha instalado de manera provisional en un muelle del módulo estadounidense Unity.

Una vez que el transbordador se separe de la estación orbital, 'Harmony' será llevado hasta su posición permanente en el extremo del laboratorio estadounidense Destiny.

Allí, el Harmony servirá de eje para la instalación futura del módulo japonés Kibo y el módulo Columbus de la Agencia Espacial Europea.

La misión del 'Discovery', al mando de Pamela Melroy, ha sido planificada con una duración de 14 días e incluye cinco jornadas de labores en el espacio exterior.

El laboratorio europeo 'Columbus', un cilindro de 4,5 metros de diámetro por ocho de largo, tiene previsto viajar a bordo del transbordador 'Atlantis' en diciembre. Con un coste de 880 millones de euros, será la aportación europea más importante a la ISS, y podrá albergar simultáneamente a tres astronautas.

La Agencia Espacial Europea (ESA) acaba de anunciar que sus técnicos ya han cerrado la compuerta del 'Columbus', lo que significa que todo está listo en su interior y ya sólo queda esperar a que llegue su turno de subir a la órbita terrestre.

El módulo 'Harmony', o Nodo 2, será el pasillo que conecte a la parte estadounidense con las zonas europea y japonesa. Dado que éstos serán los dos únicos lugares de la ISS diseñados específicamente para la ciencia, y que la cooperación internacional es la principal razón de ser de la Estación, su importancia resulta evidente. Tal y como asegura su comandante, «es una misión guay [cool]».

Fuente: elmundo.es, 26 de Octubre de 2007

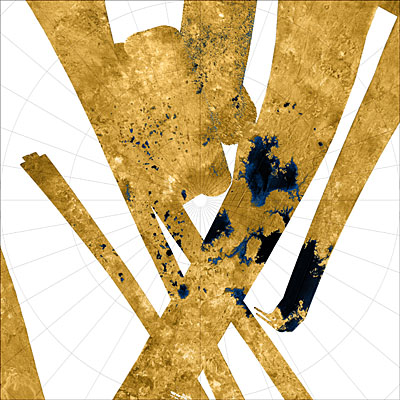

-Descubren rastros de una antigua luna de Saturno en sus anillos

|

Los anillos de Saturno están formados por infinidad de fragmentos de hielo y roca, algunos más pequeños que un grano de arena y otros del tamaño de una casa, pero los científicos aún no están de acuerdo sobre su procedencia. Unos dicen que se formaron al mismo tiempo, y procedentes del mismo material, que dio origen al planeta. Otros aseguran que proceden de grandes lunas que, tras ser destruidas, dejaron orbitando sus restos alrededor de este gigante gaseoso. Los nuevos resultados de la sonda ‘Cassini’, de la NASA, apoyan esta última versión. Al menos un antiguo satélite natural de Saturno, según publica en su última edición la revista ‘Nature’, ha contribuido a formar el más exterior de los siete anillos que adornan el planeta. En realidad, la nave espacial no ha obtenido imágenes directas de estos fragmentos, sino de unas irregularidades ondulatorias –en otras palabras, unos agujeros en la estructura del anillo- que tienen forma de hélice y que serían, según los expertos, la estela dejada por los pedazos de luna rota a su paso por la órbita de Saturno. Estas rocas, a juzgar por la huella que dejan, tendrían un diámetro de unos 100 metros, tal y como predice la teoría de que proceden de una colisión y no comparten origen con Saturno. «Probablemente hubo una gran luna, de al menos 32 kilómetros de diámetro o mayor, orbitando en aquel lugar», explica el astrónomo Miodrag Sremcevic, de la Universidad de Colorado en Boulder (EEUU). «Esta luna tuvo el desafortunado destino de ser golpeada por un gran meteorito o cometa que la partió en pedazos. Y lo que vemos ahora son los cascotes de esa luna», señaló a la agencia Reuters este investigador, uno de los autores del estudio. La luna rota habría sido un cuerpo gaseoso, como el propio Saturno, de un tamaño y características similares a los de la actual Pan, el más interior de los más de 30 satélites que posee este planeta. La colisión que la destruyó se produjo, según los científicos, hace alrededor de 100 millones de años. Es decir, mucho después de que se formara Saturno, que tiene unos 5.000 millones de años de edad |

|

Fuente: elmundo.es, 26 de Octubre

-Un campus faraónico sobre el Mar Rojo

El objetivo de la

King Abdullah University of

Science and Technology (Kaust) es convertirse en uno de los mejores centros

para realizar descubrimientos científicos y trabajar en el desarrollo humano en

Arabia Saudita.

Fuentes de la Universidad aseguran que la intención de este proyecto es

centrarse en las investigaciones que permitan aplicar la ciencia y la tecnología

en temas que afectan a las necesidades humanas y al desarrollo social y

económico. El modelo académico de la Kaust se ha estructurado en cuatro

institutos de investigación, cada uno de ellos con centros dedicados a un

conjunto específico de asuntos. Las cuatro áreas principales serán: recursos,

energía y medio ambiente; biociencias y bioingenierías; ingeniería y ciencias de

materiales; y matemáticas aplicadas y ciencias informáticas.

La Kaust va a ser un centro con ambiente verdaderamente internacional que

contratará a los mejores catedráticos y alumnos para investigaciones. No

ofrecerá puestos permanentes, y los contratos serán renovables o con una

duración de entre dos y cinco años. El alumnado será diverso e internacional,

formado por estudiantes con expediente académico brillante', comentan fuentes de

la universidad.

El claustro de profesores comenzará a organizarse en 2008, pero la intención de

los responsables del proyecto es contar con personalidades del mundo de la

investigación de prestigio internacional. La inversión será multimillonaria y la

universidad será dirigida y financiada, afirman fuentes de la entidad, 'por un

consejo de administración independiente'.

En lo que respecta a los aspectos religiosos o a la cuestión de sexo, en un país

cuyo sistema político es una monarquía autoritaria que se rige por la ley

islámica, fuentes de la universidad sostienen que 'no será obligatorio practicar

la religión islámica' y que el acceso a las mujeres 'estará permitido'. 'Los

estudiantes que entren a formar parte de la Kaust se encontrarán en centro

internacional donde lo único importante es su potencial y su expediente

académico independientemente de su sexo y religión', apuntan las mismas fuentes.

El proyecto ha sido concebido por el Rey Abdullah, guardián de las dos santas

mezquitas, quien eligió al Ministro de Petróleo Ali Ibrahim Al-Naimi para llevar

la dirección del desarrollo de la universidad. 'La Kaust es la idea que ha

perseguido durante décadas su Majestad el Rey Abdullah: crear una universidad de

primera clase en Arabia Saudí, dedicada a reunir los mejores talentos para

desvelar los grandes misterios científicos y tecnológicos para el progreso de

toda la humanidad', afirmó el ministro.

El Presidente en funciones de la Kaust, Nadhmi Al-Nasr, destacó también que,

mientras que la futura universidad se encuentra físicamente en Arabia Saudí y

ofrece sus servicios a los ciudadanos del Reino, también nace con la intención

de convertirse en una institución internacional.

Alianzas internacionales de calidad

Uno de los puntos fuertes de esta nueva universidad consistirá en las

importantes alianzas con centros de prestigio internacionales. En los 12 meses

que este proyecto ha estado en proceso de desarrollo, ya se han establecido

alianzas con algunas instituciones investigadoras internacionales, incluyendo

acuerdos formales con la

Woods

Hole Oceanographic Institution en los EE UU, el

Indian Institute of Technology

de Bombay, India; el

Institut

Français du Pétrole en Francia, la

National University de

Singapur, y la

American

University en El Cairo. Estas relaciones se establecieron para potenciar la

innovación y para reunir los mayores talentos del mundo en ciencia y tecnología.

La universidad establecerá colaboraciones con dichas instituciones al igual que

con empresas privadas del sector de la investigación científica y tecnológica.

Fuente: Cinco Días, 25 de Octubre de 2007

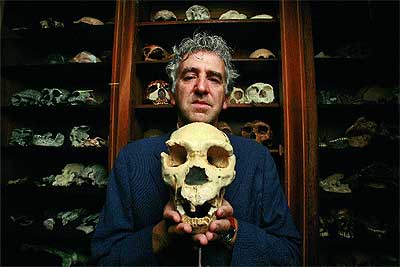

-Los neandertales eran pelirrojos

Los neandertales eran pelirrojos y de piel clara, como algunos humanos modernos que hoy habitan el hemisferio norte del planeta, según una investigación.

Este es el primer rasgo físico que se conoce de estos humanos, desaparecidos hace unos 25.000 años, que no se puede adivinar por los fósiles de sus huesos. Y se debe a una mutación genética en el gen MC1R, descubierta por el investigador español Carles Lalueza-Fox, de la Universidad de Barcelona.

Lalueza-Fox, que también participó en el hallazgo del gen FOXP2, que compartían con nosotros, explica que esta variación del MC1R no la tiene el 'Homo sapiens' moderno, que ha llegado al mismo resultado por otro camino genético, pero fruto de la misma evolución tras su llegada al hemisferio norte.

Los neandertales fueron pelirrojos. La evolución hizo que

nosotros también desarrollásemos ese color de pelo

El hallazgo, publicado hoy en la revista 'Science' fue posible por la recuperación de este receptor 1 de la melanocortina de un fósil de hace 43.000 años procedente de la cueva de El Sidrón (Asturias) y otro de hace 50.000 años procedente de la cueva de Monte Lessini (Italia). "Hay dos pigmentos y el gen MC1R regula ambos interaccionando con una proteína. Si funciona de forma correcta, se sintetiza el castaño y si hay mutación, se sintetiza el rojizo", explica el investigador catalán.

El siguiente paso fue comprobar que efectos podía tener esta mutación en el pelo y la piel de los neandertales, puesto que no existe igual en los humanos modernos. Para ello, en el Instituto Max Planck de Alemania, cultivaron células de la piel y las injertaron el gen mutado. "Enseguida se comprobó que comenzaba a sintetizarse la feomelanina, que es la proteína de los pelirrojos", comenta Lalueza-Fox.

Este fenómeno, explica, "cuadra totalmente con la lógica evolutiva". "Nuestros antepasados venían de África y conservaban el gen que les protegía de la radiación solar. Al salir hacia Europa, donde el sol no es tan intenso, ese control genético se relaja y, por selección natural, triunfó esta mutación", añade.

Curiosamente, fue algo que ocurrió, por primera vez, con los neandertales, hace medio millón de años. Posteriormente, los 'Homo sapiens' modernos, hace unos 40.000 años, volvieron a obtener el mismo aclaramiento de la piel y del pelo con otra mutación que daba el mismo resultado.

El investigador cree que localizó el MC1R por suerte. «Lo iba buscando, pero realmente no sabía lo que me iba a encontrar. No hay que olvidar que hay un millón de mutaciones genéticas entre nosotros y los neandertales, de los 3.000 millones de nucleótidos que tenemos. Este es la primera que se encuentra», explica.

A partir de ahora, pues, las imágenes de aquellos humanos del Paleolítico deberán representarlos con ojos claros y pecas, parecidos a los nórdicos europeos. «Desde luego, no se podrían morenos al tomar el Sol, como ocurre hoy con los pelirrojos», concluye el paleobiólogo.

Fuente: elmundo.es, 25 de Octubre de 2007

-El Airbus A380 hace su primer vuelo comercial

El avión más grande del mundo, el Airbus A380, efectuó este jueves su primer vuelo comercial, un vuelo de Singapore Airlines entre esta ciudad y Sydney que será diario y con una duración estimada de siete horas. Cientos de trabajadores y usuarios del aeropuerto asistieron al momento del despegue, acompañado, según las crónicas, con una enorme cantidad de fotografías y vídeos.

Entre el pasaje de este viaje inaugural, periodistas y,

como Ernest Graaff, entusiastas de la aviación, capaces de pagar 28.000 euros

por dos billetes de ida y vuelta en clase 'bussiness': "Soy un apasionado de los

aviones y estoy emocionado por ser parte de la historia". Aunque Graaf ha

escogido la opción más lujosa, el precio de los asientos para este primer vuelo

del A380 oscilaban entre 390 y los 70.000 euros, la mayor parte destinada a

proyectos benéficos.

Una cantidad entregada por los 471 pasajeros -afortunados- capaces de embarcar

en este gigante de los cielos en el que incluso hay cabida para doce suites de

lujo acondicionadas con camas, televisores con pantalla plana, una mesa de

despacho y un sillón reclinable, por no mencionar el excelso catering

disponible. En este primer vuelo hay 31 asistentes de vuelo, que servirán el

menú preparado por reputados cocineros y champán para celebrar el evento.

En el segundo piso del aparato hay 60 sillones para 'bussiness' y parte de los

399 de clase turista en ambas alturas. No alcanzar los 500 es un gesto de

Singapur Airlines para la comodidad de sus usuarios en estos viajes de larga

distancia, ya que el A380 podría alcanzar los 800 asientos.

Hasta ahora, sólo una docena de ciudades -entre las que se cuentan Singapur,

Londres, París, Nueva York, Los Ángeles y Tokio- puede permitirse acoger al

gigante de Airbus, que mide 80 metros y tiene una altura 24,1 metros. El

Aeropuerto Changi de Singapur emprendió hace tres años los trabajos de

adaptación, que supusieron tener que ampliar las pistas de aterrizaje, las

puertas de entrada a los hangares, e incluso hasta los vehículos para

transportar el equipaje.

Un vuelo que llega con retraso

El A-380 fue entregado a Singapure Airlines el pasado 15 de octubre en París y

voló hacia la ciudad-Estado dos días más tarde, donde fue recibido en la pista

de aterrizaje por el primer ministro singapurés, Lee Hsien Loong, y los

presidentes de SIA, Stephen Lee, y de Airbus, John Leahy.

El consorcio europeo Airbus tuvo problemas con la compatibilidad de algunos

programas informáticos y con el sistema de cableado en el fuselaje, lo cual

motivó que la aerolínea singapurés recibiera el avión con 18 meses de retraso.

Estos problemas en la fabricación, las pérdidas millonarias que han supuesto y

el cambio de cinco presidentes de Airbus en los últimos meses han perjudicado a

la imagen de la empresa, cuyo A-380 pronto encontrará un serio competidor en el

Dreamliner 787 de

Boeing.

Airbus ha recibido hasta la fecha 189 pedidos del A380, procedentes de 16

clientes, y tras Singapur Airlines, que recibirá sus 19 aeronaves entre 2008 y

2010, se encuentran las aerolíneas

Emirates Airlines,

Qantas o la española

Marsans. España participa

con un 10 por ciento en el desarrollo y construcción del A380, a través de la

contribución de una decena de empresas.

La aportación industrial española se fija en la fabricación de las partes más

importantes del avión, como el cono, las alas, el estabilizador de la cola y

varios elementos de la panza, que se fabrican en las tres plantas que la

división comercial de

EADS

tiene en España: Getafe (Madrid), Illescas (Toledo) y Puerto Real (Cádiz).

Fuente: elmundo.es, 25 de Octubre de 2007

-China lanza con éxito el satélite que abre su carrera para poner pie en la Luna en 2020

Con el lanzamiento de su primera sonda hacia el satélite lunar, China da un paso de gigante en la nueva carrera espacial por poner a un hombre en la Luna antes de 2020.

Chang I despegando

En un lanzamiento celebrado como un nuevo hito del programa espacial chino, el Chang'e I emprendió su periplo espacial desde la base espacial de Xichang, en el suroccidente del país al mediodía del 24 de octubre, hora española.

La parte científica de la misión tiene como objetivo obtener fotografías tridimensionales de la superficie lunar para poder analizar su composición y medir su grosor. «Aunque Estados Unidos ha lanzado satélites a la luna en varias ocasiones, nunca ha obtenido una fotografía a gran escala», señalaba a la prensa local Zhang Houying, experto de la Academia china de Ciencias.

La nave Chang'e I pretende repetir la hazaña de la diosa china del mismo nombre que, según la leyenda, bebió un elixir mágico que la elevó hasta la Luna, donde tiene un cráter bautizado en su honor. Repitiendo el recorrido de 380.000 kilómetros de la mujer de la Luna, la sonda empleará 173 horas para alcanzar la órbita deseada el 5 de noviembre. Si todo va bien y la aproximación es exitosa, la sonda debería transmitir la primera fotografía lunar a mediados de mes. Una hora después de su recepción en la Tierra y «sin retoques», la instantánea será distribuida a todo el mundo, según ha prometido el responsable científico del proyecto, Ouyang Ziyuan.

Para ello, el Chang'e I ha sido equipado con cámaras de alta definición y espectómetros de rayos X. Estos últimos se encargarán de realizar la clasificación espectral de 14 minerales, una pequeña porción del centenar que se han identificado en nuestro satélite. «Los recursos en la Luna están a disposición de cualquiera que pueda llegar, por eso la competición es feroz y muchos países quieren colocar una base allí», advertía Zhang.

En efecto, varias naciones, incluida China, pulen los planes para montar una presencia permanente en la Luna, pero ninguna de ellas antes de 2020. Hasta esa fecha, los esfuerzos se centran en mejorar la tecnología y los conocimientos sobre la Luna, con calendarios escalonados para alunizar y una competida carrera por ver qué pasaporte tendrá el próximo ser humano que pise la Luna. Por lo pronto, China lleva la delantera. El proyecto lunar del que forma parte el Chang'e I, iniciado en 2004 con un presupuesto que no se ha hecho público, es prioridad del Estado. Continuará con el alunizaje de un vehículo no tripulado, entre 2008 y 2010, y con los primeros taikonautas chinos caminando sobre la superficie lunar antes de 2020.

En la NASA, con un objetivo temporal idéntico, ya han reconocido que China podría ganar esta nueva maratón espacial. Y es que, desde que el líder comunista Mao Zedong se lamentó de que China no era capaz siquiera de lanzar una patata al cosmos, el programa espacial del país no ha parado de crecer. En 2003, China se convirtió en el tercer país -por detrás de la desaparecida URSS y de EEUU- que ha puesto en órbita a uno de sus ciudadanos.

Dado que el 95% de la tecnología espacial puede tener aplicaciones militares, hay países que ven con recelo el nuevo vigor de la industria espacial china. A principos de este año, China generó críticas en la comunidad internacional cuando destruyó una vieja sonda meteorológica con un misil antisatélites, en un tipo de prueba que hasta ahora sólo habían llevado a cabo, también, EEUU y la Unión Soviética.

Que el Chang'e I vaya a llevar al espacio el himno nacional y varias melodías revolucionarias es un signo más de que alimentar el orgullo nacional es un componente esencial, junto al científico, del programa espacial chino. La televisión transmitirá su lanzamiento, mientras 5.000 privilegiados tendrán la oportunidad de verlo en directo, por vez primera, en la base espacial de Xichang.

Fuente: elmundo.es, 24 de Octubre de 2007

-La Estación Espacial Internacional tiene otra pieza

Como estaba previsto, a las 17.38 hora española despegó ayer en Cabo Cañaveral el transbordador espacial Discovery. Rasgó envuelto en un trueno la capa de nubes que encapotaba el cielo de Florida y, un minuto después, ascendía a 6.000 kilómetros por hora rumbo a la órbita en que circunda la Tierra la Estación Espacial Internacional (ISS).

Momento del despegue

Dos minutos después del despegue, los dos cohetes de

propulsión que le proporcionan el 80 por ciento del impulso necesario para

vencer la gravedad terrestre, se separaron del transbordador y cayeron sobre el

Atlántico, de donde serán recuperados para su reutilización... El Discovery debe

acoplarse a la ISS el jueves, a las 13.35 horas española.

Sus siete tripulantes, dirigidos por una mujer, la comandante Pam Melroy, tienen

una misión crucial para el desarrollo de la Estación Espacial: acoplar el módulo

Harmony, catalogado como Nodo 2, indispensable para la futura instalación de los

módulos-laboratorio Columbus, la joya de la

ESA, la

Agencia Espacial Europea; y Kibo, que constituye la aportación estrella de la

agencia japonesa al proyecto multinacional. Serán los dos únicos módulos de la

ISS dedicados en exclusiva a la realización de experimentos científicos.

La Estación Espacial Internacional comenzó su andadura en 1998, cuando un cohete

ruso Protón colocó en órbita el módulo Zarya, diseñado para dotar a la estación

de la energía inicial necesaria para poner en marcha el proyecto. El final de su

construcción por etapas está previsto para 2010, cuando sea acoplado el Módulo

Portuario de Carga. Pero anticipar esto quizá sea quemar etapas, por cuanto que

es posible que nuevos proyectos, nuevas piezas del «lego», se añadan a su

construcción.

El módulo Harmony presenta el aspecto de un grueso tubo de aluminio presurizado,

es de fabricación italiana y pesa 14,3 toneladas. Mide 4,5 metros de diámetro

por casi 7 de longitud y su coste ha superado los 880 millones de euros. Se

trata del primer módulo habitable que se agrega a la ISS desde la instalación

del compartimiento acoplado ruso Pirs, en el año 2001; y es la aportación

europea más importante a la estación hasta ahora. Su instalación será realizada

durante la misión de diez días de los siete tripulantes del transbordador,

ayudados por los tres tripulantes permanentes de la estación.

La segunda misión encargada a los diez astronautas será la reorientación del

brazo robotizado -denominado P6 en la jerga de los expertos- de 16 toneladas y

20 metros de longitud que se acopló a la ISS en el año 2000. Una vez

posicionado, el P6 desplegará la tercera placa solar de las cuatro previstas, lo

que incrementará la producción eléctrica autónoma y renovable de la estación.

Cinco paseos espaciales

Para abordar estas complejas tareas en el exterior de la ISS, los astronautas

efectuarán cinco paseos espaciales -salidas orbitales- con una duración prevista

de 30 horas y media. Lo trabajos se llevarán a cabo en equipos de dos

astronautas durante los diez días que la nave estará acoplada a la estación. La

misión durará dos semanas si no surgen circunstancias imprevistas, como

ocurriera con la anterior misión.

El lanzamiento del Discovery se ha producido en esta ocasión no sin cierta

polémica entre los ingenieros y técnicos de la

NASA, ya que algunos de ellos

habían mostrado su preocupación durante las últimas semanas por el

descubrimiento de micro-fisuras de origen desconocido en tres de las 44 losetas

térmicas que recubren el borde de ataque de las alas de la nave, por lo que

solicitaron un aplazamiento de al menos dos meses en la misión.

El centro independiente de ingeniería y seguridad de la NASA había recomendado

en un informe reemplazar estos paneles, lo que habría alterado considerablemente

el calendario, ya de por sí muy ajustado, para culminar la construcción de la

ISS, prevista para 2010, que es el plazo programado para retirar del servicio

los tres transbordadores Discovery actualmente en activo.

Un italiano en la ISS

Paolo Nespoli despegó a primeras horas

de esta tarde rumbo a la Estación Espacial Internacional a bordo del

transbordador espacial Discovery de la NASA. En la zona de carga del

transbordador se encuentra el módulo Node 2, el primero construido por Europa

para su acoplamiento permanente a la estación.

El transbordador espacial Discovery despegó hoy desde el Centro Espacial Kennedy

que la NASA posee en Cabo Cañaveral, Florida, a las 11.38 hora local (17.38 CEST)

y se situó en la órbita terrestre tras casi 8 minutos de vuelo propulsado. Para

su misión STS-120, la tercera que el transbordador lleva a cabo este año, el

Discovery lleva a bordo siete tripulantes, entre ellos el astronauta de la ESA

Paolo Nespoli, procedente de Italia.

El primer día en el espacio se

dedicará a una serie de comprobaciones en vuelo para constatar que el Discovery

no haya sufrido daños en el lanzamiento. A continuación, el orbitador maniobrará

para ir al encuentro de la Estación Espacial Internacional (ISS). Está previsto

que el acoplamiento se lleve a cabo el 25 de octubre a las 14.33 CEST.

El objetivo de la misión STS-120, que durará 14 días , es el suministro y la instalación del Node 2, construido por Italia. El Node 2 es la primera elemento que se añade a la ISS en los últimos 6 años que agranda el espacio vital y de trabajo de la Estación La segunda tarea que llevará a cabo será la reubicación de la sección de soporte P6 de la ISS y el despliegue de sus paneles solares y del radiador de dispersión térmica.

Con la misión también se realizará el relevo de uno de los miembros de la tripulación de la Expedición ISS. El astronauta de la NASA Clayton Anderson, asignado a la estación desde su llegada en junio con la tripulación de la misión STS-117, será sustituido por el astronauta de la NASA Daniel Tani.

"Resulta siempre muy gratificante ver cómo se pone en marcha una misión

después de observar el duro trabajo que requiere su preparación", comenta Daniel

Sacotte, Director de Vuelos Tripulados, Microgravedad y Programas de Exploración

de la ESA. "Esta es una misión de gran importancia para Europa, ya que

suministra a la ISS el elemento Node 2, de construcción europea y que facilitará

el acoplamiento del laboratorio Columbus de la ESA en la siguiente misión que se

envíe a la Estación".

No es el primer italiano en viajar al espacio

Aunque este es el primer vuelo espacial de Paolo Nespoli, no se trata del

primer italiano que visita la ISS desde el inicio de su construcción en 1998. Le

han precedido sus compañeros astronautas de la ESA Umberto Guidoni (2001) y

Roberto Vittori (2002 y 2005).

Nespoli, que ha recibido el nombre de Esperia, que los griegos de la antigüedad dieron a la península italiana, es fruto de las seis oportunidades de vuelo concedidas a la Agencia Espacial Italiana (ASI) por el suministro de tres contenedores de carga presurizados (Multi-Purpose Logistics Modules, o MPLM) a la NASA en función de un acuerdo bilateral. La estrecha colaboración entre la ESA y la ASI condujo a la designación de Nespoli, miembro del Cuerpo de Astronautas Europeos, para ocupar la plaza de vuelo de la ASI.

Durante la compleja misión de montaje, Nespoli tendrá un papel destacado como astronauta de actividad intravehicular (IVA) en tres de los cinco paseos espaciales, que incluyen la instalación de Node 2. Como astronauta IVA, Nespoli coordinará las actividades desde el interior de la ISS durante los paseos espaciales, además de participar en preparativos tales como la configuración y prueba de los trajes y herramientas espaciales. Ayudará a los astronautas a vestir el traje espacial para salir al exterior, así como en las tareas de despresurización y represurización de las esclusas de aire.

Nespoli también tendrá otras responsabilidades durante la misión Esperia,

como llevar a cabo un programa conjunto de la ESA/ASI de experimentos sobre

fisiología y biología humanas, junto con varias actividades educativas.

El módulo Node 2 facilitará la labor del Colombus

Node 2, o ‘Harmony’, que es el nombre que se le ha dado, es el segundo de tres elementos de interconexión de la Estación Espacial. Los nodos conectan los distintos módulos presurizados para permitir el paso de astronautas y equipos, además de proporcionarles importantes recursos, como energía eléctrica y control térmico y medioambiental.

El Harmony se acoplará temporalmente al muelle de Node 1 durante el primer paseo espacial, que se llevará a cabo el 26 de octubre. Una vez que el transbordador se separe de la Estación al finalizar la misión STS-120, el Node 2 se instalará en su ubicación definitiva, en el muelle delantero del laboratorio Destiny de EE.UU., para lo que se utilizará el brazo robótico de la Estación.

El módulo Node 2 fue desarrollado por la NASA mediante contrato con la industria europea, de la que Thales Alenia Space es el principal proveedor. La ESA suministra este elemento a la NASA, junto con el Node 3, como retribución por el lanzamiento del Columbus con el sistema STS.

"Italia se enorgullece del papel que desempeña en esta misión y, por encima de todo, de su participación en el programa de la ISS. Nos proporciona una gran satisfacción cooperar con la ESA en la gestión de esta misión", declaró Simonetta di Pippo, Directora de Observación del Universo de la ASI y coordinadora de la misión Esperia por parte de la ASI. "Deseamos a Paolo y a la tripulación de la STS-120 el mayor de los éxitos en su misión. Después de la instalación del MPLM, otro módulo construido por la industria italiana será una pieza clave del conjunto de la ISS, lo cual confirma la capacidad europea e italiana para sustentar los próximos pasos de la exploración espacial".

Un riesgo "asumible"

Finalmente, la Agencia Espacial estadounidense consideró que se trataba de «un

riesgo menor y perfectamente asumible», por lo que la semana pasada dio luz

verde al despegue del transbordador.

Además, poco antes del lanzamiento, se había hallado un trozo de hielo en el

tanque externo de la nave. No obstante, fue luego reabsorbido por el calor

ambiental y se autorizó el despegue. El hielo es un serio motivo de preocupación

porque si se desprende durante el vuelo y golpea al transbordador, puede generar

daños en el recubrimiento térmico.

Nadie olvida en la NASA que el impacto de un pedazo de espuma aislante -más

ligera que el hielo-, desprendido del tanque externo, causó la desintegración

del Columbia, y la muerte de sus siete tripulantes, cuando la nave reingresaba a

la atmósfera en 2003 después de visitar la ISS.

La Estación Espacial Internacional es un proyecto presupuestado en unos 100.000

millones de dólares, que lleva nueve años en marcha y en el que participan un

total de 16 países. La comunidad científica dedicada a la investigación espacial

considera la ISS fundamental para la preparación de futuras misiones,

principalmente rumbo a Marte, y a la Luna, donde Estados Unidos planea volver en

el horizonte del año 2020.

Fuente: ABC, ESA, 24 de Octubre de 2007

Un equipo internacional de expertos se ha embarcado en la

iniciativa más ambiciosa hasta ahora en tecnología de exploración. Su fin es

sondear la Tierra hasta profundidades nunca alcanzadas. Quieren conocer el

origen y el futuro de nuestro planeta y la vida, saber por qué se producen

seísmos y contribuir a su predicción, atravesando la corteza terrestre desde el

lecho marino hasta llegar al manto, que forma el 80% de la Tierra.

El protagonista es el buque japonés de perforación submarina

Chikyu, que pretende obtener datos sismológicos, volcánicos, geológicos,

medioambientales y climatológicos en la falla de Nankai, 600 kilómetros al

suroeste de Tokio, en el Pacífico.

La corteza está formada por unos 72 kilómetros de roca sólida bajo los

continentes, pero su espesor es de menos de 8 kilómetros bajo los océanos y en

la depresión de Nankai es relativamente fina, sólo 7 kilómetros. Allí se solapan

dos grandes placas tectónicas y se origina el 90% de los terremotos que sufre

Japón, que registra el 20 % de todos los superiores a 6 grados en la escala

Richter.

Además de ofrecer pistas sobre acontecimientos del pasado, como el mortífero

maremoto que golpeó en diciembre de 2004 los países ribereños del océano Indico,

y sobre el origen y evolución de la vida en los últimos 4.600 millones de años,

el experimento de perforación de la corteza terrestre en la depresión de Nankai

permitirá conocer mejor la historia climática de la Tierra.

María José Jurado, del Departamento de Geofísica y Georiesgos del

Instituto de Ciencias de la

Tierra Jaume Almera (CSIC), en Barcelona, es el único científico español de

los 18 que integran la primera expedición a bordo del Chikyu, que partió el 21

de septiembre del puerto nipón de Shingu, como parte del experimento NanTroSEIZE,

del

Programa Integrado de

Perforación Oceánica (IODP). En este programa participan Japón, EEUU, China,

Corea del Sur y los países del

Consorcio Europeo para Investigación Oceánica (ECORD). [El consejo de ECORD

se reúne esta semana en Madrid. El Gobierno español, a través del Ministerio de

Educación y Ciencia, aportará 350.000 euros al programa en 2008, un 40% más que

el año anterior, precisamente con motivo del inicio de la actividad de Chikyu.]

"Mi grupo de trabajo establece la geología de lo que se ha perforado en el

sondeo", explicó Jurado desde el Chikyu a este diario. "Otros se encargan de

caracterizar las estructuras de deformación que se observan, de sus

características -porosidad, presiones de fluidos- y de correlacionar esa

información con los perfiles de sísmica de reflexión". Esta primera fase, "es

muy gratificante porque se trata de un grupo excelente, no sólo científico sino

también humano, y porque se intentan abordar objetivos que hasta hace poco

quedaban fuera del alcance de la tecnología existente", concluye Jurado, quien

sin embargo, también señala: "Estamos perforando en una zona que plantea

problemas importantes por ser rocas muy deformadas, por lo que puede ser difícil

alcanzar las profundidades previstas".

El padre de la iniciativa es Asahiko Taira, del Centro Japonés para la

Exploración de las Profundidades de la Tierra, responsable de la operación del

Chikyu. "Se me ocurrió esta idea en 1990, cuando pensé que si Rusia y EE UU

investigaban el espacio exterior, Japón podría liderar la exploración del

espacio interior, es decir, de las profundidades del mar", señaló Taira a este

diario. Ahora que "esta expedición es realidad me siento más entusiasmado, pero

más responsable por el apoyo popular e institucional de que goza, y porque

genera muchas expectativas", aseguró.

El barco tiene por delante un largo trabajo. En la primera etapa, que concluye

en febrero de 2008, se intentará perforar en seis sitios hasta 1,5 kilómetros de

profundidad. En la segunda (en 2008 y 2009), se taladrará de 3 a 3,5 kilómetros

bajo el lecho marino, con lo que se batirá una marca mundial, pues el pozo más

profundo excavado hasta la fecha tiene 2,1 kilómetros. En la tercera (de 2009 a

2010) se intentará hacerlo de 5,5 a unos 6 kilómetros, para instalar un sistema

de control en la falla sísmica, que permanecerá allí uno o dos años, mientras se

completan los sensores del definitivo sistema de control, que se instalarán en

la cuarta etapa (de 2010 a 2011).

Fuente: El País Digital, 24 de Octubre de 2007

-El mapa de nuestras diferencias genéticas

Aunque genéticamente somos un 99% iguales, una pequeña

fracción de ADN nos hace diferentes. Una segunda versión del mapa de estas

pequeñas variaciones ha sido publicada en la revista 'Nature'.

La investigación, que ofrece resultados más detallados que los de la primera

fase, puede servir para explicar la relación entre algunas enfermedades y la

genética.

Conocer y comprender la pequeña fracción genética que varía

de una persona a otra es importante para entender por qué unos individuos son

más susceptibles a unas enfermedades, unos fármacos funcionan mejor en algunos

pacientes o los motivos por los que una población reacciona a ciertos factores

medioambientales y otra no.

En este trabajo están involucrados 200 científicos que conforman el

Consorcio Internacional HapMap,

una sociedad pública y privada con patrocinio de agencias de Reino Unido,

Canadá, China, Japón, Nigeria y Estados Unidos. Los artículos que publica 'Nature'

corresponden a la segunda parte de la investigación que dio sus primeros

resultados en 2005.

Los científicos explican que los análisis publicados ahora contienen dos veces

más marcadores que los encontrados en la versión inicial, en concreto 2,1

millones, que sumados al millón anterior suponen 3,1 millones de variantes

genéticas o polimorfismos de nucleótidos (cambios en las letras que constituyen

la cadena de ADN). Cuantas más variaciones se registren en ese mapa, más

precisas serán las investigaciones dirigidas a buscar una base genética en

determinadas enfermedades.

De hecho, algunos resultados ya se han obtenido gracias a la información

proporcionada por el HapMap. Este verano, el

Wellcome Trust Case Control

Consortium encontró que más de 20 variantes genéticas estaban relacionadas

con un mayor riesgo de sufrir una serie de patologías, como la artritis

reumatoide, la diabetes tipo 1 y 2, la enfermedad celiaca o la coronaria.

La fase II del HapMap se realizó utilizando las mismas muestras de ADN

estudiadas en la fase I, que procedían de la sangre de 270 voluntarios sanos de

cuatro poblaciones geográficas distintas: Yoruba en Ibadan, Nigeria; Japonesa en

Tokio; Han Chinese en Pekín; y residentes de Utah con ancestros del noreste y

noroeste de Europa. Pero en esta ocasión se emplearon nuevas herramientas para

llevar a cabo estos análisis y mejores métodos estadísticos.

Cambios relacionados con la supervivencia

El nuevo mapa ha permitido conocer las tasas de recombinación genética

(redistribución de las moléculas de ADN) en el genoma humano. Así los

investigadores han detectado que los mayores cambios se han encontrado entre los

genes involucrados en la defensa del cuerpo y los que menos recombinaciones

presentan son aquellas proteínas que se encargan del correcto plegamiento de

otras proteínas. Por lo general, el mayor número de recombinaciones se da en el

material genético involucrado con la estructura celular externa.

Estas diferencias podrían indicar, según los autores, que los cambios o

recombinaciones en áreas del genoma que afectan a la respuesta frente a

organismos infecciosos u otros factores ambientales se producen porque ofrecen

una ventaja para la supervivencia.

Dentro de los planes de estos investigadores se encuentra la ampliación de estos

análisis a otras siete poblaciones para ofrecer información de otras variaciones

genéticas menos frecuentes como la de dos tribus de Kenya o la de residentes de

Los Ángeles con ancestros mexicanos. "Los datos del proyecto HapMap ofrecerán un

recurso inestimable para comprender la estructura de la variación genética

humana y su relación con el fenotipo", concluyen los autores.

Fuente: elmundo.es, 24 de Octubre de 2007

-España consume y contamina tres veces por encima de su "capacidad biológica"

La capacidad de carga del planeta es un término que se acuñó

a finales de los años 60 para definir el límite de un ecosistema natural para

absorber impactos o soportar un determinado uso. De ella se deriva un indicador

de carácter global, la llamada «huella ecológica», esto es, el territorio

necesario para producir los recursos que el hombre necesita y para asimilar los

residuos que genera. Y las hectáreas necesarias para mantener a un solo español

ascienden ya a 6,40, superando la media de la

Unión Europea, que

es de 4,7 hectáreas por persona.

Estos números no dejarían de ser precisamente eso si no fuera

porque la «biocapacidad» (la capacidad de carga) de nuestro territorio para

abastecernos y para «absorber» nuestros residuos es sólo de 2,43 hectáreas por

persona. Por tanto, estamos superando en un 260 por ciento el nivel considerado

sostenible. Así lo explicó ayer el secretario general para el Territorio y la

Biodiversidad, Antonio Serrano, en la presentación de los resultados

preliminares del informe «El análisis de la huella ecológica en España»,

elaborado por el

Ministerio de

Medio Ambiente.

Grado de urbanización

Para calcular este indicador de la huella ecológica (cultivos, pastos, bosques o

ecosistemas acuáticos necesarios para mantener a una población) se tienen en

cuenta las hectáreas necesarias para proporcionar el alimento vegetal; la

superficie necesaria para pastos que alimenten al ganado; la superficie marina

necesaria para producir el pescado; las hectáreas de bosque necesarias para

asumir el dióxido de carbono (CO2) que provoca nuestro consumo energético, y la

cantidad de hectáreas utilizadas para urbanizar, generar infraestructuras y

centros de trabajo. Por tanto, es lógico que la huella ecológica vaya ligada al

grado de urbanización y que las regiones con más territorio y menos pobladas den

como resultado un indicador, en apariencia, más sostenible. Por tanto,

atendiendo sólo a este criterio es Aragón la comunidad autónoma con una huella

ecológica mayor (7,25), seguida por Cantabria (7,02), Navarra (6,96) y Madrid

(6,75). En el lado opuesto de la tabla estarían Canarias (5,11), Extremadura

(5,50), Andalucía (5,63) y Castilla y Léon (5,75).