|

|||||

![]()

![]()

NOTICIAS CIENTIFICAS

--Nuevas Noticias Próximamente--

![]()

TITULARES DE LAS NOTICIAS DEL MES :

Jeff Wacker: La inteligencia artificial es un gran fracaso

Las erupciones volcánicas calentaron el planeta hace 55 millones de años

Japón y Corea del Sur redactan leyes para regular las conductas de los robots

El hierro influye sobre el cambio climático

Malaria: La vieja condena de África

López-Alegría: Desde el espacio uno se da cuenta de que no hay fronteras

Detectives de toxinas, metales pesados y malas medidas

Descubren el primer planeta habitable fuera del Sistema Solar

A un paso de la visión artificial

Primeras imágenes del Sol en tres dimensiones

Un telescopio extremadamente grande para Canarias

Cobertura para 700 científicos desde un gran centro de biomedicina

El deshielo en el casquete polar glaciar de Groelandia duplica las previsiones

Descubierta una proteína en la sangre humana que actúa contra el virus del sida

Investigadores en auxilio de Arquímedes

Casi 40 millones de dólares para conservar la biodiversidad vegetal

Descubren que los chimpancés han evolucionado más que los humanos

Un fallo informático puso fin a la sonda Mars Global Surveyor

Crean el primer prototipo de hardware evolutivo

El Teide interesa a la NASA, a la espera de la decisión final de la UNESCO

Secuencian el genoma del macaco

Un gen duplicado predispone a la obesidad

El español Joan Massagué consigue dar nuevas explicaciones sobre la metástasis

Detectan agua en un planeta distante

La ONU quiere tratar el cambio climático más en serio

Los restos de Juana de Arco son un fraude

El acelerador de partículas estalla por errores en los cálculos

Dos cosmonautas y un turista llegan en la Soyuz a la Estación Espacial

Diez maravillas de la naturaleza peligran por el cambio climático

Expertos desvelan claves sobre la circulación oceánica de hace 21000 años

El segundo informe del IPCC es más duro que el primero del año 2007

Marte también sufre el cambio climático

Gran Hermano espacial camino de Marte

El Tribunal Supremo de EEUU sanciona las medidas del Gobierno para regular el cambio climático

Maggie parece un muñeco de dibujos animados: tiene unos enormes ojos negros que parpadean con frecuencia, mide aproximadamente un metro cuarenta, levanta los brazos, gira, rueda.

Reconoce gestos y voces humanas.

También puede conectarse a internet y leer las noticias, y -con la ayuda de etiquetas de radiofrecuencia- identifica cajas de medicinas y su modo de empleo, algo que podría ser de ayuda para personas invidentes.

"Nació" en la primavera española de 2005 en el Robotics Lab de la Universidad Carlos III de Madrid y cuando fue presentado recientemente en el II Congreso Internacional sobre Domótica, Robótica y Teleasistencia para Todos, causó sensación.

En los titulares de la prensa Maggie llegó a ser el "robot para ciegos", el "robot capaz de sentir cosquillas", "el robot amable", "el robot lazarillo", y hasta el "humanoide".

Maggie

Plataforma y juguete

Maggie es uno de varios proyectos de robótica que se desarrollan en España.

No es un humanoide, ni un enfermero, ni un lazarillo, sino una plataforma de investigación, dirigida sobre todo a la interacción con las personas explicó a BBC Mundo Miguel Ángel Salichs, catedrático de ingeniería de sistemas y automática de Universidad Carlos III de Madrid.

No es un robot comercial, es un prototipo de laboratorio y continuamente se le están incorporando nuevas funciones.

Según el profesor Salichs, primero podría entrar a las casas como un juguete sofisticado.

"Lo que vamos buscando es que Maggie se perciba como un ser vivo, que se vea como algo que tiene sus propias emociones, que el usuario, en el caso de que sea un niño, piense que es un ser vivo", comentó el profesor Salichs.

Al profesor le gustaría algún día ver a Maggie en nuestros entornos cotidianos "saludando a la gente por el pasillo, ayudando a las personas o dándoles información", pero para llegar a ello hay un largo camino de investigación y mucho trabajo por hacer.

Y con investigación constante se busca que los robots se parezcan cada vez más a los seres humanos, dotarlos de más autonomía, que tomen sus propias decisiones.

Mucho camino por delante

"Una de las cosas que tenemos que tener cuidado es, por una parte transmitir nuestra ilusión pero por otra transmitir que hay que trabajar mucho para tener lo que se vé en las películas de la ciencia ficción", agregó Salichs.

Los expertos se refieren a la sociedad del siglo XXI como una "sociedad robotizada".

Dicen que en este siglo veremos "una masiva intervención de robots en todos los aspectos de la vida cotidiana y productiva", así lo señala el libro blanco de la robótica, publicado recientemente por el Comité Español de Automática.

El libro añade que "los robot no solamente estarán localizados en las factorías y con aspecto de brazo manipulador, sino también saldrán al asfalto y al campo para realizar multitud de tareas de servicios e industriales que hoy en día son efectuadas manualmente".

Fuente: BBC Mundo, 30 de Abril de 2007

-Hawking desafía a la gravedad

El famoso físico británico Stephen Hawking ha cumplido su sueño de volar en gravedad cero. El Boeing 727 en el que lo ha conseguido ha aterrizado con éxito en Cabo Cañaveral.

Todo ha salido bien. El jefe de la misión, Noah McMahon, declaró al término del vuelo: "Es un tipo muy fuerte, estuvo todo el rato sonriendo. Nos ha sorprendido". Además, reveló que "no tuvo ningún problema de ningun tipo. Todo fue mucho mejor de lo esperado y esto demuestra que cualquiera puede hacerlo".

Debido al estado de salud de Hawking, estaba previsto inicialmente que el avión describiese sólo una parábola (subida y bajada) cuando habitualmente son 15. Sin embargo, el avión ha descrito finalmente ocho. Y en cada una de ellas estuvo "alrededor de 25 segundos en situación de ingravidez total", declaró a EL MUNDO McMahon.

Hasta los movimientos del físico dentro de la nave tenían que adecuarse a las necesidades de los dos fotógrafos que acompañaban a Hawking para inmortalizar el momento. Cuando el científico dijo que quería dar varias volteretas, "le levantamos del suelo [del avión], le giramos para que mirara a las cámaras, y después le ayudamos a dar varias vueltas", explicaba Peter Diamandis, consejero delegado de Zero Gravity.

Hawking no ocultó que "hubiera seguido una y otra vez". "Fue increíble", dijo, con el sintetizador de voz que le permite hablar. Y añadió: "¡Espacio, allá voy!". Poco antes había explicado que "no he tenido ningún problema con la gravedad cero. Ha sido maravilloso".

Para salir, un camión con una plataforma se acercó hasta el avión para transportar la silla de ruedas del físico. Desde allí, Hawking saludó, mientras que la tripulación y sus compañeros de viaje le aplaudían.

Horas antes de despegar, el conocido físico británico no podía contener la emoción: "Como podéis imaginar, estoy muy emocionado. He estado en una silla de ruedas durante casi cuatro décadas y la oportunidad de estar en gravedad cero será maravillosa. Nos vemos en la gravedad cero".

"Quiero además despertar el interés de la opinión pública por el espacio. Un vuelo en gravedad cero es el primer paso hacia los viajes espaciales", dijo.

Más allá de un sueño infantil, el autor de 'Breve Historia del Tiempo' ha dado a su paseo ingrávido un tono trascendental. "La vida en la Tierra está en un creciente riesgo de ser destruida por un desastre, como el calentamiento de la atmósfera, una guerra atómica, un virus modificado por medio de la ingeniería genética u otros factores, y no creo que la raza humana tenga futuro a menos que se vaya al espacio", añadió.

En este tipo de vuelos, el avión describe normalmente 15 parábolas (subida y bajada). En las dos primeras, se recrea la gravedad de Marte (un tercio de la de la Tierra), en la tercera, cuarta y quinta la de la Luna (que es la decimosexta parte de la terrestre), y en las otras 10, gravedad cero.

"Esta iniciativa nació cuando en un programa de radio en el Reino Unido le preguntaron cuáles eran las ambiciones que le quedaban por cumplir, y él respondió que siempre había querido salir al espacio", explicó el asistente personal del físico, Sam, un afable joven que respondió a la mayor parte de las preguntas de su jefe en la rueda de prensa horas antes del vuelo, dado que Hawking necesita minutos para emitir sonidos a través del sintetizador con el que habla gracias a los movimientos de sus músculos faciales.

Inmovilizado en una silla de ruedas desde hace 40 años, Stephen Hawking apenas puede mover su cara más que para pestañear y sonreír. Es una sonrisa torcida, casi una mueca, que el físico británico, de 65 años, no dejaba de mostrar a las cámaras de televisión junto a la inmensa pista de aterrizaje de Cabo Cañaveral, antes de subirse al avión.

Vistiendo un traje azul de la NASA, en su silla de ruedas, con las manos cruzadas sobre las rodillas, Hawking sonreía porque estaba en el camino de lograr dos de sus sueños: viajar al espacio y liberarse, al menos momentáneamente, de su silla de ruedas.

Hawking no viajará al espacio hasta el año que viene, como muy pronto. Pero su vuelo ha sido un gran paso en esa dirección. El físico británico ha experimentado lo que es estar en gravedad cero, como si fuera un astronauta fuera del campo gravitatorio de la Tierra

Fuente: El Mundo, 29 de Abril de 2007

-Jeff Wacker: La inteligencia artificial es un gran fracaso

La profesión de Jeff Wacker es la de

futurista corporativo. Este gurú de las nuevas tecnologías, alto cargo de la

empresa de externalización

EDS, se dedica a

investigar cómo será la empresa en las próximas décadas a raíz del impacto de la

innovación. La mejora de la productividad, asignatura pendiente de la economía

española, pasa necesariamente por un cambio en las formas de trabajar y en

establecer nuevas relaciones entre las máquinas y el ser humano.

Pregunta. ¿Qué se podrá hacer con la tecnología del futuro?

Respuesta. Las tecnologías de la información se están convirtiendo en parte de

nuestras vidas. Su implantación supuso primero una revolución en los negocios.

Luego se extendió a los hogares: los ordenadores entraron en las casas, los

consumidores empezaron a sustituir sus calculadoras y sus máquinas de escribir.

Lo que vivimos ahora es Internet y la conexión entre los ordenadores que nos

permite compartir contenidos. La próxima ola será aún más dirigida hacia el

consumidor, pero será menos visible.

P. ¿En qué sentido?

R. Tendré mi coche que, sin que yo ni siquiera me entere, se pondrá en contacto

con el fabricante, para comprobar que no hay averías. Mi móvil servirá para

todo. Será mi yo digital. Así, mis latidos, mi tensión arterial, se transmitirán

en tiempo real al centro médico. Podré hablar con el póster de la calle que

anuncia el concierto de Mozart y comprar la entrada conectando el aparato con el

cartel publicitario. Por lo general, entraremos en la era de la conciencia de la

ubicación. Significa que con mi móvil no sólo podré saber cuál es el restaurante

más cercano, sino comprobar si tienen sitio y qué tienen de menú. Será posible

que mi ordenador detecte en un aeropuerto a otro, cuyo usuario trabaja para una

compañía similar o tiene mis mismos intereses y que nos pongamos en contacto y

cenemos juntos. La tecnología estará en todas partes y tendrá capacidad

sensorial, para oír y ver. ¡Hasta en los tapones de las botellas de agua!

P. ¿Qué problemas supone este nuevo entorno?

R. Uno de los mayores desafíos es la energía. El chip necesita baterías,

electricidad. Pero ya se están desarrollando nanotecnologías que permiten

alimentar un aparato a través de las vibraciones de la voz. Hasta el aire

acondicionado, que produce ondas, podrá también cargar chips. El otro reto es la

tutela de la privacidad. Habrá que tener la posibilidad de poner filtros de

protección y de removerlos cuando queramos. O que incluso el ordenador lo haga

de forma automática, que sepa cuando no quiero ser molestado. También está el

problema del coste. Al comienzo el uso de esta tecnología será caro. Entre 2008

y 2012 habrá un consumo limitado. A partir de entonces los precios bajarán y

habrá un boom.

P. ¿Qué pasará en el mundo de los negocios?

R. Hasta ahora la tecnología proporcionaba un instrumento para que el trabajador

accediera a lo que quisiera hacer. Pero no le explicaba cuál es la mejor manera

para llevar a cabo la tarea. En el futuro el ordenador se convertirá en un

asistente. El PC será proactivo y nos ayudará en nuestro esfuerzo laboral.

Identificará la información que necesitamos incluso antes de que nosotros se la

preguntemos. No perderemos tiempo en detalles. Esto aumentará la productividad.

Y el paso siguiente será el flujo de gestión automático.

P. ¿Qué es esto?

R. Me explico. Si contrato a un nuevo empleado, tengo que enviar un correo al

encargado de la seguridad para que le facilite el acceso al edificio. En el

futuro, no tendré que dedicar tiempo a esta incidencia, sino que lo harán las

máquinas solas.

P. ¿Cuál será entonces el papel del ser humano?

R. La automatización siempre ha sustituido a los hombres. Pero no los

ha eliminado. Ahora las máquinas construyen el producto, pero la aportación del

ser humano seguirá siendo fundamental, no tanto en hacer el proceso, sino en

gestionar las máquinas que elaboran dicho proceso. De hecho, en la actualidad,

el Boeing 777 lo pilota un ordenador y el comandante controla la máquina. En la

empresa, el papel del ser humano será el de la creación, de la innovación y de

saber adaptar el sistema a los cambios.

P. Habrá que cambiar la gestión de las empresas...

R. Ya no habrá que pagar a los empleados según la cantidad de producto, sino de

acuerdo con las mejoras que habrán sido capaces de introducir en el sistema. De

la misma manera que una compañía puede formar a los empleados para hacer tareas

rutinarias, es posible enseñarles a ser innovadores. Así, en el futuro

trabajaremos en equipo, sin respetar un horario, en función de un objetivo.

Algunos trabajos como el comercial, tienen aspectos que sólo pueden desarrollar

los humanos, porque las relaciones personales, en el momento de negociar una

venta, son muy importantes. En cambio, muchas tareas administrativas, frecuentes

en la administración pública pero también en el sector financiero, serán

monopolio de las máquinas.

P. ¿Qué es lo que una empresa no tiene que hacer?

R. Simular. Crear modelos de negocios abstractos en laboratorios con fórmulas

matemáticas es un error, porque la inteligencia artificial es un gran fracaso.

En cambio, la vía adecuada es estudiar los otros modelos de negocios en sus

respectivas condiciones, ver cuáles son las nuestras y adaptarlos entonces a

estas exigencias.

Fuente: La Vanguardia, 27 de

Abril de 2007

-Las erupciones volcánicas calentaron el planeta hace 55 millones de años

El calentamiento que sufrió la Tierra hace 55 millones de años fue causado por erupciones volcánicas en Groenlandia y la zona occidental de las islas británicas, indica un estudio publicado por la revista 'Science'.

Esa actividad volcánica ocurrió durante

la llamada "máxima termal Paleoceno-Eoceno" (PETM, en inglés), que ocasionó un

aumento de cinco grados centígrados en los trópicos y de más de seis en el

Ártico, según el estudio, realizado por científicos del Colegio de Ciencias

Atmosféricas y Oceánicas de la

Universidad de Oregón.

De acuerdo con los geólogos, las erupciones y la contaminación atmosférica

resultante originaron lo que denominan "una emergencia planetaria" de aumento de

la temperatura en la superficie marina, así como una acidificación de los

océanos que causó la extinción de muchas especies.

El estudio es importante, a juicio de sus autores, porque documenta la reacción

del planeta a la liberación de grandes cantidades de gases invernadero en la

atmósfera y vincula, de manera concluyente, un importante acontecimiento

volcánico con un período de calentamiento global.

Se considera que esos gases invernadero, entre ellos el dióxido de carbono y el

metano, actualmente producidos por la actividad industrial, son los componentes

principales de la contaminación y el calentamiento que está sufriendo la Tierra.

"Sin duda esas erupciones y el calentamiento global de entonces están vinculados

y ese fenómeno constituye una analogía para lo que ocurre hoy", señaló Robert

Duncan, uno de los científicos.

"Se habían encontrado vestigios de este calentamiento en residuos marinos así

como evidencia geológica de que las erupciones ocurrieron virtualmente en el

mismo momento. Pero hasta ahora no se había establecido una vinculación directa

entre ambos fenómenos", explicó.

"Existe sin duda una analogía que nos permite ver de qué forma el planeta ha

reaccionado ante el fenómeno", añadió.

Duncan también señaló que, además, con este estudio se ha constatado el hecho de

que en algunos lugares del planeta el calentamiento fue muy rápido y en otras

bastante lento, "como ocurre hoy".

El vínculo entre la actividad volcánica y el calentamiento global surgió de la

correlación de los registros fósiles examinados por los científicos, según el

informe de la investigación.

El PETM se caracterizó por enormes cambios en la composición carbono-isotópica

de los océanos, la corrosión de los caparazones del plancton, así como la

extinción de algunos organismos de las profundidades marinas.

Los científicos también vincularon el PETM con la separación física de

Groenlandia del continente europeo a través del análisis de las capas de cenizas

que se depositaron al culminar las erupciones volcánicas.

Mediante una comparación de las sustancias químicas residuales, establecieron

que la composición de las capas de cenizas en el este de Groenlandia eran

similares a las de los sedimentos marinos en el océano Atlántico, según el

informe.

"Creemos que las erupciones volcánicas comenzaron hace unos 61 millones de años

y que pasaron otros cinco millones (de años) hasta que el manto se debilitó y el

material fundido surgió en la superficie", indicó Duncan.

"Fue como si se destapara una olla. La placa tectónica se partió y así nació el

océano Atlántico", indicó.

La actividad volcánica que se registró en Groenlandia hace entre 55 millones y

61 millones de años llevó a la superficie alrededor de 10 millones de kilómetros

cúbicos de magma.

Según los científicos, esos flujos de lava pueden verse a simple vista en el

oeste de Escocia y en las islas Faroe, puesto que, tras enfriarse, dejaron un

espectro de lava que en algunas zonas tienen una profundidad de hasta seis

kilómetros.

Fuente: EFE, 27 de Abril de 2007

Los robots comienzan a salir de la

cadena de montaje y realizan todo tipo de actividades profesionales y

domésticas. El parque mundial supera las 922.000 unidades, buena parte en el

sector de la automoción. En España funcionan 25.000, el cuarto país europeo por

detrás de Alemania, Italia y Francia, y el séptimo del mundo que más robots

emplea. Sin embargo, la mayor parte son importados y su producción se reparte

entre los fabricantes

ABB Robotics (Suecia),

Fanuc (Japón) y

Kuka (Alemania).

Se calcula que en el mundo existen más

de 31.000 robots de servicios destinados a usos profesionales. El 20% son

submarinos automáticos, el 19% limpiadores y otro 16% realiza tareas de

seguridad y defensa. El 45% restante se reparte entre construcción y demolición,

lecheros, sanitarios y plataformas de uso general.

A pesar de no crear prácticamente robots comerciales, sino adaptaciones de

equipos foráneos, España es una potencia investigadora con grandes perspectivas

a corto plazo: cuenta con 42 grupos científicos muy activos, fundamentalmente de

universidades y centros tecnológicos, según el Libro Blanco de la Robótica en

España, publicado recientemente por el Grupo Temático de Robótica (GTR) del

Comité Español de Automática.

Si en el ámbito automovilístico España ha perdido la partida, aún hay

posibilidades de producir robots manipuladores para la industria del cuero, el

calzado o la alimentación; la recolección en la agricultura intensiva o para

realizar tareas peligrosas en el sector de la construcción. De hecho, la empresa

vasca

Fatronik ha licenciado a

una multinacional norteamericana su manipulador ultrarrápido Quattro.

Sin embargo, las mejores perspectivas para los investigadores españoles se

encuentran en la robótica de servicio, tanto profesional como doméstica. En los

próximos tres años el mercado mundial crecerá en 34.000 unidades de uso

profesional y en 5,6 millones para el hogar, como las aspiradoras automáticas

que limpian solas la casa.

Juan Domingo Tardós, del grupo de Robótica de la

Universidad de Zaragoza, recomienda a los

investigadores que adecuen las aplicaciones científicas a las necesidades reales

y, a las empresas locales, que arriesguen su capital en aplicaciones novedosas.

Porque los beneficios que se obtienen cuando se ponen en marcha proyectos

europeos es del 8%. "Nuestros investigadores en robótica son reconocidos en

Europa y consiguen muchos proyectos y financiación, algo que no se refleja en

las ayudas españolas", afirma Carlos Balaguer, coordinador del GTR y de la Red

Nacional de Robótica.

En

Euron, la red de excelencia europea de

robótica, que se reunió recientemente en Creta (Grecia), la representación

española era la tercera más numerosa, por detrás de Alemania y Francia.

A pesar del gran número de proyectos en los que trabajan los grupos de

investigación, "la empresa española no es receptiva a los encantos de la

robótica", según Carlos Balaguer, del Grupo Español de Robótica (GTR). A su

parecer, "tenemos buenos productos en estado precompetitivo, pero no encontramos

pymes que quieran hacer dinero con ellos". También pesa la elevada competencia

entre los numerosos grupos por la escasa financiación que reciben los proyectos.

Sin ir más lejos, la

Universidad Politécnica de Madrid (UPM)

"cuenta con productos listos para comercializar", asegura el investigador en

robótica Antonio Barrientos.

Su grupo ha creado un robot que ayuda al médico a medir los temblores de los

enfermos de Parkinson y que ha sido probado con 42 pacientes durante seis meses

en el Hospital Ramón y Cajal de Madrid. Mientras esperan a ver si llega algún

inversor, el grupo creará una spin-off que adapte robots aéreos a tareas como la

inspección del tendido eléctrico.

La robótica de servicios puede ser la gran aliada de la investigación española,

que destaca en el desarrollo de robots móviles autónomos, básicamente para

interiores, o en la interacción humano-robot multimodal, mediante la voz, gestos

y visión, según Carlos Balaguer. También en la robótica asistencial, para dar

servicio a ancianos, niños y personas discapacitadas; robots aéreos (pequeños

helicópteros, aviones y dirigibles autónomos) o robots médicos.

'ROBOCÓPTERO'

Aníbal Ollero, responsable de robótica de la

Universidad de

Sevilla, lidera el proyecto europeo Aware, que

durante tres años desarrolla tecnologías que permitan integrar robots

helicópteros con redes inalámbricas de sensores de bajo peso y consumo, que

pueden estar fijos o ser transportados por personas (bomberos, por ejemplo) o

vehículos terrestres.

A cuentagotas, algunos investigadores han podido transferir su tecnología. Como

el grupo de robótica de la

Universidad de Málaga (UM).

La empresa

Sener fabricará el brazo

robótico para operaciones de laparoscopia diseñado por el grupo malagueño y que

ha sido ensayado clínicamente con pacientes.

Su innovación: "No es necesario ligar el dispositivo, una minicámara activada

por voz, ni calibrarlo en cada intervención, explica Alfonso García-Cerezo,

investigador de la UM. En tres años, la empresa espera vender 35 unidades.

El centro tecnológico vallisoletano Cartif está desarrollando equipos para

inspeccionar tuberías o para la limpieza automática de conductos de aire

acondicionado, y ahora trabaja "en el desarrollo de un robot que asista en la

colocación de los clavos en las fracturas de huesos largos", explica Javier

Pérez Turiel, del grupo de robótica de Cartif.

La

Universidad Politécnica de Cataluña (UPC) es

una de las que tiene mayor tradición en robótica y una parte de los esfuerzos de

investigación se decantan hacia la vertiente asistencial. "Trabajamos en

diferentes proyectos y prototipos de sistemas robotizados de ayuda a los

discapacitados y de soporte a los procedimientos quirúrgicos en cirugía

mínimamente invasiva", explica Alicia Casals, del Grupo de Robótica, Automática

y Visión Artificial de la UPC.

El grupo de investigación de la

Universidad

Jaume I (Castellón) que en su día diseñó un

robot bibliotecario que extrae libros de las estanterías, trabaja ahora "en un

autómata que tome decisiones y manipule objetos cotidianos como el pomo de una

puerta", cuenta Pedro Sanz.

MANIPULAR OBJETOS BLANDOS

Si obtienen recursos del VII Programa Marco, este equipo de la Jaume I ampliará

la manipulación a objetos blandos, como un robot planchador. Además,

transferirán su tecnología a la empresa valenciana

Robotnik,

con la que participa en el proyecto europeo Guardians, un enjambre de robots

autónomos que sirven para detectar incendios urbanos.

Más al sur, en la

Universidad de Alicante,

han desarrollado el desensamblador automático de componentes de ordenador,

explica Fernando Torres.

El equipo de Juan Domingo Tardós en la universidad de Zaragoza, trabaja "en

robots móviles autónomos para desplegarlos en el interior de túneles para

informar en accidentes".

¿Veremos coches que recojan pasajeros al llamarlos por el móvil? Aunque parezca

futurista, será una de las pruebas de robots cooperativos con humanos del

proyecto europeo Urus, coordinado por Alberto Sanfeliu, del

Instituto de Robótica Industrial de Barcelona.

Los futuros investigadores también se divierten. Esta misma semana, 200

estudiantes de la UPM han participado en la olimpiada de robots Cibertech 2007.

MÁS VELOZ QUE LA F1

Como un relámpago. Instalado en la cinta transportadora, Quattro identifica y

separa los machos de las hembras de verdel, un pescado azul, a un ritmo de 240

piezas por minuto y con aceleraciones de 200 metros por segundo, el doble de los

robots convencionales y cinco veces más que un bólido de la Fórmula 1. Trabaja

como lo harían tres humanos juntos, pero sin cansarse y una empresa conservera

vasca está probando este ingenio francoespañol para medir si duplica la

productividad.

Quattro es el robot industrial más rápido del mundo y lo ha desarrollado la

fundación española Fatronik con el Laboratorio de Ciencias Informáticas,

Robótica y Microelectrónica de Montpellier (Francia). Han vendido la licencia a

la norteamericana Adept, que los fabricará en serie. Quattro está optimizado

para manejar objetos de hasta dos kilogramos de peso, ya sea para colocar

bombones y galletas en cajas o para empaquetar tabletas de turrón o chocolate.

El autómata ha sido premiado recientemente por Euron, red de excelencia europea

de investigadores en robótica, como ejemplo de transferencia tecnológica. A

mediados de mayo, una spin-off de Fatronik se encargará de la integración

industrial. Jon Sanmartin, ingeniero de I+D de Fatronik, calcula que en España

se venderán 10 unidades al año y unas 300 en todo el mundo.

Fuente: El País, 27 de Abril de

2007

-Japón y Corea del Sur redactan leyes para regular las conductas de los robots

En pocos días se han sucedido dos

noticias hermanas. Los gobiernos de Japón y Corea del Sur están preocupados por

un futuro lleno de robots y no están muy seguros de que se trate en todos los

casos de máquinas amigas. Y ambos, aunque con perfiles un tanto distintos, han

iniciado una política preventiva ante este futuro, parece ser, incierto con los

robots.

El Gobierno japonés ha redactado un

borrador de 60 páginas con el propósito de garantizar que los robots siempre

estarán bajo el control humano. Este documento debe ser discutido por la

industria, investigadores y abogados con el fin de elaborar una ley que

satisfaga este propósito. El título del borrador ya es una muestra del miedo que

preside la iniciativa: "Borrador de guía para asegurar la sana conducta de la

próxima generación de robots".

El periódico británico

The Times informó de su

existencia la semana pasada e incluso le dedicó un editorial un tanto incrédulo

en el que trasladaba este ejercicio legislativo a Gran Bretaña. El diario

simplificaba enormemente, hasta el ridículo, las reglas que deben regir el

futuro de los robots y las circunscribía a conductas como la de no ofenderse si

le preguntaban la edad a la hora de comprar cigarrillos o alcohol, apagar los

teléfonos móviles en el cine y comportarse en los controles por rayos X en los

aeropuertos.

El documento japonés propone evaluar el nivel de riesgo y las fuentes del mismo.

Uno de los remedios preventivos consiste en crear una base de datos en la que se

recojan todos los incidentes en los que un humano haya sido herido por un robot,

las causas del mismo y que esta documentación sea accesible a todos los

fabricantes de robots.

Japón es uno de los países donde está más desarrollada la robótica, no ya en el

sector industrial, sino también en el de la ayuda doméstica y a ancianos. La

próxima generación, inminente, asumirá tarea de patrullaje de seguridad y tutela

de bebés. El mercado de estos robots "de ayuda" ronda los 10.000 millones de

yenes, pero las autoridades creen que en 15 años se disparará a cifras

astronómicas. Algunos analistas atribuyen el empuje de esta industria robótica

auxiliar a que con las máquinas se intentan solucionar problemas, como la

asistencia a ancianos, que de otra manera exigirían altos contingentes de mano

de obra inmigrante, cuya entrada se quiere evitar.

Corea del Sur también ha reunido a un grupo de expertos para elaborar un código

ético que evite que los hombres sean víctimas de los robots... o viceversa.

La carta ética de los robots debería suscribirse antes de que termine este año.

Trabaja en ella un comité que reúne a expertos, futurólogos y autores de ciencia

ficción. De acuerdo con un comunicado oficial, recogido por la BBC, el Gobierno

quiere implantar un criterio de conducta sobre las funciones de los robots

porque éstos pueden desarrollar una vida inteligente en un futuro próximo.

Park Hye-Young, miembro del despacho de robótica del ministerio surcoreano de

Comercio e Industria, explicó que el código se iba a inspirar en las reglas

establecidas por Isaac Asimov. El objetivo de la iniciativa es garantizar el

control del hombre sobre estas máquinas, evitar su uso clandestino, tenerlas

perfectamente identificadas y asegurar que el uso de los datos adquiridos por

los robots no vulnere derechos como el de la privacidad.

El imaginario de la ciencia-ficción no ha sido muy amable con los robots. Menos

todavía el cine, más proclive a presentarlos como criaturas, almas de metal, que

se rebelan contra su creador, en una repetición del relato bíblico. Sin embargo,

en la realidad, el empleo de los robots es pacífico y creciente. Sólo en el

sector industrial, en 2004, había 850.000 robots, de los que más del 40%

habitaban en Japón. El parque de robots en España rondaba los 22.000.

LAS TRES LEYES DE ISAAC ASIMOV

Asimov fijó las tres leyes que deben regir la existencia de los robots:

Fuente: El País, 26 de Abril de 2007

-El hierro influye sobre el cambio climático

Las variaciones en la cantidad de hierro que emerge de las profundidades a la superficie marina pueden tener un efecto mayor en el cambio climático de lo que hasta ahora se creía, según advierte un estudio de científicos franceses y australianos.

Esta investigación, que recoge en su

última edición la revista científica 'Nature',

analiza la función de ese elemento como nutriente del fitoplancton, conjunto de

organismos acuáticos responsable de casi la mitad de los procesos de

fotosíntesis que tienen lugar en la Tierra.

La cantidad de este microorganismo marino, que varía en función del hierro que

emerge a la superficie, es clave, por tanto, en el procesamiento del dióxido de

carbono de la atmósfera, uno de los principales causantes del calentamiento del

planeta.

Para analizar este proceso, los científicos estudiaron un fenómeno de

florecimiento natural del fitoplancton en el Océano Índico meridional, a unos

2.000 kilómetros al norte de la costa de la Antártida, cerca del archipiélago de

las islas Kerguelen.

Hasta ahora, las investigaciones sobre el florecimiento del fitoplancton, que

consiste en la multiplicación de este microorganismo por un exceso de nutrientes

y una temperatura favorable, habían provocado artificialmente este fenómeno

mediante la fertilización de las aguas durante un corto período de tiempo.

"Hemos descubierto que el suministro de hierro y otros nutrientes a la

superficie marina desde la profundidad es la causante del gran florecimiento de

fitoplancton que observamos sobre la meseta Kerguelen en el Océano Índico Sur",

indica el informe.

"Esta fertilización natural es al menos diez veces más eficaz que la que

propició los florecimientos artificiales de algunos experimentos a corto plazo",

añade.

Para los científicos, esto demuestra que el efecto del hierro sobre el

fitoplancton y, en consecuencia, sobre el nivel de dióxido de carbono de la

atmósfera, es mayor que el que hasta ahora se atribuía.

Fuente: EFE, 26 de Abril de 2007

-Malaria: La vieja condena de África

Más de 300 millones de infectados, un millón de muertos. Estas son sólo algunas de las dramáticas cifras que cada año se cobra la malaria en el mundo, fundamentalmente en el África subsahariana y en los niños menores de cinco años.

Decididos a hacer frente a la

situación, en el año 2000, los gobiernos africanos se comprometieron a reducir

la incidencia de la malaria en África a la mitad para el año 2010. Los 53 países

firmantes de la Declaración de Abuja fijaron el 25 de abril como el Día de la

Malaria en África.

En estos años, se han producido diferentes avances en la lucha con el paludismo

(desde la secuenciación del genoma del mosquito y el parásito culpables de la

enfermedad al éxito de los ensayos clínicos con la vacuna antimalárica).

Los organismos internacionales son optimistas. La iniciativa Roll Back Malaria

(el programa contra el paludismo de múltiples organismos, como la

OMS

y el

Banco Mundial) ha

establecido unos ambiciosos objetivos para 19 países africanos, que en los

próximos meses presentarán sus proyectos al Fondo Global contra el Sida, la

Malaria y la Tuberculosis sus proyectos para obtener fondos. La UE, por su

parte, acaba de anunciar la creación de la Alianza Europea contra la Malaria.

Sin embargo, es inevitable recordar que estos organismos han recibido en años

anteriores críticas por su gestión de la lucha contra la malaria y que, en

muchas ocasiones, las donaciones de los países pudientes dejan mucho que desear.

Según un informe de la

Organización para la Cooperación y el Desarrollo

Económicos, las contribuciones de Occidente

durante 2006 disminuyeron un 5%.

El abordaje de la enfermedad 'sobre el terreno' también presenta sus luces y

sombras. En los últimos años ha aumentado en empleo de mosquiteros impregnados

con antimosquitos (una solución simple y barata para prevenir la picadura del

Anopheles). Sin embargo, al mismo tiempo, se está produciendo un aumento de las

resistencias a los tratamientos antimaláricos.

Fuente: El Mundo, 25 de Abril de 2007

-López-Alegría: Desde el espacio uno se da cuenta de que no hay fronteras

Los astronautas estaban al caer cuando

Jordi Gasull, miembro voluntario del grupo de apoyo psicológico de la

NASA,

se palpó el trozo de jamón ibérico que llevaba oculto bajo su forro polar. La

misión 'pata negra' seguía adelante.

Con ochocientos gramos de jamón

escondidos bajo su pelliza, Gasull acudió a bordo de un helicóptero Mi-8 el

pasado sábado al encuentro de su amigo, el astronauta de la NASA Miguel

López-Alegría (Madrid, 1958), que aterrizó en las yermas planicies de Kazajistán

a bordo de la cápsula Soyuz TMA-9, donde también viajaban el ruso Mijail Tiurin

(autor el pasado noviembre del primer golpe de golf en el espacio) y el quinto

turista espacial, el multimillonario de origen húngaro Charles Simonyi, uno de

los cerebros pioneros de Microsoft.

Integrado en el equipo de rescate, Gasull tenía la sana intención de cambiar la

clásica manzana con que celebran los astronautas su encontronazo con la ley de

la gravedad por el jamón ibérico. ¿Qué mejor reconstituyente para un español

tras una odisea de siete meses en el espacio? "Lo sabía. Sabía que me lo

traerías", le dijo López-Alegría nada más ver la mercancía en cuanto salió de la

cápsula.

Aunque los médicos de la NASA desaconsejaron la ingesta 'in situ' del jamón

debido al delicado estado de su estómago, López-Alegría no ha tardado ni

veinticuatro horas en hincarle el diente.

Después de permanecer 215 días en órbita como comandante de la XIV misión

tripulada de la Estación Espacial Internacional (es el primer español que llega

tan alto), López-Alegría ya camina y se recupera satisfactoriamente en una

clínica de la Ciudad de las Estrellas, el centro de entrenamiento de astronautas

a las afueras de Moscú.

Al igual que hizo cuando se subió al cohete Soyuz en el cosmódromo de Baikonur (Kazajistán),

el pasado mes de septiembre, López Alegría, profirió al poco de aterrizar un "¡salut

y força al canut!" dirigido a su amigo Jordi Abusada, director de fotografía que

le sigue como un satélite inseparable con su cámara para grabar un documental

sobre el mundo interior de los astronautas.

Hace unos años Abusada ya estuvo tres meses en la NASA y rodó a López-Alegría en

Houston y Cabo Cañaveral para la película documental 'Mira la Luna' de Elías

Querejeta que se estrenará próximamente.

P. En tus siete meses en órbita has batidos dos récords, el de mayor número de

horas en paseos espaciales (67 horas y 40 minutos en diez salidas), así como el

récord de permanencia en órbita jamás logrado por un astronauta de la NASA...

R. Los récords sólo muestran el trabajo bien hecho. Además, están hechos para

ser batidos. Mi compañera Suni Williams batirá pronto mi récord de permanencia.

Me satisface como anécdota, pero nada más.

P. Este año Rusia celebra el 50º aniversario del lanzamiento del 'sputnik' y del

comienzo de la carrera espacial. ¿Cómo ves el papel de Rusia en el futuro de la

aventura espacial?

R. El papel de Rusia será cada vez más importante en los próximos años, ya que a

partir de 2010, cuando el transbordador deje de funcionar y hasta que esté lista

la nueva nave que irá a la Luna, la estación estará en manos de los rusos. Ellos

van a tener un papel fundamental en la continuidad del trabajo en el espacio.

Creo que es importante recordar que la estación es un proyecto de cooperación

internacional y que el futuro del espacio pasa por el diálogo y el entendimiento

de todas las naciones.

P. ¿Cómo has visto la Estación Espacial Internacional? ¿Crees que es un proyecto

con futuro o crees que -como auguran algunos críticos- los planes de EE.UU. para

viajar a la Luna o a Marte pueden condenarla a desaparecer?

R. Yo diría que la Estación Espacial es un paso, un eslabón más para poder

llegar a la Luna y a Marte. Hay que entender que en la ISS se desarrollan

experimentos que permiten estudiar las consecuencias de las largas estancias en

el espacio para el ser humano y el efecto de las radiaciones solares. Pensemos

que un viaje a Marte duraría no menos de 18 meses.

Fuente: El Mundo, 25 de Abril de 2007

-Detectives de toxinas, metales pesados y malas medidas

Frutas emponzoñadas por hongos tóxicos,

atún contaminado con metales cancerígenos, salmones ahumados con hidrocarburos

aromáticos policíclicos (HAP) que, a pesar de lo amable de su adjetivo

intermedio, pueden causar mutaciones genéticas. El peor menú imaginable se sirve

sobre las poyatas de laboratorio del

Instituto de Materiales de Referencia y Medidas (IRMM)

en Geel (Bélgica), institución de referencia europea en la metrología, la

ciencia de la medición.

Afortunadamente, su propósito no es

gastronómico: la Comisión Europea ha inaugurado recientemente tres nuevos

laboratorios en el IRMM. Se dedicarán a mejorar el análisis de la presencia en

alimentos de micotoxinas (toxinas de los hongos), de metales pesados como el

mercurio, el cadmio y el plomo, y de los HAP. El objetivo es que todos los

laboratorios de los 27 países miembros de la UE detecten por igual estas

sustancias perjudiciales para la salud.

Una red de unos 1.200 laboratorios de referencia vigila la calidad alimentaria

en Europa, pero sólo 40 cuentan con el máximo rango, el de laboratorios de

referencia comunitaria. Como los tres nuevos del IRMM.

El fantasma de las crisis en seguridad alimentaria que han venido alarmando

Europa en los últimos años sobrevuela los discursos de inauguración: vacas

locas, lengua azul, dioxinas del pollo o gripe aviaria. En palabras del

comisario europeo de Salud y Protección del Consumidor, el chipriota Markos

Kyprianou, el objeto de instalaciones como éstas es que en el continente se siga

consumiendo "la comida más segura del mundo". Jörg Stroka, director del

laboratorio de micotoxinas, matiza: "Sí, pero puede mejorarse".

No es casual que los nuevos laboratorios se instalen en el IRMM. La función de

este instituto es homogeneizar las referencias de medición, medir las medidas, y

actuar como un laboratorio de laboratorios: "Asesoramos a los laboratorios que

no hacen las cosas bien", dice el onubense Alejandro Herrero, bioquímico y

doctor en tecnología alimentaria. Herrero es director del IRMM desde 2002 y no

oculta que existen "deficiencias" en algunos países nuevos, "aunque el proceso

de adhesión ha sido muy intenso".

Piotr Robuch dirige el nuevo laboratorio de metales pesados. En referencia a las

crisis de seguridad alimentaria se pregunta: "¿En situaciones de riesgo quién

tiene la razón? ¿La industria o el consumidor? La primera pregunta que nos

hacemos es, sea lo que sea: ¿Se ha medido bien? Los ciudadanos tienen derecho a

saber quién está comprobando la seguridad de nuestra comida. Y qué calidad del

control en seguridad se ha realizado. Y los operadores de comida pueden

preguntarse: "¿Estamos siendo controlados por laboratorios de confianza?".

La seguridad alimentaria también es cuestión de rapidez: "si a un puerto de

Europa llega un barco con mercancías sospechosas, ¿se descarga o no?", se

cuestiona Stroka. "Si no se hace bien el análisis, se puede estar poniendo en

riesgo la salud de los consumidores. Si se tarda demasiado en hacer los

análisis, puede perderse una mercancía en buen estado", añade.

Herrero destaca que su instituto es independiente de los grupos de presión de la

industria alimentaria. "Aquí medimos las medidas y contribuimos así a lograr

confianza en ellas y a asegurar que sean comparables". En pocas palabras, que la

calidad de un paquete de harina comprado en Malta se haya comprobado igual que

la de uno adquirido en Lituania. O que el kilo de plátanos que un supermercado

vende en Portugal se haya pesado igual que si se hubiera vendido en Estonia.

El IRMM, al igual que otros centros comunes de investigación de la Comisión

Europea, ayuda a elaborar las políticas de la UE y las pone en práctica. El

reciente Séptimo Programa Marco de I+D refuerza el papel orientativo de estos

centros y su conexión con la comunidad científica, y destina 1.751 millones de

euros a su financiación. Más de 2.700 personas en toda Europa trabajan en ellos.

Y colaboran con más de mil organizaciones públicas y privadas.

La confianza de la Comisión Europea en el IRMM se puede medir en términos

económicos, según Herrero. El diagnóstico de la encefalopatía espongiforme

bovina, las vacas locas, que supone un gran impacto económico, ha reducido su

coste en unos 250 millones de euros gracias a medidas propuestas por el IRMM.

Esta cantidad supera su presupuesto para los próximos siete años.

Hasta un 20% de todos los productos alimenticios, especialmente los de origen

vegetal, pueden verse afectados por micotoxinas. La dificultad de su análisis

estriba en que a menudo afectan sólo a una parte del alimento. Como forzosamente

hay que analizar una muestra, se corre el riesgo de que se escape la parte

infectada. El IRMM ha desarrollado una novedosa técnica de muestreo que permite

recoger una parte de partículas de la superficie del alimento.

Stroka ilustra en la presentación del laboratorio que dirige: "En la Edad Media,

el ergot alcaloides causó grandes estragos entre la población, que sufría el

fuego de San Antonio, una urticaria que retrató Peter Brueghel en sus cuadros".

Hoy, las micotoxinas siguen siendo a veces un enemigo difícil de prever. Así

ocurre con las T-2 y las HT-2, frecuentes en Escandinavia, que aparecen en la

naturaleza sin que se sepa bien la causa. La lista, además, sigue creciendo:

"Pensamos que el cambio climático pueda tener repercusiones en el surgimiento de

nuevas micotoxinas", señala Stroka.

Los metales pesados que ayuda a analizar el IRMM también causan importantes

daños. El cadmio -que contienen las pilas eléctricas-, se acumula en los riñones

y los ataca, al igual que al sistema respiratorio. El plomo -presente en las

cañerías antiguas- destruye neuronas, como el mercurio, fundamentalmente de

origen industrial, que también es cancerígeno. El nuevo laboratorio los buscará

con técnicas avanzadas en el pescado. Y ya ha contribuido a regularizar más de

2.000 laboratorios para adaptarlos a los estándares europeos.

Los HAP, presentes en los alimentos ahumados y en los cocinados en barbacoa,

pueden tener efectos cancerígenos y causar mutaciones en el ADN. Su detección es

fundamental. Thomas Wenzel, el director del laboratorio específico, se maravilla

de los avances en el terreno: "Ya somos capaces de identificar tan sólo 2 gramos

de HAP dispersos en mil toneladas de material".

Además de estos laboratorios, el IRMM se dedica a otras aplicaciones de la

metrología. "Nuestro reto", apunta su director, "es medir las biomoléculas. Una

proteína no es una especie molecular única, sino una familia de moléculas.

Dentro de ellas puede que sólo sea una la que es tóxica y hay que detectar

exactamente cuál".

Además, el IRMM acoge uno de los centros de apoyo del proyecto internacional

Avogadro. Toma su nombre de la constante de Avogadro, el número de átomos de

carbono 12 contenidos en 12 gramos de este elemento. El proyecto intenta

encontrar una referencia física para la unidad de masa, el kilogramo.

Sustituiría a la actual unidad, un cilindro de platino e iridio guardado en

París."La cuestión es saber qué parte de esa materia -el kilo- equivale

exactamente a un número de veces el número de Avogadro. Medir la constante es

fundamental", indica Philip Taylor, investigador principal del proyecto.

Del iridio y el platino se ha pasado a usar tres isótopos de silicio, 28, 29 y

30, un material muy puro producido en Siberia con la tecnología del uranio. Así

se ha logrado un grado de incertidumbre de sólo 0,0000002, pero todavía es

necesario llegar al octavo decimal, uno más, para que la incertidumbre sea

despreciable y el kilo guardado en París pase a la historia. "El IRMM es el

único instituto del mundo capaz de hacer esa medida en preparados de silicio

para calcular el número de átomos, su densidad y llegar a una definición del

kilogramo con una precisión absoluta", asegura Taylor, para quien lograr ese

gemelo eterno del kilo de París, llevará aún dos o tres años.

Fuente: El País, 25 de Abril de 2007

-Descubren el primer planeta habitable fuera del Sistema Solar

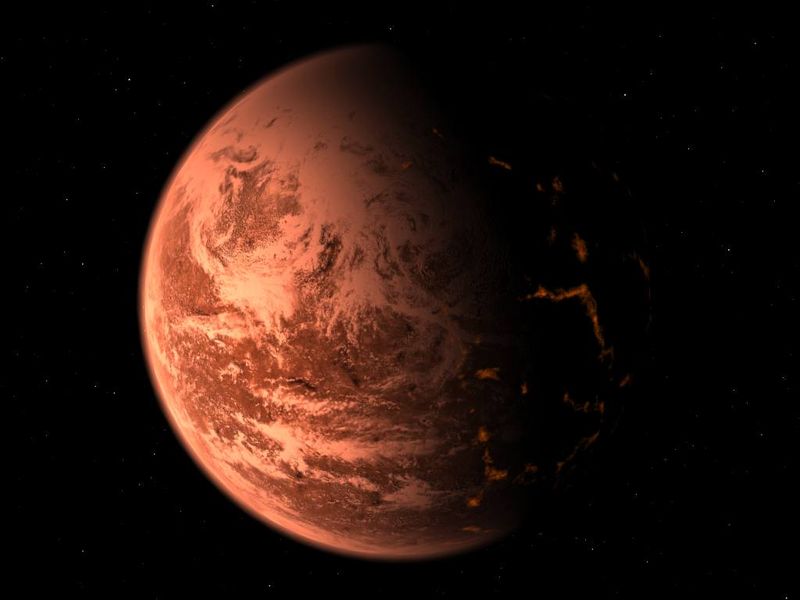

Un equipo de astrónomos de Suiza, Francia y Portugal acaba de anunciar el descubrimiento del primer planeta extrasolar que podría, por lo menos hipotéticamente, ser habitado por el hombre. O lo que es lo mismo, el primer planeta hallado más allá de las fronteras de nuestro Sistema Solar y cuyas condiciones son parecidas a las de la Tierra.

Recreación artística del planeta

El nuevo mundo, con un diámetro apenas

un 50% mayor que el terrestre y una masa cinco veces superior, reúne, en efecto,

las condiciones necesarias para disponer de agua en estado líquido, el

ingrediente fundamental de la vida. Se trata del planeta extrasolar más pequeño

y similar al nuestro de los cerca de dos centenares que han sido descubiertos

hasta ahora. La «súper Tierra», término con el que se refieren los astrónomos al

hallazgo, gira alrededor de Gliese 581, una estrella bien conocida por los

científicos, más pequeña y fría que el Sol.

Se trata de una «enana roja» que se encuentra en la constelación de Libra, a

20,5 años luz de distancia (recordemos que un año luz equivale a casi diez

billones de kilómetros) y en cuya órbita ya se habían descubierto otros dos

planetas, gigantes gaseosos con quince y ocho masas terrestres, mucho más

parecidos a Neptuno que a nuestro propio mundo.

El nuevo planeta «viaja» alrededor de su astro mucho más deprisa que la Tierra

alrededor del Sol, y efectúa una órbita completa cada trece días. Además, se

encuentra catorce veces más cerca de Gliese 581 de lo que la Tierra está de su

estrella particular. Sin embargo, debido a las diferencias de tamaño,

luminosidad y temperatura entre Gliese 581 y el Sol, el nuevo mundo está

exactamente en la «zona habitable» de su estrella, una estrecha franja orbital

en la que un planeta debe estar situado para que en él se den las condiciones

necesarias para la vida.

MUY FRÍOS O MUY CALIENTES

Alrededor de cada estrella, según su tamaño y temperatura, la «zona habitable»

es el área concreta en la que sería posible que se formara un planeta con agua

en estado líquido. Los mundos que se encuentran fuera de esta zona quedan, en

principio, descartados como candidatos. En efecto, si estuvieran más cerca de la

estrella, serían tan calientes que cualquier resto de agua se evaporaría al

instante, como es el caso de Mercurio en nuestro Sistema Solar. Si estuvieran

más lejos, serían tan fríos que el agua sólo sería posible en forma de hielo,

como sucede en Marte. Para nuestro Sol, la zona habitable se encuentra

exactamente entre las órbitas de Venus y Marte. Lugar que ocupa nuestro propio

mundo, la Tierra.

El segundo factor que se tiene en cuenta es el tamaño y la masa del planeta

candidato. Los mundos con menos de la mitad de la masa terrestre no tienen

gravedad suficiente para retener una atmósfera bajo cuyo abrigo pueda

desarrollarse la vida, como sucede, una vez más, con Marte. Y al otro extremo,

los planetas con una masa superior a diez veces la de la Tierra tienen gravedad

suficiente para seguir atrayendo gases y elementos abundantes en el espacio,

como hidrógeno y helio, y terminan por convertirse en gigantes gaseosos, como es

el caso, en nuestro sistema, de Júpiter, Saturno, Urano y Neptuno.

ENTRE 0 y 40 GRADOS

Pero la «Súper Tierra» descubierta alrededor de Gliese 581 cumple ambos

requisitos: está en la zona habitable de su estrella y no tiene más de cinco

masas terrestres. «Estimamos -afirma Stéphane Udry, del

Observatorio de Ginebra y

coautor del descubrimiento- que la temperatura en esta «Súper Tierra» debe

oscilar entre los 0 y los 40 grados, con lo que el agua debería ser líquida.

Además -añade-su radio es 1,5 veces el de la Tierra, y los modelos existentes

predicen que el planeta debería ser rocoso, como nuestra Tierra, o cubierto por

océanos».

«Por lo que sabemos -asegura por su parte Xavier Delfosse, del

Observatorio de Grenoble,

en Francia, y también miembro del equipo- el agua líquida es crítica para la

vida. Y a causa de la temperatura y de su relativa proximidad, este planeta se

convertirá probablemente en un importante objetivo para futuras misiones

espaciales dedicadas a la búsqueda de vida extraterrestre. En el mapa del tesoro

del Universo, uno estaría tentado de marcar este mundo con una «X»».

LAS MÁS ABUNDANTES

Gliese 581 se encuentra entre las cien estrellas más cercanas a la Tierra. Se

trata de una «enana roja», la clase de estrellas más abundantes en nuestra

galaxia, pequeñas y relativamente frías (con temperaturas superficiales que

rondan los 3.500 grados, la mitad que el Sol). «Las enanas rojas -dice Xavier

Bonfill, otro de los autores del estudio, de la

Universidad de Lisboa-

son los objetivos ideales para buscar planetas de baja masa en los que pueda

haber agua en estado líquido. Debido a que emiten menos luz, las «zonas

habitables» de estas estrellas están mucho más cerca de ellas de lo que sucede

en el Sol». El descubrimiento se ha realizado gracias al espectrógrafo HARPS, en

el telescopio de 3,6 metros en

La Silla, en Chile.

Fuente: ABC, 25 de Abril de 2007

-A un paso de la visión artificial

La visión es el más útil y apreciado de

los sentidos humanos. No es para menos, ya que los científicos calculan que más

del 40 por ciento de toda la información que llega al cerebro lo hace a través

del sistema visual. La

OMS estima que en el

mundo hay más de 65 millones de ciegos, y que en los próximos quince años la

cifra se puede duplicar.

Durante más de dos milenios de

Medicina, la posibilidad de devolver la visión a los ciegos ha sido una utopía,

pero los avances en Oftalmología, Genética, Ingeniería... sugieren desde hace

décadas que hay luz al final del túnel en determinados tipos de ceguera.

La degeneración macular, la retinitis pigmentosa, el glaucoma o los traumas

oculares son algunas de las principales causas de la ceguera y se deben, todas

ellas, a la inutilización del ojo, órgano de la visión, pero estas causas no

anulan el resto del sistema visual -nervios, tálamo o corteza cerebral-. En

relación a estos casos se investiga desde 1918 la posibilidad de generar

mediante impulsos eléctricos externos en la corteza cerebral percepciones

subjetivas de luz, denominadas fosfenos, que reemplacen las señales que el ojo

transmite al cerebro. Con impulsos eléctricos, al fin y al cabo, trabaja el

sistema nervioso.

REPRODUCIR EL «MAPA VISUAL»

Hasta ahora, dos son los campos abiertos en estas investigaciones: la

implantación de electrodos en determinadas zonas de la retina, que reproducen la

función neuronal de los conos y los bastones; e implantar electrodos en la

corteza cerebral, concretamente, en la región primaria del córtex, la V1, en la

que se reproduce el «mapa visual» enviado por la retina. Ambas técnicas han

logrado resultados prometedores, pero muy limitados en los dos casos.

Ahora, un equipo de investigadores del Departamento de Neurobiología de la

Escuela de Medicina de Harvard,

encabezados por John S. Pezaris y R. Clay Reid, ha abierto una tercera vía para

atacar el problema. Han probado que la estimulación eléctrica del sistema visual

puede facilitar mucho el diseño y la aplicación de elementos protésicos para

solucionar o mitigar la ceguera si dichos estímulos se aplican, mediante

electrodos, directamente al centro de proceso de datos de la visión, es decir,

al tálamo, y más en concreto a su núcleo geniculado lateral dorsal (NGL), que es

la región que recibe las señales de la retina, las procesa y, posteriormente,

las remite a la región V1 del córtex cerebral, en la que se reciben y analizan

los distintos mensajes de la visión -colores, tamaños, profundidad,

movimientos...-.

La investigación, publicada en «PNAS»,

la revista de la Academia Nacional de Ciencias estadounidense, detalla cuatro

razones por las cuales es más eficaz la implantación de electrodos en el núcleo

geniculado que en el córtex cerebral.

La primera es que el campo receptor de las neuronas del NGL es simple y similar

al de la retina, pero la estimulación neuronal es más sencilla. La segunda,

porque presenta una mayor respuesta a las corrientes funcionales, en particular

a las enviadas por los sistemas magnocelular y parvocelular de la retina. La

tercera, es que una sencilla craneotomía permite, por medio de un tubo de

diámetro muy pequeño, implantar los electrodos de forma que reproduzcan la mayor

parte del campo visual, con especial atención a las neuronas que recogen la

información enviada por la fóvea, la parte de la retina que, en los primates,

carece de bastones, pero presenta una gran cantidad de conos y es el punto de

máxima agudeza visual. Cuarta y más importante razón: el acceso quirúrgico al

NGL requiere de muy pocas innovaciones y es una técnica conocida, ya que el

núcleo geniculado lateral dorsal es adyacente a las regiones cerebrales que se

estimulan en la actualidad con electrodos como terapia contra enfermedades como

el párkinson.

Los experimentos desarrollados por Pezaris y Reid se llevaron a cabo sobre dos

macacos -macho y hembra- sanos, es decir, sin perturbaciones en su sentido de la

visión. Les fueron implantados electrodos de tungsteno en diferentes

localizaciones del NGL.

IMPULSOS ELÉCTRICOS

En el experimento se examinó el impulso eléctrico que llegaba al núcleo

geniculado lateral dorsal cuando los monos veían sobre una pantalla de ordenador

puntos luminosos -inmóviles, en movimiento, de mayor o menor intensidad...-. La

información fue recogida en una base de datos o «mapa visual». El siguiente paso

en el experimento fue examinar los movimientos de los ojos de los macacos en

respuesta a la estimulación eléctrica del tálamo.

Los investigadores comprobaron que los monos, durante la estimulación eléctrica,

dirigían su mirada hacia los puntos de la pantalla correspondientes a la

localización del electrodo en la región del cerebro estimulada, de acuerdo con

el «mapa visual» elaborado anteriormente, con más de un 80 por ciento de

aciertos. La «exactitud» del método fue comprobada en centenares de

localizaciones, con diferentes intensidades y voltajes, con resultados «muy

satisfactorios».

Este hecho prueba que el sistema visual del primate, similar al del ser humano,

recibió, procesó y reaccionó al estímulo eléctrico como si de una señal visual

se tratase.

Los investigadores concluyen en su trabajo que el núcleo geniculado lateral

dorsal del tálamo (NGL) es el lugar más apropiado para conectar al cerebro un

sistema protésico de visión artificial.

Fuente: ABC, 24 de Abril de 2007

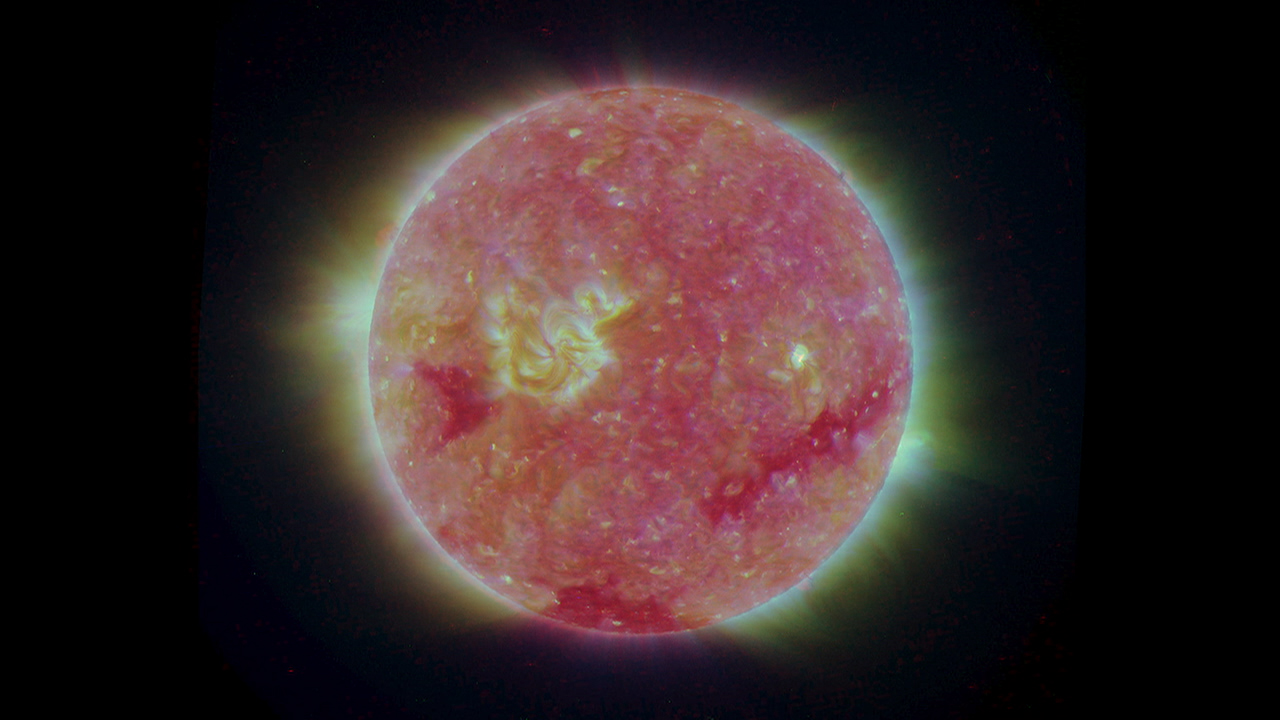

-Primeras imágenes del Sol en tres dimensiones

Un equipo de científicos de la Universidad de Gales, en el Reino Unido, ha obtenido las primeras imágenes en tres dimensiones del Sol a partir de los datos enviados por el Observatorio de Relaciones Terrestres Solares (STEREO) de la NASA.

"Por primera vez" -dice la agencia en

un comunicado- "los científicos podrán ver las estructuras de la atmósfera del

Sol en tres dimensiones, lo que les será de gran ayuda para comprender la física

solar, así como para mejorar la predicción de las tormentas solares".

Según los autores, se trata "del mayor avance de la ciencia solar de los

últimos diez años".

Los científicos han desarrollado un programa que convierte en imágenes en tres

dimensiones los datos que envían las dos sondas del observatorio STEREO que,

desde el pasado mes de octubre, están en dos órbitas distintas en torno al Sol.

Las dos naves pueden detectar las turbulencias de las partículas de alta energía

que ocurren en la corona solar, también denominadas erupciones solares, un

fenómeno que puede tener graves consecuencias sobre astronautas, satélites e

incluso la Tierra, puesto que afectan gravemente a las comunicaciones.

Hasta ahora, "cuando había una erupción (solar) y el Sol desprendía materia al

espacio, sólo podíamos verlo en plano, en dos dimensiones, a pesar de que era

una estructura en tres dimensiones", explicó Andy Breen, un de los responsables

de la investigación, que remarcó la importancia de este avance para entender las

"complejas estructuras de la atmósfera solar".

"Va a revolucionar nuestros conocimientos sobre el Sol y sobre el modo en que la

Tierra y el Sol están conectados", añadió el científico, quien participa además

en la misión para la Investigación Coronaria y Heliosférica de la Conexión entre

el Sol y la Tierra (SECCHI) de la Administración Nacional de la Aeronáutica y el

Espacio de EE.UU. (NASA).

Las imágenes a simple vista parecen de tonalidades grises, puesto que para verse

en tres dimensiones hacen falta unas gafas que la NASA ayuda a fabricar en casa.

Basta un poco de cartulina, acetato, plástico de colores, pegamento o celofán y

una buena dosis de paciencia, que junto con algo de maña permiten a cualquier

aficionado disfrutar de unas imágenes nunca antes vistas de nuestro astro rey.

Fuente: El Mundo Digital, 24 de Abril de 2007

-Un telescopio extremadamente grande para Canarias

España apuesta "firmemente" por que se

ubique en el Observatorio del Roque de los Muchachos, en la isla canaria de La

Palma, el ambicioso proyecto de Telescopio Europeo Extremadamente Grande (E-ELT),

promovido por el

Observatorio Europeo Austral (ESO),

un organismo al que acaba de adherirse España.

Así lo manifestó Xavier Barcons, jefe

de la Delegación española en ESO, que es el Centro Europeo para la Investigación

Astronómica en el Hemisferio Sur y el principal organismo mundial del ámbito

europeo en el campo de la astrofísica, integrado por Alemania, Bélgica,

Dinamarca, Finlandia, Francia, Italia, Países Bajos, Portugal, Reino Unido,

Suecia y Suiza, aparte de España.

Esta semana la directora general del Centro Europeo para la Investigación

Astronómica en el Hemisferio Sur (ESO, sus siglas en inglés), Catherine Cesarsky,

junto con la ministra de

Educación y Ciencia,

Mercedes Cabrera, presentaron públicamente durante un acto celebrado en Madrid,

la adhesión de España a este organismo.

Actualmente, ESO trabaja con astrónomos y astrofísicos para definir un nuevo

telescopio gigante para la próximo década, el E-ELT, que con un espejo primario

de 42 metros de diámetro compuesto por 906 segmentos hexagonales y un espejo

secundario de 6 metros de diámetro será clave en el futuro en la observación

astronómica en la banda óptica e infrarroja desde Tierra.

Con ese diámetro de 42 metros y su sistema de óptica adaptativa, el E-ELT

superará en más de 100 veces la sensibilidad de los mayores telescopios ópticos

actuales y permitirá grandes avances en el conocimiento astrofísico,

posibilitando estudios detallados de planetas extrasolares, de los primeros

objetos que se formaron en el Universo o de agujeros negros supermasivos.

Entre las ubicaciones del mismo, se manejan dos, dijo Barcons, la del Roque de

los Muchachos (Canarias), junto al Gran Telescopio de Canarias (GTC), pero

también Chile, en donde ESO opera tres observatorios; los planes de ESO es que,

en menos de dos años esté decidido dónde se situará el E-ELT, agregó.

Esa decisión respecto a la futura ubicación del telescopio es fundamental para

el diseño del proyecto, ya que sus características variarán en función de dónde

se sitúe. Así, por ejemplo, explicó, si se erigiera en Chile, el telescopio

debería dotarse de elementos capaces de soportar movimientos sísmicos.

Según Barcons, que es además miembro del

Instituto de Física de Cantabria (IFCA),

algunas de las tecnologías usadas para la construcción del GTC se usarán en el

E-ELT de 40 metros, "lo que confirma que España dispone de empresas e industrias

que han adquirido experiencia muy competitiva en tecnologías clave en el plano

internacional".

Uno de los planteamientos expresados por España desde el inicio de las

negociaciones con ESO, al que se adhirió formalmente el pasado 14 de febrero, es

que el Telescopio Europeo Extremadamente Grande se ubicara en el Observatorio

del Roque de los Muchachos. "El apoyo que daría España a esta posibilidad sería

muy decidido", dijo.

Precisamente una parte importante del diseño de este telescopio consiste en

buscarle una ubicación, y para ello, prosiguió, "se está haciendo un trabajo

técnico de prospección de la calidad de las distintas posibles ubicaciones".

"Creemos que sería muy conveniente para Europa que este telescopio de ESO

pudiera estar en territorio europeo", y para ello, explicó Barcons, la

delegación española pondrá en su día sobre la mesa "un estudio muy serio", no

sólo técnico, sino también político y económico sobre las ventajas de instalar

el proyecto en Canarias.

El coste estimado para su diseño, construcción e inicio de operaciones es de

unos mil millones de euros.

Fuente: EFE, 23 de Abril de 2007

-Un nuevo micro-robot para operar el corazón

Mide apenas dos centímetros y se mueve

como una oruga. Se trata de un pequeño robot que se introduce en el pecho a

través de una pequeña incisión y puede desplazarse por la superficie del corazón

para aplicar tratamientos o insertar dispositivos como los marcapasos.

Las posibilidades de este aparato,

llamado HeartLander, suenan a ciencia ficción, pero ya han sido probadas con

éxito en cerdos vivos.

Científicos estadounidenses de la

Universidad de Carnegie Mellon de Pittsburgh (EE.UU.)

trabajan en este prototipo que podría acabar con las operaciones a corazón

abierto que requieren anestesia general y la retirada de algunas costillas,

provocando recuperaciones largas y complicadas.

OPERACIONES CON ANESTESIA LOCAL

Sus creadores afirman que, si la investigación tiene éxito, gracias al robot

podrían realizarse en un futuro operaciones cardiacas mientras el corazón sigue

latiendo, sin necesidad de abrir la caja torácica y usando simplemente anestesia

local.

Según recoge la revista

New Scientist, el

dispositivo se introduce en el pecho del paciente a través de una pequeña

incisión y, después, se acopla en la superficie del corazón. A través de una

especie de ventosas que lleva instaladas, el pequeño robot puede desplazarse por

la zona en un movimiento que emula al que realiza una oruga y que es controlado

por los científicos desde el exterior con un joystick. En total, el dispositivo

puede recorrer 18 centímetros en un minuto.

El robot lleva acoplada una aguja que permite inyectar determinados fármacos o,

incluso, podría usarse para la aplicación de células madre en determinados

tejidos dañados.

En los experimentos realizados en cerdos, a los que se les implantó un

marcapasos y aplicó un líquido similar al de algunos fármacos, el pequeño robot

se desplazó por todo el corazón sin ningún problema.

En este sentido, los científicos destacan que esta técnica podría ser muy útil

para llegar a algunas zonas del corazón que no son fácilmente accesibles

mediante la cirugía tradicional.

"Muchas operaciones pueden realizarse introduciendo instrumentos en el corazón a

través de las venas, pero esto no es posible si existe tejido dañado o enfermo

cerca de la superficie del corazón. Este dispositivo sí sería útil en esos

casos", explica el cardiólogo británico Andrew Rankin en declaraciones a

NewScientist.

En este momento, los investigadores trabajan en varios puntos para mejorar el

funcionamiento del robot. Entre otras cosas, piensan en incluir una cámara o

sonda de radiofrecuencia que podría servir, por ejemplo, para el tratamiento de

las arritmias.

Con todo, los científicos reconocen que aún faltan muchos años para que este

dispositivo pueda utilizarse en humanos.

Fuente: El Mundo Digital, 20 de Abril de 2007

-Cobertura para 700 científicos desde un gran centro de biomedicina

La investigación sobre células madre,

la nanociencia, estudios clínicos sobre diversas enfermedades o el campo de la

medicina regenerativa son algunas de las parcelas que cubrirá el nuevo Centro de

Investigación Biomédica de Aragón (CIBA), cuyo proyecto fue presentado en

Zaragoza.

Desde estas instalaciones se dará

cobertura al trabajo de setecientos investigadores, según destacó la consejera

aragonesa de Salud, Luisa Noeno, quien explicó que el CIBA se edificará sobre un

solar de 2.140 metros cuadrados y que en la construcción de este centro se

invertirán más de 13 millones de euros.

El CIBA pretende convertirse en un centro de referencia en la investigación

médica en España y ser una plataforma básica de apoyo al trabajo de cientos de

investigadores en un amplio número de disciplinas de biomedicina.

El proyecto de edificación arranca el proceso para que se convierta en una

realidad. La previsión apunta a que estará listo en el año 2009.

El director del

Instituto Aragonés de Ciencias de la Salud,

Esteban de Manuel, afirmó que este centro, que calificó de «avanzado y

completo», será una «pieza clave» para la investigación sanitaria de esta

Comunidad Autónoma y que se plantea, entre otros objetivos, generar conocimiento

acorde con las necesidades sanitarias de los aragoneses, resultar competitivo y

ser capaz de que los resultados de su trabajo den lugar a retornos económicos.

En el CIBA trabajarán alrededor de 160 personas entre las áreas de gestión,

unidades y grupos de investigación, infraestructuras y servicios. El edificio

tendrá cinco plantas, que sumarán un total de 4.500 metros cuadrados útiles.

Incluirá, entre otras dotaciones, unidades de transgénesis, equipos de

resonancia magnética, cuatro quirófanos y laboratorio de microcirugía, cultivo y

separación celular, ácidos nucleicos, protómica, anatomía patológica y

microscópica, así como áreas para grupos de investigación clínica y básica.

Fuente: ABC, 20 de Abril de 2007

-El deshielo en el casquete polar glaciar de Groelandia duplica las previsiones

La aceleración del deshielo en el casquete glaciar de Groenlandia en los últimos 25 años duplica lo que se pensaba y equivale a un tercio de la superficie de Francia, informó el Centro Nacional francés de Investigación Científica (CNRS).

Entre 1979 y 2005, la superficie de Groenlandia afectada por

el deshielo al menos un día al año aumentó en un 42%, mientras que la

temperatura media de la estación estival aumentó 2,4 grados centígrados.

El norte de Groenlandia es donde el fenómeno se hace más espectacular, con

episodios importantes de deshielo que han sido observados desde el año 2000 a

más de 1.500 metros de altitud, algo nunca registrado antes por los satélites,

según el CNRS.

Se trata de los resultados de un estudio efectuado por investigadores del

Laboratorio de

glaciares y geofísica del medioambiente (LGGE), con sede en Grenoble

(sureste de Francia), y de la

Universidad católica de Lovaina, en Bélgica.

Otros científicos franceses han demostrado la teoría planteada en 1998 por los

estadounidenses Paul Hoffman y Daniel Schrag de que la Tierra era una bola de

nieve hace 715 millones de años, informa la Academia de Ciencias en su sitio de

Internet.

Esa demostración y recreación del escenario posible de la primera glaciación del

planeta ha sido efectuada en el marco del programa "Eclipse" (Medioambiente y

clima del pasado: historia y evolución), lanzado en 2000 por el CNRS.

Fuente: EFE, 20 de Abril de 2007

-Descubierta una proteína en la sangre humana que actúa contra el virus del sida

La clave para el control de la infección del VIH podría estar en la sangre de los propios afectados. Investigadores de la Universidad alemana de Ulm han descubierto que una proteína -llamada por eso inhibidora de virus- se une al agente infeccioso e impide que entre en los linfocitos. El hallazgo se publica hoy en la revista Cell.

Los científicos llevan casi desde el principio de la epidemia

buscando una explicación para la variabilidad de la actuación del VIH en las

personas. En unas, bastan pocos meses para que, si no recibe medicación, el

sistema inmunitario se destruya y aparezca el sida. Otras, sin embargo, viven

durante años -hay casos registrados de más de dos décadas- sin tomar pastilla

alguna y sin desarrollar la enfermedad. La presencia del péptido identificado

podría explicar esta situación.

Pero, aparte de saciar una curiosidad, el hallazgo puede tener a medio plazo

efectos prácticos. Si se desarrolla un fármaco o un tratamiento genético que

estimule la producción de este péptido, se podría disponer de un nuevo

medicamento para controlar la infección.

Este fármaco tendría dos ventajas: por un lado, al tratarse de una proteína

humana, se supone que sus efectos secundarios serían mucho menos agresivos que

los de los antivirales que se usan actualmente. Por otro lado, como el péptido

actúa bloqueando el virus e impidiendo que entre en los glóbulos blancos, se

abre una nueva línea terapéutica que serviría para tratar los casos en los que

el virus ha desarrollado resistencias a los fármacos ya existentes.

Fuente: El País, 19 de Abril de 2007

-Investigadores en auxilio de Arquímedes

Un mecenas cuya identidad se mantiene en secreto, un mohoso libro de oraciones del siglo XIII que se ha reescrito sobre documentos mucho más antiguos de trabajos de Arquímedes y una red de investigadores que recurren a las técnicas más modernas y a los mejores expertos sobre el saber más antiguo son los elementos de un detectivesco proyecto de investigación en el que las ciencias experimentales ayudan a revelar la historia.

Dos de estos expertos, Revel Nezt y William Noel, cuentan en

El código de Arquímedes (Editorial Temas de Hoy) los detalles de este curioso

proyecto de investigación, que comenzó en 1999 y todavía no ha terminado.

España es el primer país en que se publica este libro, cuyos autores iniciaron

la investigación que pronto se convirtió en el Proyecto Palimpsesto, privado,

que utiliza herramientas de integración de sistemas y planificación estratégica.

Lo está financiando el todavía desconocido comprador del manuscrito (por dos

millones de dólares), cuando éste salió a la luz en una subasta en Nueva York en

1998 tras mantenerse oculto y minusvalorado durante casi todo el siglo XX. Según

los autores, se ha confirmado que es el manuscrito más antiguo que existe sobre

Arquímedes, el único que contiene en griego original el famoso ensayo Sobre

los cuerpos flotantes y la única fuente en griego para el revolucionario

El método y el ameno Stomachion. Y además, contiene diagramas.

Noel es conservador del Museo de Arte Walters en Baltimore (Estados Unidos),

donde fue depositado el manuscrito tras la subasta. Netz es matemático y experto

en Arquímedes, al que considera el científico más importante de la historia,

como queda meridianamente claro en el libro. Del trabajo artesanal de desmontaje

y conservación de las mohosas páginas del palimpsesto a su análisis en el

sincrotrón de Stanford, la investigación ha hecho un largo camino. En paralelo