|

|||||

![]()

![]()

NOTICIAS CIENTIFICAS

--Nuevas Noticias Próximamente--

![]()

TITULARES DE LAS NOTICIAS DEL MES :

Spitzer descubre un sistema planetario con dos soles

El exterior del núcleo de la Tierra se encuentra a más de 3500 grados centígrados

El futuro está en la electrónica del plástico

Un extraño hexágono es fotografiado por la sonda Cassini

El misterio del agua y la mecánica cuántica

Científicos surcoreanos clonan lobos

Nuevas superlentes permiten llegar al microscopio óptico a la escala del virus

Científicos españoles investigan los fondos de la Antártida

Canarias propondrá que Macaronesia sea un santuario de cetáceos

60 equipos de investigación desarrollan la predicción climática detallada para Europa

Cada dólar invertido en meteorología ahorra siete de pérdidas en catástrofes humanas

Una red de reservar marinas podría frenar la desaparición de pesquerías

Un escurridizo mamífero que vivía entre dinosaurios: el Yanoconodon

Descubren una nueva especie de pantera

El agua congelada en el polo sur marciano podría cubrir toda la superficie de Marte

El invierno más cálido de los últimos 127 años

Una enorme masa de agua subterránea, se encuentra en Marte

El meteorito Apophis podría chocar con la Tierra

Consiguen borrar recuerdos de ratas

La ESA quiere llegar a Marte en el 2025

Grupo de telómeros y telomerasa

Evolución dentro de la misma especie

Los submarinos pronto imitarán a los peces

Un paso más hacia el genoma del cáncer

Los dilemas éticos de la robótica

El agua que fluía en la superficie marciana posiblemente no se mantuvo en estado líquido

La NASA confirma la existencia de mares de metano líquido en Titán

Consiguen leer los pensamientos

Una expedición explorará la corteza de la Tierra en el fondo del océano Atlántico

Excelencia e independencia en la ciencia

La comunicación y la teleportación, cada día más cerca

Logran desarrollar el material tecnológico más fino del mundo

Éxito en el desarrollo de nuevas vacunas contra el SIDA

El eclipse de Luna del 3 de Marzo

-Spitzer descubre un sistema planetario con dos soles

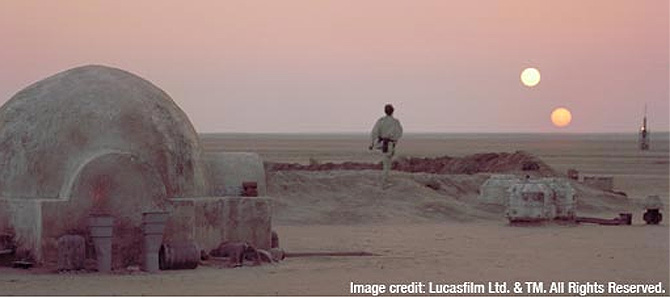

El telescopio espacial 'Spitzer', de la NASA, ha descubierto innumerables sistemas planetarios con dos soles, según ha informado el Laboratorio de Propulsión a Chorro (JPL). Según los astrónomos de la agencia espacial, ha dejado de ser una fantasía el doble atardecer que hipnotiza a Luke Skywalker en la película 'La guerra de las galaxias'.

Esos sistemas binarios, formados por discos de asteroides, cometas y posiblemente planetas, parecen ser tan numerosos como los de un solo sol, como el nuestro, manifiesta el organismo de la agencia espacial estadounidense.

"Ya parece no haber oposición a la idea de que se hayan formado planetas en sistemas binarios", según manifiesta David Trillin, científico de la Universidad de Arizona y autor de un informe sobre las operaciones del 'Spitzer' en la revista 'Astrophysical Journal'.

En el universo "podría haber incontables planetas con dos o más soles", añadió Trillin.

Según el comunicado de JPL, hasta ahora los astrónomos sabían que los planetas podían formarse en sistemas binarios en los que sus estrellas están separadas por mil veces la distancia que existe entre nuestro Sol y la Tierra.

De los aproximadamente 200 planetas descubiertos hasta ahora fuera de nuestro vecindario espacial, alrededor de 50 giran en torno a uno de dos soles en el mismo sistema.

En su estudio, los astrónomos apuntaron el telescopio infrarrojo para buscar los discos de polvo cósmico en los sistemas binarios.

Según JPL, esos discos están formados por rocas similares a los asteroides que nunca llegaron a formar parte de un planeta.

Su presencia indica que en algún momento ocurrió el proceso de formación de planetas en torno a una estrella, añadió.

Los astrónomos también se vieron sorprendidos por el hecho de que esos discos son más frecuentes o numerosos en los sistemas binarios y esto podría significar que la formación de un planeta se inclina más hacia los dos soles.

"Pero también podría significar que esos sistemas binarios en realidad sólo son más polvorientos. Una mejor respuesta a este interrogante deberá provenir de futuras observaciones", señaló Trilling

Fuente: El Mundo, 30 de Marzo de 2007

-El exterior del núcleo de la Tierra se encuentra a más de 3500 grados centígrados

La temperatura de la corteza del núcleo de la Tierra supera los 3.500 grados centígrados, según un estudio dirigido por el Instituto de Tecnología de Massachusetts en Cambridge (Estados Unidos) que se publica esta semana en la revista 'Science'.

Los investigadores han utilizado un método sísmico

tomado de las instalaciones de explotación petrolífera para estimar las

temperaturas que existen a 3.000 kilómetros por debajo de la superficie.

Los investigadores estudiaron miles de kilómetros de área bajo América Central.

Bajo estas profundidades, la temperatura estimada es de 3.950 Kelvin (3.676,85

grados centígrados), con una variabilidad de más o menos 200.

Una estimación exacta de la temperatura proporciona a los geólogos información

sobre cómo se transfiere el calor hacia el interior, la evolución térmica del

planeta y la generación de los campos magnéticos de la Tierra.

La comparación de mapas de las estructuras y las temperaturas en localizaciones

distintas del planeta completarán los detalles sobre la evolución dinámica de la

Tierra.

Los investigadores recogieron datos de cientos de seismógrafos y utilizaron un

proceso de dispersión tridimensional para analizar los límites entre el núcleo y

su corteza externa. Tras ello evaluaron la transición de la perovskita, el

material común del manto, a postperovskita.

Los científicos, utilizando teorías y medidas de laboratorio, emplearon la

posición de la transición de la perovskita a postperovskita para determinar la

temperatura de los límites entre el núcleo y su corteza.

Fuente: El Mundo, 30 de Marzo de 2007

-El futuro está en la electrónica del plástico

Hay una industria electrónica nueva que parece estar a punto de irrumpir con fuerza en Europa y hay una empresa que se encuentra a la vanguardia de esta novedosa tecnología. A principios de este año, la empresa británica de tecnología Plastic Logic anunciaba que se había hecho con 100 millones de dólares (76 millones de euros) de capital riesgo para construir la primera planta comercial del mundo para fabricar electrónica de plástico (también llamada electrónica orgánica).

La función principal de dicha fábrica será

incrementar la producción comercial de pantallas para productos de lectura

electrónica para "llevar a cualquier parte y leer en cualquier parte".

Valiéndose de un proceso desarrollado por la propia compañía, esta planta

fabricará pantallas que, según sus creadores, son casi tan flexibles como el

papel, tienen su mismo aspecto y su mismo tacto.

Según Anusha Nirmalananthan, directora de marketing de la compañía, esta

tecnología revolucionará el mercado de las pantallas digitales. "Nuestras

pantallas flexibles serán delgadas, ligeras y resistentes y harán posible

fabricar productos de lectura electrónica que serán tan cómodos y tan naturales

para leer como el papel", aseguró.

"Su capacidad de conexión instantánea permitirá al usuario descargarse un libro

o un periódico y leerlo esté donde esté y cuando quiera. Su batería durará el

equivalente para leer miles de páginas, así que el usuario no tendrá qué

preocuparse por recargarla", agregó.

Plastic Logic, surgida del Laboratorio Cavendish de la

Universidad de Cambridge, participó en dos

proyectos financiados por la UE, Discel y Naimo, pertenecientes al Quinto y al

Sexto Programa Marco, respectivamente. En Naimo encabezó el desarrollo de

técnicas de nanofabricación que ahora se emplearán para fabricar los ingeniosos

materiales plásticos con los que se fabrican estas novedosas pantallas

flexibles.

"Europa se encuentra a la cabeza de esta tecnología a nivel mundial y el apoyo

de la UE a proyectos como Naimo han contribuido a garantizar que esta carrera la

vamos a ganar; no nos quedaremos simplemente en los puestos de cabeza", asegura

Stuart Evans, director ejecutivo de Plastic Logic.

En realidad, los semiconductores plásticos no son nada nuevo, ya que se

descubrieron en la década de los años sesenta; lo novedoso y emocionante es la

perspectiva de su comercialización, especialmente porque tiene lugar en Europa.

Esta compañía ha elegido la ciudad de Dresde, del este de Alemania, situada en

la denominada "Silicon Saxony" o "Sajonia de silicio" [en referencia al Silicon

Valley californiano], para ubicar su nueva fábrica, pensando en la sólida

tradición de la ciudad en el ámbito de la investigación microelectrónica.

Esta fábrica empleará un conjunto simple de operaciones de procesamiento para

construir planos posteriores de matriz activa sobre "sustratos" (el material

sobre el que se forman los circuitos) de plástico que, al combinarlos con un

material de plano anterior de papel electrónico, se usarán para crear módulos de

pantallas delgadas, ligeras y resistentes.

Esta empresa empezará hacia mediados de 2008 la producción en masa de estas

pantallas de 10 pulgadas (25 cm), 150 píxeles por pulgada y 16 grados de grises.

Plastic Logic se propone producir un millón de láminas semiconductoras de

plástico en su primer año y, después, 2,2 millones al año. La compañía augura

que las ventas anuales a nivel mundial podrían aumentar hasta 41,6 millones de

unidades de aquí a 2010.

Mientras despega esta nueva tecnología de la electrónica de plástico, muchos de

los gigantes del mundo de la electrónica están ansiosos por llevarse su parte

del pastel. El grupo franco-estadounidense Alcatel-Lucent, la neerlandesa

Philips, la japonesa Hitachi, la surcoreana Samsung todos están trabajando en

los semiconductores plásticos o, como mínimo, se mantienen alerta a su

desarrollo.

Según Anusha Nirmalananthan, los científicos están "creando una industria de la

electrónica nueva y muy importante que complementará al silicio".

"Es más, les llevamos dos años de ventaja a nuestros competidores", afirma.

Fuente: CORDIS, 29 de Marzo de 2007

-Un extraño hexágono es fotografiado por la sonda Cassini

La NASA ha publicado unas imágenes de una extraña figura de seis caras con forma de enjambre hexagonal que rodea la totalidad del Polo Norte de Saturno. Los científicos analizan con curiosidad las imágenes, tomadas ya por las sondas Voyager hace dos décadas y que ahora ha vuelto a detectar la nave 'Cassini'.

Extraño hexágono en el polo Norte de Saturno

"Se trata de un fenómeno muy extraño, con unas formas geométricas casi perfectas, porque en el hexágono se pueden apreciar seis lados rectos que discurren en paralelo", señaló Kevin Baines, experto en fenómenos atmosféricos que forma parte del equipo de investigadores de la misión 'Cassini' en el Laboratorio de Propulsión a Chorro de la NASA. "Nunca hemos visto nada parecido en otro planeta. Desde luego, la espesa atmósfera de Saturno, hace que éste sea uno de los últimos lugares donde hubiéramos esperado ver una figura geométrica tan regular", matizó.

La figura mide unos 25.000 kilómetros y se calcula que dentro del remolino podrían caber cuatro planetas del tamaño de la Tierra.

Las imágenes nocturnas del polo norte de Saturno fueron tomadas por las cámaras de infrarrojos de la sonda 'Cassini', y muestran claramente la estructura hexagonal que gira alrededor del polo. Para los científicos tiene gran importancia no sólo porque ayudará a explicar este curioso fenómeno, sino también porque supone una de las imágenes más detalladas de esta región del planeta jamás tomada.

Hace dos décadas, las naves Voyager 1 y 2 lograron fotografiar este remolino, con menor resolución, el extraño fenómeno, y según se revela por las imágenes tomadas por la 'Cassini', parece que se trata de una característica duradera del planeta. En las imágenes de la 'Cassini' también se puede ver un segundo hexágono, más oscuro y brillante que el original captado por las 'Voyager'.

En la fotografía, el color rojo indica la radiación cuya longitud de onda son cinco micras, el calor generado en el interior caliente de Saturno que escapa del planeta. Las imágenes fueron tomadas entre el 30 de octubre y el 11 de noviembre de 2006 desde una distancia de 1.3 millones de kilómetros.

Fuente: El Mundo, 28 de Marzo de 2007

-El misterio del agua y la mecánica cuántica

La ecuación de Schrödinger, uno de los fundamentos de la

teoría de la mecánica cuántica, ha desvelado el funcionamiento de las moléculas

del agua gracias al uso de un conjunto de ordenadores superpotentes. Formada por

dos átomos de hidrógeno y por uno de oxígeno, se cree que el secreto de las

propiedades de este líquido tan común como misterioso radica en la capacidad de

sus moléculas para formar determinados enlaces entre los átomos de hidrógeno. El

desarrollo de este nuevo modelo informático podría tener múltiples aplicaciones,

y quizá resuelva determinadas cuestiones como la razón por la que el agua, en

estado sólido (hielo), no se hunde dentro de sí misma.

Esencial para todas las formas de vida, y objetivo eterno de estudio, el agua es

una sustancia con algunos misterios que aún no han podido ser revelados, al

menos desde la física clásica.

El acercamiento a este extraño elemento constitutivo, sin embargo, desde la

perspectiva de la física cuántica (desde la ecuación de Schrödinger para ser más

exactos), y gracias al uso de un conjunto de ordenadores superpotentes, ha

revelado la estructura subyacente del conjunto de moléculas aparentemente

sencillas del agua, que están formadas "tan sólo" por dos átomos de oxígeno y

uno de hidrógeno.

El logro lo ha alcanzado un equipo de científicos de la

universidad norteamericana de

Delaware y de la

Radboud

University de Holanda, que han desarrollado un nuevo método para desvelar

las propiedades ocultas del agua, y sin necesidad de concienzudos experimentos

de laboratorio: simplemente, informática.

PRINCIPIOS FUNDAMENTALES

Y es que, en teoría, toda la química y la física de la materia a escala

macroscópica podría ser descrita íntegramente por una enorme ecuación de

Schrödinger aplicable a más de 10 elevado a 23 átomos de una unidad de materia.

Utilizar esta ecuación y aplicarla de manera eficaz es actualmente posible

gracias al uso de ordenadores con una capacidad de cálculo superpotente, que

permitirían comprender algunas de las enigmáticas propiedades del agua. Este

tipo de herramienta informática de análisis ya se ha aplicado en otros campos,

como la meteorología y la mecánica celeste.

Los resultados de la investigación han sido publicados por la revista

Science y han sido

explicados en un comunicado de la universidad de Delaware. La investigación ha

estado liderada por el profesor de física y astronomía de dicha universidad,

Krzysztof Szalewicz, que ha colaborado con Robert Bukowski, de la

Cornell University, y

Gerrit Groenenboom y Ad van der Avoird, del

Institute for Molecules and

Materials de la Radboud University.

PROPIEDADES EXTRAÑAS

Todo el mundo sabe que una molécula de agua es H2O, pero, aunque su composición

parezca simple, el agua líquida en realidad es mucho más compleja que eso. Por

ejemplo, señala Szalewicz, contrariamente a otros líquidos, el agua aumenta de

volumen cuando se congela, lo que explica que el hielo flote en el agua. Por

otro lado, el agua puede absorber grandes cantidades de calor antes de empezar a

calentarse y lo libera lentamente mientras se enfría.

Las características únicas del agua parecen relacionarse con su estructura

molecular y con la capacidad de sus moléculas para formar enlaces de hidrógeno

con otras moléculas de agua. El hidrógeno de la molécula del agua tiene una

carga ligeramente positiva, mientras que la carga del otro extremo de la

molécula es ligeramente negativa.

Tradicionalmente se pensó que en el agua en estado líquido cada molécula se

coordinaba con una media de otras cuatro moléculas gracias a estos enlaces de

hidrógeno. Sin embargo, posteriormente se descubrió que esta coordinación tiene

lugar sólo con dos moléculas.

AMBIGÜEDADES

Todas estas ambigüedades del agua han sido estudiadas desde la mecánica cuántica

por Szalewicz y sus colegas, aplicando leyes de la física a un nivel

microscópico.

El resultado: los investigadores han conseguido generar un nuevo marco teórico

para describir la estructura y el comportamiento de la molécula del agua átomo a

átomo, gracias a los ordenadores de última generación, multiprocesadores,

capaces de aportar soluciones bastante ajustadas de las ecuaciones de la

mecánica cuántica para la descripción de las fuerzas que ejercen unas moléculas

del agua sobre otras. Esto debería permitir desvelar el porqué de las extrañas

propiedades de este líquido.

Con un conjunto de ordenadores Linux funcionando en paralelo, y que realizaron

cálculos a gran escala, el estudio tardó varios meses en completarse. El nuevo

modelo puede predecir con bastante exactitud, tanto las propiedades de un par de

moléculas de agua, como las del agua en estado líquido.

Las aplicaciones de este novedoso modelo, señalan los investigadores, van desde

la posibilidad de comprender mejor el agua en diversos estados y en condiciones

extremas, hasta el estudio de otros líquidos y sistemas moleculares, el ADN en

biología o el llamado plegamiento de proteínas (proceso por el que una proteína

alcanza su estructura tridimensional), entre otras.

Fuente: Tendencias 21, 27 de marzo de 2007

-Fotones, mejor que electrones

IBM va a desvelar un prototipo de microprocesador que utiliza

conexiones ópticas en lugar de las tradicionales (mediante semiconductores) y

que, según publica el diario

The Wall Street

Journal es capaz de procesar 160.000 millones de bits por segundo, o lo que

es lo mismo, 160 Gbit/s. Para entendernos, tantos datos como los que contiene

una película de alta definición en una fracción de segundo.

La compañía planea tener este tipo de microprocesadores en la

calle en un plazo de entre 18 y 30 meses, pero eso sí, para un mercado especial:

el de los supercomputadores y el de algunos servidores de red, ya que no sólo

servirá para aumentar su capacidad de procesamiento, sino sobre todo para

reducir drásticamente el espacio que necesitan, la energía que consumen y los

gastos en refrigeración que conllevan.

Detrás de este salto tecnológico está un proyecto que ha sido cofinanciado por

la conocida agencia

DARPA, y

una idea teóricamente obvia, pero que hasta ahora planteaba serias dificultades

técnicas pero sobre todo de rentabilidad: sustituir las conexiones eléctricas

(los datos se transmiten mediante electrones) por conexiones ópticas (en las que

los fotones toman el papel de bits de información).

Fuente: Cinco días, 27 de marzo de 2007

-Científicos surcoreanos clonan lobos

Un grupo de científicos surcoreanos ha anunciado la clonación de dos ejemplares de lobo, las primeras conseguidas de esta especie. Según los investigadores, que pertenecen al equipo del polémico Woo Suk Hwang, se trata de un importante avance para la protección de esta especie, que en dicho país ya no vive en libertad.

Los dos lobos clonados nacieron entre el 18 y 26 de octubre del año 2005, según confirmó Lee Byeong-chun, un profesor de veterinaria de la Universidad Nacional de Seúl, citado por la oficina de investigación del plantel educativo. Sin embargo, el equipo ha tardado año y medio en confirmar la noticia, puesto que las diferentes publicaciones científicas a las que se lo enviaron han querido revisar concienzudamente todos y cada uno de los datos para evitar fraudes como el ocurrido anteriormente con el anuncio de Hwang, que falsificó datos de sus experimentos con células madre.

Según informan los científicos surcoreanos, las pruebas genéticas realizadas con los dos ejemplares de lobo -llamados 'Snuwolf' y 'Snuwolffy'- han mostrado que ambos son clones. Los resultados de la investigación serán publicados en la revista 'Cloning and Stem Cells'. Sin embargo, hasta el momento el equipo científico no ha aportado una verificación independiente de los estudios del ADN de los lobos.

El equipo científico, dirigido actualmente por el doctor Lee Byung-chun -antiguo colaborador de Hwang- es el mismo que hace dos años logró por primera vez clonar un perro. "Normalmente, las publicaciones científicas no exigen verificaciones del ADN mitocondrial antes de publicar una investigación, pero en este caso hemos tenido que proporcionárselo para que pudieran verificarlo, para evitar problemas que han sucedido anteriormente", señaló Lee a la agencia Reuters.

Según los científicos, la clonación de estos lobos servirá de gran avance para la protección de este especie, que en muchos países se encuentra en peligro. De hecho, en Corea del Sur hace más de 20 años que no se ven ejemplares en libertad, y los únicos de que se tiene constancia es de un pequeño grupo de diez ejemplares que vive en un parque natural en Seúl.

El doctor Lee fue el 'segundo de a bordo' del equipo de investigación liderado por Hwang, cuyos presuntos descubrimientos sobre la producción de células troncales humanas mediante la clonación resultaron ser un fraude. Hwang no sólo perdió el reconocimiento de la comunidad científica, sino que fue llevado a juicio en Corea del Sur, y algunos de sus colaboradores fueron suspendidos de empleo y sueldo por desviación de fondos y falsificación de datos.

Sin embargo, de todos los experimentos realizados por el equipo surcoreano, el único que se demostró cierto fue la clonación de un perro, un cachorro de raza afgana llamado 'Snuppy', y cuya investigación estaba directamente a cargo del doctor Lee.

El pasado mes de diciembre, el equipo del doctor Lee anunció la clonación de tres cachorros de perro, también de raza afgana, y que había sido factible gracias a una sustancial mejora en el procedimiento de clonación.

para conseguir los lobos clonados -dos hembras-, el equipo científico transfirió 251 embriones a 12 madres adoptivas, de las que lograron producir dos clones que salieron adelante.

Los perros son unos de los animales mamíferos más difíciles de clonar, debido a su complejo sistema reproductivo.

No se trata, evidentemente, de unas lentes convencionales, sino que están confeccionadas con «metamateriales» con un índice de refracción negativo. Es así como los investigadores han logrado superar la barrera que impone a los instrumentos ópticos el denominado «límite de difracción».

Fuente: El Mundo, 27 de Marzo de 2007

-Nuevas superlentes permiten llegar al

microscopio óptico a la escala del virus

Dos equipos de físicos estadounidenses han creado, trabajando de forma

independiente, las primeras superlentes capaces de una ampliación de la imagen

tal que va más allá de todos los límites de resolución óptica conocidos: pueden

poner bajo el ojo del investigador objetos de una escala de tamaños inimaginable

hasta la fecha, como proteínas, virus, o el mismo ADN.

La difracción es un fenómeno característico de las ondas, por

el que se dispersan y se curvan cuando encuentran un obstáculo. Se produce en

todo tipo de ondas: ondas sonoras, ondas en la superficie de un fluido y ondas

electromagnéticas, como las de la luz. La difracción sólo se observa si el

obstáculo que encuentran las ondas es del mismo orden que la longitud de onda.

LA DISTORISÓN DE LA LUZ

La distorsión de la luz por la difracción produce una borrosidad que limita la

capacidad de aumento útil de un microscopio, o de un telescopio. Así, los

detalles menores de media milésima de milímetro no pueden verse en la mayoría de

los microscopios ópticos. Sólo un microscopio de barrido de campo cercano puede

superar el límite de difracción y visualizar detalles ligeramente menores en

tamaño que la longitud de onda de la luz.

Ya en una primera aproximación al problema, se llegó a la conclusión de que el

límite de difracción sólo podía superarse mediante el empleo de ondas

«evanescentes», que al salvar los obstáculos sin distorsiones permiten

resoluciones ópticas muy superiores a las obtenidas con las ondas de luz visible

«normales», pero cuya captura por lentes convencionales provoca su rápido

decaimiento o «evanescencia».

John Pendry, físico del

Imperial College de Londres, predijo ya en el año 2000 que el decaimiento de

las ondas evanescentes puede resolverse si son amplificadas al pasar por un

material con índice de refracción negativo. Desde entonces, han sido fabricadas

varias superlentes con un éxito limitado en la transmisión de ondas

evanescentes, pero ninguna de ellas ha conseguido un índice de decaimiento

aceptable de la onda.

DESDE MARYLAND Y BERKELEY

Ahora, dos equipos de investigadores lo han conseguido en trabajos

independientes. En la

Universidad

de Maryland, un equipo dirigido por Igor Smolyaninov ha logrado construir

una superlente a partir de anillos concéntricos de distintos polímeros,

depositados sobre una delgadísima película de oro. De forma simultánea, otro

equipo, dirigido por Xiang Zhang, ha optado en la

Universidad de Berkeley,

en California, por un dispositivo en tres dimensiones (3D) de láminas de plata

curvadas, y de óxido de aluminio, incrustadas sobre una base de cuarzo.

Estos dos diseños han sido calificados de metamateriales por tratarse de

nanoestructuras artificiales creadas por los físicos, ya que no existen en la

naturaleza, o al menos no se conocen, sustancias con un índice de refracción

negativo.

A partir de estas superlentes, montadas en un dispositivo de geometría

cilíndrica, un equipo externo a la lente captura las ondas evanescentes emitidas

por los objetos a estudio tras ser iluminados por un finísimo rayo láser, de

forma que se obtiene una imagen ampliada más allá del límite de difracción,

mucho más de lo que un microscopio convencional puede registrar.

UNA SOLUCIÓN "RÉCORD"

Smolyaninov ha obtenido con su superlente de anillos de polímeros una resolución

de 70 nanometros, siete veces superior al límite de difracción de la iluminación

por láser efectuada sobre el objeto. Por su parte, Zhang, con su «hiperlente» en

3D -así prefiere llamarla-, ha logrado una resolución cercana a los 130

nanometros.

Estas enormes prestaciones logradas por ambas superlentes abren una nueva

dimensión al campo de la óptica. Las resoluciones obtenidas por Smolyaninov y

Zhang sólo son superadas por la microscopía electrónica -por los denominados

microscopios de fuerzas atómicas, o por los de túnel de barrido-, pero estos

microscopios no se basan en la óptica, sino en la interacción atómica: el

observador no «ve» la muestra, sólo contempla su «huella».

Igor Smolyaninov ha manifestado a la revista electrónica «Physicsweb»,

en cuyo último número aparecen reflejados ambos trabajos, que «ahora el

verdadero desafío reside en localizar la muestra a estudio -por su reducidísimo

tamaño-... apenas llegas a ver si la tienes enfocada o no».

Fuente: ABC , 27 de Marzo de 2007

La

Academia

Noruega de las Ciencias y las Letras, que concede el galardón, anunció el

nombre del premiado y destacó que los trabajos de Varadhan "tienen una gran

fuerza conceptual y una belleza intemporal". El Premio Abel 2007 está dotado con

750.000 euros.

Varadhan nació en Madrás (India) en 1940 y se doctoró en el Instituto Indio de

Estadística de Calcuta. Después se fue a Estados Unidos, donde inició su carrera

académica en el Instituto Courant de Ciencias Matemáticas de la Universidad de

Nueva York. La Teoría de la Probabilidad es la herramienta que se aplica en el

análisis de situaciones que se rigen por el azar; por ejemplo, al tirar una

moneda al aire repetidas veces. Varadhan, señaló la Academia Noruega en un

comunicado, ha hecho aportaciones esenciales "al haber creado una teoría

unificada de las grandes desviaciones". Esta área se aplica en diferentes

campos, desde la física y la biología, hasta la economía o la estadística.

Si se tira una moneda al aire muchas veces, cabe esperar que la mitad de ellas

salga cara y la otra mitad, cruz. Sin embargo, se producen valores inesperados:

sale más veces cara o cruz del valor medio. La teoría de las grandes

desviaciones permite analizar la incidencia de esos valores anómalos. Las

soluciones sirven para abordar problemas como: ¿Qué reservas de capital se

requieren para que la probabilidad de quiebra de una empresa de seguros se

mantenga a un nivel aceptable?

Fuente: El País, 23 de Noviembre de 2007

Si el petróleo se convirtió en el oro

negro del siglo XX y aún hoy sigue provocando turbulencias en el mercado, el

agua es el indiscutible oro azul del siglo XXI. En la teoría económica se maneja

la llamada paradoja del diamante, para explicar cómo en el desierto una gota de

agua cobra un valor económico muy superior al de un diamante.

El hecho es que más de 1.100 millones de

personas no tienen un acceso normalizado al agua y dos de cada cinco personas en

el mundo carecen de saneamiento adecuado, según estadísticas de la ONU, que

vaticina que las necesidades de agua aumentarán un 55% a escala mundial en los

próximos 20 años. El oro líquido es ya un activo de inversión para el futuro.

El sector llega en buena forma al día mundial del agua. El índice Bloomberg de

empresas de distribución de aguas acumula una rentabilidad a 12 meses del

10,94%, frente al 5,98% que logra el índice Euro Stoxx. Si bien es cierto que

sobre el sector siempre ha pesado una prima de concentración corporativa, que

explica también la buena marcha de la compañía española Aguas de Barcelona, que

gana un 16,86% en ese periodo.

'La perspectiva del sector es atractiva y comparativamente favorable en relación

con los mercados de acciones mundiales', constatan desde Pictet Funds, cuyo

fondo basado en la industria del agua logra una rentabilidad del 72,9% en un

plazo de tres años. 'Globalmente la infraestructura del agua está desfasada y la

necesidad de financiación es ya de 534.000 millones de dólares en EE.UU. y de

330.000 millones de euros en Europa', apunta David Owen, gestor de Pictet Funds.

El Banco Mundial cifra entre 60.000 y 80.000 millones de dólares anuales la

necesidad inversión en todo el mundo para cubrir los servicios básicos, aunque

la inversión real no llega al 40% de esa cantidad, lo que da una idea de las

posibilidades futuras del sector.

'Las perspectivas de crecimiento son buenas; el mercado de EE.UU. se está

liberalizando cada vez más y el tratamiento de agua, especialmente en países

como China e India, ofrece grandes oportunidades debido a la polución', constata

Jerôme Schupp, de Banque Syz.

Así, el fondo New Resources de DWS (la gestora de fondos de Deutsche Bank),

donde la industria del agua tiene un peso del 38,4% en la cartera, logra en un

plazo de 12 meses un rendimiento próximo al 10%. El índice Wowax, sobre el que

Société Générale crea productos derivados basados en agua, tiene una

rentabilidad histórica del 120% en los últimos tres años.

Aunque las empresas de distribución de agua pierden de media un 3,58% en lo que

va de año, todo el mercado está esperando una oleada de operaciones

corporativas, lideradas por las francesas Suez y Veolia, que den combustible a

las cotizaciones, que en un plazo de 12 meses ya arrojan un saldo positivo del

10,94%.

En cualquier caso, las necesidades de inversión también apuntan a un futuro

brillante para el sector. DWS calcula que las necesidades de inversión para los

próximos ochos años, supondrán un incremento del 330% en EE.UU. y del 100% en

Europa, respecto a los niveles de inversión del año 2000. En los países en

desarrollo se espera crecimiento superior incluso al 1.000%.

Fuente: Cinco Días, 22 de Marzo de 2007

-Científicos españoles investigan los fondos de la Antártida

El deshielo de las plataformas antárticas Larsen A y Larsen B ha permitido a un equipo español estudiar la fauna de unos fondos marinos inaccesibles para el hombre desde hacía más de 1.000 años y descubrir que los fondos bentónicos son mucho más ricos y diversos de lo que se pensaba.

|

|

|

Estrella de mar de 12 brazos encontrada a 100 metros de profundidad en la plataforma Larsen A |

|

curioso pez cuya coloración es azul. |

Según explicaron en rueda de prensa los investigadores del CSIC Enrique Isla y Josep-María Gili, el objetivo de su proyecto, 'Climant', es estudiar el "acoplamiento" que se produce en la Antártida entre el fondo marino (bentos) y la columna de agua (pélagos).

Cuando se desintegran fragmentos de la plataforma helada, los icebergs resultantes se comportan como "verdaderos bulldozers" y destruyen los fondos a su paso, apuntó Enrique Isla, responsable del proyecto en España, en el que también participan científicos alemanes y chilenos.

Después, los micronutrientes y semillas almacenados en el hielo se precipitan al fondo del mar, lo que permite que la vida se desarrolle y se produzca la colonización con especies de zonas cercanas en las zonas arrasadas, dijo Isla.

"La retirada de las plataformas de hielo de la zona estudiada nos ha dado la posibilidad de llegar a un lugar en el primer momento de esta recolonización", añadió.

Lo que más asombró a los científicos fue descubrir que el fondo marino en esta plataforma continental era mucho más rico y diverso en animales bentónicos de lo que tenían previsto, puesto que hasta el momento se pensaba que "el ecosistema antártico era más lento", explicó Gili.

Entre las especies halladas durante la campaña se encuentran ascidias, de aspecto semejante a tubos de plástico, y holoturias, similares a las babosas, que al parecer son los primeros grupos en llegar a las zonas despobladas. En algunos lugares estas comunidades de animales cubren casi por completo el lecho marino.

En el apartado de las curiosidades, se ha descubierto una especie de esponja que, por forma y tamaño, ha recibido el nombre de 'Stilogorgia chupachups', algo para lo que, según explicó Gili "ha habido incluso que pedir permiso a la empresa" que fabrica los caramelos. Se trata de una especie "muy común en la zona, que tiene una historia de aislamiento de 30 millones de años".

Lo más llamativo para la comunidad científica no es hallar especies nuevas porque "en la Antártida lo normal es descubrir entre 30 y 40 en cada viaje", sino el hecho de que, de las detectadas "más del 50% son endémicas", es decir, que "sólo viven" en el continente helado, lo que convierte a la región en el lugar con "la fauna marina más antigua de la Tierra"; con "el nivel más alto de especies endémicas" y, durante "un mes al año, el lugar con el ecosistema más productivo del planeta".

Además, encontraron crinoideos pedunculados, animales cuyos brazos se extienden en forma de palmera, que hasta ahora eran asociados a mares profundos, "lo que induce a pensar que las condiciones ambientales existentes bajo las plataformas de hielo son parecidas a las que se dan en el mar profundo", dijo Enrique Isla.

Los deshielos, y consecuentes desprendimientos de icebergs, por sí mismos no se pueden considerar negativos.

Durante los 40 millones de años en que la Antártida "está donde está" este proceso ha provocado un aumento en la diversidad de especies.

El gran peligro del cambio climático es la posible envergadura que pueda alcanzar porque "si desaparece el hielo alrededor de las zonas destruidas, no habrá desde donde colonizar", especificó Gili.

Sin embargo, el científico opina que la mayor amenaza para estos ecosistemas no es el calentamiento global, "tras 40 millones de años congelándose la Antártida no se descongelará en 100", sino el aumento de las cuotas de pesca de krill, un pequeño crustáceo que sirve de alimento a muchas especies polares como las ballenas.

Esta especie es "clave" porque sirve de vector entre los nutrientes del hielo y muchas especies.

A diferencia del Ártico, "mucho más sensible al cambio climático", en la Antártida el Polo Sur se está enfriando y la península se está calentando. "Las muestras de agua, animales y sedimentos obtenidas ayudarán en el análisis de cómo el cambio climático está presionando en ecosistemas especialmente sensibles", concluyó Isla.

La campaña, que se desarrolló a bordo del rompehielos alemán 'Polarsten', se integra en el Proyecto 'Climant', un trabajo internacional que estudia los efectos del calentamiento global en el continente helado en el que participan 40 científicos de 12 países.

Junto a los científicos del Instituto de Ciencias del Mar del CSIC han participado investigadores de la Universidad de Sevilla.

El equipo científico señaló que la biodiversidad del fondo marino de la Antártida evoluciona a una velocidad "mucho mayor de la esperada" a causa del cambio climático por lo que, cuando antes se viajaba allí para estudiar el terreno de década en década, "ahora habrá que ir con más frecuencia, quizá anualmente".

. Sin embargo, es algo que resulta muy complicado, especialmente económicamente hablando porque, según apuntaron "sólo el combustible" les ha costado "seis millones de dólares" y aunque el Gobierno alemán "ha prestado sus plataformas de trabajo" y "un barco que tiene instalaciones y facilidades que no tiene otro en el mundo" lo que financia el Ministerio de Educación y Ciencia español, "no llega al 5% del gasto real", que es "mucho dinero".

Fuente: El Mundo, 21 de Marzo

-Canarias propondrá que Macaronesia sea un santuario de cetáceos

El Gobierno de Canarias propondrá que la Macaronesia -región a la que pertenece este archipiélago junto con las Azores, Madeira, las Salvajes y Cabo Verde- sea un santuario para cetáceos, informó la Consejería de Medio Ambiente y Ordenación Territorial del Gobierno canario.

La propuesta se hará en la Conferencia Internacional de Protección de los Delfines que se celebrará en noviembre de este año en Tenerife y en la que participarán representantes de Portugal, España y países africanos con motivo de la celebración en 2007 del Año Internacional de Protección de los Delfines.

El director general del Medio Natural del Gobierno canario, Juan Carlos Moreno, que hoy se reunió con representantes de entidades para concretar el desarrollo de esta propuesta, indica en un comunicado que el diseño de las acciones se sustentará en los pilares de educación ambiental e investigación.

Juan Carlos Moreno destaca la importancia de que las entidades privadas en Canarias tengan conocimiento de la necesidad de potenciar y sacar rendimiento a la riqueza del mar en las islas, tanto desde el punto de vista educativo como desde el económico y el investigador.

La apuesta, en palabras de Juan Carlos Moreno, debe hacerse desde la óptica de la protección y la conservación de las aguas insulares.

Fuente: EFE, 21 de Marzo de 2007

-60 equipos de investigación desarrollan la predicción climática detallada para Europa

Una de las áreas prioritarias de la

investigación es la modelización climática a escala regional, una difícil

disciplina en la que son líderes mundiales los científicos europeos.

Más de 60 equipos de investigación, casi todos de la UE, están trabajando en un

macroproyecto denominado Ensembles, entre cuyos objetivos destaca la creación de

modelos de clima que permitan hacer proyecciones para las próximas décadas con

una elevada resolución espacial: 25 kilómetros. Los actuales modelos climáticos

globales, que abarcan todo el planeta, tienen una resolución máxima de unos 200

kilómetros, por lo que con ellos no es posible simular la evolución de las

temperaturas o las lluvias a lo largo del siglo en áreas más pequeñas.

"Ensembles va a realizar simulaciones climáticas para todo el siglo, con

especial atención al periodo 2000-2050, usando modelos climáticos regionales

avanzados de 25 kilómetros de resolución", explica Manuel de Castro, catedrático

de la

Universidad de Castilla-La Mancha

y participante en el proyecto europeo. "Además, vamos a calibrar los diferentes

modelos que usemos, comparando sus resultados y cuantificando las incertidumbres

que presentan". Pero Ensembles, enfocado al territorio europeo y la cuenca del

Mediterráneo, tiene otro objetivo ambicioso: "Al final del proyecto, en 2009,

muchos de estos modelos regionales podrán hacer simulaciones en otras zonas,

fuera de Europa", explica Chris Hewitt, científico del

Hadley Centre británico y

director de Ensambles.

Las simulaciones y proyecciones climáticas, puntualiza De Castro, no son iguales

a las predicciones meteorológicas. No tratan de predecir qué tiempo hará en un

día y un lugar concretos dentro de 35 años, algo que impide la naturaleza

caótica de la atmósfera, sino de simular el cambio de las condiciones

climáticas, es decir, de valores promedio a lo largo de las próximas décadas en

la región de interés.

Los modelos regionales son clave, por ejemplo, para conocer los impactos del

calentamiento a esa escala, lo que es muy útil para los responsables políticos y

económicos que preparan las medidas de respuesta. España, entre otros, está

trabajando en esta orientación de análisis de impactos.

De momento, y a la espera de resultados con mayor resolución, las simulaciones

indican que en el último tercio de siglo las temperaturas medias en la península

Ibérica podrían aumentar entre cuatro y siete grados centígrados en verano,

respecto a los valores actuales; las precipitaciones podrían disminuir entre un

30% y un 70% en primavera y verano. En invierno, en la mitad sur de la

Península, las lluvias posiblemente se reducirían entre el 10% y el 30%, pero en

la mitad norte disminuirían menos o incluso aumentarían ligeramente. De Castro

puntualiza que estos valores están calculados para uno de los peores escenarios

posibles, es decir, para un incremento más acelerado que el actual en las

emisiones de gases de efecto invernadero.

Ensembles, financiado con 15 millones de euros por el VI Programa Marco de la

UE, deriva en parte de otro proyecto europeo, Prudence, en cuyo marco se

prepararon y aunaron 10 modelos regionales con resolución de 50 kilómetros

(algunos ya de 25 kilómetros) y con proyecciones para el último tercio del siglo

XXI. Uno de ellos era -y sigue siéndolo en Ensembles- el modelo Promes,

desarrollado por el equipo de De Castro.

Los resultados de Prudence se recogen en el AR4 del IPCC, tanto en el volumen

dedicado a la ciencia del cambio climático como en el que se ocupa de sus

impactos. El hecho de que en el capítulo 11 del informe, sobre proyecciones

regionales, sólo se establezcan conclusiones derivadas de modelos sobre Europa

demuestra hasta qué punto, por ahora, la ciencia europea es líder mundial en

modelización regional. Para el resto del planeta, los análisis de impacto se han

ceñido a los resultados de los modelos globales, que dividen la superficie de la

Tierra y la atmósfera en celdillas de más de 200 kilómetros de lado.

"Hasta ahora, sólo las simulaciones de Prudence han generado un conjunto

coordinado multimodelo de simulaciones con resolución de 50 kilómetros para

todas las zonas; un conjunto similar de experimentos se está realizando ahora en

Norteamérica, en el proyecto Narccap", explica Jens Christensen, experto del

Instituto Meteorológico Danés y líder de dicho capitulo 11 del AR4. Él destaca

el objetivo de Ensembles de reducir la resolución a 25 kilómetros, y añade que

se aplicarán estos modelos en otras partes del mundo, como África occidental y

Latinoamérica.

PARA MEDIADOS DE SIGLO

En el proyecto Ensembles los científicos europeos han asumido el reto de acercar

a la primera mitad del siglo XX el plazo de la proyección climática, y ya con

alta resolución -algunos de los 10 modelos del programa anterior, el Prudence,

ya estaban en 25 kilómetros, pero otros eran de 50 kilómetros-.

"Las proyecciones a medio plazo son más difíciles porque el ruido que generan en

la simulación las fluctuaciones naturales del clima resulta algo más dominante",

aclara el experto danés Jens Christensen. El problema es que es más difícil, por

ejemplo, identificar con rigor en una simulación un aumento de temperatura media

de dos grados en las próximas décadas que un aumento de cuatro a finales de

siglo.

Hay que tener en cuenta que estas simulaciones del clima, tanto a escala global

como las regionales, son complejísimas. Son modelos que reproducen

razonablemente bien la evolución de las condiciones climáticas y los fenómenos

físicos y biogeoquímicos que las determinan, y exigen el uso de superordenadores

muy potentes. De Castro comenta que realizar una simulación climática de cien

años requiere un tiempo de computación continuo de entre seis y nueve meses,

dependiendo de la potencia del superordenador.

Los científicos, una vez desarrollado un modelo, primero lo arrancan en el

pasado -por ejemplo, a principios o mediados del siglo XX-, para hacerlo avanzar

hasta el presente, de manera que así pueden verificar si los resultados de la

simulación, por ejemplo en la década de los noventa, reproducen bien las

condiciones climáticas ya observadas en la región que interesa. Sólo entonces se

ejecuta el modelo hacia el futuro.

Además del equipo de Castilla-La Mancha participan tres instituciones españolas

más entre las 65 de Ensembles: el

Instituto

Nacional de Meteorología, la

Universidad de Cantabria

y la Fundación para la Investigación del Clima, pero éstas no utilizan modelos

climáticos regionales propios.

Fuente: El País, 21 de Marzo de 2007

-Cada dólar invertido en meteorología ahorra siete de pérdidas en catástrofes humanas

Según señaló Michel Jarraud, secretario

general de la

Organización Meteorológica Mundial (OMM),

"invertir un euro en medidas de prevención de los riesgos asociados a fenómenos

climáticos puede evitar que se tengan que desembolsar siete en gastos

relacionados con los desastres".

Jarraud ha participado en Madrid en la conferencia internacional para mejorar

los servicios del tiempo, el clima y el agua en el mundo, que ha inaugurado la

Reina Sofía y en la que participarán durante toda la semana centenares de

expertos de todo el mundo. Unas jornadas de las que esperan sacar los marcos de

actuación de la comunidad internacional, así como crear un foro de diálogo entre

productores y usuarios finales de servicios meteorológicos para introducir

mejoras en la utilidad de los productos dirigidos a agricultura, la salud

humana, el turismo, la energía, el transporte, o el desarrollo sostenible, entre

otros temas.

Para el secretario general de la OMM, en los últimos 20 años los desastres

naturales han dejado un menor balance de víctimas mortales, debido en parte a la

mejoría de los sistemas de alerta temprana de fenómenos meteorológicos extremos.

"Unos servicios meteorológicos, climatológicos e hidrológicos adecuados puede

ayudar a las sociedades a atajar, o al menos reducir sustancialmente buena parte

de esas muertes, y también pueden ayudarnos a luchar contra el cambio

climático", señaló.

El presidente de la OMM, Alexander Bedritsky, señaló que "es evidente que los

servicios nacionales de meteorología e hidrología en muchos países carecen de

influencia política a los más altos niveles". Así, en esta conferencia, según

Bedritsky, "se pueden encarar estos retos mediante el incremento de la

comprensión global sobre cómo todos los sectores son dependientes de los

servicios del tiempo, agua y clima, mientras que sienta las bases para su

modernización y desarrollo".

"Las vidas de cientos de millones de personas en todo el mundo se ven afectadas

cada día por las decisiones que tienen que ver con el tiempo, el clima y el

agua, y los fenómenos hidrometeorológicos extremos -que representan un 90% de

los desastres naturales- han provocado en los últimos años catástrofes de

consecuencias devastadoras", matizó Jarraud. La ministra de Medio Ambiente,

Cristina Narbona, reiteró el compromiso del gobierno español con "todos aquellos

proyectos de Naciones Unidas que pretenden avanzar hacia un desarrollo más

sostenible a nivel mundial". Señaló que la Conferencia pretende avanzar en la

identificación de los beneficios económicos y sociales de los servicios

meteorológicos y apuntó que España es un país "especialmente vulnerable" ante el

cambio climático. Enrique Iglesias, secretario general de la Secretaría General

Iberoamericana, señaló que "la información relativa al clima es vital para

Iberoamérica, porque son países que dependen mucho de la exportación de materias

primas, por lo que la incidencia de la climatología en la agricultura, la

ganadería o la pesca son fundamentales". En cuanto a España, Portugal y el resto

de Europa, Iglesias matizó que la información meteorológica es también sumamente

importante, "porque predecir el tiempo es clave para un sector como el turismo,

de gran importancia en estos países".

Fuente: El Mundo, 20 de Marzo de 2007

Fuente: El País Digital, 15 de Marzo de 2007

-Una red de reservar marinas podría frenar la desaparición de pesquerías

Una presión humana excesiva sobre los

ecosistemas marinos, con la actividad pesquera a la cabeza, ha causado una

perdida de biodiversidad en el mar sin precedentes en las últimas décadas: el

desarrollo industrial de las flotas pesqueras ha permitido su expansión hasta un

punto en el que casi no queda un rincón de los océanos sin explotar y el

descenso general de los recursos pesqueros es incontestable. A este problema se

unen, entre otros, la contaminación, la destrucción de valiosísimos ecosistemas

costeros o los efectos potenciales del cambio climático y el agujero en la capa

de ozono. Hoy en día, el uso de nuevas herramientas como las reservas marinas

para la gestión integral y precautoria de los océanos está emergiendo con

fuerza. Greenpeace demanda la creación de una red global de reservas para la

recuperación y gestión sostenible de los ecosistemas marinos.

Entre el público general no existe

todavía una percepción adecuada de la agudeza de la crisis que sufren nuestros

océanos. A menudo asistimos a discusiones sobre la situación de los recursos

pesqueros, en torno a los recortes de las cuotas de pesca, pero hay un gran

desconocimiento de la globalidad y profundidad de este problema, de sus causas y

de las posibles soluciones.

El desarrollo industrial de la pesca durante el pasado siglo forzó la

desaparición del mito de los océanos como una fuente inagotable de recursos.

Durante demasiado tiempo los océanos estuvieron (y en cierta medida aún están)

al alcance de quien tuviera medios para explotarlos; paralelamente, los avances

tecnológicos posibilitaron una capacidad de captura muy por encima de las

posibilidades de reproducción de los ecosistemas marinos apoyada por muchos

gobiernos, que subvencionaron generosamente la construcción de más y mejor

equipados barcos.

Los resultados no se hicieron esperar. La actividad pesquera industrial ha ido

agotando las poblaciones de las especies que ocupan los lugares más elevados de

las complejas redes tróficas marinas. Actualmente se calcula que la abundancia

de peces predadores a nivel global es aproximadamente tan sólo un 10%

de los niveles pre-industriales; muchas poblaciones de cetáceos podrían

desaparecer en las próximas décadas; la producción pesquera ha estado

descendiendo desde principios de los 90 pese a que disponemos cada vez de buques

más potentes y tecnologías más eficaces para capturar peces en numerosas

pesquerías, particularmente en las de arrastre, un porcentaje importante de las

capturas son devueltas muertas al mar dos de los ecosistemas costeros más

productivos en las zonas tropicales han sido destruidos en gran medida: el 25%

de los arrecifes de coral ha desaparecido y el 25% de los bosques de manglar ha

sido destruido en los últimos 20 anos. Como resultado disponemos de ecosistemas

menos funcionales y mucho más vulnerables a fenómenos de alcance global como el

cambio climático o la contaminación.

Precaución cero: un par de ejemplos cercanos y recientes

El desastre anunciado por todos en la costera de la anchoa

este mismo año no hace sino confirmar la total falta de seriedad de nuestros

gobernantes en cuanto a políticas responsables de pesca. De nada han servido las

advertencias de los científicos, ni las demandas de los pescadores, que el año

pasado exigían el cierre de la pesquería de anchoa en el cantábrico por dos años

para permitir la recuperación del recurso, que se encuentra en niveles mínimos

históricos. Como en 2005, este año el cierre de la pesquería lo han

tenido que llevar a cabo los propios pescadores, renunciando a salir a faenar

ante la falta de capturas. Nuestra administración pesquera sigue diciendo que no

cerrará el caladero si no hay pruebas científicas que demuestren la necesidad

del cierre. La situación exige exactamente lo contrario: cerrar el caladero

hasta que haya evidencias de su recuperación.

Como Greenpeace ha denunciado estos días una de las pesquerías más emblemáticas

del Mediterráneo, la del atún rojo, desaparece. Lo

estamos viviendo en directo. Avisamos hace cuatro años, cuando los gobiernos

miembros de la CICAA, organización que gestiona la pesca de atún en la región,

acordaron una cuota de pesca un 25% mayor de la recomendada por los científicos.

Hemos venido calificando de pesca pirata lo que sucede con esta especie

en la región: todo el mundo pesca lo que puede y los gobiernos mediterráneos se

toman a broma sus obligaciones de comunicar debidamente sus capturas a los

organismos de gestión.

La flota atunera mediterránea podría estar capturando un 40% más de lo

legalmente permitido en el Mediterráneo, condenando a la especie a su extinción

comercial (45.000 toneladas frente a las 32.000 legales). Pese a que el estado

de sobreexplotación del recurso era evidente, tanto España como otros Gobiernos

mediterráneos han venido subvencionando generosamente a la industria atunera

mediterránea en los últimos años, incluyendo la renovación de buena parte de

esta flota. Dinero público destinado a que hoy en día tan sólo unas pocas

empresas asociadas a capital japonés y australiano monopolicen el grueso de las

capturas de atún en el Mediterráneo.

Son tan sólo dos ejemplos que muestran por un lado la gravedad del problema, y

por otro la poca seriedad de los responsables de administrar la actividad

pesquera. La búsqueda de niveles máximos de capturas en lugar del uso de un

enfoque más precautorio y la gestión de los pesquerías especie por especie,

en lugar de tener en cuenta el conjunto del ecosistema son factores

fundamentales en el fracaso de la gestión pesquera tradicional.

En los últimos años no ha habido cambios significativos en la forma en la que

los gobiernos hacen frente a esta crisis. Las grandes flotas industriales han

seguido recibiendo generosas subvenciones; las flotas ilegales continúan

eludiendo todo control; los modelos de acuicultura industrial más destructiva

-como la del langostino tropical- siguen expandiéndose; la contaminación es un

grave problema en amplias zonas costeras; y un largo etcétera.

Una red de reservas marinas como instrumento de gestión precautoria

Algo fundamental es que el mismo objetivo de la gestión pesquera debe cambiar,

desde la actual maximización de los rendimientos a corto plazo hacia la

minimización de los impactos sobre el medio ambiente, y especialmente del riesgo

de dañar las poblaciones o los ecosistemas marinos de forma irreversible.

Ninguna pesquería debería poner en peligro la capacidad de cualquier especie de

resistir las fluctuaciones medioambientales, ya sean naturales o inducidas por

el ser humano, ni inhibir la recuperación de cualquier especie que se encuentre

amenazada o en peligro de extinción. Los impactos destructivos de las

actividades pesqueras sobre los hábitats y ecosistemas marinos deben ser también

eliminados, y la pesca en zonas de especial sensibilidad ecológica debería ser

prohibida.

Además, para compensar nuestras grandes lagunas de conocimiento en lo que se

refiere a los procesos ecológicos marinos, la gestión pesquera debe ser

precautoria, poniendo el acento en la prevención del daño, en

contraposición a los intentos de reparar los errores con medidas de recuperación

o de mitigación una vez que estos se han producido. Las reservas marinas,

mediante las cuales se protegen áreas enteras contra una amplia gama de impactos

de origen humano, contribuyen precisamente a estos objetivos, lo que las

convierte en una herramienta de conservación única. Contar con una parte del

ecosistema al margen de las actividades extractivas es sin duda una forma de

disminuir el riesgo, hoy día muy elevado, de sobreexplotación de los recursos.

Las reservas no son una herramienta tan nueva. Ciertamente en el pasado

existían muchos refugios naturales para las especies marinas, proporcionados por

zonas que eran simplemente inaccesibles y que explicaban la resilencia de

algunas pesquerías. Se trata de lugares protegidos que en buena medida han

desaparecido con el surgimiento de nuevas tecnologías, pero que podrían ser

ahora recuperados a través de la creación de reservas marinas.

Beneficios de las reservas marinas

Se ha comprobado que el establecimiento de reservas marinas tiene como resultado

aumentos a largo plazo y a menudo rápidos en la abundancia, diversidad y

productividad de organismos marinos. Si bien los beneficios de la protección son

más evidentes para las especies que pasan la mayor parte de su tiempo dentro de

la reserva marina, también las reservas pueden brindar protección a las especies

migratorias, si éstas son protegidas en etapas vulnerables tales como las que

pasan en áreas de desove y cría. Las reservas marinas pueden reestablecer el

equilibrio ecológico alterado por las actividades humanas. Por ejemplo, la pesca

puede alterar la relación predador/presa y ocasionar cambios en el hábitat y las

reservas pueden ayudar a mitigar estos efectos. Es vital que los hábitats más

importantes estén representados dentro de una red regional. Estos deben incluir

hábitas vulnerables; etapas críticas de la vida de las especies, p.e. lugares de

desove y cría; lugares capaces de dar apoyo a especies sobreexplotadas o poco

abundantes; etc.

Las reservas marinas como herramienta de gestión pesquera

Por definición las reservas marinas están cerradas a la pesca pero el

establecimiento de una red de reservas marinas puede beneficiar a las pesquerías

de varias maneras. Las reservas marinas permiten que las poblaciones explotadas

recuperen sus hábitats y que los hábitats modificados por las actividades

pesqueras se regeneren. Existen evidencias cada vez mayores que sugieren que el

establecimiento de una red de reservas marinas puede producir mejores

rendimientos en las zonas de pesca adyacentes. Esto esta relacionado con la

migración de peces adultos y jóvenes más allá de los límites de la reserva así

como con la exportación de larvas y huevos desde la reserva hacia las áreas de

pesca. Al ser áreas no explotadas, las reservas marinas sirven también como

áreas valiosas de referencia que se pueden utilizar para facilitar la

comprensión de los efectos de la pesca fuera de la reserva y para informar las

decisiones de gestión.

Las reservas marinas brindan además la oportunidad a las comunidades locales de

obtener derechos de propiedad sobre las reservas de su área y sobre sus zonas

adyacentes, un hecho muy importante que tiende a ser infravalorado. Otras

actividades no extractivas tales como el buceo, la fotografía submarina y la

observación de cetáceos se benefician todas ellas con una vida marina diversa y

abundante.

¿Por qué una red? Tamaño, escala y conectividad de las reservas marinas

Diferentes modelos parecen dejar claro que independientemente de su tamaño, el

establecimiento de reservas marinas conduce a incrementos en la densidad,

biomasa, talla de los especimenes así como de la diversidad. Para proteger el

ecosistema en su conjunto es importante garantizar que todos los hábitats estén

representados dentro de una red de reservas marinas.

Para conservar una gama representativa de hábitats y especies se necesitará

establecer cierto número de reservas marinas y es importante que éstas estén

ubicadas en una red que garantice su conectividad. Muchas especies marinas

tienen fases dispersas en aguas abiertas y con frecuencia los huevos y las

larvas son transportados a sitios muy alejados de donde fueron fecundados. En la

misma medida en que aumenta la cobertura de un área se incrementa también la

conectividad.

El Congreso Mundial de Parques de Durban en 2003 recomendó que "las redes

deberían ser extensas e incluir áreas estrictamente protegidas que abarquen por

lo menos el 20-30% de cada hábitat". Dos expertos destacados en los

aspectos científicos de las reservas marinas, Callum Roberts y Julie Hawkins, de

la Universidad York en el Reino Unido, han llegado a la conclusión de que

"todos los argumentos convergen hacia la importancia de la protección a gran

escala, con un máximo de beneficios generalmente en el rango de entre el 20 y el

40% del mar como parte de reservas".

Se ha subrayado también la importancia de crear reservas en una red de distintos

tamaños. Crear una red de reservas marinas más pequeñas en la zona costera

tendrá la ventaja de distribuir los beneficios entre las comunidades pesqueras a

lo largo de la costa en vez de concentrarlos en unas pocas y extensas reservas

marinas donde varias comunidades juntas perderán sus espacios de pesca.

La propuesta de Greenpeace

Greenpeace está promoviendo una red global de reservas marinas que abarque el

cuarenta por ciento de los océanos del planeta con el fin de disponer de océanos

y mares bien conservados y de permitir su recuperación en los casos necesarios.

Esto significa establecer una red representativa de reservas marinas, que

comprenda reservas a gran escala en alta mar, y un mosaico de reserva marinas de

menor extensión en conjunción con áreas de pesca bien gestionadas y sostenibles

en la zona costera. Para garantizar que tanto los beneficios de la reservas

marinas y el acceso a las áreas de pesca de distribuyan equitativamente

alrededor de la línea costera, en el diseño de una red se deben considerar tanto

los factores sociales como los biológicos.

Se trata de una medida con importantes ventajes desde el punto de la gestión

pesquera, cuyos beneficios son cada vez más evidentes y en la que es necesario

comenzar a dar pasos cuanto antes. Por el momento, las primeras experiencias

piloto han ofrecido en general resultados muy positivos cuando han estado bien

gestionadas. Es hora de pasar de pequeños ejemplos casi diríamos anecdóticos, a

redes más consistentes que permitan explorar su funcionamiento a pleno

rendimiento.

Fuente: mi+d,

-Un escurridizo mamífero que vivía entre dinosaurios: el Yanoconodon

Los investigadores han declarado a la

revista

Nature que el peculiar

animal, rescatado en una formación de rocas ricas en fósiles al norte de China,

da a conocer un elemento crucial en la evolución de los mamíferos: la estructura

del oído que permite una gran sensibilidad de audición.

El animal, llamado Yanoconodon por las montañas Yan de la provincia de Hebei,

vivió hace 125 millones de años durante el periodo cretácico, el tercero y

último de la era mesozoica, conocida a veces como la Edad de los Dinosaurios. Su

cuerpo era muy raro para ser un mamífero, con un torso alargado y extremidades

cortas y rechonchas. "En cierto modo, es como el cuerpo de una salamandra en un

mamífero", ha declarado en una entrevista el responsable de los científicos Zhe-Xi

Luo del

museo Carnegie de historia natural

en Pittsburgh, Pensilvania.

Los científicos piensan que Yanoconodon - que medía unos 15 centímetros de largo

y pesaba alrededor de 30 gramos - era un animal nocturno que comía insectos.

Vivió en un ambiente abundante de lagos de agua potable, plantas con flores y

otros muchos animales. Entre ellos había una variedad de dinosaurios a los que

nada les hubiera gustado más que convertirlo en un aperitivo con pieles.

Luo ha declarado que el Yanoconodon es particularmente importante porque supone

una etapa intermedia en la evolución de la estructura auditiva de los mamíferos.

Los mamíferos poseen una capacidad auditiva superior al resto de vertebrados,

una característica fundamental para la vida del mamífero. Los investigadores

creen que muchos mamíferos primitivos adoptaron una existencia nocturna que les

mantuvo alejados de las multitudes de dinosaurios y otras bestias que buscaban

un alimento fácil.

Los científicos llevan tiempo buscando pistas sobre los orígenes de la

estructura auditiva de los mamíferos. Los primeros mamíferos aparecieron hace

unos 220 millones de años, no mucho después de los primeros dinosaurios, pero el

proceso de adquisición de la anatomía de los modernos mamíferos llevó muchas

decenas de millones de años más.

Fuente: El País, 16 de Marzo de 2007

-Descubren una nueva especie de pantera

El Fondo Mundial para la Naturaleza (WWF, por sus siglas en inglés) anunció que la pantera nebulosa encontrada en las islas de Borneo y Sumatra es una especie distinta a la que habita en el sureste del continente asiático.

La pantera nebulosa, que debe su nombre

a las grandes manchas de su pelaje que le permiten confundirse entre las hojas,

es el mayor depredador de Borneo y se caracteriza por ser el felino con los

colmillos más largos en relación a su tamaño, que oscila entre los 60 y los 110

centímetros de largo.

"Las pruebas de ADN muestran una cuarentena de diferencias genéticas entre las

dos especies", por lo que "la pantera nebulosa de Borneo debe ser considerada

como una especie distinta", explicó en un comunicado de prensa el responsable

del estudio, Stephen O'Brien. El WWF señaló que tales diferencias "son

comparables a las que existen entre otras especies de felinos como el león, el

tigre, el leopardo, el jaguar o el leopardo de las nieves".

En paralelo, se analizaron los pelajes de varios ejemplares procedentes de

distintas regiones y se compararon la forma y el color de sus manchas y "quedó

claro que se trataba de dos especies distintas", aseguró el investigador del

departamento de Ciencias Naturales del

Museo

Nacional de Escocia, Andrew Kitchener.

La pantera nebulosa continental, también llamada pantera longibanda, está

cubierta de grandes manchas irregulares con borde negro e interior pardo, pero

las de la especie de Borneo son de un color más vivo y tienen pequeñas manchas

oscuras en su interior. Los expertos, que creen que las dos especies se

diferenciaron hace 1,4 millones de años, estiman la población de panteras

nebulosas de Borneo entre 8.000 y 18.000 ejemplares.

"Que el mayor depredador de Borneo sea una especie distinta enfatiza la

importancia de conservar el área del Corazón de Borneo", aseguró el coordinador

del programa de ese mismo nombre en el Fondo, Stuart Chapman.

Se trata de una región montañosa y selvática de 220.000 kilómetros cuadrados,

situada en el centro de la tercera isla más grande del mundo, donde se

identificó la mayor parte de las 52 especies que se descubrieron allí en 2006.

Fuente: EFE, 16 de Marzo de 2007

-El agua congelada en el polo sur marciano podría cubrir toda la superficie de Marte

Una nueve medición de la sonda 'Mars Express' ha descubierto una enorme masa de agua congelada bajo el polo sur marciano, reveló el Laboratorio de Propulsión a Chorro (JPL), de la NASA en un comunicado.

El texto señala que esa región polar

contiene suficiente agua congelada como para cubrir toda la superficie del

planeta con una capa líquida de 11 metros de profundidad.

"Los depósitos del polo sur de Marte cubren una región mayor que la superficie

del estado de Texas. La cantidad de agua que contienen había sido calculada

antes, pero nunca con tanta precisión", manifestó Jeffrey Plaut, científico del

JPL.

La misión de 'Mars Express' es una operación conjunta de la

NASA

y de la

Agencia Espacial Europea

y la masa de hielo fue detectada por el 'Radar Avanzado para Investigación

Subterránea y Ionosférica de Marte' (MARSIS, por sus siglas en inglés).

Ese instrumento, desarrollado de forma conjunta por la NASA y la

Agencia

Espacial de Italia, también está investigando

el grosor de depósitos similares en el polo norte marciano, señaló el JPL.

El comunicado del JPL cita declaraciones de Giovanni Picardi, de la

Universidad de Roma 'La Sapienza' e

investigador principal a cargo del instrumento, quien manifiesta que "MARSIS

demuestra ser un instrumento muy poderoso para investigar bajo la superficie de

Marte".

Las capas de hielo polar contienen la mayor parte del agua existente en Marte,

aun cuando hay otras zonas que parecen haber sido húmedas en el pasado, según el

JPL. "Comprender la historia y la suerte corrida por el agua en Marte es clave

para comprender si el planeta tuvo vida, ya que toda la vida depende del agua

líquida", señaló el JPL.

Fuente: EFE, 16 de Marzo de 2007

-El invierno más cálido de los últimos 127 años

El último invierno en el hemisferio norte ha sido el más cálido desde que comenzaron a registrarse las temperaturas ambientales en 1880, según ha revelado la Administración Nacional Oceánica y Atmosférica de Estados Unidos (NOAA, siglas en inglés).

El organismo del Gobierno de EEUU indicó en su página "web" de Internet que en el periodo diciembre-febrero, las temperaturas fueron de 1,3 grados centígrados superiores a la media del siglo XX.

El informe indicó que uno de los factores que contribuyó a las temperaturas récord del invierno en el hemisferio norte fue el fenómeno estacional de 'El Niño', que cada fin de año se centra en las aguas del océano Pacífico. El aumento se debilitó en febrero cuando las temperaturas oceánicas en la zona del Pacífico ecuatorial bajaron en más de 0,5 grados centígrados.

NOOA también señaló que durante el último siglo, las temperaturas en la superficie del planeta han aumentado una media de 0,06 grados centígrados por década. Sin embargo, ese incremento ha sido tres veces superior a partir de 1976 (0,18 grados centígrados) por década, y los mayores aumentos se han registrado en las latitudes altas del hemisferio norte.

A pesar de que NOAA no planteó la relación, su informe se suma a la serie de estudios que señalan que el planeta está sufriendo un calentamiento como resultado de la contaminación causada por los gases de efecto invernadero, producidos por las actividades industriales, el uso de combustibles no renovables, y otros procesos.

Fuente: El Mundo, 16 de Marzo de 2007

-Una enorme masa de agua subterránea, se encuentra en Marte

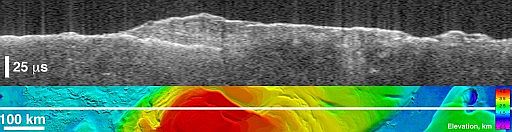

La parte superior muestra la capa de hielo. La inferior muestra el corte topográfico

Una nueve medición de la sonda 'Mars Express' ha descubierto una enorme masa de agua congelada bajo el polo sur marciano, reveló el Laboratorio de Propulsión a Chorro (JPL), de la NASA en un comunicado. El texto señala que esa región polar contiene suficiente agua congelada como para cubrir toda la superficie del planeta con una capa líquida de 11 metros de profundidad.

"Los depósitos del polo sur de Marte cubren una región mayor que la superficie del estado de Texas. La cantidad de agua que contienen había sido calculada antes, pero nunca con tanta precisión", manifestó Jeffrey Plaut, científico del JPL.

La misión de 'Mars Express' es una operación conjunta de la NASA y de la Agencia Espacial Europea y la masa de hielo fue detectada por el 'Radar Avanzado para Investigación Subterránea y Ionosférica de Marte' (MARSIS, por sus siglas en inglés).

Ese instrumento, desarrollado de forma conjunta por la NASA y la Agencia Espacial de Italia, también está investigando el grosor de depósitos similares en el polo norte marciano, señaló el JPL.

El comunicado del JPL cita declaraciones de Giovanni Picardi, de la Universidad de Roma 'La Sapienza' e investigador principal a cargo del instrumento, quien manifiesta que "MARSIS demuestra ser un instrumento muy poderoso para investigar bajo la superficie de Marte".

Las capas de hielo polar contienen la mayor parte del agua existente en Marte, aun cuando hay otras zonas que parecen haber sido húmedas en el pasado, según el JPL. "Comprender la historia y la suerte corrida por el agua en Marte es clave para comprender si el planeta tuvo vida, ya que toda la vida depende del agua líquida", señaló el JPL.

Fuente: El Mundo, 16 de Marzo de 2007

-La NASA confirma la existencia de mares de metano líquido en Titán

La sonda Cassini de la NASA ha descubierto inmensos mares, probablemente de metano o etano, en las regiones del norte de la luna Titán de Saturno, ha anunciado este martes la agencia espacial estadounidense.

Los instrumentos de radar de la nave han

captado regiones oscuras -que prueban la existencia de esos mares-, cuya

superficie sería mayor a las observadas anteriormente, algunas más grandes

incluso que muchos mares terrestres. Titán es el segundo satélite natural de

Saturno y la segunda luna más grande del Sistema Solar, casi un 50% mayor que

nuestra luna.

"Desde hace tiempo nos planteábamos hipótesis sobre los océanos de Titán y ahora

con múltiples instrumentos tenemos indicaciones de mares que empequeñecen los

lagos que habíamos visto antes", ha señalado Jonathan Lunine, científico de la

misión en la

Universidad de Arizona.

La NASA ha explicado que hasta el momento no existe una

indicación concluyente de que en esos mares haya algún tipo de líquido. Sin

embargo, debido a las condiciones prevalecientes en Titán, es probable que sean

una combinación de metano y etano, gases que son abundantes en la atmósfera de

esa luna.

La misión de la sonda Cassini, iniciada con su lanzamiento en 1997, es un

proyecto conjunto de la NASA, la

Agencia Espacial Europea

y la

Agencia Espacial de Italia.

Fuente: El País, 15 de Marzo de 2007

-El meteorito Apophis podría chocar con la Tierra

Duque señaló

que el asteroide Apophis, de unos 250 metros de largo, pasará muy cerca de la

Tierra en 2029 y causará, siete años después, un tsunami peor que el de 2004.

El ingeniero y

astronauta español Pedro Duque advirtió de que existe "una

certeza matemática absoluta" de que el asteroide Apophis pasará "enormemente

cerca" de la Tierra en 2029. Hay una gran posibilidad de que derribe satélites

comerciales y de que siete años después, en 2036, atraído por el campo magnético

del planeta, pueda caer en la superficie marítima originando un "inmenso

tsunami", "infinitamente más grande" que el que asoló Indonesia en 2004.

En un coloquio sobre Defensa y el sector aeroespacial organizado en el Hotel

Palace de Madrid, el astronauta señaló que el asteroide, de unos 250 metros de

largo, quedaría inmerso en el campo electromagnético terrestre y se precipitaría

previsiblemente contra el mar, provocando "un inmenso tsunami". El asteroide

causaría, según Duque, "un agujero" en la superficie marítima

de "varios kilómetros de extensión".

Don Quijote y Sancho

El astronauta señaló que tanto la Unión Europea como Estados Unidos están

evaluando los procedimientos a adoptar para afrontar esta situación e indicó que

el coste de una misión para desviarlo rondaría los 1.000 millones de euros. En