|

|||||

![]()

![]()

NOTICIAS CIENTIFICAS

--Nuevas Noticias Próximamente--

![]()

TITULARES DE LAS NOTICIAS DEL MES :

Identifican la proteína que nos hace sentir frío

¿Cuál es la alternativa a los combustibles fósiles?

El Gran Telescopio de Canarias estará listo dentro de un año

El telescopio "Spitzer" de la NASA descubre nuevas galaxias enanas

Chip Power6 , el nuevo invento revolucionario de IBM

El futuro energético está en las papas

Crean un mapa del cuerpo humano tridimensional

Kioto pasa factura a los aviones

Nuevas imágenes de Cassini nos acercan a Titán

El dinosaurio nadador de La Rioja

Estados Unidos da Luz Verde a la primera píldora anticonceptiva que elimina la menstruación

Estrellas naciendo en Orión vistas por el telescopio Spitzer

Gro Harlen Brundtland: Hay que pasar ya a la acción porque el cambio climático está fuera de control

La UE da el primer paso para la creación de una Política Espacial Europea

La próxima guerra será por el agua

La ONU asegura que "estamos a las puertas de una extinción masiva de especies"

Guerra entre Microsoft y Linux

Los polos podrían fundirse en mil años

Fertilizar los océanos para obtener beneficios

Dos nuevos barcos de investigación oceanográfica para España

Crean un cerebelo artificial que permite a los robots comportarse como humanos

Medio ambiente quiere convertir los zoos en centros de conservación

Más de la mitad de los españoles no usan internet

Estados Unidos vetará en el G-8 todo compromiso sobre el cambio climático y ahorro de energía

Cómo combatir el cambio climático según Antonio Ruiz de Elvira

SpeciesBase, nace una web para clasificar la vida

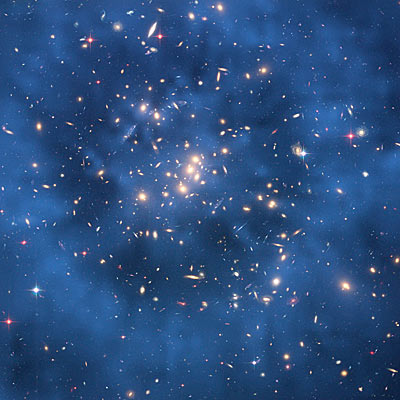

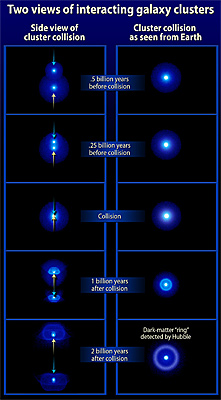

El Hubble permite descubrir la distribución de materia oscura alrededor de un cluster

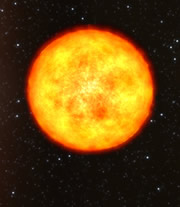

Descubren una de las estrellas más vieja del universo

Avistada una bola de fuego en la península

La NASA se enfrenta con los problemas del espacia en el fondo del mar

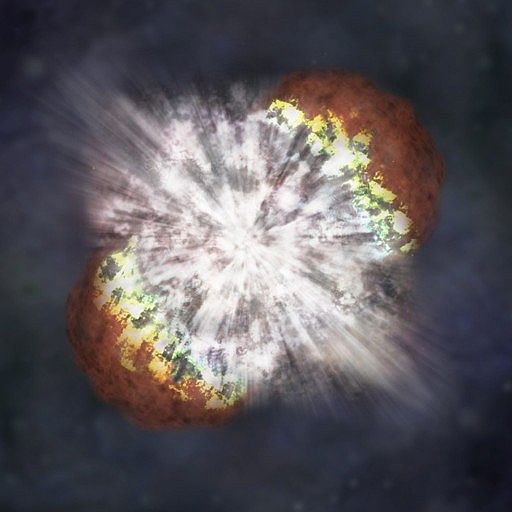

Una supernova espectacular es descubierta por la NASA

La Universidad hebrea de Jerusalén anuncia el descubrimiento de la tumba de Herodes

Cinco grandes proyectos impulsan una nueva etapa en la genómica

Frenar el cambio climático es posible y más barato que renunciar a la acción

La huella de Tartessos conduce a Doñana

El gobierno de Canarias edita el libro historia de la ciencia

A Coruña celebra el Día de la Ciencia

"Nemo" sabe como volver a casa

El rover Spirit encuentra evidencias de explosiones volcánicas del pasado

La energía nuclear centra el debate sobre el cambio climático

La nanotecnología se apresta a utilizar la luz que pasa por agujeros pequeños

Internet, los cohetes y la radio: los mejores inventos del hombre

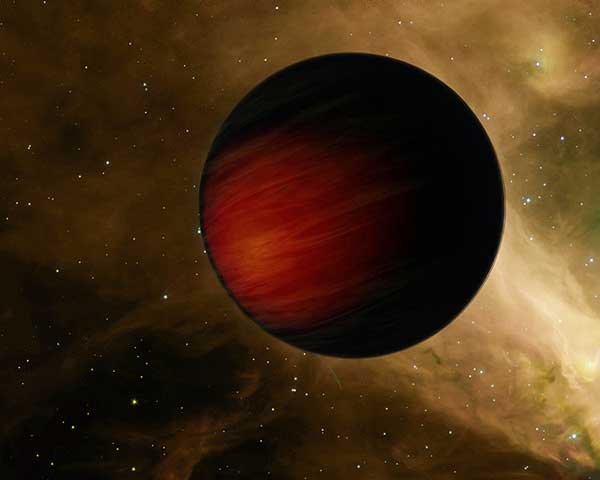

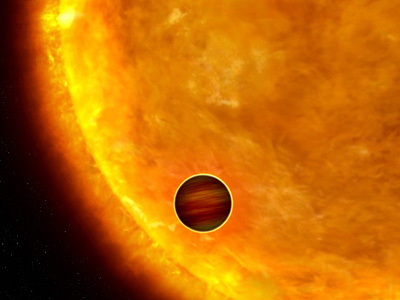

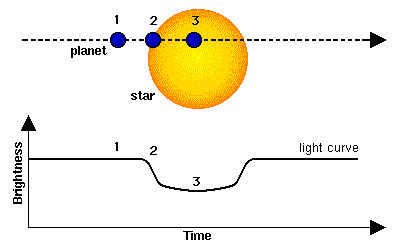

COROT detecta su primer planeta

La NASA celebra el aniversario de sus satélites con fotos espectaculares

-Identifican la proteína que nos hace sentir frío

Han conseguido identificar al responsable de que sintamos frío: es la proteína TRPM8, presente en las células del sistema nervioso y que se activa con las bajas temperaturas y al entrar en contacto con agentes químicos refrescantes como el mentol.

Este logro, que recoge en su edición de

Internet la revista científica británica

Nature, es resultado de

una investigación que científicos de las Universidades de

California y

Yale

y del

Instituto Médico de Wisconsin,

todos en EE.UU., llevaron a cabo con ratones.

Al estudiar el comportamiento de los roedores, los expertos vieron que aquellos

que carecían de la proteína TRPM8, que se activa con temperaturas inferiores a

los 26 grados centígrados, tenían problemas para sentir frío cuando el

termómetro marcaba los 10 grados centígrados.

Esto, sin embargo, no sucedió con temperaturas extremas, circunstancia que,

según los científicos, los ratones carentes del TRPM8 trataban de evitar a toda

costa. "Nuestro estudio da muestras del papel esencial y predominante que la

TRPM8 desempeña en las sensaciones térmicas en un amplio espectro de

temperaturas", afirman los investigadores en su artículo.

Esto hace válida la hipótesis de que los canales TRP, encargados de controlar la

entrada de calcio a la célula, "son los principales sensores de los estímulos

térmicos en el sistema nervioso periférico", añaden. El 17% de las neuronas de

los roedores dotados de esta proteína reaccionaron al frío o al mentol -alcohol

refrescante-, mientras que las de aquellos carentes de la TRPM8 no ofrecieron

respuesta alguna.

Esta diferencia en la respuesta a los cambios de temperatura es mucho menor en

el caso del calor: en torno a un 40 por ciento de las neuronas de ambos tipos de

roedores reaccionaron a un ascenso del mercurio del termómetro.

Fuente: EFE, 31 de Mayo de 2007

-¿Cuál es la alternativa a los combustibles fósiles?

Muchos son los que consideran que los biocombustibles pueden ser la panacea para nuestras carencias energéticas y las crisis de pobreza mundial. Sin embargo, un nuevo informe de las Naciones Unidas sugiere que, sin una buena planificación, estos nuevos recursos energéticos pueden llegar a causar tantos problemas como los que solucionan.

Las tecnologías bioenergéticas modernas

que producen calor, electricidad y combustibles para el transporte están

avanzando rápidamente. Recientemente han despertado gran interés los

biocombustibles líquidos, concretamente el etanol y el biodiésel. Los últimos

cinco años, la producción mundial de estos biocombustibles se ha doblado, y

probablemente lo volverá a hacer en los próximos cuatro años.

Muchos países de todo el mundo, desde Argentina hasta Malasia, pasando por la

India o Zambia, han promulgado nuevas políticas a favor de los biocombustibles

durante los últimos años. La política energética de la UE dicta que antes de

2020 al menos un 10% de todos los combustibles deberán ser biocombustibles.

No resulta sorprendente que el interés mundial por la bioenergía haya crecido

rápidamente durante estos últimos años, afirma Mats Karlsson, Presidente del

programa ONU-Energía, que publicó el informe "Sustainable

Bioenergy: A Framework for Decision Makers".

"¿Qué puede ser más atrayente que la energía producida en casa, basada

esencialmente en la fotosíntesis basada en la luz y el agua y que ofrece nuevos

empleos y oportunidades de desarrollo?".

En efecto, el desarrollo de las industrias bioenergéticas, incluidos los

biocombustibles, podría ofrecer un suministro de energía limpia a millones de

personas que actualmente carecen de tal suministro, según sugiere este informe.

Por ejemplo, el hecho de cocinar con fuentes tradicionales de bioenergía como la

madera ha causado muchos problemas de seguridad y de salud a muchas personas que

viven en el mundo en vías de desarrollo, especialmente a las mujeres, quienes se

han visto encerradas en un ciclo de pobreza. El acceso a fuentes energéticas más

modernas podría ayudar a reducir estos problemas y sacar a muchas poblaciones de

la pobreza.

Las nuevas industrias bioenergéticas también podrían ofrecer un potencial

importante de creación de empleo y generar ingresos, especialmente en zonas

rurales de algunas de las regiones más pobres del mundo, dado que la gran

mayoría del empleo relacionado con la bioenergía se produce en la agricultura,

el transporte y el procesamiento.

Sin embargo, este informe alerta de que esta prosperidad acarrea otros

problemas. En primer lugar, la demanda de terreno para cultivos bioenergéticos

podría ejercer presión sobre otros usos, principalmente en los cultivos de

alimentos, lo que probablemente comportaría un aumento de los precios de

alimentos básicos como los cereales. De forma similar, dado que la producción de

materias primas para biocombustibles también requiere un importante

abastecimiento de agua, esto puede disminuir la disponibilidad de ésta para el

uso doméstico, lo que amenazaría la salud y la seguridad de gran parte de la

población.

En segundo lugar, dado que los biocombustibles se producen y se tratan a gran

escala, los autores temen que una transición hacia estos combustibles desplace

fuera de sus tierras a los agricultores más pobres del mundo y agudice su

pobreza.

El informe también señala las repercusiones que la producción de biocombustibles

podría tener sobre el medio ambiente. Dependiendo de la elección de materias

primas y de lo que éstas sustituyeran, unos buenos métodos agrícolas, como los

cultivos intercalados y la rotación de cultivos, podrían tener repercusiones

neutras e incluso positivas para el medio ambiente circundante, se afirma en

este documento.

Sin embargo, los cultivos que tienen finalidades energéticas generalmente suelen

presentarse en forma de monocultivos de gran escala, cosa que, según se alerta

en el estudio, podría llevar a una pérdida importante de biodiversidad, una

erosión del suelo y la lixiviación de nutrientes. Se destacan los casos de la

India, Sri Lanka y Tailandia, donde los cultivos de biocombustibles ya han

llevado a una deforestación a gran escala.

Incluso cultivos más variados y sostenibles que tengan finalidades energéticas

podrían perjudicar el medio ambiente si sustituyen las selvas y praderas, se

señala en este informe. Otros impactos potenciales son la eutrofización del

agua, la acidificación de los suelos y las aguas superficiales e incluso la

disminución del ozono.

Este informe concluye sugiriendo un marco de trabajo para que las autoridades

políticas fomenten la producción y el uso sostenibles de biocombustibles y otras

fuentes de bioenergía para generar los máximos beneficios para los pobres y para

el medio ambiente. En el ámbito de la investigación y el desarrollo, este

documento hace un llamamiento a los gobiernos para que financien actividades que

fomenten el bien público, incluidas actividades de investigación fundamental sin

aplicaciones comerciales inmediatas, y la identificación de las necesidades de

bioenergía y de ámbitos para la investigación de políticas.

La energía nuclear es la solución

James Lovelock, considerado como un gurú de los verdes, asegura que la energía nuclear es la única manera de detener el calentamiento global y que ya no hay tiempo para desarrollar otras fuentes renovables.

Lovelock es el autor de la Hipótesis

Gaia, que desde la década de 1970 es aceptada por la comunidad científica a la

hora de entender y explicar los fenómenos climáticos de nuestro planeta.

Según esa hipótesis, la Tierra funciona como un organismo que se regula a sí

mismo, como si todos los organismos que en ella viven fueran responsables de que

sea apta para la vida.

Este cientifico es uno de los pioneros en la concienciación universal sobre el

calentamiento global, opuesto a los reactores nucleares como fuente de energía

para el planeta.

PASADO COMPROMETIDO

Lovelock se contaba entre los científicos que advirtió en 1989 a la primera

ministra Margaret Thatcher sobre el efecto invernadero.

El diario británico

The Independent recogía unas declaraciones de

Lovelack en las que el experto ecologista aseguraba que ahora cree que los

recientes fenómenos climáticos muestran que el planeta se está calentando a una

velocidad mucho mayor de la que predijeron los científicos del

Panel

Intergubernamental sobre Cambio Climático, de

las Naciones Unidas, en 2001. Sobre la base de esos datos, Lovelack sostiene que

no hay tiempo para reconvertir las fuentes de energía tradicionales -generadoras

de grandes emisiones de dióxido de carbono y que producen el efecto invernadero-

en otras como la eólica, la solar o la mareomotriz.

Lovelack sostiene que será una extensión de las centrales nucleares la que

permita evitar el rosario de catástrofes climáticas que pueden producirse por el

calentamiento global. En la línea del último éxito de Hollywood en cine

catastrófico -El día de mañana-, Lovelack cita el alarmante crecimiento de los

mares, los desastres climáticos, las inundaciones y la desaparición de grandes

áreas agrícolas. El científico asegura estar preocupado principalmente por dos

fenómenos recientes: el derretimiento de los hielos en Groenlandia, que eleva

los niveles de los mares, y la ola de calor que sacudió a Europa Central el año

pasado. El experto añade que los temores sobre la seguridad de la energía

nuclear "son irracionales y exagerados" y que "los verdes deben dejarlos de lado

por el bien del planeta".

Algunos grupos ecologistas ya han respondido a Lovelack: Greenpeace coincide en

la preocupación de Lovelock y en sus exigencias de respuestas drásticas frente a

los cambios climáticos. Sin embargo, Stephen Tindale, director ejecutivo de

Greenpeace en Inglaterra,

asegura que el gurú "está equivocado si piensa que la energía nuclear es parte

de la solución. La energía nuclear crea enormes problemas; no sabemos qué hacer

con los desechos, ni con las emisiones radiactivas, además de los riesgos de

accidentes y de ataques terroristas".

Fuente: Cordis, Expansión, 30 de Mayo de 2007

-El Gran Telescopio de Canarias estará listo dentro de un año

Para el próximo 13 de julio está previsto que el Gran Telescopio de Canarias (GTC), una de las principales instalaciones científicas españolas, afronte su prueba de fuego, la denominada primera luz, en la que la máquina astronómica capta por primera vez la luz de los astros en su espejo principal, o en parte del mismo en este caso.

Seguramente se

apuntará a Polaris, estrella que, por su posición en el cielo, exige poco

movimiento del telescopio para seguirla, explicó la semana pasada José Miguel

Rodríguez Espinosa, director científico del GTC, durante el congreso Astrid de

instrumentación científica celebrado en Madrid. Pero también se tomarán imágenes

de otros objetivos celestes que están aún por decidir, comentó. Tras 10 años de

trabajos, incluidos cuatro de retraso sobre el plan inicialmente previsto, el

GTC debe demostrar ahora que funciona. Su operación científica rutinaria tendrá

que esperar otro año más.

Con una decena de grandes telescopios del mismo rango -de espejo de ocho a 10

metros de diámetro- ya funcionando en el mundo, el observatorio español tiene

ahora el doble reto de desempeñar un papel clave para el avance de la astronomía

española y de ser competitivo en el marco científico internacional.

Tras la primera luz, el plan de los responsables del GTC, impulsado por el

Instituto de Astrofísica de Canarias, es

optimizar el telescopio e ir incorporando y probando los instrumentos de

observación previstos, algunos de los cuales están listos y otros en diferentes

fases de su desarrollo.

La primera luz se hará con la caja de guiado del telescopio y las cámaras se

instalarán después, aunque la cámara espectrógrafo Elmer, planeada como

instrumento de reserva, está ya lista. El instrumento Osiris tiene que pasar las

últimas pruebas y se instalará en el telescopio dentro de seis meses, y el

multiespectrógrafo Emir está previsto para 2009. Estos tres equipos se han

desarrollado en España, y a ellos se añade la cámara CanariCam, desarrollada y

construida en la

Universidad de Florida (EE.UU.),

que está terminada.

El GTC, cuyo coste es de 104 millones de euros (sin apenas encarecimiento sobre

lo previsto), está financiado al 90% por España, con un 70% a cargo de la

Administración Central y un 30% de la Comunidad Autónoma de Canarias, explica

Pedro Álvarez, director del telescopio. El 10% restante lo aportan la

Universidad

Autónoma de México y la Universidad de Florida.

Sin embargo, cuando en la década de los años noventa el entonces Consejo Asesor

de Grandes Instalaciones dio luz verde al proyecto, especificó que debía tener

una implicación de socios extranjeros abultada. "No pudo ser, las previsiones

iniciales fracasaron y sólo se consiguió la participación de México y Florida",

explica Miguel Angel Quintanilla, secretario de Estado de Universidades e

Investigación. "Pero ahora hay gran participación internacional en el GTC

gracias a la entrada de España en el

Observatorio Europeo Austral (ESO) y, de hecho,

parte de nuestro pago en especies de la cuota de ingreso en dicha organización

la hacemos en horas de utilización del GTC para ESO".

El espejo del telescopio estará formado por 36 segmentos exagonales que

compondrán una superficie de 10,4 metros de diámetro. Esta opción, frente a la

inicialmente considerada de espejo de una sola pieza, facilita enormemente su

transporte hasta el observatorio del Roque de los Muchachos (La Palma). Pero con

el tiempo la idea ha resultado además ser una gran ventaja tecnológica, porque

la siguiente generación de telescopios gigantes, como el ELT (de 40 metros) del

ESO y el futuro James Webb espacial, tendrán espejos segmentados. Por esto

adquiere valor añadido notable la experiencia del telescopio español, que heredó

la idea del espejo principal múltiple de los dos Keck estadounidenses, el

primero de ellos estrenado en 1990.

En la otra cara de la moneda, los espejos han supuesto no pocos quebraderos de

cabeza para los responsables del GTC, dadas las dificultades que ha tenido la

empresa francesa que los fabrica. Los problemas de pulido de los bordes están ya

solucionados, asegura Rodríguez Espinosa.

Los espejos han tenido bastante que ver en el retraso acumulado del proyecto,

que "pecó de excesivo optimismo inicial, aunque no podemos estar descontentos en

comparación con otros proyectos similares", dice Quintanilla. Pero no han sido

el único escollo.

Álvarez argumenta que el GTC ha afrontado los problemas normales de cualquier

proyecto de esta envergadura. Parte de los defectos de fabricación de la cúpula

se han subsanado y otros "ya sabemos como arreglarlos y lo haremos este verano,

pero optamos por aplazar las modificaciones necesarias para que no afectaran al

avance de la construcción y montaje del telescopio". También algunas piezas

estructurales dieron problemas. Ahora es el software de control del telescopio

el que preocupa, con el agravante de la escasez de personal para abordar esta

tarea que reconocen responsables del proyecto. En el proyecto trabajan 58

personas.

Con talante de mirar hacia adelante y de confiar en que las fases más

problemáticas han quedado atrás, muchos astrónomos españoles esperan la hora de

empezar a usar el GTC. "Es un elemento crítico en el desarrollo de la astronomía

española, hay científicos que ya están pensando en las observaciones que harán",

comenta Jordi Torras, gestor del Programa Nacional de Astronomía.

Quintanilla señala: "Ahora que se está terminando la puesta en marcha del

telescopio, esperamos que sea lo más provechoso posible; vamos a preparar los

protocolos para optimizar su utilización con los criterios de calidad científica

que deben tener todas las grandes instalaciones".

El GTC cuenta con explotar con éxito lo que se consideran sus especialidades,

frente a los telescopios hermanos o competidores que ya observan el cielo tanto

desde el hemisferio Sur como desde el Norte. "Con el instrumento Osiris podrá

destacar en el estudio de las galaxias activas, el universo violento", adelanta

Rodríguez Espinosa. "CanariCam es idóneo para estudiar discos protoplanetarios

fríos y Emir para observar galaxias en las que la formación estelar es intensa",

añade.

LOS ASTRÓNOMOS ESPAÑOLES PIDEN APOYO PARA LA INSTRUMENTACIÓN

La astronomía de primera línea internacional no se puede limitar a estudiar el

cielo con los mejores telescopios, sino que debe desarrollar a la vez

instrumentación avanzada para los mismos y poder abordar así los retos

científicos más candentes. La astronomía española, aunque ha alcanzado un buen

nivel, tiene todavía pendiente el salto hacia esa faceta instrumental para

seguir avanzando. En ambos puntos se mostraron de acuerdo los participantes en

la sesión de debate sobre el tema que se celebró la semana pasada en el congreso

'Desarrollo de Instrumentación Astronómica: futuros retos científicos y

tecnológicos', organizado por la red científica

Astrid de Madrid, con

participación de más de 150 expertos.

El reciente ingreso de España en el Observatorio Europeo Austral (ESO) parece

ser el catalizador que da carácter de urgencia a este reto de la instrumentación

astronómica si se quieren aprovechar plenamente las oportunidades que esa

organización brinda en cuanto a alta tecnología y experiencia en sus desarrollos

e instalaciones.

"Hacer un instrumento para un telescopio grande es un trabajo de muchos años y

exige mucha dedicación", señaló Carlos Eiroa, coordinador del debate. "¿Estamos

dispuestos, al propia comunidad científica, a crear el clima necesario para que

los jóvenes investigadores se involucren en esta vertiente de la astronomía?

¿Estamos dispuestos a presionar a las instituciones para que se apoye y se

promocione?", planteó.

Manuel Serrano, del

Centro para el Desarrollo Tecnológico e Industrial (CDTI,

del Ministerio de Industria) recordó que aunque se han hecho progresos en los

últimos años, "el sector no está aún estructurado. En el Gran Telescopio de

Canarias se están dando pasos importantes", y añadió: "El desafío ahora es ESO".

Varios expertos apuntaron la necesidad de incorporar personal técnico en las

instituciones científicas y mejorar el trabajo conjunto con las empresas

tecnológicas. Pese a que diferentes grupos españoles participan ya con éxito en

la creación de instrumentos internacionales, sobre todo de misiones de la

Agencia Europea del Espacio (ESA)

y de la astronomía solar, es un buen indicador del camino que aún queda por

recorrer el hecho de que no haya habido ni un investigador principal español en

misiones o proyectos internacionales.

"Astrid es un programa de coordinación de actividades de I+D, del programa

Regional de Ciencia y Tecnología de la Comunidad de Madrid, y se centra en el

desarrollo de instrumentos astronómicos, con 11 grupos científicos participantes

de universidades, instituciones y empresas", explicó Jesús Gallego, coordinador

de Astrid.

Fuente: El País, 30 de Mayo de 2007

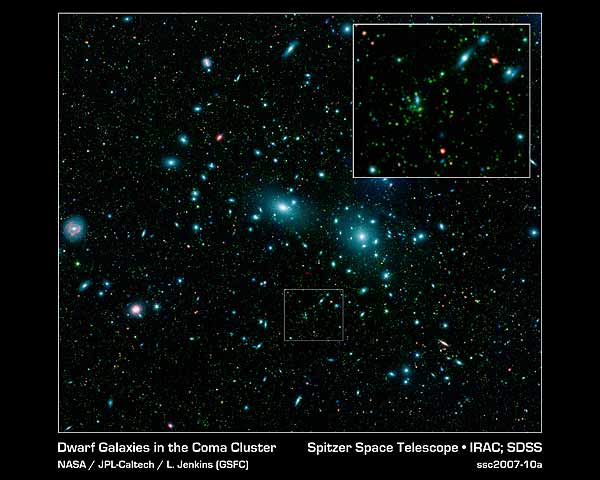

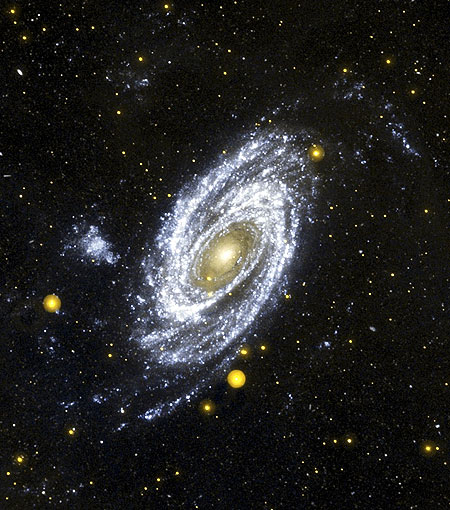

-El telescopio "Spitzer" de la NASA descubre nuevas galaxias enanas

Las observaciones del telescopio espacial 'Spitzer', de la NASA, y el 'William Herschel', situado en la isla canaria de La Palma, han permitido calcular la existencia de miles de galaxias enanas hasta ahora desconocidas a algo más de 350 millones de años luz, una distancia casi inconcebible para nuestra mente pero relativamente cercana cuando se trata de estudiar esta clase de objetos.

Nuevas galaxias detectadas por Spitzer

Las galaxias enanas tienen un gran interés astronómico porque los científicos creen que fueron las primeras en surgir cuando el Universo aún era un recién nacido, de modo que las galaxias más grandes, como nuestra propia Vía Láctea, se formaron después como consecuencia de la acumulación de las más pequeñas.

Las miles de galaxias enanas recién descubiertas se encuentran en el llamado cúmulo de Coma, una densa estructura de forma esférica, con una longitud de 20 millones de años luz (la Vía Láctea mide unos 100.000 años luz, lo que significa que la radiación tarda ese tiempo en recorrerla). Los expertos ya sospechaban que dicho cúmulo, situado en la constelación de Coma Berenices, estaba formado por más de 1.000 galaxias, pero los nuevos datos recogidos por la cámara de infrarrojos del Spitzer han cuadruplicado esta cifra, según los sorprendentes resultados que presentó ayer la investigadora estadounidense Leigh Jenkins, en una conferencia de la Sociedad Americana de Astronomía en Honolulu, Hawai.

El 'Spitzer', que lleva casi cuatro años estudiando la energía de infrarrojos (es decir, calor) proveniente de los confines del cosmos, tomó una serie de 288 instantáneas del cúmulo de Coma.

Jenkins y su colega Ann Horschemeier, ambas pertenecientes al Centro de Vuelo Goddard de la NASA, construyeron un mosaico con estas imágenes y descubrieron cerca de 30.000 objetos, muchos de los cuales parecían galaxias enanas. El cosmólogo iraní Bahram Mobasher, del Instituto Científico del Telescopio Espacial, en Baltimore, partió de estos datos y empleó el observatorio 'William Herschel', situado en el punto más alto de isla de La Palma, para medir la distancia entre estas galaxias y calcular cuántas formaban parte del mismo cúmulo.

El resultado fue 1.200, aunque hay que tener en cuenta que sólo se estudió una fracción del cúmulo, por lo que el cómputo final asciende a un mínimo de 4.000 galaxias. Aun así, los investigadores ya están usando telescopios aún más potentes, como los Keck de Hawai, en busca de galaxias todavía más pequeñas que hayan pasado desapercibidas. "Estamos liquidando los anteriores estudios de cúmulos cercanos", explica Hornschemeier. "Gracias al 'Spitzer', podemos observar con profundidad cúmulos cercanos como el Coma en un corto periodo de tiempo".

Las galaxias que forman el cúmulo Coma tienen unos 15.000 millones de años de antigüedad, y forman parte de una constelación muy poco vistosa a simple vista -Coma Berenices- situada al oeste de Leo y al norte de Virgo, ambas mucho más populares.

La historia conocida de Coma Berenices, también llamanda Cabellera Berenices (coma, en latín, significa cabellera), se remonta al siglo III antes de Cristo. Mientras el faraón egipcio Ptolomeo III, apodado el Bienhechor, se encontraba en Siria combatiendo a sus enemigos, su esposa Berenices realizó un solemne juramento ante el altar de Afrodita: si su marido volvía sano y salvo, se cortaría sus largos cabellos y los entregaría a la diosa como ofrenda. El faraón, en efecto, regresó, y Berenices no tardaría en cumplir su promesa, pero se dice que un sacerdote egipcio, celoso de que una divinidad griega recibiera semejante honor, robó la melena del templo.

Berenices quedó desconsolada, pero pronto acudiría en su ayuda el astrónomo Conón de Samos, quien le aseguró que acababa de aparecer en el firmamento una nueva constelación, y que ésta era en realidad su antigua cabellera, recuperada y llevada a los cielos por Afrodita. Hoy en día, el inmenso cúmulo de galaxias continúa sorprendiendo a los científicos, pero aún debe su nombre a esta leyenda.

Fuente: El Mundo, 29 de Mayo de 2007

-Chip Power6 , el nuevo invento revolucionario de IBM

El sector de los chips vuelve a

agitarse. A principios de esta semana,

IBM

presentó en Londres su nuevo Power6, un microchip para servidores que opera a

una velocidad de 4,7 gigahercios (GHz), el doble que su antecesor, el Power5.

Eso sí, consumiendo la misma energía. Como medida de comparación, algunos

analistas recordaban que el Itanium 2 de

Intel tiene una velocidad de 1,66 GHz.

Con este movimiento, el gigante azul

quiere revolucionar el mercado. El microchip, que se comercializará en junio

(para la línea de servidores Unix incluida), tiene un acceso de ancho de banda

de 300 gigas por segundo.

Y mientras IBM trata de fortalecerse en el segmento de chips para servidores,

Intel y

AMD mantienen su disputa.

Esta última está ultimando el lanzamiento de los chips de cuatro núcleos de la

denominada Serie Barcelona. La firma está en disposición de empezar a producir

en masa sus nuevos procesadores, que se introducirían en los servidores durante

el tercer trimestre de este año.

Con la llegada de estos nuevos equipos, AMD aspira a volver a tener beneficios y

a recuperarse en bolsa. De momento, la compañía se ha visto favorecida por la

mejora en su recomendación por parte de los analistas de Think Equity Partners,

que han justificado su decisión en los pedidos recibidos por AMD de parte de

Dell.

Mientras, Intel ya prepara su respuesta industrial. En los próximos meses, la

multinacional lanzará los procesadores Penryn, presentados ya en el Intel

Developer Forum de Pekín. Una de las características que la empresa ha querido

destacar es la eliminación definitiva del plomo.

Además, Intel anunció esta semana una alianza con la europea ST Microelectronics

en el ámbito de los chips de memoria flash, usados sobre todo en los teléfonos

móviles, para integrar en una sociedad los activos de ambas en esta área. En la

nueva empresa, que tendría unos ingresos anuales de 3.600 millones de dólares,

va a entrar el grupo de capital privado Francisco Partners, que tomará un 6,3%

del capital (a través de la compra de acciones preferentes), valorado en 150

millones.

-El futuro energético está en las papas

Aunque la tecnología del hidrógeno es,

teóricamente, limpia e inagotable, aún pesa un importante obstáculo sobre esta

alternativa que -según el Departamento de Energía de EE.UU.- debería haberse

implantado ampliamente en vehículos a motor para el año 2020.

El impedimento está en el propio combustible: el hidrógeno libre no existe como

recurso, y debe obtenerse por descomposición de fuentes tales como gas natural,

agua, biomasa -mediante su fermentación a etanol- o hidrocarburos, siempre a

través de un proceso energéticamente costoso. Otro inconveniente es la

logística: el almacenamiento, transporte y manipulación. Para empeorar el

problema, expertos del

Instituto Tecnológico de California

advirtieron hace cuatro años que, en una hipotética «economía del hidrógeno»,

los escapes de este gas podrían «comerse» hasta un 10 por ciento del ozono de la

atmósfera.

¿PATATA NORMAL O SUPER?

El procedimiento detallado por Zhang y su equipo en la revista digital «Public

Library of Science» usa como materia prima el

almidón, un compuesto vegetal de reserva abundante en cultivos como la patata o

los cereales. Según el científico, cualquier otro polisacárido vegetal, como la

celulosa, sería una fuente válida. El secreto reside en el uso de una vía

biológica sintética, reuniendo trece enzimas que no se encuentran juntas en la

naturaleza.

Añadiendo el «cóctel» a una mezcla de almidón y agua, y mediante una reacción de

alta eficiencia a baja temperatura y a presión atmosférica, los reactivos se

descomponen en dióxido de carbono e hidrógeno. El primero es recogido en una

membrana, y el segundo alimenta la pila que genera electricidad para mover, por

ejemplo, el motor de un coche.

«Ecológico, eficiente y seguro: hemos matado tres pájaros de un tiro», declaró

Zhang. Y todo con un «combustible» que podría venderse en cualquier

supermercado.

Fuente: ABC, 29 de Mayo de 2007

-Crean un mapa del cuerpo humano tridimensional

Investigadores de una universidad

canadiense han creado el primer modelo virtual en cuatro dimensiones del cuerpo

humano, un dispositivo que no sólo permitirá comprender mejor la evolución de

ciertas enfermedades, sino incluso visualizar cómo tienen lugar en tiempo real.

La imagen, creada por ordenador,

permite ver un cuerpo humano en el que los órganos internos y el sistema

circulatorio aparecen coloreados en distintos tonos. La imagen se proyecta como

una especie de holograma en una sala oscura donde el modelo virtual parece

flotar. Precisamente el proyecto ha sido bautizado como 'CAVE man', un juego de

palabras con el 'hombre de las cavernas' que hace alusión a la oscuridad de la

sala que lo acoge.

La iniciativa, presentada esta semana en la universidad canadiense de Calgary,

comprende más de 3.000 elementos del cuerpo humano. Tal y como explican sus

creadores, el modelo puede ser manipulado a voluntad, como si de un videojuego

se tratase, para poder observarlo desde diversos ángulos o enfocar ciertos

órganos al detalle.

"La imagen está casi viva", se felicita Andrei Turinsky, especialista del

departamento de Bioquímica y Biología Molecular en la

Universidad de Calgary. "Esto nos permite

disponer por primera vez de un modelo completo del cuerpo humano, desde el punto

de vista anatómico, químico y de los tipos de tejidos que lo componen", ha

señalado Turinsky, uno de los padres del diseño.

Empleando técnicas de programación informática, los creadores han llegado a la

creación esta imagen que puede examinarse con unas gafas especiales. El

resultado es una especie de atlas completo del cuerpo humano en cuatro

dimensiones (las tres espaciales y el tiempo) que permite observar la evolución

de ciertas enfermedades o, por ejemplo, estudiar la reacción del organismo a los

medicamentos.

Fuente: El Mundo, 29 de Mayo de

2007

-Kioto pasa factura a los aviones

La UE prevé incluir a las aerolíneas en

el mercado de emisión de dióxido de carbono en 2011, lo que conllevará un gasto

medio anual cercano a los 50 millones de euros entre 2011 y 2017. La lucha

contra el cambio climático que, supuestamente, provocará en el futuro todo tipo

de catástrofes naturales, tal y como se esfuerzan en advertir los ecologistas,

tiene un precio.

El plan de la Comisión Europea (CE)

para incluir, en el año 2011, las emisiones de dióxido de carbono (CO2) que

genera la aviación continental en el mercado de derechos del Protocolo de Kioto

podría suponer, como mínimo, un coste cercano a los 350 millones de euros para

la economía nacional de 2011 a 2017. Además, según la CE, el precio de los

billetes podría incrementarse en 40 euros, en caso de que las aerolíneas estén

obligadas a comprar derechos de emisión para poder volar.

Según los últimos datos publicados por el

Ministerio de Medio Ambiente,

el tráfico aéreo español produjo 4,13 millones de toneladas de CO2 en 1990

-fecha base empleada por Kioto para limitar la emisión de gases de efecto

invernadero (GEI) de cara al futuro-. En 2005 (última cifra disponible), la

aviación nacional emitió 6,9 millones de toneladas de CO2 (el 1,57% del volumen

total de GEI generados por España en ese año)-, lo que representa un incremento

del 66,9% (un 3,5% anual), en quince años.

El próximo octubre, el Parlamento Europeo se expresará sobre la inclusión del

transporte aéreo en el mercado de emisiones a partir de 2011, una fecha que el

Gobierno español espera que se retrase hasta 2013. A partir de entonces, las

aerolíneas europeas estarían obligadas a entrar en el mercado de CO2, si sus

emisiones superan el volumen alcanzado en 2005 (año base para el cálculo en el

sector aéreo). Así, para 2011, suponiendo que el ritmo de crecimiento de las

emisiones del sector se mantuviera constante, España superaría en 1,58 millones

de toneladas (un 22,9%) el límite de Kioto.

Dicho volumen alcanzaría un precio aproximado de 31,6 millones de euros en 2011,

tomando como referencia el coste medio de 20 euros por tonelada de CO2. "El

precio más probable que está barajando el mercado en cuanto a la venta de

derechos de emisión de cara al futuro", explica el director de

CO2

Spain, Larry Philp.

COSTE

Esta tendencia al alza supondría un coste total acumulado de 353 millones de

euros para la economía nacional desde 2011 hasta 2017 (una de las fechas que se

barajan para aplicar la tercera fase de Kioto), unos 50 millones al año. Esta

factura se sumaría a los cerca de 3.000 millones de euros que calcula el

Gobierno para cumplir el segundo Plan Nacional de Asignaciones de 2008 a 2012,

aprobado recientemente por la UE, y que afecta a cerca de mil empresas del

sector industrial y energético.

Sin embargo, la cifra podría resultar, incluso, muy superior a estos cálculos

iniciales, teniendo en cuenta que los aeropuertos españoles atendieron 750.000

vuelos en los cuatro primeros meses del presente año (un 8,3% más que en el

mismo período de 2006), y que el tráfico aéreo internacional crecerá de media un

3,5% hasta 2020, según

Boeing. Mientras, la CE

no descarta recortar aún más el volumen de emisiones permitidas a los Estados

miembro.

Por ello, las aerolíneas españolas comienzan a preparase para el futuro. Spanair

prevé un aumento aproximado de sus emisiones de CO2 cercano al 7,3% de aquí a

2011, que espera compensar con la introducción de "avances tecnológicos en los

aviones, el uso de combustibles alternativos y la mejora de la gestión del

tráfico aéreo y demás instrumentos económicos como comercio de emisiones y tasas

reguladoras, etcétera". Todavía queda saber cuándo se verá afectado el tráfico

por carretera, otro de los sectores exentos de Kioto, que, en España, generó 95

millones de toneladas de CO2 en 2005 (más del 20% del total).

BRUSELAS BUSCA LA MANERA DE COBRAR EL CO2

La Unión Europea trabaja en la inclusión del transporte aéreo en el comercio

desde hace casi cinco años. A lo largo de este periodo, los países han

presentado doce sistemas distintos para tratar de limitar los gases que emiten

los aviones en la atmósfera. No obstante, actualmente, se barajan sólo dos

posibilidades: la ecotasa o la entrada en el comercio de emisiones. La primera

iniciativa implica gravar los billetes que adquieren los viajeros, con un

impuesto verde por la contaminación del vuelo.

Otra posibilidad, que según el director de CO2 Spain, Larry Philp, supondría un

sistema más práctico y sencillo, hubiera consistido en gravar con más impuestos

el consumo de combustible de los aparatos, en contraposición "al complejo

sistema de derechos de emisión". Sin embargo, todo apunta a que será esta última

propuesta la que salga adelante. Según la Comisión Europea, "los operadores

aéreos podrán comprar créditos de emisión de otros sectores dentro de la UE para

cubrir el límite de emisiones".

Esto afectará a todos los vuelos que se realicen entre países europeos a partir

de 2011 y, desde 2012, a todos aquéllos con destino o salida en cualquier país

de la UE. La cifra exacta de derechos de emisión para el sector aéreo se fijará

en relación a la media de emisiones de la industria entre 2004 y 2006, si bien,

"un porcentaje fijo quedará exento de pago". La asignación de derechos para los

dos primeros años (2011 y 2012), vendrá determinada por lo que hayan establecido

los miembros de cada Estado, que estarán representados en un único órgano

comunitario.

Además, los operadores aéreos deberán llevar un control de sus emisiones, cuyo

informe será remitido a la autoridad competente cada 31 de marzo. No obstante,

hasta el próximo octubre no se sabrá la propuesta final.

Fuente: Expansión 28 de Mayo de 2007

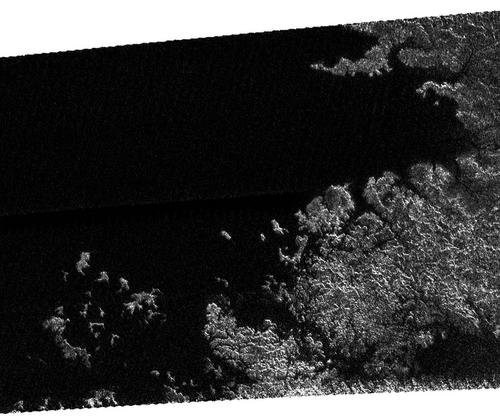

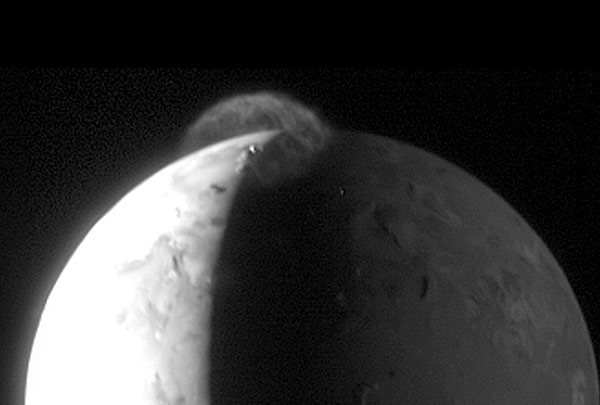

-Nuevas imágenes de Cassini nos acercan a Titán

Titán, la luna mayor de Saturno, tiene mares, montañas, islas y bahías y su topografía es similar a la de la Tierra, según revelan fotografías transmitidas por la nave espacial 'Cassini' y publicadas por la NASA.

Sin embargo, los mares de Titán no son azules ni son de agua, sino que son negros intensos debido a que sus componentes principales son metano y etano, señaló la agencia estadounidense en un boletín.

Imagen

de Cassini del pasado 12 de Mayo donde se muestra una línea de costa y numerosas

islas en un gran mar

Según los científicos de la NASA, la ausencia de brillo en algunas regiones

mostradas por las fotografías sugiere que la profundidad del líquido "marino"

sería de varios metros al menos.

Por otra parte, el contorno de las islas sigue la misma dirección de las

penínsulas, lo que indicaría que han sido formadas por una inundación.

Las imágenes fueron captadas por el radar de 'Cassini' el pasado 12 de mayo

cuando la nave realizaba su aproximación número 31 a Titán.

La misión de 'Cassini' es un proyecto conjunto de la NASA, la

Agencia Espacial

Europea y la

Agencia Espacial

de Italia.

La sonda inició su misión el 15 de octubre de 1997 y entró en la órbita de

Saturno en julio de 2004.

En enero de 2005 se desprendió de la sonda 'Huygens', que descendió sobre Titán

y de inmediato comenzó a transmitir información sobre sus condiciones

ambientales.

Titán no sólo es la luna más grande de Saturno sino también la segunda más

grande del sistema solar, sólo comparable a Ganímedes, uno de los 16 satélites

de Júpiter.

Pese a estar clasificado en la misma categoría que, por ejemplo, la Luna, Titán

es más grande que planetas como Mercurio o Plutón.

La temperatura de la superficie de Titán parece ser de unos -178 °C. Tiene una

atmósfera más densa que las de Mercurio, la Tierra, Marte y Plutón, y la presión

atmosférica es de unos 1.6 bares, un 60% mayor que la de la Tierra.

Fuente: EFE, NASA, 28 de Mayo de 2007

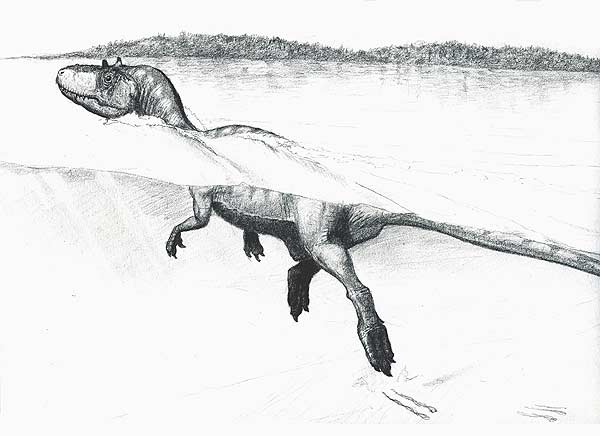

-El dinosaurio nadador de La Rioja

Hubo dinosaurios que volaban, pero ahora también sabemos que eran capaces de nadar con soltura. Así lo demuestran las huellas halladas en La Rioja, primera evidencia científica de que aquellos grandes seres del Cretácico flotaban sobre las aguas.

El dinosaurio nadador podía ser así

El hallazgo de unos arañazos fosilizados en el yacimiento de la Virgen del Campo, en el municipio riojano de Enciso, fueron la pista que llevó al paleontólogo español Rubén Ezcarra, de la Fundación Patrimonio Paleontológico de La Rioja, y al francés Loic Costeur, de la Universidad de Nantes (Francia) a la confirmación de algo que ya se sospechaba, pero que no había podido demostrarse con certeza.

El equipo encontró 12 huellas consecutivas del mismo ejemplar en un rastro de unos 14 metros. Se trataba, según explican en la prestigiosa revista Geology, de la Sociedad Americana de Geología, de un dinosaurio terápodo no volador que iba flotando, dado que las huellas se corresponden con la señal que dejaron sus uñas al rozar el fondo de la laguna en cuyos alrededores vivía.

El rastro revelador lo forman seis pares asimétricos de arañazos de un promedio de 50 centímetros de longitud por 15 de ancho. El espacio entre ellos sugiere que el dinosaurio daba los pasos a un intervalo de entre 2,43 y 2,71 metros y a una profundidad de unos 3,2 metros dentro del agua, como indican los sedimentos.

Fuente: El Mundo, 25 de Mayo de 2007

-Estados Unidos da Luz Verde a la primera píldora anticonceptiva que elimina la menstruación

La Agencia Federal del Medicamento (FDA) ha aprobado la venta en las farmacias de los Estados Unidos de la primera píldora anticonceptiva que suprime de forma indefinida el ciclo menstrual de las mujeres. El producto, que se comercializará con la marca Lybrel, utiliza una combinación en bajas dosis de las hormonas sintéticas utilizadas por otros anticonceptivos orales. Pero con la peculiaridad de que los envases de 28 píldoras para un mes no incluirán los múltiples placebos que normalmente permiten el ciclo menstrual.

El fármaco, desarrollado por la

compañía

Wyeth Pharmaceuticals y

que se espera comercializar a partir del mes de julio con receta, es presentado

como ideal para aquellas mujeres que sufren de excesivas molestias y

complicaciones durante sus periodos, pero también para las interesadas en

eliminar de sus vidas esta parte incómoda de la biología reproductiva. Según ha

recalcado Amy Marren, portavoz de los laboratorios fabricantes, «hay muchas

mujeres que consideran esto como una gran opción».

A tenor de las investigaciones facilitadas a la FDA, durante dos pruebas

clínicas realizadas con 2.400 voluntarias durante un año, este producto

farmacéutico ha demostrado ser tan efectivo a la hora de evitar embarazos como

otras píldoras anticonceptivas estándares. Logrando suprimir completamente la

menstruación durante el primer año de consumo, aunque con el desagradable efecto

secundario de hemorragias y pérdidas de sangre esporádicas.

Grupos de activistas a favor de los llamados derechos reproductivos han dado la

bienvenida al lanzamiento de Lybrel. Según ha insistido al

Washington Post Vanesa Cullins, de la

Federación de Paternidad Planificada de Estados Unidos,

«las necesidades de control de natalidad de cada mujer son diferentes y los

mejores métodos son aquellos que encajan dentro del estilo de vida y las

necesidades de cada mujer».

OTRAS PÍLDORAS

Durante los últimos años, la FDA ya ha venido aprobando otras píldoras

anticonceptivas que reducen los días de menstruación, o incluso limitan el

número de periodos de una mujer a cuatro veces por año. En el caso de Lybrel,

como las mujeres que utilicen estas píldoras pueden desconocer si están

embarazadas, la FDA insiste en realizar los correspondientes análisis para

descartar o confirmar tal posibilidad.

Con todo, la aprobación de Lybrel -todavía sin precio fijado de venta al

público- no ha dejado de plantear su corresponde dosis de reproches y críticas.

Empezando por dudas sobre la existencia de suficientes estudios sobre su

seguridad y sobre la sabiduría de suprimir indefinidamente el ciclo menstrual de

las mujeres.

A juicio de algunos especialistas médicos, en la actualidad no se conoce por

completo la relevancia de estos ciclos como para aventurar que su eliminación no

tendrá consecuencias negativas en el futuro.

NATURALEZA CONDICIONADA

Aunque según ha enfatizado Daniel Shames, subdirector del centro de evaluación e

investigación de fármacos de la FDA, «los riesgos de usar Lybrel son similares a

otros contraceptivos orales, no sospechamos que vayan a existir sorpresas a un

largo plazo de este producto». En este sentido, se ha recordado que

tradicionalmente las mujeres no han tenido trece periodos naturales, año tras

año, por la sucesión de consecutivos embarazos y periodos de lactancia.

La polémica de Lybrel se ha trasladado incluso hasta el terreno de la psicología

y el feminismo. Como ha cuestionado la profesora Ingrid Johnston-Robledo, de la

Universidad Estatal de Nueva York, este fármaco

«plantea un mensaje equivocado sobre la menstruación en las vidas de las

mujeres, especialmente para las más jóvenes, al perpetuar numerosas actitudes

negativas y tabúes que coinciden en presentar el ciclo femenino como algo que

roza lo sucio, debilitador y vergonzoso».

Fuente: ABC, 24 de Mayo de 2007

-Estrellas naciendo en Orión vistas por el telescopio Spitzer

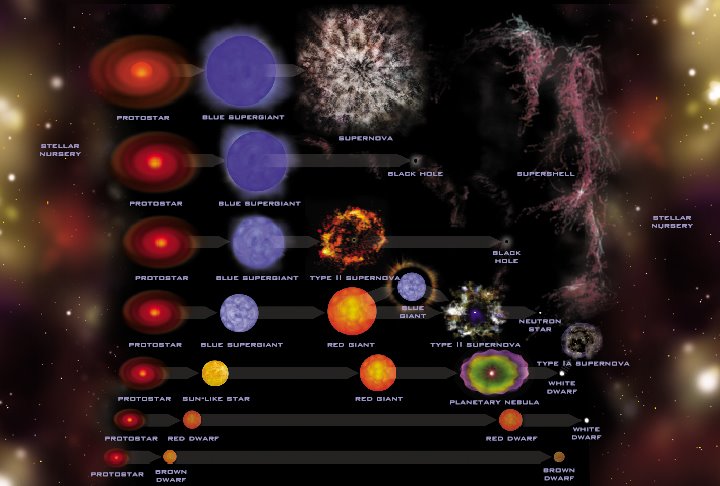

Las imágenes, que han sido objeto de una nota de prensa por parte de NASA, muestran una nueva población de estrellas y de enanas marrones que posiblemente han sido creadas a partir de la explosión de una supernova hace aproximadamente 3 millones de años.

Barnard 30, localizada a unas 1300 años luz

La investigación ha sido liderada por

un equipo de astrónomos dirigido por el español David Barrado Navascués del

Laboratorio de Astrofísica Espacial y Física Fundamental de INTA.

Spitzer es un satélite astronómico de NASA (lanzado en 2003) que permite

analizar el rango infrarrojo del espectro. El estudio del infrarrojo es

especialmente adecuado para comprender los momentos iniciales del Universo así

como el nacimiento de nuevas estrellas, de sistemas planetarios o de objetos

fríos, ya que la radiación infrarroja es capaz de atravesar las densas nubes de

polvo y gas interestelar, que se forman alrededor de estos objetos y que los

hacen invisibles a otros instrumentos.

Las imágenes del Spitzer proceden de

una región denominada Barnard 30, situada en la constelación Orión. Se

trata de una zona que contiene varias nubes formadas por polvo y gas

interestelar muy fríos. Su estructura regular, casi circular, indica que su

origen se debe a la explosión, hace unos 3 millones de años, de una estrella

supermasiva, que expulsó ingentes cantidades de materia y energía en un final

apocalíptico.

Spitzer ha atravesado esta densa nube de polvo y ha descubierto la formación de

una nueva asociación estelar, un conjunto de estrellas de baja masa y de enanas

marrones (objetos de apariencia estelar, que no tienen masas suficiente como

para poder generar energía en su interior a partir de reacciones nucleares y que

se pueden catalogar como verdaderos eslabones entre las estrellas y los

planetas). Además, un número apreciable de estas estrellas y enanas marrones

presentan discos de polvo alrededor de las mismas, que es el material a partir

del cual se forman los planetas. Por tanto, nos encontraríamos también ante el

incipiente nacimiento de nuevos sistemas planetarios.

Fuente: Redacción, mi+d, 23 de Mayo de 2007

-Gro Harlen Brundtland: Hay que pasar ya a la acción porque el cambio climático está fuera de control

Gro Harlem Brundtland vuelve a la senda

del medio ambiente. Hace 20 años, la dos veces primera ministra noruega y luego

directora de la

Organización Mundial de la Salud

fue la encargada de dirigir una comisión de la ONU para buscar caminos que

compaginaran la empresa humana y los límites del planeta. La población mundial

rozaba en ese momento los cinco mil millones de personas. Los científicos

alzaban las primeras voces preocupantes sobre el cambio climático. A sus 68

años, la doctora Brundtland ha sido llamada para atacar una vez más los

problemas ambientales.

Ahora, la población del planeta supera

los 6.500 millones de personas, y casi la mitad de ellas viven con menos de dos

dólares diarios. Las emisiones contaminantes están creciendo sin freno en las

potencias económicas ya establecidas y en las que aspiran a serlo, en un mundo

en el que la expansión económica es la principal meta a alcanzar.

El secretario general de la ONU, Ban Ki-moon, ha elegido a Gro Harlem Brundtland como

enviada especial para el cambio climático, con la tarea de estimular a los

gobernantes a actuar para reducir las emisiones de gases de efecto invernadero.

Una de sus primeras paradas ha sido Madrid para participar en la iniciativa

«Liderazgo Global para la Acción Climática», auspiciada por la

Fundación Naciones Unidas y el

Club de Madrid.

Pregunta. Es una de las autoras del concepto de desarrollo sostenible. Ahora,

con la urgencia del cambio climático ¿es necesario dar un impulso a este

concepto?

Respuesta. El análisis y las recomendaciones del informe «Nuestro futuro común»

de hace 20 años, en el que se establecen las bases del concepto de desarrollo

sostenible, siguen siendo relevantes ahora. Si mira a lo que se dijo en ese

momento, los mensajes son los mismos. Por tanto, la cuestión no es un nuevo

mensaje, sino más acción. Y de hecho todo lo que el mundo ha acordado en las

cumbres de Río y Johanesburgo sobre lo que debía hacerse sigue vigente, pero el

nivel de acción debe ascender a otro punto, porque estamos perdiendo tiempo

mientras el problema climático está fuera de control.

P. ¿Cómo ve todo lo ocurrido desde la Cumbre de Río en 1992?

R. Bueno, ha habido cosas positivas y negativas. Ha habido cambios en la

dirección correcta en cuanto al número de contaminantes ambientales, como el

sulfuro, los policlorobifenilos, etc., y en algunas áreas el mundo

industrializado ha cambiado. Pero en muchos aspectos que están más relacionados

con la biodiversidad y con el desarrollo de unos patrones más sostenibles en el

mundo en desarrollo la situación ha cambiado muy poco o ha ido en la dirección

errónea. Así, en África, la situación es peor que hace veinte años: hay más

desertificación, mayor escasez y contaminación del agua y un problema casi

irreversible de erosión del suelo. Y la cuestión del clima y el calentamiento

global no harán más que sumarse a estos problemas y empeorarlos.

P. ¿Proteger el medio ambiente a escala global requiere nuevas políticas

económicas?

R. Sí. En el mundo desarrollado debemos entender que invertir en nuestro propio

futuro, en el futuro de nuestros hijos y nietos, significa compartir algunos de

nuestros recursos con los países pobres. Por ejemplo, en Noruega se paga

alrededor del 1% del Producto Interior Bruto (PIB) cada año en cooperación al

desarrollo. Muchos de los países industrializados no lo hacen y debemos

conseguirlo. El acuerdo de hace 30 años hablaba de un 0,7% del PIB para esta

cuestión, pero sólo muy pocos países han alcanzado este nivel. No debería ser

imposible y marcaría una gran diferencia, puesto que la salud y la educación son

las bases del desarrollo, también del desarrollo sostenible.

P. El protocolo de Kioto incluye mecanismos para invertir en países en

desarrollo...

R. Sí, por supuesto, pero esos mecanismos que acordamos en Kioto no se están

usando en todas sus posibilidades y lo que es seguro es que no se están

utilizando en beneficio de las naciones en desarrollo o, por lo menos, no de las

realmente necesitadas. No es lo mismo China que África.

P. ¿Cree que ha llegado el momento para que algunos países en desarrollo

renuncien a la idea de que los desarrollados son los únicos responsables del

cambio climático?

R. Tenemos que cambiar la filosofía de base, porque históricamente es

absolutamente cierto y sólo en los últimos años las emisiones de los países en

desarrollo son cuantificables. Pero si hablamos de lo que tenemos que hacer

desde ahora hasta 2012, los escenarios cambian. Históricamente tenemos que

avergonzarnos, pero si miramos hacia adelante nos necesitamos unos a otros para

buscar las soluciones, aunque el mundo industrializado tendrá que llevar la

mayor carga.

P. ¿Cuál será exactamente su labor como enviada especial de la ONU para el

cambio climático?

R. Ayudar al secretario general a conseguir un consenso global en las cuestiones

sobre las que debe girar la nueva negociación. Esta es su agenda durante este

año hasta la Cumbre Mundial del Clima de Bali, en diciembre. Él necesita la

ayuda de gente como yo, que pueda viajar y tener contactos directos con los

gobiernos, para intentar sacar a relucir las sensibilidades y ver dónde están

los problemas para poder llegar así a terrenos comunes.

P. ¿Qué países visitará usted?

R. No queremos dar detalles sobre esto porque hay países a los que no interesa

que estas visitas sean un asunto público, pero sí le puedo decir que ya he

hablado con los representantes del grupo de los pequeños Estados insulares, con

varios países africanos y con Canadá, que debe cambiar algunas de sus políticas

si no quiere parecerse a Estados Unidos.

P. ¿Es posible el acuerdo en Bali para reducir emisiones después de 2012?

R. Pensamos que sí, pero yo añadiría que es necesario.

P. Parece que en los últimos años la gente es más consciente del problema.

Después de tantos años trabajando en esto, ¿no le ha sorprendido que se haya

tardado tanto tiempo?

R. No del todo. Los científicos y algunos políticos lo han sabido desde hace

años, pero el público en general sólo lo ha sabido o ha querido saberlo cuando

ha empezado a ver las consecuencias, como el «Katrina» o el hecho de que el

hielo se esté derritiendo en Groenlandia. Y por eso pienso que Al Gore ha hecho

un buen trabajo revelando la realidad, hablando con el público y enseñándoles

las imágenes del desastre.

P. Antes de esta misión usted luchaba contra el sida, la malaria, el

tabaquismo... ¿Es un desafío tratar ahora con la salud del planeta en sí mismo?

R. Siento que siempre lo he hecho. Desde el principio mi trabajo ha girado sobre

desarrollo, salud y medio ambiente.

Fuente: ABC, 23 de Mayo de 2007

-Marte tuvo agua en abundancia

'Spirit', el vehículo explorador de la NASA en Marte, ha revelado la existencia de sílice en el planeta, lo que demuestra que éste tuvo agua en abundancia durante su pasado remoto, según ha informado el Laboratorio de Propulsión a Chorro (JPL) de la agencia espacial estadounidense.

Este descubrimiento se agrega a las

pruebas casi concluyentes de que en un momento de su evolución Marte albergó

condiciones favorables al desarrollo biológico como lo conocemos en la Tierra.

Un boletín de JPL señaló que los yacimientos de sílice fueron descubiertos en

las cercanías del cráter Gusev, donde 'Spirit' descendió hace más de tres años.

Científicos de ese organismo de la NASA indicaron que para que se produjeran

concentraciones de hasta 90% de sílice el ambiente en las cercanías de Gusev

tuvo que haber sido muy húmedo.

"Nuestra gente quedó asombrada" cuando se conocieron los resultados del

analizador químico instalado en un extremo del espectrómetro de rayos X de 'Spirit',

señaló Steve Squyres, responsable del programa de los robots exploradores de

Marte.

'Spirit' y el vehículo explorador gemelo 'Opportunity' descendieron sobre la

superficie marciana en enero de 2004 y a los pocos meses revelaron que el

actualmente árido planeta tuvo agua en su pasado.

Esas pruebas estuvieron constituidas por la existencia de altas concentraciones

de azufre, la alteración de minerales e indicios de actividad volcánica

explosiva que hubiesen requerido agua.

Pero la presencia de sílice "es la mejor prueba de que hubo agua en el cráter

Gusev", indicó Albert Yen, geoquímico de la NASA en JPL.

Según los científicos de JPL, es posible que el sílice se haya formado tras la

combinación del suelo con vapores ácidos producidos por una actividad volcánica

en presencia de agua.

La otra es que el material haya sido creado por un ambiente de aguas termales.

"Lo más importante de esto es lo que nos dice acerca de la existencia de

ambientes que tuvieron similitudes con lugares en la Tierra donde se han

desarrollado algunos organismos", dijo David Des Marais, astrobiólogo del

Centro Ames de Investigaciones

de la NASA.

Doug McCuistion, director del Programa de Exploración de Marte, señaló que la

presencia de sílice refuerza la idea de el agua fue abundante en Marte e

"impulsa nuestra esperanza de que podamos demostrar que el planeta fue alguna

vez habitable y tal vez posibilitó la existencia de vida".

Entre tanto, en la antípoda del planeta, 'Opportunity' ha completado la

exploración del cráter Victoria, iniciada hace ocho meses.

John Callas, director del proyecto para los vehículos exploradores, dijo que el

vehículo se desplaza ahora hacia una zona llamada 'Duck Bay' para buscar un

sendero seguro hacia el cráter.

Fuente: El Mundo, 23 de Mayo de 2007

-La UE da el primer paso para la creación de una Política Espacial Europea

La UE y la Agencia Espacial Europea (ESA) han sentado las bases de una política espacial común al adoptar un acuerdo que mejorará la coordinación entre sus actividades y evitará la duplicación de esfuerzos.

La decisión se tomó en la cuarta sesión

del Consejo Espacio y se plasmó en una resolución sobre 'Política Espacial

Europea' que incide en la importancia de ese sector "como elemento estratégico

que contribuye a la independencia, seguridad y prosperidad de Europa".

El comisario europeo de Industria, Gunter Verhuegen, opinó que con la decisión

adoptada, Europa se suma a Estados Unidos, Rusia y China, países que están

apostando por una política espacial fuerte.

"Sin una política espacial europea, Europa pasaría a ser irrelevante. Con esta

resolución pretendemos revivir las aspiraciones europeas de liderazgo global en

importantes áreas industriales y de investigación", señaló el comisario.

Verheugen incidió además que el continente "ya no es el pariente pobre del

espacio", aunque insistió en que se debe hacer un esfuerzo por "mejorar su

rendimiento" y aumentar su eficiencia.

Por su parte, el director general de la ESA, Jean-Jacques Dordain, consideró que

el consenso logrado entre los 29 países presentes en la Agencia Espacial Europea

y la UE "es el mensaje más fuerte que Europa puede dar a sus ciudadanos y a los

socios internacionales".

Según Dordain, la "novedad" de la resolución adoptada es que "integra todas las

dimensiones europeas", incluida la ciencia, la educación y las actividades de

seguridad y defensa.

El director de la ESA precisó además que el paso dado no significa que exista la

intención de convertir a la Agencia Espacial Europea en una agencia comunitaria.

La resolución apuesta además por mejorar las sinergias entre los programas

espaciales civiles y de defensa y en el uso de tecnologías.

También subraya la necesidad de que, tanto a nivel comunitario como europeo,

aumenten los esfuerzos para animar a los jóvenes a seguir estudios técnicos, una

formación indispensable en esta área.

Peor suerte ha corrido en el consejo el programa 'Galileo', el proyecto europeo

para crear una red de satélites de navegación que pueda competir con el

estadounidense GPS. El proyecto, que la semana pasada la Comisión decidió que

será financiado íntegramente con dinero público después de los diversos fracasos

de las empresas privadas para sacarlo adelante, fue calificado como una idea

"estúpida" por el vicepresidente de la Comisión, que señaló que el proyecto

"tiene unas funciones muy limitadas".

Guenter Verheugen, comisario de Industria de la Comisión, señaló en una rueda de

prensa que el sistema no es tan importante para la política espacial europea

como lo son otros. "'Galileo' es una idea estúpida, porque sólo permite hacer

una cosa: ayudarte a navegar, nada más", criticó tras la reunión del Consejo.

El sistema Galileo, que prevé la puesta en marcha de una red de 30 satélites, es

responsabilidad del francés Jacques Barrot, vicepresidente de la Comisión

Europea y Comisario de transportes.

Verheugen, que tiene un largo historial de encontronazos con otros comisarios,

matizó después que "desde el punto de vista comercial, Galileo es un proyecto

interesante, pero si se compara la complejidad tecnológica de otros proyectos

espaciales, 'Galileo' es un proyecto estúpido".

Fuente: EFE, 23 de Mayo de 2007

imbo Wales ha dejado una importante

huella en la Red de la mano de su creación,

Wikipedia, fundada hace

seis años. Aquel proyecto de enciclopedia cuyo software libre permitía editar

sus entradas a cualquier persona, es hoy una web que consistentemente está entre

las 10 más populares del mundo, según

Alexa.com.

Pero para este dinámico visionario de 41 años, su aventura en la Red continúa.

Ahora ultima otro proyecto, basado, de nuevo, en software libre, y que puede

cambiar el modelo de negocio de los buscadores. Calcula que esté listo para

moverse a toda capacidad a finales de año.

Se trata de

Wikia. Esta página web es

el hogar de comunidades en la Red en la que éstas pueden leer, discutir,

alterar, manejar, actualizar y compartir información de cuestiones que les unan.

Es un foro de foros con formato de revista y con entradas elaboradas por los

usuarios que cubren el mundo de la salud, el de los viajes o el entretenimiento,

entre otros, y al que se le añadirá el buscador.

A diferencia de Wikipedia, Wikia es una empresa con ánimo de lucro, cuya primera

fuente de ingresos es la publicidad. Varios inversores, entre ellos Amazon, han

aportado los cuatro millones de dólares del capital inicial de esta compañía en

la que Wales empezó a trabajar a fines de 2004 junto con Angela Beesley, miembro

de la Fundación Wikipedia.

El gran reto de Wikia pasa por poner en marcha el buscador que Wales cree que

estará listo a fin de año. Su código será abierto para que esté a disposición de

quien lo quiera o necesite. Para que no sólo sea usado sino también copiado y

que las búsquedas estén controladas por una comunidad de personas con

sensibilidad y compromiso y no intereses comerciales.

¿Y cómo va a financiarse? 'Publicidad. Abriendo el contenido se incrementa el

tráfico', aseguraba Wales en un encuentro con la prensa extranjera en Nueva York

recientemente. Tiene claro es su opinión sobre el resto de los buscadores. Cree

que hasta que llegó Google la calidad de las búsquedas había sido mala pero 'el

éxito de ésta obligó al resto a hacer mejoras'.

Wales quiere dar la impresión de que es más un hombre con ideas y dotes para la

organización que un gestor. Rápidamente asegura: 'No soy un empresario'. Para

redondear esa percepción afirmó desconocer por qué el precio de Google está tan

alto y expresó su sorpresa por un artículo publicado en la revista Fast Company

sobre él en el que le presentaban como una amenaza para el líder de los

buscadores. 'Es divertido, Google es inmenso. Yo solo soy yo'. Para ser preciso,

el mundo de la economía no le es tan ajeno ya que si se ha dedicado a Wikipedia,

una fundación sin ánimo de lucro, es porque la fortuna que hizo como

intermediario de opciones y futuros en Chicago se lo ha permitido. Además tiene

un máster en finanzas.

Tampoco está tan solo. Además de la legión de entusiastas que desean participar

de forma desinteresada, en Wikia ya trabajan 33 personas con dedicación

exclusiva, buena parte de ellas desde Polonia. Ha fichado a Gil Penchina, de

Ebay, para que sea el consejero delegado, y a Jeremie Miller, fundador de una

plataforma de mensajería instantánea de código abierto (Jabber) para trabajar en

el buscador. Wales ve Wikia como una empresa con fuerte potencial pero muy

pequeña frente a los grandes. Pero dice que su madre está orgullosa 'compró

hasta cinco revistas en la que me llevaron a la portada'.

En su encuentro con corresponsales en Nueva York, Jimbo Wales no ahorró

alabanzas para el browser Firefox por ejemplo. 'Hay un cambio que se está

produciendo y que está empezando ahora, es la democratización de los medios y el

conocimiento. Creo que la gente puede colaborar de forma libre y hacer un buen

trabajo'.

Todo ello, el mundo de los blogs y la información online, ¿es el fin de las

empresas de comunicación? El reto que plantea Internet es muy intenso en la

prensa y la de EE.UU., acostumbrada a extensas tiradas, lo sufre como nunca

ahora.

Wales no cree que el software libre y el acceso a la información online sea el

fin de la prensa y el negocio de los medios. 'Mi visión es que los periódicos

que tendrán éxito serán los que no metan la cabeza bajo la tierra', aludiendo al

ineludible potencial de Internet.

'Si se compara la calidad de los productos de búsqueda de Google, Yahoo o Ask,

uno se da cuenta de que todos son muy similares', afirmaba Jimbo Wales. De

acuerdo con este nuevo empresario, ninguno tiene claramente el liderazgo en la

calidad y todos tienen sus inclinaciones comerciales.

Fuente: Cinco días, 22 de Mayo de 2007

-La próxima guerra será por el agua

Los problemas en el abastecimiento de agua han disparado la importancia económica, social e incluso política de este recurso. Su escasez y su mala gestión son ya una amenaza para el crecimiento de la economía mundial, además de un riesgo de tensiones territoriales.

Los visionarios aseguran que en la

próxima gran guerra se luchará por el petróleo. Sin embargo, a día de hoy no es

estrafalario pensar que el agua podría adelantarse como causa de disputa.

Hay signos evidentes en todo el mundo de que la escasez en el abastecimiento de

agua ya está produciendo conflictos o miedo a que se produzcan. El agua está en

el corazón de las tensiones en Oriente Medio, afectando a Israel y los

territorios palestinos, Siria, Líbano y Jordania. Todos tienen derechos sobre el

río Jordán, del que dependen para la agricultura, el agua potable y los

servicios sanitarios.

Otras zonas de peligro incluyen las cuencas de los ríos Nilo, Níger y Zambezi,

en África; o la disputa entre Siria y Turquía por el Tigris y el Éufrates.

Incluso en las zonas sin riesgo de violencia, los países con escasos recursos

están pagando el precio a través de pérdidas de productividad y ralentización

del crecimiento económico.

Este mismo verano, la amenaza de sequías catastróficas no se cernirá sólo sobre

África, sino también en otras zonas, como Europa. El reto es encontrar

soluciones a nivel internacional, antes de que la sequía se convierta en un

desastre para la economía mundial.

La contundencia de las estadísticas basta para convencer del problema tanto a

economistas como a ecologistas. La ausencia de agua potable y servicios

sanitarios que sufre más del 40% de la población mundial supone unos 485 miles

de millones de euros cada año, según datos de la

Organización Mundial de la Salud. Un informe

del

Banco Mundial sobre la

sequía que padeció Kenia entre 1998 y 2000 asegura que uno de sus efectos

directos fue la reducción en un 16% del PIB del país.

En países desarrollados, las restricciones de agua también pueden ser

económicamente devastadoras. El Departamento Oceánico y Atmosférico de Estados

Unidos asegura que las pérdidas en este país debidas a la sequía rondan los

8.000 millones de dólares anuales. Las restricciones en Europa en 2003

supusieron 13.000 millones de dólares para su economía, sobre todo por los

efectos en las cosechas agrícolas.

Incluso en los lugares donde hay abundancia de agua, la mala gestión y la

persistencia de sistemas de distribución injustos consiguen que haya gente que

pase sed mientras otros llenan sus piscinas con agua mineral. Pero, ¿por qué se

ha convertido de repente el agua en un elemento de preocupación para la economía

mundial? Uno de los culpables es el cambio climático, que, además de disminuir

las reservas de agua en algunas regiones, está causando inundaciones en las

áreas donde los glaciares se están derritiendo.

Además, las necesidades de la agricultura moderna son inabarcables. Se necesitan

mil toneladas de agua para producir una de cereal.

La industria también pasa sed: actividades como la producción de alimentos o la

industria textil requieren enormes cantidades de agua.

La contaminación de las reservas de agua -ya sea por sal, por residuos humanos o

animales o toxinas provenientes de la industria- es otro problema acuciante,

particularmente en China, donde el agua destinada al consumo de 300 millones de

personas, casi un cuarto de su población, está habitualmente contaminada por

productos químicos, como incluso ha reconocido la agencia oficial de noticias

Xinhua. Esta escasez de agua potable es uno de los pocos problemas que podrían

frenar el crecimiento de China e India, asegura Bjron Stigson, presidente del

Consejo Empresarial Mundial para el Desarrollo Sostenible: "Las propias

autoridades chinas reconocen que es el mayor problema al que se enfrentan".

POSIBLES SOLUCIONES

Los avances tecnológicos podrían ser una gran ayuda para paliar las diferencias

entre demanda y reservas de agua. El más importante es la reutilización de agua,

mediante el tratamiento de aguas residuales para que se devuelvan con seguridad

a los ríos, destinarlas a usos agrícolas o usarlas en procesos industriales. La

desalinización -una opción que ha sido elegida en España- es otra posibilidad,

pero tiene la contrapartida de que necesita grandes cantidades de energía. Otra

alternativa es la implantación de cultivos que, gracias a modificaciones

genéticas, pueden utilizarse en zonas de sequía o de alta salinidad. Tanto esta

opción como la desalinización no convencen a los grupos ecologistas.

Sea cual sea la técnica utilizada, el ahorro de agua será un elemento vital,

sobre todo si se tiene en cuenta que la Tierra albergará cerca de 9.000 millones

de personas en 2050. La salud de muchas de ellas, y también la economía mundial,

dependerá de las políticas hidrológicas que se emprendan.

¿TIENE LA CULPA EL CAMBIO CLIMÁTICO?

Constantemente se habla de los efectos que el cambio climático tendrá sobre los

recursos hidrológicos en el planeta. Las previsiones son que en 2080 la

temperatura media haya ascendido cuatro grados, con las consecuencias que eso

puede tener: aumento del nivel del mar, deshielo de glaciares, sequías y lluvias

torrenciales más acusadas, etcétera. Sin embargo, según los expertos, las

grandes sequías que Europa ha conocido en los últimos tiempos responden, sobre

todo, a la mala gestión que se hace del agua.

Juan Pablo Pérez, vocal de Medio Ambiente del

Colegio Oficial de Geólogos

y gerente de

Garrigues Medioambiente,

explica que "estamos en una época en la que existe un excesivo afán por

interpretar cualquier fenómeno natural como consecuencia del cambio climático.

Los problemas de la sequía surgen, en el 80% de los casos, de una mala gestión

del agua. Hay mucho despilfarro. Sobre todo en el regadío. Además, en algunos

países -entre ellos, España-, se paga hasta 20 ó 30 veces menos de lo que cuesta

el agua, no hay conciencia de su precio real, sobre todo entre los agricultores,

que consumen el 80% del total". Hay experiencias en otros países que demuestran

la importancia del precio en el consumo. En Hungría el agua había sido

subvencionada casi al completo hasta 1990, y se aumentó el precio unas quince

veces. Esto provocó una reducción de la demanda del 50%. Según la OMS, la

escasez de agua provoca pérdidas de 485 miles de millones de euros cada año.

Fuente: Expansión, 22 de Mayo de 2007

-La ONU asegura que "estamos a las puertas de una extinción masiva de especies"

El apetito por los bienes de consumo y

servicios por parte del segmento más privilegiado de la sociedad está

exacerbando la presión sobre la Tierra, con consecuencias para todos. Si la

presión demográfica y los niveles de consumo aumentan, la biodiversidad decrece,

y la habilidad del mundo natural para continuar aportando bienes y servicios de

los que depende la humanidad se irá debilitando cada vez más.

AL LÍMITE DE LA CAPACIDAD

Esto es lo que ha venido ocurriendo hasta ahora, pero el cambio climático pondrá

al límite la capacidad de los ecosistemas para proporcionar bienes y servicios a

la sociedad, a demás de los impactos mismos sobre los sistemas y especies

naturales. Por eso, el Día Internacional de la Biodiversidad, que se celebra hoy

auspiciado por Naciones Unidas, gira en torno a la «Diversidad biológica y

cambio climático».

«La diversidad biológica es lo que sostiene la vida en la Tierra, pero estamos a

las puertas de la sexta mayor extinción masiva de especies de la historia del

planeta», según el secretario ejecutivo del Convenio sobre la Diversidad

Biológica (CDB) de Naciones Unidas, Ahmed Djoghlaf. En vísperas de la

celebración hoy del Día Internacional para la Diversidad Biológica, Djoghlaf

subrayó que el cambio climático crea condiciones a las que la flora y la fauna

no pueden responder con suficiente rapidez. A su juicio, la pérdida de especies

agravará el calentamiento global en un círculo vicioso. Según la tendencia

actual, un 30 por ciento de todas las especies conocidas desaparecerán antes de

que finalice este siglo.

UN DECLIVE CONTINUO

La Lista Roja de especies amenazadas 2006 de la

Unión Internacional de Conservación de la Naturaleza

(UICN) ya revelaba nítidamente el continuo

deterioro de la biodiversidad del planeta y el impacto que tiene la humanidad en

la vida sobre la tierra.

El número total de especies oficialmente declaradas extintas es de 784, y a

otras 65 solamente se las puede encontrar en cautiverio o en cultivo. De las

40.177 especies evaluadas, 16.119 figuran en la lista de especies amenazadas con

la extinción. Esto incluye a uno de cada tres anfibios y a una cuarta parte de

los árboles de coníferas del mundo, además de una de cada ocho aves, y uno de

cada cuatro mamíferos conocidos están en peligro.

POR TODO EL PLANETA

Todo indica que el oso polar será una de las víctimas más notorias del

calentamiento global. El impacto del cambio climático se siente cada vez más en

las regiones polares, donde se prevé que el hielo marino del verano se reducirá

entre un 50 y un 100 por ciento en los próximos 50 a 100 años. Se pronostica que

la población de osos polares, que dependen del flujo de hielo ártico para la

caza de focas y que están especialmente adaptados a la vida en el ambiente

marino ártico, sufrirá una disminución del 30 por ciento en los próximos 45